확률론적 분류

Probabilistic classification| 다음에 대한 시리즈 일부 |

| 머신러닝 및 데이터 마이닝 |

|---|

|

기계학습에서 확률론적 분류자는 관측치가 속해야 하는 가장 가능성이 높은 분류만을 출력하는 것이 아니라, 입력의 관찰을 주어진 클래스 집합에 대한 확률 분포를 예측할 수 있는 분류기다. 확률론적 분류자는 그 자체로[1] 유용할 수 있거나 분류자를 앙상블에 결합할 때 유용할 수 있는 분류를 제공한다.

분류의 종류

공식적으로, "일반적인" 분류자는 샘플 x에 클래스 라벨 ŷ:

샘플은 어떤 집합 X(예: 모든 문서의 집합 또는 모든 이미지의 집합)에서 나오는 반면, 클래스 라벨은 훈련 전에 정의된 유한 집합 Y를 형성한다.

확률론적 분류자는 이러한 분류자의 개념을 일반화한다: 함수 대신 조건부 분포 X X인데 이는 주어진 x 에 대해 모든 Y Y그리고 이 확률의 합계 1)에)에 확률을 할당한다는 것을 의미한다. "하드" 분류는 최적의 결정 규칙을[2]: 39–40 사용하여 수행될 수 있다.

또는, 영어에서 예측된 수업은 가장 높은 확률이다.

이항 확률론적 분류자를 통계학에서는 이항 회귀 모형이라고도 한다. 계량학에서는 일반적으로 확률론적 분류를 이산선택이라고 한다.

순진한 베이즈, 로지스틱 회귀 분석 및 다층 수용체(적절한 손실 함수에 따라 훈련된 경우)와 같은 일부 분류 모델은 자연적으로 확률론적이다. 서포트 벡터 기계와 같은 다른 모델은 아니지만, 이들을 확률론적 분류자로 바꾸는 방법이 존재한다.

생성 및 조건부 훈련

로지스틱 회귀 분석과 같은 일부 모델은 조건부 확률 ( 을 교육 세트에서 직접 최적화한다(경험적 위험 최소화 참조). Other classifiers, such as naive Bayes, are trained generatively: at training time, the class-conditional distribution and the class prior are found, and the conditional distribution is derived using Bayes' 통치를 [2]: 43 하다

확률교정

모든 분류 모델이 자연적으로 확률론적인 것은 아니며, 특히 순진한 베이즈 분류자, 의사결정 나무, 부양 방법 등 일부 분류 모델은 왜곡된 등급 확률 분포를 생산한다.[3] 의사결정 나무의 경우, Pr(y x)가 x가 끝나는 잎에 y라는 라벨이 붙은 훈련 표본의 비율인 경우, 이러한 왜곡이 발생하는 이유는 C4.5나 CART와 같은 학습 알고리즘이 (0 또는 1에 가까운 확률로, 따라서 높은 치우침) 견본을 거의 사용하지 않고 균일한 잎을 생산하는 것을 명시적으로 목표로 하기 때문이다. 관련 비율([4]고분산)

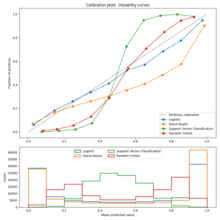

교정은 교정 그림(신뢰도라고도 함)을 사용하여 평가할 수 있다.[3][5] 보정 그림은 예측 확률 또는 점수 대역(예: 지지 벡터 기계에서 왜곡된 확률 분포 또는 "하이퍼플레인까지의 서명 거리")에 대한 각 등급의 항목의 비율을 보여준다. ID 함수의 편차는 예측 확률 또는 점수를 확률로 사용할 수 없는 보정이 제대로 이루어지지 않은 분류자를 나타낸다. 이 경우 이러한 점수를 적절하게 보정된 클래스 멤버십 확률로 바꾸는 방법을 사용할 수 있다.

이항 사례의 경우 공통적인 접근방식은 점수에 로지스틱 회귀 모형을 학습하는 플랫 스케일링을 적용하는 것이다.[6] 충분한 훈련 데이터를 이용할[7] 수 있을 때 동위원소 회귀 분석을 사용하는 대체 방법은 일반적으로 플랫의 방법보다 우수하다.[3]

멀티클래스의 경우 2진법 과제에 대한 감소를 사용할 수 있으며, 위에서 설명한 알고리즘을 이용한 일변량 보정, 헤스티와 티비시라니에 의한 쌍방향 커플링 알고리즘의 추가 적용이 뒤따른다.[8]

확률론적 분류 평가

확률론적 분류에 일반적으로 사용되는 손실 함수에는 로그 손실과 예측 확률 분포와 실제 확률 분포 사이의 브리어 점수가 포함된다. 이들 중 전자는 로지스틱 모델을 훈련하는 데 흔히 사용된다.

서로 다른 예측 방법을 비교할 수 있도록 예측 확률과 실제 이산 결과 쌍에 점수를 할당하는 방법을 점수 규칙이라고 한다.

참조

- ^ Hastie, Trevor; Tibshirani, Robert; Friedman, Jerome (2009). The Elements of Statistical Learning. p. 348. Archived from the original on 2015-01-26.

[I]n data mining applications the interest is often more in the class probabilities themselves, rather than in performing a class assignment.

- ^ a b Bishop, Christopher M. (2006). Pattern Recognition and Machine Learning. Springer.

- ^ a b c Niculescu-Mizil, Alexandru; Caruana, Rich (2005). Predicting good probabilities with supervised learning (PDF). ICML. doi:10.1145/1102351.1102430. Archived from the original (PDF) on 2014-03-11.

- ^ Zadrozny, Bianca; Elkan, Charles (2001). Obtaining calibrated probability estimates from decision trees and naive Bayesian classifiers (PDF). ICML. pp. 609–616.

- ^ "Probability calibration". jmetzen.github.io. Retrieved 2019-06-18.

- ^ Platt, John (1999). "Probabilistic outputs for support vector machines and comparisons to regularized likelihood methods". Advances in Large Margin Classifiers. 10 (3): 61–74.

- ^ Zadrozny, Bianca; Elkan, Charles (2002). "Transforming classifier scores into accurate multiclass probability estimates" (PDF). Proceedings of the eighth ACM SIGKDD international conference on Knowledge discovery and data mining - KDD '02. pp. 694–699. CiteSeerX 10.1.1.164.8140. doi:10.1145/775047.775151. ISBN 978-1-58113-567-1. CiteSeerX: 10.1.1.13.7457.

- ^ Hastie, Trevor; Tibshirani, Robert (1998). "Classification by pairwise coupling". The Annals of Statistics. 26 (2): 451–471. CiteSeerX 10.1.1.309.4720. doi:10.1214/aos/1028144844. Zbl 0932.62071. CiteSeerX: 10.1.1.46.6032.