메타서치엔진

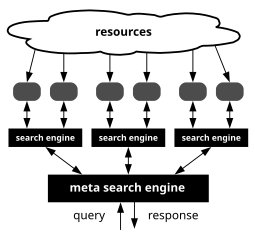

Metasearch engine메타서치 엔진(또는 검색 집계 도구)은 웹 검색 엔진의 데이터를 사용하여 자체적인 결과를 생성하는 온라인 정보 검색 도구다.[1][2] 메타서치 엔진은 사용자로부터 입력을 받아 검색 엔진에[3] 결과를 즉시 조회한다. 충분한 데이터가 수집되고, 순위가 매겨지며, 사용자에게 제시한다.

스팸과 같은 문제는 결과의 정확성과 정확성을 떨어뜨린다.[4] 핵융합 과정은 메타세르크 엔진의 공학을 향상시키는 것을 목표로 한다.[5]

메타서치 엔진의 예로는 온라인 여행사와 공급자 웹사이트의 검색 결과를 집계하는 스카이캐너와 Kayak.com, 인터넷 검색 엔진의 결과를 집계하는 익사이츠 등이 있다.

역사

메타 검색에 대한 아이디어를 통합한 첫 번째 사람은 콜로라도 주립 대학의 다니엘 드릴링거였습니다. 그는 사용자들이 한 번에 최대 20개의 다른 검색 엔진과 디렉토리를 검색할 수 있는 SearchSavvy를 개발했다. 빠르기는 하지만 검색엔진은 단순한 검색으로 제한되어 있어서 신뢰성이 없었다. 워싱턴 대학의 학생 Eric Selberg는 MetaCrawler라고 불리는 좀 더 "업데이트된" 버전을 발표했다. 이 검색엔진은 자체 검색 구문을 뒷면에 추가하고, 검색하고 있던 검색엔진과 구문을 일치시킴으로써 SearchSavvy의 정확도를 향상시켰다. 메타크롤러는 쿼리된 검색엔진의 양을 6개로 줄였지만, 보다 정확한 결과를 도출하긴 했지만 여전히 개별 엔진에서 쿼리를 검색하는 것만큼 정확한 것으로 평가되지는 않았다.[6]

1996년 5월 20일 당시 와이어드 소유였던 핫봇은 잉크토미와 다이렉트 히트 데이터베이스에서 검색 결과가 나오는 검색 엔진이었다. 검색 결과가 빠르고 검색 결과 내에서 검색이 가능한 검색 엔진으로 알려져 있었다. 1998년 라이코스에 인수되자 검색엔진 개발은 주춤했고 시장점유율은 급격히 떨어졌다. 몇 가지 변경을 거친 후, HotBot은 라이코스의 웹사이트 재설계에 그것의 기능이 통합되어 단순화된 검색 인터페이스로 재설계되었다.[7]

1999년 보슈와 수바쉬 칵이 개발한 메타세어크 엔진은 순간적으로 훈련된 신경망을 이용해 검색 결과를 분류했다.[8] 이것은 나중에 솔로세아치라고 불리는 또 다른 메타세르치 엔진에 통합되었다.[9]

2000년 8월 인도는 아마존닷컴이 출범하면서 첫 메타 검색엔진을 얻었다.[10] 이것은 당시 16살이었던 수메트 람바에 의해 개발되었다.[11] 그 웹사이트는 나중에 Tazaa.com으로 다시 브랜드화되었다.[12]

Ixquick은 개인 정보 보호 정책 선언으로 알려진 검색 엔진이다. 1998년 데이비드 보드닉이 개발하고 출시한 서프보드 홀딩 BV가 소유하고 있다. 2006년 6월, Ixquick은 Scroogle과 같은 과정을 거쳐 이용자들의 사적인 세부사항들을 삭제하기 시작했다. ixquick의 개인정보 보호정책에는 사용자의 IP주소에 대한 기록, 쿠키 식별, 개인 데이터 수집, 제3자와의 개인 데이터 공유 등이 없다.[13] 또한 결과가 별별로 순위가 매겨지는 독특한 순위 체계를 사용한다. 어떤 결과에서 별이 많을수록 검색엔진은 결과에 대해 더 많은 동의를 얻었다.

2005년 4월 당시 InfoSpace, Inc.가 소유하고 운영하는 Dogpile은 웹 검색에 메타서치 엔진을 사용하는 것의 이점을 측정하기 위해 피츠버그 대학 및 펜실베이니아 주립 대학교의 연구자들과 협력하여 선두 웹 검색 엔진의 중복과 순위 차이를 측정했다. 결과는 구글, 야후! 및 어스크 지브스의 무작위 사용자 정의 쿼리 10,316건에서 주어진 쿼리에 대해 1면 검색 결과의 3.2%만이 검색 엔진 전체에서 동일하다는 것을 발견했다. 그해 말 구글, 야후!, MSN 검색, 어스크 지브스의 임의 사용자 정의 쿼리 12,570건을 사용한 또 다른 연구는 주어진 쿼리에 대해 1면 검색 결과의 1.1%만이 검색 엔진 전체에서 동일하다는 것을 발견했다.[14]

이점

여러 개의 쿼리를 다른 검색 엔진으로 보내 해당 항목의 탐지 가능 데이터를 확장하고 더 많은 정보를 찾을 수 있도록 한다. 이들은 다른 검색 엔진에 의해 구축된 인덱스를 사용하여 집계하고 종종 고유한 방식으로 결과를 후처리한다. 메타서치 엔진은 동일한 양의 노력으로 더 많은 결과를 검색할 수 있기 때문에 단일 검색 엔진에 비해 이점이 있다.[2] 그것은 또한 자원을 찾기 위해 다른 엔진에서 검색을 개별적으로 입력해야 하는 사용자들의 작업을 줄여준다.[2]

사용자가 검색하는 목적이 주제의 개요를 얻거나 빠른 답변을 얻기 위한 것이라면 메타시칭도 유용한 접근법이다. 메타어치 엔진은 야후!나 구글과 같은 여러 검색 엔진을 거치며 결과를 비교하는 대신 신속하게 컴파일하고 결과를 결합할 수 있다. 추가 후처리(Dogpile) 없이 쿼리된 각 엔진의 결과를 나열하거나, 결과를 분석해 자체 규칙(IxQuick, Metacrawler, Vivismo)에 따라 순위를 매기는 방식으로 할 수 있다.

또한 메타서치 엔진은 검색자의 IP 주소를 쿼리된 검색 엔진으로부터 숨길 수 있으므로 검색에 프라이버시를 제공할 수 있다.

단점들

메타서치 엔진은 쿼리 양식을 구문 분석할 수 없거나 쿼리 구문을 완전히 변환할 수 없다. 메타서치 엔진에 의해 생성된 하이퍼링크 수는 제한적이므로 사용자에게 질의의 전체 결과를 제공하지 않는다.[15]

대부분의 메타서치 엔진은 단일 검색 엔진에서 10개 이상의 링크된 파일을 제공하지 않으며, 일반적으로 결과를 위해 더 큰 검색 엔진과 상호 작용하지 않는다. 클릭당 지불이 우선시되며 일반적으로 먼저 표시된다.[16]

메타 어시징은 또한 특히 사용자가 인기 있는 정보나 일반적인 정보를 검색하는 경우 질의한 주제에 대한 커버리지가 더 많다는 착각을 준다. 쿼리된 엔진에서 동일한 결과가 여러 개 나오는 것이 일반적이다. 또한 사용자가 쿼리와 함께 보낼 고급 검색 구문으로 검색하는 것도 어려워 특정 엔진에서 고급 검색 인터페이스를 사용할 때보다 결과가 정확하지 않을 수 있다. 이것은 많은 메타세르크 엔진이 간단한 검색을 사용하는 결과를 낳는다.[17]

작전

메타서치 엔진은 사용자로부터 단일 검색 요청을 수신한다. 이 검색 요청은 다른 검색 엔진의 데이터베이스로 전달된다. 메타서치 엔진은 웹 페이지의 데이터베이스를 생성하는 것이 아니라 여러 소스에서 데이터 통합의 연합 데이터베이스 시스템을 생성한다.[18][19][20]

모든 검색 엔진은 독특하고 순위 데이터를 생성하기 위한 알고리즘이 다르기 때문에 중복 데이터도 생성될 것이다. 중복 제거를 위해 메타서치 엔진은 이 데이터를 처리하고 자체 알고리즘을 적용한다. 수정된 목록은 사용자의 출력으로 생성된다.[citation needed] 메타서치 엔진이 다른 검색 엔진에 접촉할 때 이들 검색 엔진은 다음과 같은 세 가지 방법으로 응답한다.

- 이들은 모두 협력하고 인덱스 데이터베이스에 대한 개인 접근을 포함하여 메타서치 엔진의 인터페이스에 대한 완전한 액세스를 제공하며, 인덱스 데이터베이스에 대한 변경사항을 메타서치 엔진에 통보한다.

- 검색 엔진은 인터페이스에 대한 접근을 거부하거나 제공하지 않는 비협조적인 방식으로 작동할 수 있다.

- 검색 엔진은 완전히 적대적일 수 있으며, 심각한 상황에서 법적 방법을 모색함으로써 그들의 데이터베이스에 대한 메타서치 엔진의 전체 접근을 거부할 수 있다.[21]

서열 건축

많은 검색 엔진에서 순위가 높은 웹 페이지는 유용한 정보를 제공하는 데 더 관련이 있을 가능성이 높다.[21] 그러나, 모든 검색 엔진은 웹사이트마다 다른 랭킹 점수를 가지고 있고 대부분의 경우 이 점수는 같지 않다. 이것은 검색 엔진들이 점수를 매기기 위해 다른 기준과 방법들을 우선시하기 때문에, 웹사이트는 한 검색 엔진에서 높은 순위를 매기고 다른 검색 엔진에서는 낮은 순위를 매기는 것처럼 보일 수 있기 때문이다. 메타세어치 엔진은 신뢰할 수 있는 계정을 생성하기 위해 이 데이터의 일관성에 크게 의존하기 때문에 이것이 문제다.[21]

퓨전

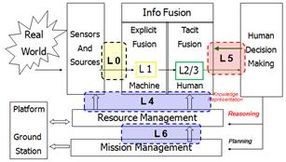

메타세어치 엔진은 Fusion의 공정을 사용하여 데이터를 필터링하여 보다 효율적인 결과를 얻는다. 사용되는 두 가지 주요 융접 방법은 Collection Fusion과 Data Fusion이다.

- Collection Fusion: 분산 검색이라고도 하며, 관련 없는 데이터를 인덱싱하는 검색 엔진을 특별히 다룬다. 콜렉션 퓨전(Collection Fusion)은 이러한 출처가 얼마나 중요한지 판단하기 위해 콘텐츠를 살펴본 다음 질의와 관련하여 관련 정보를 제공할 가능성이 얼마나 있는지를 데이터 순위를 매긴다. Collection Fusion은 생성된 것 중에서 가장 좋은 자원을 골라낼 수 있다. 이 선택된 자원은 목록으로 통합된다.[21]

- 데이터 퓨전: 공통 데이터 세트를 인덱싱하는 검색 엔진에서 검색된 정보를 처리한다. 그 과정은 매우 비슷하다. 데이터의 초기 순위 점수는 단일 목록으로 통합되며, 그 후에 이 문서들의 원래 순위를 분석한다. 점수가 높은 데이터는 특정 질의에 대한 높은 수준의 관련성을 나타내며 따라서 선택된다. 목록을 작성하려면 콤섬과 같은 알고리즘을 사용해 점수를 정규화해야 한다. 검색엔진이 서로 다른 알고리즘 정책을 채택해 산출된 점수가 비교가 안 되는 결과를 낳기 때문이다.[22][23]

스팸덱싱

스팸덱싱은 검색엔진 지수의 의도적인 조작이다. 그것은 지수화 시스템의 의도와 일치하지 않는 방식으로 지수화된 자원의 관련성 또는 중요도를 조작하기 위해 여러 가지 방법을 사용한다. 스팸덱싱은 검색의 반환 내용이 정밀도가 떨어지기 때문에 사용자에게 매우 괴롭고 검색 엔진에 문제가 될 수 있다.[citation needed] 이는 결국 검색엔진을 신뢰할 수 없게 되고 사용자가 신뢰할 수 없게 된다. 스팸덱싱에 대처하기 위해 검색 로봇 알고리즘은 더 복잡하게 만들어지고 문제를 제거하기 위해 거의 매일 변경된다.[24]

이는 순위 리스트 형식에 크게 의존하는 웹 크롤러의 지수 기준을 충족시키기 때문에 메타서치 엔진의 주요 문제다. 스팸덱싱은 검색 엔진의 자연 순위 시스템을 조작하고, 웹사이트를 자연적으로 배치되는 것보다 더 높은 순위에 올려놓는다.[25] 이를 달성하기 위해 사용되는 세 가지 주요 방법이 있다.

콘텐츠 스팸

콘텐츠 스팸은 검색 엔진이 페이지 내용에 대해 가지고 있는 논리적 보기를 변경하는 기법이다. 기법에는 다음이 포함된다.

- 키워드 스터핑 - 페이지의 키워드 수, 다양성 및 밀도를 높이기 위해 페이지 내 키워드 배치 계산

- 숨김/잘 보이지 않는 텍스트 - 배경과 동일한 색상으로 위장하거나 작은 글꼴 크기를 사용하거나 HTML 코드 내에 숨김으로써 관련 없는 텍스트

- 메타 태그 스터핑 - 메타 태그에서 키워드 반복 및/또는 사이트 내용과 무관한 키워드 사용

- Gateway Pages - 콘텐츠는 거의 없지만 상대적인 키워드 또는 구문이 있는 낮은 품질의 웹 페이지

- 스크래퍼 사이트 - 웹 사이트가 다른 웹 사이트의 콘텐츠를 복사하고 웹 사이트의 콘텐츠를 만들 수 있도록 허용하는 프로그램

- 기사 회전 - 다른 사이트의 내용을 복사하는 것과 반대로 기존 기사 다시 쓰기

- 컴퓨터 변환 - 컴퓨터 변환을 사용하여 여러 언어로 내용을 다시 쓰므로 읽기 어려운 텍스트가 생성

링크 스팸

링크 스팸은 장점 이외의 이유로 존재하는 페이지 사이의 링크다. 기법에는 다음이 포함된다.

- 링크 구축 소프트웨어 - 검색 엔진 최적화(SEO) 프로세스 자동화

- 링크 팜 - 서로를 참조하는 페이지(상호 감탄 사회라고도 함)

- 숨겨진 링크 - 방문자가 볼 수 없거나 볼 수 없는 곳에 하이퍼링크 배치

- Sybil 공격 - 악의적인 의도를 위해 여러 개의 ID 위조

- 스팸 블로그 - 상업적 홍보와 대상 사이트에 대한 링크 권한의 전달만을 위해 만들어진 블로그

- 페이지 가로채기 - 유사한 콘텐츠로 인기 있는 웹 사이트의 복사본을 만들지만 관련이 없거나 악의적인 웹 사이트로 웹 서퍼 리디렉션

- 만료된 도메인 구입 - 만료된 도메인을 구입하고 관련 없는 웹 사이트에 대한 링크로 페이지 교체

- 쿠키 스터핑 - 제휴사 추적 쿠키를 웹 사이트 방문자의 컴퓨터에 자신도 모르게 배치

- 포럼 스팸 - 사용자가 편집하여 스팸 사이트에 대한 링크를 삽입할 수 있는 웹 사이트

클로킹

웹 크롤러와 웹브라우저로 서로 다른 자료와 정보가 전송되는 SEO 기법이다.[26] 검색엔진 설명과 실질적으로 다른 사이트를 방문하거나 특정 사이트에 더 높은 순위를 부여하도록 검색엔진을 속일 수 있기 때문에 일반적으로 스팸덱싱 기법으로 사용된다.

참고 항목

참조

- ^ Berger, Sandy (2005). "Sandy Berger's Great Age Guide to the Internet". Que Publishing.ISBN 0-7897-3442-7

- ^ a b c "Architecture of a Metasearch Engine that Supports User Information Needs". 1999.

- ^ Ride, Onion (2021). "How search Engine work". onionride.

- ^ Lawrence, Stephen R.; Lee Giles, C. (October 10, 1997). "Patent US6999959 - Meta search engine" – via Google Books.

- ^ Voorhees, Ellen M.; Gupta, Narendra; Johnson-Laird, Ben (April 2000). "The collection fusion problem".

- ^ "The Meta-search -- Search Engine History".

- ^ "Search engine rankings on HotBot: a brief history of the HotBot search engine".

- ^ Shu, Bo; Kak, Subhash (1999). "A neural network based intelligent metasearch engine": 1–11. CiteSeerX 10.1.1.84.6837.

{{cite journal}}: Cite 저널은 필요로 한다.journal=(도움말) - ^ Kak, Subhash (November 1999). "Better Web searches and prediction with instantaneously trained neural networks" (PDF). IEEE Intelligent Systems.

- ^ "New kid in town".

- ^ "Rediff Search: Teens have.com of age!".

- ^ "Tazaa.com - About Tazaa.com".

- ^ "ABOUT US - Our history".

- ^ Spink, Amanda; Jansen, Bernard J.; Kathuria, Vinish; Koshman, Sherry (2006). "Overlap among major web search engines" (PDF). Emerald.

- ^ "Department of Informatics". University of Fribourg.

- ^ "Intelligence Exploitation of the Internet" (PDF). 2002.

- ^ HENNEGAR, ANNE. "Metasearch Engines Expands your Horizon".

- ^ MENG, WEIYI (May 5, 2008). "Metasearch Engines" (PDF).

- ^ Selberg, Erik; Etzioni, Oren (1997). "The MetaCrawler architecture for resource aggregation on the Web". IEEE expert. pp. 11–14.

- ^ Manoj, M; Jacob, Elizabeth (July 2013). "Design and Development of a Programmable Meta Search Engine" (PDF). Foundation of Computer Science. pp. 6–11.

- ^ a b c d Manoj, M.; Jacob, Elizabeth (October 2008). "Information retrieval on Internet using meta-search engines: A review" (PDF). Council of Scientific and Industrial Research.

- ^ Wu, Shengli; Crestani, Fabio; Bi, Yaxin (2006). Evaluating Score Normalization Methods in Data Fusion. Information Retrieval Technology. Lecture Notes in Computer Science. Vol. 4182. pp. 642–648. CiteSeerX 10.1.1.103.295. doi:10.1007/11880592_57. ISBN 978-3-540-45780-0.

- ^ Manmatha, R.; Sever, H. (2014). "A Formal Approach to Score Normalization for Meta-search" (PDF). Archived from the original (PDF) on 2019-09-30. Retrieved 2014-10-27.

- ^ Najork, Marc (2014). "Web Spam Detection". Microsoft.

- ^ Vandendriessche, Gerrit (February 2009). "A few legal comments on spamdexing".

- ^ Wang, Yi-Min; Ma, Ming; Niu, Yuan; Chen, Hao (May 8, 2007). "Connecting Web Spammers with Advertisers" (PDF).