재귀 최소 제곱(RLS)은 입력 신호와 관련된 가중 선형 최소 제곱 비용 함수를 최소화하는 계수를 재귀적으로 찾는 적응형 필터 알고리즘이다. 이 접근법은 평균 제곱 오차를 줄이는 것을 목표로 하는 최소 평균 제곱(LMS)과 같은 다른 알고리즘과 대조적이다. RLS의 도출에서 입력 신호는 결정론적인 것으로 간주되는 반면, LMS 및 유사한 알고리즘의 경우 그것들은 확률론적인 것으로 간주된다. RLS는 대부분의 경쟁사와 비교했을 때 매우 빠른 컨버전스를 보인다. 그러나 이러한 이점은 높은 계산 복잡성의 비용으로 발생한다.

동기

RLS는 가우스에 의해 발견되었지만 Plackett이 1821년부터 가우스의 원작을 재발견한 1950년까지 사용되지 않거나 무시되었다. 일반적으로 RLS는 적응형 필터로 해결할 수 있는 모든 문제를 해결하는 데 사용될 수 있다. 예를 들어, 신호 ) 이(가) 에코이(가)를 통해 전송되어 신호 d(n)가 다음과 같이 수신되도록 한다고 가정해 보십시오.

신호 d(n)가 다음과 같이 수신되도록 한다고 가정해 보십시오.

여기서 () 은(는) 가법 노이즈를 나타낸다 . RLS 필터의 목적은

. RLS 필터의 목적은 + -tap

+ -tap FIR 필터, w 을(를) 사용하여

FIR 필터, w 을(를) 사용하여 원하는 신호 ) d을(를) 복구하는 것이다.

원하는 신호 ) d을(를) 복구하는 것이다.

여기서 =[( ) x( - 1)… x( - ) \quadots 은는 p+ {\의 가장  x ( 샘플을 포함하는 열 벡터 입니다

x ( 샘플을 포함하는 열 벡터 입니다![{\displaystyle \mathbf {x} _{n}=[x(n)\quad x(n-1)\quad \ldots \quad x(n-p)]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/09eb921b307dabe5f3f396085912215d09c02114)

복구된 원하는 신호의 추정치는 다음과 같다.

복구된 원하는 신호의 추정치는 다음과 같다.

목표는 필터  {n의 파라미터를 추정하는 것이며,

{n의 파라미터를 추정하는 것이며,

{\ +1 {\ \

{\ +1 {\ \ +1}에 적응된 제곱 추정치를 한다. 역시 아래와 같이 컬럼 벡터로서

+1}에 적응된 제곱 추정치를 한다. 역시 아래와 같이 컬럼 벡터로서 , 전치(transpose)인 w {

, 전치(transpose)인 w {  는 행 벡터다. The matrix product

는 행 벡터다. The matrix product  (which is the dot product of

(which is the dot product of  and

and  ) is

) is  , a scalar. d ( )- ( n) 이(가) 일부 최소 제곱 의미에서 크기가 작을

, a scalar. d ( )- ( n) 이(가) 일부 최소 제곱 의미에서 크기가 작을 경우 추정치는 "좋음"이다.

경우 추정치는 "좋음"이다.

이 진화할수록 +1 {에 대한 새로운 추정치를 찾기 위해 최소 제곱 알고리즘을 완전히 다시 수행하지 않는 것이 바람직하다

RLS 알고리즘의 이점은 행렬을 반전시킬 필요가 없기 때문에 계산 비용을 절감할 수 있다는 것이다. 칼만 필터와 같은 결과 이면에 직관력을 제공한다는 점도 장점이다.

토론

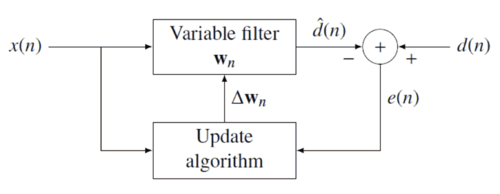

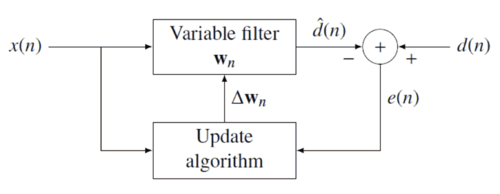

RLS 필터의 이면에 있는 아이디어는 새 데이터가 도착하면 필터를 하고n {\ _{의 필터 계수를 적절하게 선택하여

_{의 필터 계수를 적절하게 선택하여 비용 함수 {\를 최소화하는 것이다. 오류 신호 ) 및

비용 함수 {\를 최소화하는 것이다. 오류 신호 ) 및 원하는 신호 은(는) 아래의 음의 피드백 다이어그램에서 정의된다

원하는 신호 은(는) 아래의 음의 피드백 다이어그램에서 정의된다 .

.

오류는 으로 추정 ( n) 을(를) 통한 필터 계수에 따라 달라진다

따라서 가중 최소 제곱 오차 C{\ - 최소화하고자 하는 비용 함수 - ( ){\ e의 함수도 필터 계수에 따라 달라진다

- 최소화하고자 하는 비용 함수 - ( ){\ e의 함수도 필터 계수에 따라 달라진다 .

.

여기서 < {\0<\은 오래된 오류 샘플에 기하급수적으로 적은 가중치를 주는 "변수 인자"이다 .

.

벡터 의 모든 항목 에 대한 부분파생상품을 취하고 결과를

모든 항목 에 대한 부분파생상품을 취하고 결과를 0으로 설정하여 비용함수를 최소화한다.

0으로 설정하여 비용함수를 최소화한다.

다음으로 e () 을(를) 오류 신호의 정의로 대체하십시오 .

.

![\sum _{{i=0}}^{{n}}\lambda ^{{n-i}}\left[d(i)-\sum _{{l=0}}^{{p}}w_{{n}}(l)x(i-l)\right]x(i-k)=0\qquad k=0,1,\cdots ,p](https://wikimedia.org/api/rest_v1/media/math/render/svg/f227f57b5708e2279ff63386d33c501f76f500b7)

방정식 산출물 재배열

![\sum _{{l=0}}^{{p}}w_{{n}}(l)\left[\sum _{{i=0}}^{{n}}\lambda ^{{n-i}}\,x(i-l)x(i-k)\right]=\sum _{{i=0}}^{{n}}\lambda ^{{n-i}}d(i)x(i-k)\qquad k=0,1,\cdots ,p](https://wikimedia.org/api/rest_v1/media/math/render/svg/43bb38e8f5f1fa0bb012d33ae44308679a9707c2)

이 형식은 행렬 단위로 표현할 수 있다.

where  is the weighted sample covariance matrix for

is the weighted sample covariance matrix for  , and

, and  is the equivalent estimate for the cross-covariance between

is the equivalent estimate for the cross-covariance between  and

and  이 식을 바탕으로 비용 함수를 최소화하는 계수를 다음과 같이 찾아낸다.

이 식을 바탕으로 비용 함수를 최소화하는 계수를 다음과 같이 찾아낸다.

이것이 토론의 주된 결과다.

λ 선택

이 (가) 작을수록 공분산 행렬에 대한 이전 표본의 기여도가 작다. 이는 필터가 최근 샘플에 더 민감하게 반응하게 만들며, 이는 필터 공효과의 변동이 더 크다는 것을 의미한다. = 케이스는

(가) 작을수록 공분산 행렬에 대한 이전 표본의 기여도가 작다. 이는 필터가 최근 샘플에 더 민감하게 반응하게 만들며, 이는 필터 공효과의 변동이 더 크다는 것을 의미한다. = 케이스는 성장하는 윈도우 RLS 알고리즘으로 불린다. 실제로 은(는) 대개 0.98과 1 사이에서 선택된다

성장하는 윈도우 RLS 알고리즘으로 불린다. 실제로 은(는) 대개 0.98과 1 사이에서 선택된다 .[1] 타입 II 최대우도 추정을 사용하면 데이터 집합에서 최적 을(를) 추정할 수 있다

.[1] 타입 II 최대우도 추정을 사용하면 데이터 집합에서 최적 을(를) 추정할 수 있다 .[2]

.[2]

재귀 알고리즘

논의 결과 비용 함수를 최소화하는 계수 벡터를 결정하기 위한 단일 방정식이 도출되었다. 이 섹션에서는 양식의 재귀적 솔루션을 도출하고자 한다.

where  is a correction factor at time

is a correction factor at time  . We start the derivation of the recursive algorithm by expressing the cross covariance

. We start the derivation of the recursive algorithm by expressing the cross covariance  in terms of

in terms of

|  |

| |  |

| |  |

여기서 ( ) 은 (는) + 치수

(는) + 치수 데이터 벡터임

데이터 벡터임

![{\mathbf {x}}(i)=[x(i),x(i-1),\dots ,x(i-p)]^{{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dab2ea44a54d82de74ac9f6d26e3f5f6c2a44d8a)

마찬가지로 는 R (n ) 을

R ( 1){\) 단위로 표현한다.

R ( 1){\) 단위로 표현한다.

|  |

| |  |

계수 벡터를 생성하기 위해 결정론적 자동 공분산 행렬의 역행렬에 관심이 있다. 그 일에는 우드베리 매트릭스 정체성이 유용하다. 와 함께

| ( - ) )는 (+ ) -by- (+ ) -by- + ) )}이다 + ) )}이다 |

| ( ) 은 는) (+ ) -by-1 는) (+ ) -by-1 (열 벡터) (열 벡터) |

| 은 (는) 1-by+ ) (는) 1-by+ )  행 벡터) 행 벡터) |

| }는 1-by-1 ID 행렬이다. 1-by-1 ID 행렬이다. |

우드베리 매트릭스 정체성은 다음과 같다.

|  | ![\left[\lambda {\mathbf {R}}_{{x}}(n-1)+{\mathbf {x}}(n){\mathbf {x}}^{{T}}(n)\right]^{{-1}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f12c798517a6c530e616e5915429e3e16370785e) |

| |  |  |

| | |  |

| | |  |

표준 문헌에 부합하기 위해, 우리는 정의한다.

|  |

| |  |

여기서 게인 벡터 ) 은 (는)

(는)

|  |

| |  |

다음 단계로 전에 g(n) {\ {n)}을(를) 다른 형태로 가져와야 한다

가져와야 한다

|  |

|  |

왼쪽에서 두 번째 항을 뺀 값

|  |

| | ![=\lambda ^{{-1}}\left[{\mathbf {P}}(n-1)-{\mathbf {g}}(n){\mathbf {x}}^{{T}}(n){\mathbf {P}}(n-1)\right]{\mathbf {x}}(n)](https://wikimedia.org/api/rest_v1/media/math/render/svg/3baaff4ae27f9cfc51e54ada85a9de0999978262) |

) 의 재귀적 정의에서 원하는 형식이 다음과 같다.

형식이 다음과 같다.

이제 우리는 재발을 완료할 준비가 되었다. 논의한 바와 같이

|  |

| |  |

두 번째 단계는 ( n) 의 재귀적 정의에서 따옴 다음은 P 의 대체 형태와 p

다음은 P 의 대체 형태와 p ()의 재귀적 정의를 통합하고 g 를

()의 재귀적 정의를 통합하고 g 를 얻는다.

얻는다.

| ![=\lambda \left[\lambda ^{{-1}}{\mathbf {P}}(n-1)-{\mathbf {g}}(n){\mathbf {x}}^{{T}}(n)\lambda ^{{-1}}{\mathbf {P}}(n-1)\right]{\mathbf {r}}_{{dx}}(n-1)+d(n){\mathbf {g}}(n)](https://wikimedia.org/api/rest_v1/media/math/render/svg/d1dfdfb80807912183bd47c28d76f65ea9d4c553) |

| |  |

| | ![={\mathbf {P}}(n-1){\mathbf {r}}_{{dx}}(n-1)+{\mathbf {g}}(n)\left[d(n)-{\mathbf {x}}^{{T}}(n){\mathbf {P}}(n-1){\mathbf {r}}_{{dx}}(n-1)\right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/9800c914543c33d7b8ebd7f295efc9fdc51b57e7) |

-= (n- ) r (- )rn-1)을사용하여 업데이트 방정식에 도달한다.

방정식에 도달한다.

| ![={\mathbf {w}}_{{n-1}}+{\mathbf {g}}(n)\left[d(n)-{\mathbf {x}}^{{T}}(n){\mathbf {w}}_{{n-1}}\right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/78ebe76268d69116b2d676aab45f0272977a6df2) |

| |  |

여기서 ( )= (n )- T( - 는 선행 오류다. 후미 오류와 비교하십시오. 필터가 업데이트된 후 계산된 오류:

선행 오류다. 후미 오류와 비교하십시오. 필터가 업데이트된 후 계산된 오류:

그 말은 우리가 보정 계수를 찾았다는 겁니다.

이러한 직관적인 만족도 결과는 보정 계수가 가중 인자 를 통해 원하는 감도를 제어하는 오차와 게인 벡터 모두에 정비례한다는 것을 나타낸다

RLS 알고리즘 요약

p-th 순서 RLS 필터에 대한 RLS 알고리즘은 다음과 같이 요약할 수 있다.

| 매개 변수: | = p필터 순서 순서 |

| = 잊는 요인 요인 |

| = 값을 초기화하여 () 초기화하여 () |

| 초기화: | ( )=  |

| ( )= =- p,…,-  |

|  |

| ( )= 여기서 I 은 I 은 순위 p + 의 이다 순위 p + 의 이다 |

| 계산: | = ,,…의 경우, |

| ![{\mathbf {x}}(n)=\left[{\begin{matrix}x(n)\\x(n-1)\\\vdots \\x(n-p)\end{matrix}}\right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/d85a8706d78172d40a299b2bb60ae26b22a21f6c)

|

|  |

|  |

|  |

| ( )= w( - )+ ( n) g ) { |

에 대한 재귀는 대수 리카티 방정식을 따르며 따라서 Kalman 필터와 평행선을 그린다.[3]

따라서 Kalman 필터와 평행선을 그린다.[3]

격자 재귀 최소 제곱 필터(LRLS)

Lattice Recursive Lest Square 적응 필터는 산술 연산(순서 N)이 적게 필요하다는 점을 제외하고 표준 RLS와 관련이 있다.[4] 기존 LMS 알고리즘보다 빠른 수렴율, 모듈형 구조, 입력상관 매트릭스의 고유값 스프레드 변화에 대한 불감증 등 추가적인 장점을 제공한다. 기술된 LRLS 알고리즘은 사후 오류에 기초하며 정규화된 형태를 포함한다. The derivation is similar to the standard RLS algorithm and is based on the definition of  . In the forward prediction case, we have

. In the forward prediction case, we have  with the input signal

with the input signal  as the most up to date sample. 후진 예측 사례는 ( )= ( - - 1) 이며

as the most up to date sample. 후진 예측 사례는 ( )= ( - - 1) 이며 여기서 나는 우리가 예측하고자 하는 과거의 표본의 지수이고, 입력 신호 은

여기서 나는 우리가 예측하고자 하는 과거의 표본의 지수이고, 입력 신호 은 가장 최근의 표본이다.[5]

가장 최근의 표본이다.[5]

매개 변수 요약

- ( , ) 은

(는) 전방반사 계수임

(는) 전방반사 계수임

- ( k, ) 은

(는) 역반사 계수다.

(는) 역반사 계수다.

- ( , ) 은(는) 후방의 전방 예측 오류를 나타낸다

.

.

- ( , ) 은(는) 후방의 역방향 예측 오류를 나타낸다

.

.

- ( , i) 은

(는) 최소 최소값 후진 예측 오류임

(는) 최소 최소값 후진 예측 오류임

- m ( , ) 은

(는) 최소 최소 최소값 전방 예측 오류임

(는) 최소 최소 최소값 전방 예측 오류임

- (, ) 은(는) priori 오류와 properi 오류 사이의 변환 계수다

.

.

- ( ) 은

(는) 피드포워드 승수 계수다.

(는) 피드포워드 승수 계수다.

- 은

(는) 0.01일 수 있는 작은 양의 상수임

(는) 0.01일 수 있는 작은 양의 상수임

LRLS 알고리즘 요약

LRLS 필터 알고리즘은 다음과 같이 요약할 수 있다.

| 초기화: |

| i = 0,1,...,N의 경우 |

| - ,)= - ,)=  k < 0의 경우 x(k) = 0)) k < 0의 경우 x(k) = 0)) |

|  |

|  |

|  |

| 끝 |

| 계산: |

| k ≥ 0의 경우 |

|  |

|  |

|  |

|  |

| i = 0,1,...,N의 경우 |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

|  |

| 피드포워드 필터링 |

|  |

|  |

|  |

| 끝 |

| 끝 |

| |

정규화된 격자 재귀 최소 제곱 필터(NLRLS)

LRLS의 정규화된 형태는 재귀와 변수가 적다. 알고리즘의 내부 변수에 정규화를 적용하여 크기를 1로 제한하여 유지할 수 있다. 이는 일반적으로 높은 계산 부하를 수반하는 분할 및 제곱근 연산의 수 때문에 실시간 애플리케이션에서는 사용되지 않는다.

NLRLS 알고리즘 요약

NLRLS 필터에 대한 알고리즘은 다음과 같이 요약할 수 있다.

| 초기화: |

| i = 0,1,...,N의 경우 |

| (- ,)= displaystyle {\만약 x( k) = d(k) = 0(k) = k < 0))) k) = d(k) = 0(k) = k < 0))) |

|  |

|  |

| 끝 |

|  |

| 계산: |

| k ≥ 0의 경우 |

| ( k)= ( - )+ (k) }( 입력 신호 에너지) 입력 신호 에너지) |

| () = d (k -) + 2 ( ) 스타일 \sigma }( 참조 신호 에너지) 참조 신호 에너지) |

|  |

|  |

| i = 0,1,...,N의 경우 |

|  |

|  |

|  |

| 피드포워드 필터 |

|  |

| ![\overline {e}(k,i+1)={\frac {1}{{\sqrt {(1-\overline {e}_{b}^{2}(k,i))(1-\overline {\delta }_{D}^{2}(k,i))}}}}[\overline {e}(k,i)-\overline {\delta }_{D}(k,i)\overline {e}_{b}(k,i)]](https://wikimedia.org/api/rest_v1/media/math/render/svg/580293031a5a01b0b256042558d14b8ae206561d) |

| 끝 |

| 끝 |

| |

참고 항목

참조

- Hayes, Monson H. (1996). "9.4: Recursive Least Squares". Statistical Digital Signal Processing and Modeling. Wiley. p. 541. ISBN 0-471-59431-8.

- 사이먼 헤이킨, 프렌티스 홀, 2002, ISBN 0-13-048434-2

- M.H.A 데이비스, R.B.빈터, 확률적 모델링 및 제어, 스프링거, 1985년 ISBN 0-412-16200-8

- 웨이펑 류, 호세 프린시페, 사이먼 헤이킨, 커널 적응 필터링: 종합 소개, 존 와일리, 2010, ISBN 0-470-44753-2

- R.L. Plackett, 1950, Biometrica, 37, 149-157, ISSN 0006-3444의 최소 제곱의 일부 이론

- C.F.Gauss, Theoryia combinationis warnosiae, 1821, Werke, 4. Gottinge

메모들

- ^ 에매년 C. 이피아코르, 배리 W. 저비스 디지털 신호 처리: 실용적 접근법, 제2판. 인디애나폴리스: Pearson Education Limited, 2002, 페이지 718

- ^ 스티븐 반 베렌버그, 이그나시오 산타마리아, 미겔 라자로-그레딜라 "커널 재귀 최소 사각형에서의 망각 인자 추정", 2012년 6월 23일, 2012년 신호 처리를 위한 기계 학습에 관한 IEEE 국제 워크숍에 접속했다.

- ^ 웰치, 그레그, 비숍, 게리 "Calman Filter 소개" 노스캐롤라이나 대학 컴퓨터과학과 9월 17일 채플힐에서 2011년 7월 19일에 접속했다.

- ^ Diniz, Paulo S.R. "어댑티브 필터링: 알고리즘 및 실제 구현", 스프링거 네이처 스위스 AG 2020, 7장: 적응 격자 기반 RLS 알고리즘 https://doi.org/10.1007/978-3-030-29057-3_7

- ^ 알부, 카들렉, 소프트리, 마투섹, 헤르마넥, 콜먼, 페이건 "Virtex에 RLS 래티스의 (정상화) 구현", 디지털 신호 처리, 2001년 12월 24일에 접속했다.

![{\displaystyle \mathbf {x} _{n}=[x(n)\quad x(n-1)\quad \ldots \quad x(n-p)]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/09eb921b307dabe5f3f396085912215d09c02114)

모든 항목

모든 항목

![\sum _{{i=0}}^{{n}}\lambda ^{{n-i}}\left[d(i)-\sum _{{l=0}}^{{p}}w_{{n}}(l)x(i-l)\right]x(i-k)=0\qquad k=0,1,\cdots ,p](https://wikimedia.org/api/rest_v1/media/math/render/svg/f227f57b5708e2279ff63386d33c501f76f500b7)

![\sum _{{l=0}}^{{p}}w_{{n}}(l)\left[\sum _{{i=0}}^{{n}}\lambda ^{{n-i}}\,x(i-l)x(i-k)\right]=\sum _{{i=0}}^{{n}}\lambda ^{{n-i}}d(i)x(i-k)\qquad k=0,1,\cdots ,p](https://wikimedia.org/api/rest_v1/media/math/render/svg/43bb38e8f5f1fa0bb012d33ae44308679a9707c2)

(가) 작을수록 공분산 행렬에 대한 이전 표본의 기여도가 작다. 이는 필터가 최근 샘플에 더 민감하게 반응하게 만들며, 이는 필터 공효과의 변동이 더 크다는 것을 의미한다.

(가) 작을수록 공분산 행렬에 대한 이전 표본의 기여도가 작다. 이는 필터가 최근 샘플에 더 민감하게 반응하게 만들며, 이는 필터 공효과의 변동이 더 크다는 것을 의미한다.

(는)

(는)

![{\mathbf {x}}(i)=[x(i),x(i-1),\dots ,x(i-p)]^{{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dab2ea44a54d82de74ac9f6d26e3f5f6c2a44d8a)

R

R

(는) 1-by

(는) 1-by

![\left[\lambda {\mathbf {R}}_{{x}}(n-1)+{\mathbf {x}}(n){\mathbf {x}}^{{T}}(n)\right]^{{-1}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f12c798517a6c530e616e5915429e3e16370785e)

(는)

(는)

![=\lambda ^{{-1}}\left[{\mathbf {P}}(n-1)-{\mathbf {g}}(n){\mathbf {x}}^{{T}}(n){\mathbf {P}}(n-1)\right]{\mathbf {x}}(n)](https://wikimedia.org/api/rest_v1/media/math/render/svg/3baaff4ae27f9cfc51e54ada85a9de0999978262)

![=\lambda \left[\lambda ^{{-1}}{\mathbf {P}}(n-1)-{\mathbf {g}}(n){\mathbf {x}}^{{T}}(n)\lambda ^{{-1}}{\mathbf {P}}(n-1)\right]{\mathbf {r}}_{{dx}}(n-1)+d(n){\mathbf {g}}(n)](https://wikimedia.org/api/rest_v1/media/math/render/svg/d1dfdfb80807912183bd47c28d76f65ea9d4c553)

![={\mathbf {P}}(n-1){\mathbf {r}}_{{dx}}(n-1)+{\mathbf {g}}(n)\left[d(n)-{\mathbf {x}}^{{T}}(n){\mathbf {P}}(n-1){\mathbf {r}}_{{dx}}(n-1)\right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/9800c914543c33d7b8ebd7f295efc9fdc51b57e7)

![={\mathbf {w}}_{{n-1}}+{\mathbf {g}}(n)\left[d(n)-{\mathbf {x}}^{{T}}(n){\mathbf {w}}_{{n-1}}\right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/78ebe76268d69116b2d676aab45f0272977a6df2)

![{\mathbf {x}}(n)=\left[{\begin{matrix}x(n)\\x(n-1)\\\vdots \\x(n-p)\end{matrix}}\right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/d85a8706d78172d40a299b2bb60ae26b22a21f6c)

가장 최근의 표본이다.

가장 최근의 표본이다. (는) 전방반사 계수임

(는) 전방반사 계수임 (는) 역반사 계수다.

(는) 역반사 계수다.

(는) 최소 최소값 후진 예측 오류임

(는) 최소 최소값 후진 예측 오류임 (는) 최소 최소 최소값 전방 예측 오류임

(는) 최소 최소 최소값 전방 예측 오류임

(는) 피드포워드 승수 계수다.

(는) 피드포워드 승수 계수다. (는) 0.01일 수 있는 작은 양의 상수임

(는) 0.01일 수 있는 작은 양의 상수임

![\overline {e}(k,i+1)={\frac {1}{{\sqrt {(1-\overline {e}_{b}^{2}(k,i))(1-\overline {\delta }_{D}^{2}(k,i))}}}}[\overline {e}(k,i)-\overline {\delta }_{D}(k,i)\overline {e}_{b}(k,i)]](https://wikimedia.org/api/rest_v1/media/math/render/svg/580293031a5a01b0b256042558d14b8ae206561d)