tf-idf

tf–idf

정보 검색 시 tf-idf (또한 TF*)IDF, TFIDF, TF-IDF 또는 Tf-idf는 용어 주파수-역주 문서 빈도의 줄임말로서 집합 또는 말뭉치의 문서에 단어가 얼마나 중요한지를 반영하기 위한 숫자 통계량이다.[1]정보 검색, 텍스트 마이닝, 사용자 모델링의 검색에서 가중 요소로 자주 사용된다.tf-idf 값은 문서에 단어가 나타나는 횟수에 비례하여 증가하며 단어가 포함된 말뭉치의 문서 수로 상쇄되므로 일반적으로 일부 단어가 더 자주 나타나는 것을 조정할 수 있다. tf-idf는 오늘날 가장 인기 있는 용어 가중치 체계 중 하나이다.2015년 실시한 설문조사에 따르면 디지털 도서관 내 텍스트 기반 추천자 시스템의 83%가 tf-idf를 사용하고 있는 것으로 나타났다.[2]

tf-idf 가중치 체계의 변동은 사용자 질의가 주어진 문서의 관련성을 채점하고 순위를 매기는 데 있어 검색 엔진에 의해 종종 사용된다. tf-idf는 텍스트 요약과 분류 등 다양한 주제 분야에서 정지 단어 필터링에 성공적으로 사용될 수 있다.null

가장 간단한 순위 함수 중 하나는 각 쿼리 항의 tf-idf를 합산하여 계산된다. 보다 정교한 순위 함수는 이 단순한 모델의 변형이다.null

동기부여

항 빈도

영어 텍스트 문서 세트를 가지고 있으며 질의 "갈색 소"와 더 관련이 있는 문서에 따라 순위를 매기고자 한다고 가정합시다.간단한 시작 방법은 "the", "갈색", "cow" 세 단어가 모두 들어 있지 않은 문서를 제거하는 것이지만, 이것은 여전히 많은 문서를 남긴다.그것들을 더 구별하기 위해, 우리는 각 문서에서 각 용어가 발생하는 횟수를 셀 수 있다; 문서에서 용어가 발생하는 횟수를 용어 빈도라고 한다.그러나 문서 길이가 크게 다른 경우에는 조정되는 경우가 많다(아래 정의 참조).첫 번째 형태의 가중치 부여는 한스 피터 룬(1957)에 기인하며,[3] 이는 다음과 같이 요약될 수 있다.

문서에서 발생하는 용어의 무게는 단순히 빈도수와 비례한다.

역 문서 주파수

"the"라는 용어가 너무 흔하기 때문에, "brown"과 "cow"라는 의미 있는 용어에 충분한 가중치를 부여하지 않고 "the"라는 단어를 더 자주 사용하는 문서를 용어 빈도가 잘못 강조하는 경향이 있을 것이다.'the'라는 용어는 덜 통용되는 '갈색'과 'cow'와 달리 관련성이 없는 문서와 용어를 구분하는 데 좋은 키워드가 아니다.따라서 역문서의 빈도계수가 통합되어 문서 집합에서 매우 빈번하게 발생하는 용어의 가중치를 감소시키고 드물게 발생하는 용어의 가중치를 증가시킨다.null

Karen Spérck Jones(1972)는 용어 가중치의 초석이 된 역 문서 빈도(idf)라는 용어 특이성의 통계적 해석을 구상했다.[4]

용어의 특수성은 용어가 발생하는 문서 수의 역함수로 정량화할 수 있다.

정의

- tf-idf는 용어 빈도와 역 문서 빈도라는 두 가지 통계의 산물이다.두 통계량의 정확한 값을 결정하는 방법은 다양하다.

- 문서 또는 웹 페이지 내에서 키워드 또는 구문의 중요성을 정의하는 것을 목적으로 하는 수식.

| 가중치 부여 계획 | tf 중량 |

|---|---|

| 이진의 | |

| 생수 | |

| 용어 빈도 | |

| 로그 정규화 | |

| 이중 정규화 0.5 | |

| 이중 정규화 K |

항 빈도

용어 주파수, tf(t,d)는 용어 t의 빈도,

- ( t, )= , d d ′ t 스타일 {d ",

여기서 f는t,d 문서에서 용어의 원시 카운트, 즉 문서 d에서 t 용어가 발생한 횟수.용어 빈도를 정의하는 다양한 다른 방법이 있다.[5]: 128

- 원시t,d 카운트 자체: tf(t,d) = f

- 부울 "빈도": tf(t,d) = t가 d에서 발생할 경우 1이고 그렇지 않을 경우 0;

- 문서 길이에 대해 조정된 용어 빈도: tf(t,d) = ft,d ÷(d 단어의 수)

- 로그 축척 주파수: tf(t,d) = 로그(1t,d + f);[6]

- 증분 빈도, 예를 들어, 원시 빈도를 문서에서 가장 빈번하게 발생하는 용어의 원시 빈도로 나눈 값과 같은 긴 문서에 치우치지 않도록 하기 위해,

역 문서 주파수

| 가중치 부여 계획 | idf 중량( ={ D: ) |

|---|---|

| 단위의 | 1 |

| 역 문서 주파수 | |

| 역 문서 주파수 평활 | |

| 역 문서 주파수 최대값 | |

| 확률론적 역문서 빈도 |

역 문서 빈도는 단어가 얼마나 많은 정보를 제공하는지, 즉 모든 문서에 걸쳐 공통적이거나 희귀한지를 나타내는 척도다.단어를 포함하는 문서의 로그 반비례분수(총 문서 수를 용어를 포함하는 문서 수로 나눈 다음 해당 지수의 로그를 취함)이다.null

와 함께

- : 말뭉치 = N의 총 문서 수

- D: d : 라는 용어가 문서의 수(: t ( , ) 0 만약 그 용어가 말뭉치에 없다면, 이것은 0으로 나누어질 것이다.따라서 분모를 +{ D: d 으로 조정하는 것이 일반적이다.

항 빈도-역 문서 주파수

tf-idf는 다음과 같이 계산된다.

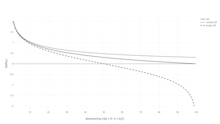

tf-idf의 높은 가중치는 전체 문서 모음에서 높은 기간 빈도와 낮은 문서 빈도로 도달한다. 따라서 가중치는 일반적인 용어를 걸러내는 경향이 있다.idf의 로그 함수 내부의 비율이 항상 1보다 크거나 같기 때문에 idf(및 tf-idf)의 값은 0보다 크거나 같다.용어가 더 많은 문서에 나타나면서 로그 내 비율이 1에 가까워져 idf와 tf-idf가 0에 가까워진다.

| 가중치 부여 계획 | 문서 용어 가중치 | 용어 가중치를 쿼리하다. |

|---|---|---|

| 1 | ||

| 2 | ||

| 3 |

idf의 정당성

Idf는 1972년 논문에서 Karen Spérck Jones에 의해 "용어적 특수성"으로 소개되었다.비록 휴리스틱스로서 효과가 좋았지만, 그것의 이론적 토대는 적어도 30년 동안 골칫거리였고, 많은 연구자들이 그것에 대한 정보 이론적 정당성을 찾으려고 노력했다.[7]null

스페르크 존스 자신의 설명은 짚프의 법칙과의 연관성 외에 별다른 이론을 제시하지 못했다.[7]주어진 문서 d에 상대적 문서 빈도로 t라는 용어가 포함될 확률을 추정함으로써 [8]idf를 확률론적 기반 위에 놓으려는 시도가 있었다.

idf를 다음과 같이 정의할 수 있다.

즉, 역 문서 빈도는 상대 문서 빈도의 "역방향" 로그다.null

이 확률론적 해석은 차례로 자기정보의 해석과 같은 형태를 취한다.그러나, 정보 검색의 문제에 그러한 기이론적 개념을 적용하면 필요한 확률 분포에 적절한 사건 공간을 정의하려고 할 때 문제가 발생한다: 문서뿐만 아니라 질의와 용어까지 고려해야 한다.[7]null

정보 이론과 연계

용어 빈도와 역 문서 빈도는 정보 이론을 사용하여 공식화할 수 있다. 그것은 그들의 제품이 문서의 공동 정보 내용 측면에서 의미를 갖는 이유를 이해하는 데 도움이 된다.분포 ( , ) 에 대한 특성 가정은 다음과 같다.

아이자와는 "tf-idf가 채택하고 있는 휴리스틱스를 대표한다"고 밝혔다."[9]

t {\ t을(를) 포함하는 조건부D {\ D 문서에 조건부 엔트로피가 표현된 것을 상기하십시오(그리고 모든 문서가 선택될 확률이 동일하고 p{\이 r=probility라고 가정).null

표기법에서 과( T {\은 각각 문서 또는 용어를 그리는 데 해당하는 "랜덤 변수"이다.이제 상호 정보의 정의를 상기하고 다음과 같이 표현될 수 있음을 주목하십시오.

마지막 단계는 문서의 (랜덤) 선택과 관련하여 용어를 그릴 수 있는 무조건적인 확률인p 을 확장하여 다음을 얻는 것이다.

이 표현은 가능한 모든 조건과 문서의 Tf-idf를 합치면 공동 배포의 모든 특수성을 고려하여 문서와 용어 사이의 상호 정보를 복구한다는 것을 보여준다.[9]따라서 각 Tf-idf는 용어 x 문서 쌍에 부착된 "정보 비트"를 가지고 있다.null

tf-idf의 예

오른쪽에 나열된 두 개의 문서만으로 구성된 말뭉치의 용어 카운트 표가 있다고 가정해 보십시오.null

| 용어 | 용어 개수 |

|---|---|

| 이 | 1 |

| 이다 | 1 |

| 또 다른 | 2 |

| 예시 | 3 |

| 용어 | 용어 개수 |

|---|---|

| 이 | 1 |

| 이다 | 1 |

| a | 2 |

| 견본을 뜨다 | 1 |

"이것"이라는 용어에 대한 tf-idf의 계산은 다음과 같이 수행된다.

그것의 원시 빈도 형식에서 tf는 각 문서에 대한 "이것"의 빈도일 뿐이다.각 문서에는 "이것"이라는 단어가 한 번 나타나지만, 문서 2에 단어가 많아지면서 상대적 빈도는 더 작아진다.null

idf는 말뭉치당 일정하며, "이것"이라는 단어를 포함하는 문서의 비율을 설명한다.이 경우, 우리는 두 개의 문서로 된 말뭉치를 가지고 있고, 그 모든 문서에는 "이것"이라는 단어가 포함되어 있다.null

따라서 tf-idf는 "이것"이라는 단어에 영(0)이며, 이는 그 단어가 모든 문서에 나타나는 것처럼 그다지 유익하지 않다는 것을 암시한다.null

"예"라는 단어가 더 흥미롭다. - 그것은 세 번 발생하지만, 두 번째 문서에서만 발생한다.

마지막으로

조건을 넘어서

tf-idf 이면의 아이디어는 조건이 아닌 다른 기업에도 적용된다.1998년에는 인용문에 idf의 개념이 적용되었다.[10]저자들은 "매우 흔치 않은 인용문을 두 개의 문서에 의해 공유한다면, 이는 다수의 문서에 의해 만들어진 인용보다 더 높은 가중치를 부여해야 한다"고 주장했다.또, 「비주얼 워드」에 대해서는, 영상에서의 객체 매칭,[11] 전체 문장의 실시를 목적으로 tf-idf를 적용했다.[12]그러나 tf-idf의 개념은 (idf가 없는) 평이한 tf 체계보다 모든 경우에 더 효과적인 것으로 증명되지는 않았다.인용에 tf-idf를 적용했을 때, 연구자들은 idf 성분이 없는 단순한 인용-카운트 가중치에 비해 개선점을 찾을 수 없었다.[13]null

파생상품

tf-idf에서 많은 용어 가중치가 도출되었다.그 중 하나가 TF-PDF(Term Frequency *비례 문서 주파수)이다.[14]TF-PDF는 미디어에서 떠오르는 주제를 파악하는 맥락에서 2001년에 도입되었다.PDF 구성요소는 서로 다른 도메인에서 용어가 발생하는 빈도의 차이를 측정한다.또 다른 파생상품은 TF–이다.IDUF. TF-에서IDuF,[15] idf는 검색하거나 권장할 문서 말뭉치를 기준으로 계산되지 않는다.대신 idf는 사용자의 개인 문서 모음에서 계산된다.저자들은 TF-를 보고한다.IDUF는 tf-idf와 동일하게 효과적이었지만, 예를 들어 사용자 모델링 시스템이 글로벌 문서 말뭉치에 접근할 수 없는 상황에도 적용할 수 있었다.null

참고 항목

참조

- ^ Rajaraman, A.; Ullman, J.D. (2011). "Data Mining" (PDF). Mining of Massive Datasets. pp. 1–17. doi:10.1017/CBO9781139058452.002. ISBN 978-1-139-05845-2.

- ^ Breitinger, Corinna; Gipp, Bela; Langer, Stefan (2015-07-26). "Research-paper recommender systems: a literature survey". International Journal on Digital Libraries. 17 (4): 305–338. doi:10.1007/s00799-015-0156-0. ISSN 1432-5012. S2CID 207035184.

- ^ Luhn, Hans Peter (1957). "A Statistical Approach to Mechanized Encoding and Searching of Literary Information" (PDF). IBM Journal of Research and Development. 1 (4): 309–317. doi:10.1147/rd.14.0309. Retrieved 2 March 2015.

There is also the probability that the more frequently a notion and combination of notions occur, the more importance the author attaches to them as reflecting the essence of his overall idea.

- ^ Spärck Jones, K. (1972). "A Statistical Interpretation of Term Specificity and Its Application in Retrieval". Journal of Documentation. 28: 11–21. CiteSeerX 10.1.1.115.8343. doi:10.1108/eb026526.

- ^ Manning, C.D.; Raghavan, P.; Schutze, H. (2008). "Scoring, term weighting, and the vector space model" (PDF). Introduction to Information Retrieval. p. 100. doi:10.1017/CBO9780511809071.007. ISBN 978-0-511-80907-1.

- ^ "TFIDF statistics SAX-VSM".

- ^ a b c Robertson, S. (2004). "Understanding inverse document frequency: On theoretical arguments for IDF". Journal of Documentation. 60 (5): 503–520. doi:10.1108/00220410410560582.

- ^ 정보 검색 소개에서 실제 확률 추정치를 참조하십시오.

- ^ a b Aizawa, Akiko (2003). "An information-theoretic perspective of tf–idf measures". Information Processing and Management. 39 (1): 45–65. doi:10.1016/S0306-4573(02)00021-3.

- ^ Bollacker, Kurt D.; Lawrence, Steve; Giles, C. Lee (1998-01-01). CiteSeer: An Autonomous Web Agent for Automatic Retrieval and Identification of Interesting Publications. Proceedings of the Second International Conference on Autonomous Agents. AGENTS '98. pp. 116–123. doi:10.1145/280765.280786. ISBN 978-0-89791-983-8. S2CID 3526393.

- ^ Sivic, Josef; Zisserman, Andrew (2003-01-01). Video Google: A Text Retrieval Approach to Object Matching in Videos. Proceedings of the Ninth IEEE International Conference on Computer Vision – Volume 2. ICCV '03. pp. 1470–. doi:10.1109/ICCV.2003.1238663. ISBN 978-0-7695-1950-0. S2CID 14457153.

- ^ Seki, Yohei. "Sentence Extraction by tf/idf and Position Weighting from Newspaper Articles" (PDF). National Institute of Informatics.

- ^ Beel, Joeran; Breitinger, Corinna (2017). "Evaluating the CC-IDF citation-weighting scheme – How effectively can 'Inverse Document Frequency' (IDF) be applied to references?" (PDF). Proceedings of the 12th IConference.

- ^ Khoo Khyou Bun; Bun, Khoo Khyou; Ishizuka, M. (2001). Emerging Topic Tracking System. Proceedings Third International Workshop on Advanced Issues of E-Commerce and Web-Based Information Systems. WECWIS 2001. p. 2. CiteSeerX 10.1.1.16.7986. doi:10.1109/wecwis.2001.933900. ISBN 978-0-7695-1224-2. S2CID 1049263.

- ^ Langer, Stefan; Gipp, Bela (2017). "TF-IDuF: A Novel Term-Weighting Scheme for User Modeling based on Users' Personal Document Collections" (PDF). IConference.

- Salton, G; McGill, M. J. (1986). Introduction to modern information retrieval. McGraw-Hill. ISBN 978-0-07-054484-0.

- Salton, G.; Fox, E. A.; Wu, H. (1983). "Extended Boolean information retrieval". Communications of the ACM. 26 (11): 1022–1036. doi:10.1145/182.358466. hdl:1813/6351. S2CID 207180535.

- Salton, G.; Buckley, C. (1988). "Term-weighting approaches in automatic text retrieval" (PDF). Information Processing & Management. 24 (5): 513–523. doi:10.1016/0306-4573(88)90021-0. hdl:1813/6721.

- Wu, H. C.; Luk, R.W.P.; Wong, K.F.; Kwok, K.L. (2008). "Interpreting TF-IDF term weights as making relevance decisions". ACM Transactions on Information Systems. 26 (3): 1. doi:10.1145/1361684.1361686. hdl:10397/10130. S2CID 18303048.

외부 링크 및 제안된 읽기

- 겐심은 벡터 공간 모델링을 위한 파이썬 라이브러리로서 tf-idf 가중치를 포함한다.

- 검색 엔진의 구조

- tf-idf 및 관련 정의(Lucene에서 사용됨)

- TfidfTransforon in scikit-learn

- Text to Matrix Generator(TMG) MATLAB 툴박스로 텍스트 마이닝(TM) 특정 i) 인덱싱, ii) 검색, iii) 차원성 감소, iv) 클러스터링, v) 분류에서 다양한 작업에 사용할 수 있다.지수화 단계는 사용자에게 tf-idf를 포함한 로컬 및 글로벌 가중치 부여 방법을 적용할 수 있는 기능을 제공한다.

- 용어 빈도에 대한 설명

r=probility라고 가정).null

r=probility라고 가정).null

(

(