3D 사운드 현지화

3D sound localization3D 음향 국산화란 소리의 근원을 3차원 공간에서 찾아내는 음향기술을 말한다.소스 위치는 일반적으로 들어오는 음파의 방향(수평 및 수직 각도)과 소스와 센서 사이의 거리에 의해 결정된다.센서의 구조 배열 설계와 신호 처리 기법을 포함한다.

대부분의 포유류(인간 포함)는 상당한 양의 합성을 수반하는 복잡한 과정에서 각 귀에서 수신한 정보를 비교함으로써 음의 국소화를 위해 쌍심청각을 이용한다.특히 3D 공간에서는 모노럴 청력을 이용한 현지화가 어렵다.

기술

음향 국산화 기술은 보청기, 감시[1], 내비게이션과 같은 일부 오디오 및 음향 분야에서 사용된다.기존 실시간 패시브 사운드 국산화 시스템은 주로 시차적(TDOA) 접근방식에 기반해 사운드 국산화 공간을 2차원 공간으로 제한하고, 소음이 심한 환경에서는 실용적이지 못하다.

적용들

음원 로컬리제이션의 적용은 음원 분리, 음원 추적, 음성 증강 등이 있다.음파탐지는 음원의 위치추적 기술을 이용해 목표물의 위치를 파악하는데, 3D 음원의 위치추적도 사람과 로봇의 효과적인 상호작용을 위해 사용된다.로봇 청각에 대한 수요가 증가하면서 휴먼-머신 인터페이스, 장애인 보조장치, 군사용 애플리케이션 등 3D 음향 국산화의 일부 응용 분야가 모색되고 있다.[2]

사운드 현지화 신호

로컬리제이션 신호는[3] 소리를 로컬리제이션하는 데 도움이 되는 기능이다.음향 국산화 신호에는 양악 신호와 단악 신호 등이 포함된다.

- 단극 단위는 스펙트럼 분석을 통해 얻을 수 있으며 일반적으로 수직 국산화에서 사용된다.

- 좌우 귀의 청각 차이에 의해 양악 단서가 발생한다.이러한 차이는 경락간 시간차(ITD)와 경락간 강도차(IID)를 포함한다.바이노럴 단서는 대부분 수평 국산화용으로 사용된다.

어떻게 국소적으로 들리는가?

우리의 청력이 사용하는 첫 번째 단서는 경내 시차다.우리 바로 앞이나 뒤에 있는 소스에서 나오는 소리는 양쪽 귀에 동시에 도착할 것이다.만약 소스가 왼쪽이나 오른쪽으로 움직인다면, 우리의 귀는 양쪽 귀에 도달하는 같은 소스에서 소리를 집어 들지만, 어느 정도 지연된다.두 귀가 같은 신호의 다른 단계를 포착하는 또 다른 방법이 있을 수 있다.[4]

방법들

3D 사운드 로컬리제이션 방법에는 여러 가지가 있다.예를 들어,

- 마이크 어레이,[5] 바이너럴 청력 로봇 헤드 등 다양한 유형의 센서 구조

- 신경망, 최대우도 및 다중 신호 분류(MUSIC)와 같은 최적의 결과를 위한 다양한 기술.

- AVS 어레이를 이용한 실시간 방법

- 오프라인 메서드(시기에 따라)

- 마이크 배열 접근법

조향 빔포스터 접근법

이 접근방식은 8개의 마이크를 RWPHAT(신뢰성 가중 위상 변환)에 의해 강화된 조향 빔 전자와 결합하여 사용한다.최종 결과는 출처를 추적하고 잘못된 방향을 방지하는 입자 필터를 통해 필터링된다.

이 방법을 사용하는 동기는 이전의 연구에 바탕을 둔 것이다.이 방법은 사운드 트랙킹과 로컬리제이션이 단일 음원에만 적용됨에도 불구하고 다중 음원 추적 및 로컬리제이션에 사용된다.

Beamfore 기반 사운드 위치 측정

가능한 모든 방향으로 조향되는 빔 전자의 출력의 최대값을 찾기 위해 지연 및 합 빔 전자의 출력 에너지를 최대화한다.신뢰도 가중 위상 변환(RWPHAT) 방법을 사용하여 M-마이크로폰 지연 및 섬광기의 출력 에너지는

Where E indicates the energy, and K is a constant, is the microphone pairs cross-correlation defined by Reliability Weighted Phase Transform:

the weighted factor reflect the reliability of each frequency component, and defined as the Wiener Filter gain , where is an estimate of a prior SNR at microphone, at time frame , for frequency , computed using the decision-directed approach.[7]

은(는) h{\ 마이크의 신호이며, 은 해당 마이크의 도착 지연이다.이 방법의 보다 구체적인 절차는 발린과 미하우에[8] 의해 제안된다.

이 방법은 음원의 방향을 감지해 음원의 거리를 유도하는 것이 장점이다.빔포밍 접근방식의 주요 단점은 움직이는 스피커를 사용하는 신경망 접근방식과 비교하여 음향 국소화 정확도와 능력의 불완전한 특성이다.

정렬된 마이크 배열 접근법

이 접근방식은 AVS(Authic Vector Sensor) 어레이를 사용하는 실시간 사운드 위치 측정과 관련이 있다.

음향 벡터 배열

• 직교로 설치된 음향 입자 속도 구배 마이크(X, Y, Z 어레이로 표시) 3개와 전방위 음향 마이크(O) 1개 포함

• 수중에서는 일반적으로 사용된다.

• Offline[9] Calibration Process를 사용하여 X, Y, Z 및 O 어레이의 임펄스 응답을 측정하고 보간하여 조향 벡터를 얻는다.

사운드 신호는 직사각형 창을 사용하여 먼저 윈도우 설정되고, 그 후에 각 결과 세그먼트 신호가 프레임으로 생성된다.XYZO 어레이에서 4개의 병렬 프레임이 검출되어 DOA 추정에 사용된다.4개의 프레임을 동일한 크기의 작은 블록으로 분할한 다음, Hamming 창과 FFT를 사용하여 각 블록을 시간 영역에서 주파수 영역으로 변환한다.그 다음 이 시스템의 출력은 조합된 3D 공간 스펙트럼에서 피크에 의해 발견되는 음원의 수평 각도와 수직 각도로 표현된다.

과거 마이크 어레이와 비교했을 때 이 어레이의 장점은 간극이 작더라도 성능이 뛰어나고, 복수의 저주파와 고주파 와이드 밴드 음원을 동시에 국산화할 수 있다는 점이다.O 어레이를 적용하면 진폭 및 시간 차이와 같은 더 많은 음향 정보를 사용할 수 있다.가장 중요한 것은 XYZO 어레이가 작은 크기로 성능이 더 좋다는 점이다.

AVS는 결합형 다중 마이크로폰 배열의 한 종류로 다중 마이크로폰 배열 접근방식을 이용해 여러 배열로 음향을 추정한 뒤 다른 배열이 교차하는 곳에서 방향이 감지되는 곳 등 반사정보를 이용해 위치를 찾아낸다.

고급 마이크 어레이의 동기

음향 반사는 항상 실제 환경에서 발생하며 마이크 배열은[10] 그러한 반사를 관찰하는 것을 피할 수 없다.이 다중 어레이 접근방식은 천장에 고정된 어레이를 사용하여 테스트되었다. 이동 시나리오의 성능은 여전히 테스트해야 한다.

다중 마이크 배열 적용 방법 알아보기

방향을 추정할 때 각도 불확실성(AU)이 발생하고, 위치 불확실성(PU)도 배열과 선원 사이의 거리가 증가하면서 악화된다.다음과 같은 사실을 알고 있다.

여기서 r은 배열 중심과 소스 사이의 거리이고, AU는 불확실한 각도다.측정은 어느 위치에서 두 방향이 교차하는지 여부를 판단하기 위해 사용된다.두 선 사이의 최소 거리:

여기서 1 i }} 방향은 두 방향이고, 는 검출된 방향과 평행한 벡터, i{\i}}}는 배열의 위치다.

만약

두 선은 교차하는 것으로 판단된다.두 선이 교차할 때 다음을 사용하여 음원 위치를 계산할 수 있다.

{는 음원 위치 추정이고, O {은 각 방향이 최소 거리로 선을 교차하는 이며 w은 가중 요인이다.{\의 가중치 계수로서 어레이에서 최소 거리가 있는 라인까지 또는 을(를) 사용하기로 결정했다.

경청기 학습법

생체 청각 학습은 생체 공학 방법이다[5].센서는 인공 핀나(반사기)와 함께 2개의 센서 마이크가 장착된 로봇 더미 헤드다.로봇 헤드는 2개의 회전 축이 있으며 수평과 수직으로 회전할 수 있다.반사경은 유입되는 백색 잡음파의 특정 패턴으로 스펙트럼 변화를 유발하며, 이 패턴은 수직 국소화의 큐에 사용된다.수평적 국산화 큐는 ITD이다.이 시스템은 정착된 백색 소음원으로 머리를 회전시키고 스펙트럼을 분석하여 신경망을 이용한 학습과정을 활용한다.실험 결과 이 시스템은 일정 범위의 도착각에서 선원의 방향을 잘 식별할 수 있다는 것을 알 수 있다.반사경의 스펙트럼 패턴이 붕괴돼 범위 밖으로 나오는 소리를 식별할 수 없다.바이너럴 청력은 마이크로폰 2개만 사용하며 여러 소음원 중 하나의 소스에 집중할 수 있다.

실제 소리 국소화에서는 로봇 헤드와 몸통이 두 개의 핀네 외에 기능적인 역할을 한다.이는 공간 선형 필터링 기능으로서 기능하며 필터링은 항상 헤드 관련 전송 기능(HRTF)의 관점에서 정량화된다.[11] HRTF는 또한 양쪽 청각 모델인 로봇 헤드 센서를 사용한다.HRTF는 현지화를 위한 다양한 단서에 기초하여 도출될 수 있다.HRTF를 이용한 음향 국소화는 HRTF를 기반으로 설계된 필터로 입력 신호를 필터링하고 있다.신경망을 이용하는 대신 머리와 관련된 전이 기능을 사용하고 국소화는 단순한 상관관계 접근법에 기초한다.

교차 전력 스펙트럼 위상(CSP) 분석

CSP 방법은[12] 또한 바이너럴 모델에도 사용된다.도착각은 두 마이크 사이의 도착 지연 시간(TDOA)을 통해 도출할 수 있으며, TDOA는 CSP의 최대 계수를 찾아 추정할 수 있다. CSP 계수는 다음과 같이 도출된다.

서 s ( n) 및 ( 는 각각 마이크 및 에 들어가는 신호다.

도착의 시간 지연)은 다음과 같이 추정할 수 있다.

음원 방향은

서 v 이(가) 소리 전파 속도인 경우, 은 샘플링 주파수, x{\은 마이크로폰 2개 사이의 최대 시간 지연 거리.

CPS 방법은 HRTF가 필요로 하는 시스템 임펄스 응답 데이터를 필요로 하지 않는다.기대 최대화 알고리즘은 여러 음원을 국소화하고 국소화 오류를 줄이는 데도 사용된다.이 시스템은 두 개의 마이크로만 사용하여 여러 개의 움직이는 음원을 식별할 수 있다.

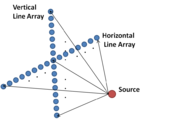

2D 센서 라인 배열

3D 공간에서 소스의 위치를 추정하기 위해 2개의 라인 센서 어레이를 수평과 수직으로 배치할 수 있다.수중 원천 국산화용으로 쓰이는 2D 라인 배열이 그 예다.[13]최대우도법을 사용하여 두 배열의 데이터를 처리함으로써 선원의 방향, 범위, 깊이를 동시에 파악할 수 있다.이 방법은 바이너럴 청력 모델과 달리 스펙트럼 분석 방법과 유사하다.이 방법은 원거리의 근원을 현지화하는 데 사용될 수 있다.

자가 회전 바이오 마이크로폰 어레이

2-마이크로폰 어레이(바이-마이크로폰 어레이라고도 함)의 회전은 3D 환경에 존재하는 정지 음원에 대한 사인파 채널 간 시간 차이(ICTD) 신호로 이어진다.결과 사인파 신호의 위상변동은 음원의 방위각도에 직접 매핑할 수 있으며, ICTD 신호의 진폭은 음원의 고도각과 두 마이크 사이의 거리의 함수로 나타낼 수 있다.[15]복수 소스의 경우, ICTD 신호에는 복수의 불연속 사인파 파형을 형성하는 데이터 포인트가 있다.무작위 샘플 컨센서스(RANSAC)와 소음 애플리케이션(DBSCAN)의 밀도 기반 공간 클러스터링과 같은 머신러닝 기법을 적용하여 ICTD 신호에서 각 불연속 사인파 파형의 위상 변화(방사능에 매핑)와 진폭(고도에 매핑)을 식별할 수 있다.[16]

계층적 퍼지 인공신경망 접근법

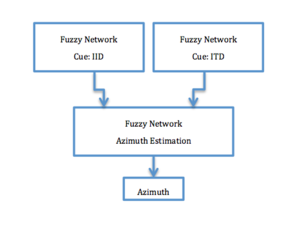

계층적 퍼지 인공신경망 접근 음향 국산화 시스템은 생물학적 바이너럴 음향 국산화 모델을 개발하였다.비록 그 과정이 완전히 이해되지는 않았지만, 두 개의 귀와 작은 뇌를 가진 몇몇 원시 동물들은 3D 공간을 지각하고 소리를 처리할 수 있다.어떤 동물들은 머리 크기가 작아서 3D 사운드 위치에서 어려움을 겪기도 한다.또한, 개구리처럼 통신음 파장은 머리 지름보다 훨씬 클 수 있다.

기존의 바이너럴 사운드 로컬리제이션 방법을 기반으로 한 계층적 퍼지 인공신경망 시스템은 인체와 유사한 높은 정확도를 위해 경락간 시간차(ITD 기반)와 경락간 강도차(IID 기반) 음향 로컬리제이션 방법을 결합했다.계층적 퍼지 인공신경망은[17] 인간의 귀와 동일한 음의 국소화 정확도를 목표로 사용되었다.

IID 기반 또는 ITD 기반 사운드 지역화 방법은 Front-back conflusion이라고 하는 주요 문제를 가지고 있다.[18]계층적 신경망 시스템에 기반한 이러한 소리 로컬리제이션에서, 이 문제를 해결하기 위해, IID 추정은 ITD 추정에 있다.이 시스템은 광대역통신 사운드에 사용되었고 비역장 시나리오에 배치되었다.

모노럴 음원에 대한 3D 사운드 로컬리제이션

일반적으로 음향 국소화는 2개 이상의 마이크를 사용하여 수행된다.두 마이크에서 소리의 도착 시간 차이를 이용하여 음원의 방향을 수학적으로 추정할 수 있다.그러나, 마이크로폰의 배열로 소리를 국소화할 수 있는 정확도는 배열의 물리적 크기에 의해 근본적으로 제한된다.배열이 너무 작으면 마이크의 간격을 너무 촘촘히 하여 모두 본질적으로 같은 소리(ITF가 0에 가까움)를 녹음하여 방향을 추정하기가 매우 어렵다.따라서 마이크 어레이의 길이(데스크톱 애플리케이션의 경우)가 수십 센티미터에서 수십 미터(수중 국산화용)에 이르는 경우도 드물지 않다.그러나, 이 크기의 마이크 배열은 작은 로봇에 사용할 수 없게 된다.대형 로봇에게도, 그러한 마이크 배열은 장착과 조작에 번거로울 수 있다.이와는 대조적으로, 단일 마이크로폰(초소형으로 만들 수 있음)을 사용하여 소리를 국산화할 수 있는 능력은 국산화 장치인 저비용과 전력뿐만 아니라 훨씬 더 소형화할 수 있는 가능성을 가지고 있다.

재래식 HRTF 접근법

3d 사운드 현지화를 구현하는 일반적인 방법은 HRTF(Head 관련 전송 기능)를 사용하는 것이다.먼저, 두 개의 방정식을 만들어 3D 사운드 위치 선정에 대한 HRTF를 계산한다. 하나는 주어진 음원의 신호를 나타내고 다른 하나는 소스에서 전달되는 소리에 대한 로봇 헤드 마이크의 신호 출력을 나타낸다.모노럴 입력 데이터는 이러한 HRTF에 의해 처리되며, 결과는 스테레오 헤드폰에서 출력된다.이 방법의 단점은 3D 사운드 로컬리제이션의 실현을 위해 필터 세트 전체에 많은 파라메트릭 연산이 필요하여 계산 복잡성이 높다는 것이다.

3D 사운드 로컬리제이션 DSP 구현

임베디드 DSP를 사용한 실시간 3D 사운드 로컬리제이션 접근방식의 DSP 기반 구현은 계산 복잡성을 줄일 수 있다 그림에서 보듯이 이 실시간 알고리즘의 구현 절차는 (i) 주파수 분할, (ii) 소리 로컬리제이션, (iiiii) 믹싱의 3단계로 나뉜다.모노럴 음원에 대한 3D 사운드 로컬리제이션의 경우, 오디오 입력 데이터는 좌우 채널과 시계열의 오디오 입력 데이터가 차례로 처리된다.[19]

이 접근방식의 특징은 3개의 서브밴드 각각에 대해 3D 사운드 로컬리제이션의 구별되는 절차를 활용할 수 있도록 가청 주파수대역을 3개로 나눈다는 점이다.

단일 마이크로폰 접근법

모나랄 국소화는 핀나(외이)의 구조에 의해 가능해지고, 이는 소리를 입사각도에 의존하는 방식으로 수정한다.기계학습 접근법은 하나의 마이크와 '인공 핀나'(방향에 의존하는 방식으로 소리를 왜곡하는)만을 사용하여 모노럴 로컬리제이션(monoral lt; machine learning approaches to monanoral localization.접근법은 피나에 의해 유도된 소리에 대한 방향 의존적 변화뿐만 아니라 자연적, 인공적 소리의 전형적인 분포를 모델링한다.[20]실험 결과는 또한 알고리즘이 인간의 언어, 개 짖는 소리, 폭포, 천둥 등 광범위한 소리를 상당히 정확하게 국소화할 수 있다는 것을 보여준다.마이크 어레이와 대조적으로, 이 접근방식은 또한 음향 국산화 장치인 낮은 비용과 전력뿐만 아니라 훨씬 더 작은 소형화 가능성을 제공한다.

참고 항목

참조

- ^ Keyrouz, Fakheredine; Diepold, Klaus; Keyrouz, Shady (September 2007). High performance 3D sound localization for surveillance applications. 2007 IEEE Conference on Advanced Video and Signal Based Surveillance, AVSS 2007. pp. 563–6. doi:10.1109/AVSS.2007.4425372. ISBN 978-1-4244-1695-0. S2CID 11238184.

- ^ Kjær, Brüel. "Noise Source Identification". bksv.com. Brüel & Kjær.

- ^ Goldstein, E.Bruce (2009-02-13). Sensation and Perception (Eighth ed.). Cengage Learning. pp. 293–297. ISBN 978-0-495-60149-4.

- ^ Kjær, Brüel. "Listening in 3D". Brüel & Kjær. Brüel & Kjær.

- ^ a b Nakashima, H.; Mukai, T. (2005). "3D Sound Source Localization System Based on Learning of Binaural Hearing". 2005 IEEE International Conference on Systems, Man and Cybernetics. Vol. 4. pp. 3534–3539. doi:10.1109/ICSMC.2005.1571695. ISBN 0-7803-9298-1. S2CID 7446711.

- ^ Liang, Yun; Cui, Zheng; Zhao, Shengkui; Rupnow, Kyle; Zhang, Yihao; Jones, Douglas L.; Chen, Deming (2012). "Real-time implementation and performance optimization of 3D sound localization on GPUs". Automation and Test in Europe Conference and Exhibition: 832–5. ISSN 1530-1591.

- ^ Ephraim, Y.; Malah, D. (Dec 1984). "Speech enhancement using a minimum-mean square error short-time spectral amplitude estimator". IEEE Transactions on Acoustics, Speech, and Signal Processing. 32 (6): 1109–21. doi:10.1109/TASSP.1984.1164453. ISSN 0096-3518.

- ^ Valin, J.M.; Michaud, F.; Rouat, Jean (14–19 May 2006). "Robust 3D Localization and Tracking of Sound Sources Using Beamforming and Particle Filtering". 2006 IEEE International Conference on Acoustics Speech and Signal Processing Proceedings. Vol. 4. p. IV. arXiv:1604.01642. doi:10.1109/ICASSP.2006.1661100. ISBN 978-1-4244-0469-8. ISSN 1520-6149. S2CID 557491.

- ^ Salas Natera, M.A.; Martinez Rodriguez-Osorio, R.; de Haro Ariet, L.; Sierra Perez, M. (2012). "Calibration Proposal for New Antenna Array Architectures and Technologies for Space Communications". IEEE Antennas and Wireless Propagation Letters. 11: 1129–32. Bibcode:2012IAWPL..11.1129S. doi:10.1109/LAWP.2012.2215952. ISSN 1536-1225.

- ^ Ishi, C.T.; Even, J.; Hagita, N. (November 2013). Using multiple microphone arrays and reflections for 3D localization of sound sources. 2013 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2013). pp. 3937–42. doi:10.1109/IROS.2013.6696919. ISBN 978-1-4673-6358-7. S2CID 16043629.

- ^ Keyrouz, Fakheredine; Diepold, Klaus (2006). "An Enhanced Binaural 3D Sound Localization Algorithm". 2006 IEEE International Symposium on Signal Processing and Information Technology. pp. 662–665. doi:10.1109/ISSPIT.2006.270883. ISBN 0-7803-9754-1. S2CID 14042947.

- ^ Hyun-Don Kim; Komatani, K.; Ogata, T.; Okuno,H.G. (Jan 2008). Evaluation of Two-Channel-Based Sound Source Localization using 3D Moving Sound Creation Tool. ICERI 2008. doi:10.1109/ICKS.2008.25.

- ^ Tabrikian,J.; Messer,H. (Jan 1996). "Three-Dimensional Source Localization in a Waveguide". IEEE Transactions on Signal Processing. 44 (1): 1–13. Bibcode:1996ITSP...44....1T. doi:10.1109/78.482007.

- ^ Gala, Deepak; Lindsay, Nathan; Sun, Liang (July 2018). "Realtime Active Sound Source Localization for Unmanned Ground Robots Using a Self-Rotational Bi-Microphone Array". Journal of Intelligent & Robotic Systems. 95 (3): 935–954. doi:10.1007/s10846-018-0908-3.

- ^ Gala, Deepak; Lindsay, Nathan; Sun, Liang (June 2018). Three-dimensional sound source localization for unmanned ground vehicles with a self-rotational two-microphone array. CDSR 2018. doi:10.11159/cdsr18.104.

- ^ Gala, Deepak; Lindsay, Nathan; Sun, Liang (Oct 2021). Multi-Sound-Source Localization Using Machine Learning for Small Autonomous Unmanned Vehicles with a Self-Rotating Bi-Microphone Array. Journal of Intelligent & Robotic Systems 103, 52. doi:10.1007/s10846-021-01481-4.

- ^ Keyrouz, Fakheredine; Diepold, Klaus (May 2008). "A novel biologically inspired neural network solution for robotic 3D sound source sensing". Soft Computing. 12 (7): 721–9. doi:10.1007/s00500-007-0249-9. ISSN 1432-7643. S2CID 30037380.

- ^ Hill, P.A.; Nelson, P.A.; Kirkeby, O.; Hamada, H. (December 2000). "Resolution of front-back confusion in virtual acoustic imaging systems". Journal of the Acoustical Society of America. 108 (6): 2901–10. Bibcode:2000ASAJ..108.2901H. doi:10.1121/1.1323235. ISSN 0001-4966. PMID 11144583.

- ^ Noriaki, Sakamoto; wataru, Kobayashi; Takao, Onoye; Isao, Shirakawa (2001). DSP implementation of 3D sound localization algorithm for monaural sound source. The 8th IEEE International Conference on Electronics, Circuits and Systems, 2001. ICECS 2001. Vol. 2. pp. 1061–1064. doi:10.1109/ICECS.2001.957673. ISBN 978-0-7803-7057-9. S2CID 60528168.

- ^ Saxena, A.; Ng, A.Y. (2009). "Learning sound location from a single microphone". 2009 IEEE International Conference on Robotics and Automation. pp. 1737–1742. doi:10.1109/ROBOT.2009.5152861. ISBN 978-1-4244-2788-8. S2CID 14665341.

(는)

(는)

음원 위치 추정이고,

음원 위치 추정이고,  각 방향이 최소 거리로 선을 교차하는

각 방향이 최소 거리로 선을 교차하는  가중 요인이다.

가중 요인이다.

![{\displaystyle csp_{ij}(k)={\text{IFFT}}\left\{{\frac {{\text{FFT}}[s_{i}(n)]\cdot {\text{FFT}}[s_{j}(n)]^{*}}{\left|{\text{FFT}}[s_{i}(n)]\right\vert \cdot \left|{\text{FFT}}[s_{j}(n)]\right\vert \quad }}\right\}\quad }](https://wikimedia.org/api/rest_v1/media/math/render/svg/7edeb234c5d51c97f20561585f8b3d5c55149f50)

샘플링 주파수,

샘플링 주파수,  마이크로폰 2개 사이의 최대 시간 지연 거리.

마이크로폰 2개 사이의 최대 시간 지연 거리.