인텔리전트 에이전트

Intelligent agent인공지능에서 지능형 에이전트(IA)는 환경을 인지하고, 목표를 달성하기 위해 자율적으로 행동하며, 학습을 통해 성과를 향상시키거나 지식을 사용할 수 있는 모든 것을 말한다.이들은 단순하거나 복잡할 수 있습니다.온도조절기는 인간과 마찬가지로 지능형 에이전트의 예로 간주되며, 기업, 주 또는 [1]생물군과 같은 정의를 충족하는 시스템도 마찬가지입니다.

유력 AI 교과서는 '인공지능'을 '지능형 에이전트의 연구와 설계'로 정의하는데, 이는 목표 지향적인 행동을 지능의 본질로 간주하는 정의이다.목표 지향적 에이전트는 경제학에서 차용한 용어인 "합리적 에이전트"[1]를 사용하여 설명되기도 합니다.

에이전트에는 IA의 모든 목표를 캡슐화하는 "객관적 함수"가 있습니다.이러한 에이전트는 완료 시 목표 [2]함수의 기대치를 극대화하는 모든 계획을 작성하고 실행하도록 설계되어 있습니다.예를 들어 강화학습 에이전트는 프로그래머가 IA의 바람직한 [3]동작을 형성할 수 있는 "보복 함수"를 가지며, 진화 알고리즘의 동작은 "적합 함수"[4]에 의해 형성된다.

인공지능의 지능형 에이전트는 경제학의 에이전트와 밀접하게 관련되어 있으며, 지능형 에이전트 패러다임의 버전은 인지과학, 윤리학, 실제 이성의 철학, 그리고 많은 학문 간 사회-인지 모델링과 컴퓨터 사회 시뮬레이션에서 연구된다.

인텔리전트 에이전트는 컴퓨터 프로그램과 유사한 추상적인 기능 시스템으로 도식적으로 설명되는 경우가 많습니다.인텔리전트 에이전트에 대한 추상적인 설명은 AIA(Abstract Intelligent Agent)라고 불리며 실제 구현과 구별됩니다.Autonomous Intelligent Agent는 사람의 개입 없이 기능하도록 설계되어 있습니다.인텔리전트 에이전트는 소프트웨어 에이전트(사용자 대신 태스크를 수행하는 자율 컴퓨터 프로그램)와도 밀접하게 관련되어 있습니다.

인공지능의 정의

컴퓨터 공학은 인공지능 연구를 지능형 에이전트에 대한 학문으로 정의한다.[a] 주요 AI[5][6][7] 교과서는 "에이전트"를 다음과 같이 정의하고 있습니다.

- "센서를 통해 환경을 인식하고 액추에이터를 통해 해당 환경에 작용한다고 볼 수 있는 모든 것"

는, 다음과 같이 「스위치 에이전트」를 정의합니다.

- "과거 경험과 지식을 바탕으로 성과 측정의 기대 가치를 극대화하는 역할을 하는 에이전트입니다."

「인공지능」연구의 분야를 다음과 같이 정의하고 있습니다.

- "합리적인 작용제의 연구 및 설계"

카플란과 Hanlein은 AI에 대해 "외부 데이터를 올바르게 해석하고, 그러한 데이터로부터 배우고, 그러한 [8]학습을 유연한 적응을 통해 특정 목표와 과제를 달성하기 위해 사용하는 시스템의 능력"이라고 비슷한 정의를 내렸다.

Padgham & Winikoff(2005)는 인텔리전트 에이전트가 환경에 배치되어 환경 변화에 시기적절하게(꼭 실시간은 아니지만) 대응한다는 점에 동의합니다.그러나 인텔리전트 에이전트도 유연하고 [b]견고한 방법으로 적극적으로 목표를 추구해야 합니다.선택적 요구 사항에는 에이전트가 합리적이어야 하며 에이전트가 믿음-욕망-의도 [9]분석을 수행할 수 있어야 합니다.

이 정의의 장점

철학적으로, 그것은 여러 줄의 비판을 피한다.튜링 테스트와 달리, 그것은 어떤 식으로든 인간의 지능을 지칭하지 않는다.따라서 그것이 "실제"인지 "시뮬레이션"인지 지능인지(즉, "합성" 대 "인공" 지능)에 대해서는 논할 필요가 없으며, 그러한 기계가 마음, 의식 또는 진정한 이해를 가지고 있음을 나타내지 않는다(즉, 존 설의 "강력한 AI 가설"을 의미하는 것은 아니다).또, 「지능적인」행동과 「지능적이지 않은」행동을 명확하게 구분하려고 하지 않습니다.프로그램은 객관적인 기능에 의해서만 측정하면 됩니다.

더 중요한 것은, AI 연구를 진전시키는데 도움을 준 많은 실질적인 이점을 가지고 있다는 것이다.프로그램을 테스트하기 위한 신뢰성 있고 과학적인 방법을 제공합니다.연구자는 특정 "목표 기능"을 최대화하는 데 가장 적합한 에이전트를 질문함으로써 격리된 문제에 대한 다양한 접근 방식을 직접 비교하거나 결합할 수 있습니다.또한 수학적 최적화('목표'로 정의됨)나 경제('합리적 에이전트'[10]와 동일한 정의를 사용함)와 같은 다른 분야와 통신하기 위한 공통 언어를 제공합니다.

목적함수

명시적인 "목표 함수"가 할당된 에이전트는 프로그래밍된 목표 함수를 성공적으로 최대화하는 액션을 일관되게 수행할 경우 보다 지능적인 것으로 간주됩니다.목표는 단순("IA가 바둑에서 이기는 경우 1, 그렇지 않은 경우 0") 또는 복잡("과거에 성공한 것과 수학적으로 유사한 작업을 수행"할 수 있습니다."목표 함수"에는 에이전트가 행동하도록 유도되는 모든 목표가 캡슐화되어 있습니다.또한 합리적인 에이전트의 경우, 이 함수는 상충하는 목표의 달성 간에 허용 가능한 트레이드오프를 캡슐화합니다.(용어는 다양합니다.예를 들어 일부 에이전트는 "유틸리티 함수", "객관적 함수" 또는 "손실 함수"를 최대화 또는 최소화하려고 합니다.) [6][7]。

목표는 명시적으로 정의되거나 유도될 수 있습니다.AI가 '강제학습'용으로 프로그램되면 어떤 행동을 장려하고 다른 행동을 처벌하는 '보복기능'이 있다.또는 진화 시스템은 동물들이 [11]먹이를 찾는 것과 같은 특정한 목표를 본능적으로 추구하도록 진화한 것과 마찬가지로 "적합성 함수"를 사용하여 고득점 AI 시스템을 돌연변이시키고 우선적으로 복제함으로써 목표를 유도할 수 있다.가장 가까운 이웃과 같은 일부 AI 시스템은 훈련 [12]데이터에 목표가 암묵적인 정도를 제외하고는 일반적으로 목표가 주어지지 않는다.이러한 시스템은 비목표 시스템이 좁은 분류 [13]작업을 수행하는 "목표"를 가진 시스템으로 프레임화 되어도 벤치마킹할 수 있다.

지식 표현 시스템과 같이 전통적으로 에이전트로 간주되지 않았던 시스템은 가능한 한 정확하게 질문에 대답하는 것을 목표로 하는 에이전트로 프레이밍함으로써 패러다임에 포함되기도 한다. 여기서 "행동"의 개념은 질문에 대답하는 "행위"를 포함하도록 확장된다.추가적인 확장으로, 모방 구동 시스템은 IA가 원하는 [6][7]동작을 얼마나 가깝게 모방하는지에 따라 "목표 함수"를 최적화하는 에이전트로 프레임화될 수 있습니다.2010년대의 생성적 적대 네트워크에서 "인코더"/"제너레이터" 구성요소는 인간의 텍스트 구성을 모방하고 즉흥적으로 표현하려고 시도한다.생성기는 적대적인 "예측 변수"/"차별자"[14] 구성 요소를 얼마나 잘 속일 수 있는지 캡슐화하는 함수를 최대화하려고 시도하고 있습니다.

GOFAI 시스템은 종종 명시적 목표 함수를 받아들이지만, 패러다임은 신경 네트워크와 진화 컴퓨팅에도 적용될 수 있다.강화 학습은 "보상의 기능"[15]을 극대화하기 위해 의도된 방식으로 작동하는 것으로 보이는 지능형 에이전트를 생성할 수 있습니다.때때로 기계 학습 프로그래머는 보상 함수를 원하는 벤치마크 평가 함수와 직접 같게 설정하는 대신 보상 쉐이핑을 사용하여 [16]학습의 점진적 진행에 대한 보상을 기계에 제공합니다.얀 레쿤은 2018년에 "사람들이 생각해낸 대부분의 학습 알고리즘은 본질적으로 어떤 객관적인 [17]기능을 최소화하는 것으로 구성되어 있다"고 말했다.알파제로 체스는 단순한 목적 함수를 가지고 있었다. 각각의 승리는 +1점으로 계산되었고, 각각의 패배는 -1점으로 계산되었다.자가운전 자동차의 객관적 기능은 [18]더 복잡해야 할 것이다.진화적 컴퓨팅은 각 에이전트의 [4]탈퇴가 허용되는 후손 수에 영향을 미치는 "적합성 기능"을 최대화하는 것으로 보이는 인텔리전트 에이전트를 진화시킬 수 있습니다.

이론적이고 계산하기 어려운 AIXI 설계는 [19]이 패러다임에서 가장 지능적인 에이전트입니다. 그러나 실제 환경에서는 IA가 한정된 시간과 하드웨어 자원에 의해 제약을 받고 있으며, 과학자들은 실제 [20][relevant?]하드웨어를 사용하여 벤치마크 테스트에서 점진적으로 더 높은 점수를 얻을 수 있는 알고리즘을 생산하기 위해 경쟁합니다.

인텔리전트 에이전트 클래스

러셀과 노비그의 분류

Russell & Norvig(2003)는 에이전트의 인식된 지능과 [21]능력에 따라 에이전트를 5개의 클래스로 분류합니다.

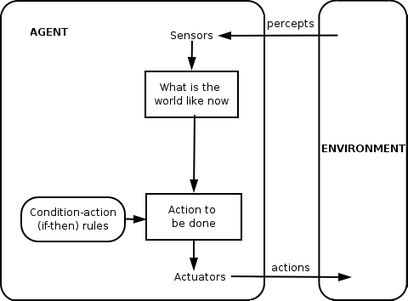

심플 리플렉스제

단순 반사 작용제는 현재 인식에 기초해서만 작용하고 나머지 지각 이력은 무시합니다.에이전트 함수는 조건-액션 규칙인 "조건이면 액션"에 기초합니다.

이 에이전트 기능은 환경을 완전히 관찰할 수 있는 경우에만 성공합니다.일부 반사 작용제에는 이미 작동기가 트리거된 조건을 무시할 수 있는 현재 상태에 대한 정보도 포함될 수 있습니다.

무한 루프는 부분적으로 관측 가능한 환경에서 작동하는 단순 리플렉스 에이전트의 경우 피할 수 없는 경우가 많습니다.주의: 에이전트가 액션을 랜덤화할 수 있는 경우 무한 루프에서 벗어날 수 있습니다.

모델 기반 반사 작용제

모델 기반 에이전트는 부분적으로 관찰 가능한 환경을 처리할 수 있습니다.현재 상태는 에이전트 내부에 저장되며 볼 수 없는 세계의 일부를 설명하는 일종의 구조를 유지합니다."세계의 구조"에 대한 이러한 지식을 세계의 모델이라고 하며, 따라서 "모델 기반 에이전트"라고 합니다.

모델 기반 반사 작용자는 지각 이력에 따라 달라지며 따라서 적어도 현재 상태의 관찰되지 않은 일부 측면을 반영하는 일종의 내부 모델을 유지해야 한다.내부 모델을 사용하여 인식 이력과 행동이 환경에 미치는 영향을 파악할 수 있습니다.그런 다음 리플렉스 에이전트와 같은 방법으로 액션을 선택합니다.

에이전트는 모델을 사용하여 환경에서 [22]다른 에이전트의 동작을 설명하고 예측할 수도 있습니다.

목표 기반 에이전트

목표 기반 에이전트는 "목표" 정보를 사용하여 모델 기반 에이전트의 기능을 더욱 확장합니다.목표 정보는 바람직한 상황을 기술합니다.이를 통해 에이전트는 여러 가지 가능성 중에서 목표 상태에 도달할 가능성을 선택할 수 있습니다.검색 및 계획은 에이전트의 목표를 달성하는 액션 시퀀스를 찾는 데 전념하는 인공지능의 하위 필드입니다.

유틸리티 기반 에이전트

목표 기반 에이전트는 목표 상태와 비목표 상태만 구분합니다.또한 특정 상태가 얼마나 바람직한지에 대한 척도를 정의할 수도 있습니다.이 측정치는 상태를 해당 주의 효용 측정치에 매핑하는 효용 함수를 사용하여 얻을 수 있다.보다 일반적인 퍼포먼스 측정치를 사용하면 에이전트의 목표를 얼마나 잘 충족시켰는지에 따라 다른 세계 상태를 비교할 수 있습니다.유틸리티라는 용어는 에이전트가 얼마나 "행복한" 상태인지를 나타내는 데 사용할 수 있습니다.

합리적인 효용 기반 에이전트는 액션 결과의 기대 효용을 극대화하는 액션, 즉 각 결과의 확률과 효용성을 고려하여 에이전트가 평균적으로 도출할 것으로 기대하는 액션을 선택한다.유틸리티 기반 에이전트는 인식, 표현, 추론 및 학습에 대한 많은 연구가 수반된 작업인 환경을 모델링하고 추적해야 합니다.

학습 에이전트

학습은 에이전트가 처음에 알려지지 않은 환경에서 작업할 수 있고, 초기 지식만으로 허용할 수 있는 것보다 더 능숙해질 수 있다는 장점이 있습니다.가장 중요한 차이는 개선을 담당하는 "학습 요소"와 외부 행동을 선택하는 "성과 요소"의 차이입니다.

학습 요소는 에이전트가 어떻게 동작하고 있는지에 대한 "평론가"의 피드백을 사용하여 앞으로 더 잘하기 위해 연기 요소 또는 "배우"를 어떻게 수정해야 하는지 결정합니다.퍼포먼스 요소는 지금까지 에이전트 전체로 간주되어 왔습니다.인식을 받아들여 액션을 결정합니다.

학습 에이전트의 마지막 구성 요소는 "문제 발생기"입니다.새롭고 유익한 경험을 할 수 있는 행동을 제안할 책임이 있습니다.

바이스 분류

Weiss(2013)는 에이전트의 4가지 클래스를 정의합니다.

- 논리 기반의 에이전트– 실행할 액션에 대한 결정은 논리적인 추론을 통해 이루어집니다.

- 사후 대응형 에이전트 – 의사결정이 어떤 형태로든 상황으로부터 행동으로 직접 매핑되어 구현됩니다.

- 신념-희망-의도 에이전트– 의사결정이 에이전트의 신념, 소망 및 의도를 나타내는 데이터 구조의 조작에 의존합니다.마지막으로,

- 계층형 아키텍처 – 다양한 소프트웨어 계층을 통해 의사결정이 실현됩니다.각 계층은 추상화 수준이 다른 환경에 대해 어느 정도 명확하게 추론합니다.

에이전트 계층

현재 인텔리전트 에이전트는 기능을 능동적으로 수행하기 위해 많은 "하위 에이전트"를 포함하는 계층 구조로 수집됩니다.지능형 하위 에이전트가 하위 수준의 기능을 처리하고 수행합니다.인텔리전트 에이전트와 서브 에이전트를 조합하여 인텔리전스의 형태를 나타내는 동작과 응답으로 어려운 태스크 또는 목표를 달성할 수 있는 완전한 시스템을 구축합니다.

일반적으로 본체를 센서와 액추에이터로 분리하여 세계를 컨트롤러의 입력으로 받아들여 액추에이터에 명령어를 출력하는 복잡한 지각 시스템으로 작동하도록 에이전트를 구성할 수 있다.그러나 컨트롤러 계층의 계층은 종종 낮은 수준의 태스크에 필요한 즉각적인 반응과 복잡하고 높은 수준의 [23]목표에 대한 느린 추론의 균형을 맞추기 위해 필요합니다.

에이전트 기능

단순 에이전트 프로그램은 가능한 모든 지각 시퀀스를 에이전트가 수행할 수 있는 가능한 액션 또는 최종 액션에 영향을 미치는 계수, 피드백 요소, 함수 또는 상수에 매핑하는 함수 f('에이전트 함수'[24]라고 함)로 수학적으로 정의할 수 있습니다.

에이전트 함수는 개별 옵션의 효용 계산, 논리 규칙에 대한 추론, 퍼지 논리 [25]등 다양한 의사결정 원칙을 포함할 수 있는 추상 개념이다.

대신 프로그램 에이전트는 가능한 모든 인식을 [26]액션에 매핑합니다.

persept라는 용어는 에이전트의 지각 입력을 가리키는 데 사용됩니다.다음 그림에서 에이전트는 센서를 통해 환경을 인식하고 액추에이터를 통해 해당 환경에 작용하는 것으로 볼 수 있습니다.

적용들

이 섹션에는 기사의 주제와 관련이 없거나 불충분한 자료가 포함될 수 있습니다.주제가 아닌 자료는 다른 기사인 소프트웨어 에이전트의 주제입니다. 의 이 에서 이 에 대해 논의해 . (2021년) ( 의과 삭제 에 대해 합니다) |

인텔리전트 에이전트는 자동화된 온라인 어시스턴트로 적용되어 개별화된 고객 서비스를 수행하기 위해 고객의 요구를 인식하는 기능을 합니다.이러한 에이전트는 기본적으로 대화 시스템, 아바타 및 사용자에게 [citation needed]특정 전문 지식을 제공하는 전문가 시스템으로 구성됩니다.또한 온라인에서 [27]인간 그룹의 조정을 최적화하는 데 사용할 수 있습니다.Hallerbach 등은 시험 대상 차량의 디지털 트윈과 독립 [28]에이전트를 기반으로 한 미시적 교통 시뮬레이션을 통해 자동 주행 시스템의 개발과 검증을 위한 에이전트 기반 접근법의 적용을 논의했다.Waymo는 자율주행차 [29][30]알고리즘을 테스트하기 위해 멀티에이전트 시뮬레이션 환경 Carcraft를 만들었습니다.운전자, 보행자 및 자동화 차량 간의 교통 상호작용을 시뮬레이션합니다.사람의 행동은 실제 인간 행동의 데이터를 바탕으로 인위적인 에이전트에 의해 모방된다.에이전트 기반 모델을 사용하여 자가운전 자동차를 이해하는 기본 아이디어는 2003년에 [31]논의되었습니다.

대체 정의 및 용도

인텔리전트 에이전트(Intelligent Agent)는 애매한 마케팅 용어로도 자주 사용되며, 때로는 가상 퍼스널 어시스턴트(virtual personal [32]assistant)와 동의어로도 사용됩니다.일부 20세기 정의에서는 에이전트를 사용자를 지원하거나 사용자를 [33]대신하는 프로그램으로 특징짓습니다.이러한 예를 소프트웨어 에이전트라고 하며 "인텔리전트 소프트웨어 에이전트"(인텔리전트 소프트웨어 에이전트)를 "인텔리전트 에이전트"라고 부르기도 합니다.

Nikola Kasabov에 따르면 IA 시스템은 다음과 같은 특성을 [34]보여야 합니다.

- 새로운 문제 해결 규칙을 점진적으로 수용합니다.

- 온라인 및 실시간 적응

- 행동, 오류 및 성공 측면에서 자신을 분석할 수 있습니다.

- 환경과의 상호작용을 통한 학습 및 개선(배양)

- 대량의 데이터로부터 신속하게 학습

- 메모리 기반의 샘플 스토리지 및 검색 용량 보유

- 단기 및 장기 기억력, 경과시간, 망각 등을 나타내는 파라미터를 설정합니다.

「 」를 참조해 주세요.

- 소프트웨어 에이전트

- 인지 아키텍처

- 인지 무선 – 구현을 위한 실용적인 분야

- 컴퓨터 공학

- 사이버네틱스

- 데이터 마이닝 에이전트

- 내장 에이전트

- 통합 검색 – 에이전트가 단일 어휘를 사용하여 이기종 데이터 소스를 검색할 수 있습니다.

- 퍼지 에이전트– 적응형 퍼지 논리로 구현된 IA

- GOAL 에이전트 프로그래밍 언어

- 지성

- 인텔리전트 시스템

- JACK 인텔리전트 에이전트

- 멀티 에이전트 시스템 및 멀티 에이전트 시스템– 여러 인터랙티브 에이전트

- 에이전트 환경의 PEAS 분류

- 강화 학습

- 시맨틱 웹 – 에이전트가 자동으로 처리할 수 있도록 웹상의 데이터를 제공합니다.

- 시뮬레이트 리얼리티

- 소셜 시뮬레이션

- 인텔리전트 에이전트 시대

메모들

인라인 참조

- ^ a b 러셀 & 노비그 2003, 2부

- ^ Bringjord, Selmer and Govindarajulu, Naveen Sundar, "인공지능", 스탠포드 철학 백과사전(2020년 여름판), Edward N. Zalta(ed), URL = https://plato.stanford.edu/archives/sum2020/entries/artificial-intelligence/

- ^ Wolchover, Natalie (30 January 2020). "Artificial Intelligence Will Do What We Ask. That's a Problem". Quanta Magazine. Retrieved 21 June 2020.

- ^ a b 헛소리, 래리."모델 기반의 진화적 계산"소프트 컴퓨팅 3, No.2(1999년): 76-82.

- ^ 러셀 & 노비그 2003, 페이지 4-5, 32, 35, 36, 56.

- ^ a b c 러셀 & 노비그 (2003)

- ^ a b c Bringjord, Selmer and Govindarajulu, Naveen Sundar, "인공지능", 스탠포드 철학 백과사전(2020년 여름판), Edward N. Zalta(ed.), 곧 공개될 URL = <https://plato.stanford.edu/archives/sum2020/entries/artificial-intelligence/>.

- ^ Kaplan, Andreas; Haenlein, Michael (1 January 2019). "Siri, Siri, in my hand: Who's the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence". Business Horizons. 62 (1): 15–25. doi:10.1016/j.bushor.2018.08.004. S2CID 158433736.

- ^ 린 파검과 마이클 위니코프입니다.인텔리전트 에이전트 시스템 개발: 실용적인 가이드.제13권John Wiley & Sons, 2005.

- ^ 러셀 & 노비그 2003, 페이지 27

- ^ 도밍고스 2015 5장

- ^ 도밍고스 2015, 7장

- ^ 린덴바움, M., 마르코비치, S. 및 루사코프, D. (2004)가장 가까운 네이버 분류자의 선택적 샘플링.기계학습, 54(2), 125~152.

- ^ "Generative adversarial networks: What GANs are and how they've evolved". VentureBeat. 26 December 2019. Retrieved 18 June 2020.

- ^ Wolchover, Natalie (January 2020). "Artificial Intelligence Will Do What We Ask. That's a Problem". Quanta Magazine. Retrieved 18 June 2020.

- ^ Andrew Y. Ng, Daishi Harada, Stuart Russell."보상 전환에 따른 정책 불변성:이론과 응용을 통해 보상형성을 실현합니다.ICML, vol. 99, 페이지 278-287. 1999.

- ^ 마틴 포드.인텔리전스 설계자:AI에 대한 진실을 만드는 사람들로부터.Packt Publishing Ltd, 2018.

- ^ "Why AlphaZero's Artificial Intelligence Has Trouble With the Real World". Quanta Magazine. 2018. Retrieved 18 June 2020.

- ^ Adams, Sam; Arel, Itmar; Bach, Joscha; Coop, Robert; Furlan, Rod; Goertzel, Ben; Hall, J. Storrs; Samsonovich, Alexei; Scheutz, Matthias; Schlesinger, Matthew; Shapiro, Stuart C.; Sowa, John (15 March 2012). "Mapping the Landscape of Human-Level Artificial General Intelligence". AI Magazine. 33 (1): 25. doi:10.1609/aimag.v33i1.2322.

- ^ Hutson, Matthew (27 May 2020). "Eye-catching advances in some AI fields are not real". Science AAAS. Retrieved 18 June 2020.

- ^ 러셀 & 노비그 2003, 46~54페이지

- ^ 스테파노 알브레히트와 피터 스톤(2018).Autonomous Agents Modeling Other Agents: 포괄적인 조사 및 미해결 문제인공지능, 제258권, 66-95페이지.https://doi.org/10.1016/j.artint.2018.01.002

- ^ Poole, David; Mackworth, Alan. "1.3 Agents Situated in Environments‣ Chapter 2 Agent Architectures and Hierarchical Control‣ Artificial Intelligence: Foundations of Computational Agents, 2nd Edition". artint.info. Retrieved 28 November 2018.

- ^ Russell & Norvig 2003, 33페이지

- ^ Salamon, Tomas (2011). Design of Agent-Based Models. Repin: Bruckner Publishing. pp. 42–59. ISBN 978-80-904661-1-1.

- ^ Nilsson, Nils J. (April 1996). "Artificial intelligence: A modern approach". Artificial Intelligence. 82 (1–2): 369–380. doi:10.1016/0004-3702(96)00007-0. ISSN 0004-3702.

- ^ Shirado, Hirokazu; Christakis, Nicholas A (2017). "Locally noisy autonomous agents improve global human coordination in network experiments". Nature. 545 (7654): 370–374. Bibcode:2017Natur.545..370S. doi:10.1038/nature22332. PMC 5912653. PMID 28516927.

- ^ Hallerbach, S.; Xia, Y.; Eberle, U.; Koester, F. (2018). "Simulation-Based Identification of Critical Scenarios for Cooperative and Automated Vehicles". SAE International Journal of Connected and Automated Vehicles. SAE International. 1 (2): 93. doi:10.4271/2018-01-1066.

- ^ Madrigal, Story by Alexis C. "Inside Waymo's Secret World for Training Self-Driving Cars". The Atlantic. Retrieved 14 August 2020.

- ^ Connors, J.; Graham, S.; Mailloux, L. (2018). "Cyber Synthetic Modeling for Vehicle-to-Vehicle Applications". In International Conference on Cyber Warfare and Security. Academic Conferences International Limited: 594-XI.

- ^ Yang, Guoqing; Wu, Zhaohui; Li, Xiumei; Chen, Wei (2003). "SVE: embedded agent based smart vehicle environment". Proceedings of the 2003 IEEE International Conference on Intelligent Transportation Systems. 2: 1745–1749 vol.2. doi:10.1109/ITSC.2003.1252782. ISBN 0-7803-8125-4. S2CID 110177067.

- ^ Fingar, Peter (2018). "Competing For The Future With Intelligent Agents... And A Confession". Forbes Sites. Retrieved 18 June 2020.

- ^ 버진, 마크, 고다나 도디그-크렌코비치입니다"인공 에이전트에 대한 체계적인 접근." arXiv 프리프린트 arXiv:0902.3513(2009).

- ^ 카사보프 1998년

기타 참고 자료

- Domingos, Pedro (September 22, 2015). The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World. Basic Books. ISBN 978-0465065707.

- Russell, Stuart J.; Norvig, Peter (2003). Artificial Intelligence: A Modern Approach (2nd ed.). Upper Saddle River, New Jersey: Prentice Hall. Chapter 2. ISBN 0-13-790395-2.

- Kasabov, N. (1998). "Introduction: Hybrid intelligent adaptive systems". International Journal of Intelligent Systems. 13 (6): 453–454. doi:10.1002/(SICI)1098-111X(199806)13:6<453::AID-INT1>3.0.CO;2-K. S2CID 120318478.

- Weiss, G. (2013). Multiagent systems (2nd ed.). Cambridge, MA: MIT Press. ISBN 978-0-262-01889-0.