인공지능

Artificial intelligence| 에 관한 시리즈의 일부 |

| 인공지능 |

|---|

가장 넓은 의미의 인공지능(AI)은 생물의 자연스러운 지능이 아닌 기계, 특히 컴퓨터 시스템이 보여주는 지능입니다. 기계학습을 통한 지능적 행동의 자동화에 초점을 맞춘 컴퓨터과학의 연구 분야로서 기계가 자신의 환경을 인지하고 정의된 목표를 달성할 가능성을 극대화하는 행동을 할 수 있는 방법과 소프트웨어를 개발하고 연구합니다. 일반적으로 인간의 지능과 관련된 작업을 수행하기 위한 목적으로. 이러한 기계는 AI라고 할 수 있습니다.

AI 기술은 산업, 정부 및 과학 전반에 걸쳐 널리 사용됩니다. 일부 세간의 이목을 끄는 응용 프로그램에는 고급 웹 검색 엔진(예: 구글 검색), 추천 시스템(유튜브, 아마존 및 넷플릭스에서 사용), 사람의 말을 통한 상호 작용(예: 구글 어시스턴트, 시리 및 알렉사), 자율 주행 차량(예: 웨이모), 생성 및 창의적 도구(예: ChatGPT 및 AI 아트); 그리고 전략 게임(예: 체스 및 바둑)에서 초인적인 플레이 및 분석. 그러나 많은 AI 애플리케이션은 AI로 인식되지 않습니다: "일단 충분히 유용하고 충분히 흔해진 어떤 것이 더 이상 AI라는 꼬리표가 붙지 않기 때문에 많은 최첨단 AI는 종종 AI라고 불리지 않고 일반적인 애플리케이션으로 필터링되었습니다."[2][3]

앨런 튜링은 그가 기계 지능이라고 부르는 분야에서 실질적인 연구를 수행한 최초의 사람이었습니다.[4] 인공지능은 1956년 학문 분야로 설립되었습니다.[5] 이 분야는 여러 차례 낙관론을 [6][7]거쳐 AI 윈터로 알려진 실망과 자금 손실의 시기를 거쳤습니다.[8][9] 딥러닝이 이전의 모든 인공지능 기술을 능가한 2012년 [10]이후와 트랜스포머 아키텍처로 2017년 이후 자금과 관심이 급격히 증가했습니다.[11] 이로 인해 2020년대 초 인공지능 붐이 일었고, 미국에 기반을 둔 기업, 대학, 실험실이 압도적으로 인공지능의 상당한 발전을 개척했습니다.[12]

21세기 인공 지능의 사용 증가는 자동화 증가, 데이터 기반 의사 결정 및 다양한 경제 부문과 생활 영역에 AI 시스템을 통합하는 방향으로 사회 및 경제적 변화에 영향을 미치고 있으며, 이는 고용 시장, 의료, 정부, 산업 및 교육에 영향을 미칩니다. 이는 AI의 장기적인 효과, 윤리적 의미, 위험성에 대한 의문을 제기하여 기술의 안전성과 이점을 보장하기 위한 규제 정책에 대한 논의를 촉발합니다.

AI 연구의 다양한 하위 분야는 특정 목표와 특정 도구 사용을 중심으로 합니다. AI 연구의 전통적인 목표에는 추론, 지식 표현, 계획, 학습, 자연어 처리, 인식 및 로봇 공학 지원이 포함됩니다.[a] 인간이 수행할 수 있는 모든 작업을 최소한 동등한 수준에서 완료할 수 있는 일반 지능은 현장의 장기 목표 중 하나입니다.[13]

이러한 목표에 도달하기 위해 AI 연구원들은 통계, 운영 연구 및 경제학에 기반한 검색 및 수학적 최적화, 형식 논리, 인공 신경망 및 방법을 포함한 광범위한 기술을 채택하고 통합했습니다.[b] AI는 또한 심리학, 언어학, 철학, 신경 과학 및 기타 분야를 활용합니다.[14]

목표들

지능을 시뮬레이션(또는 생성)하는 일반적인 문제는 하위 문제로 나뉩니다. 이것들은 연구자들이 지능형 시스템이 보여줄 것으로 기대하는 특정 특성이나 능력으로 구성됩니다. 아래에 설명된 특징은 가장 많은 관심을 받았으며 AI 연구의 범위를 다룹니다.[a]

추론 및 문제해결

초기 연구자들은 인간이 퍼즐을 풀거나 논리적 추론을 할 때 사용하는 단계별 추론을 모방하는 알고리즘을 개발했습니다.[15] 1980년대 후반과 1990년대에는 확률과 경제학의 개념을 사용하여 불확실하거나 불완전한 정보를 처리하는 방법이 개발되었습니다.[16]

이 알고리즘들 중 많은 수는 문제가 커짐에 따라 기하급수적으로 느려지는 "결합 폭발"을 경험하기 때문에 큰 추론 문제를 해결하는 데 충분하지 않습니다.[17] 인간도 초기 AI 연구가 모델링할 수 있는 단계별 추론을 거의 사용하지 않습니다. 그들은 빠르고 직관적인 판단을 사용하여 대부분의 문제를 해결합니다.[18] 정확하고 효율적인 추론은 해결되지 않은 문제입니다.

지식표상

지식 표현 및 지식 공학은[19] AI 프로그램이 질문에 지능적으로 답하고 실제 사실에 대해 추론할 수 있도록 합니다. 형식적인 지식 표현은 콘텐츠 기반 인덱싱 및 검색,[20] 장면 해석,[21] 임상 의사 결정 지원,[22] 지식 발견(대규모 데이터베이스에서 "흥미롭고" 실행 가능한 추론을 마이닝하는 것) [23]및 기타 영역에서 사용됩니다.[24]

지식 기반은 프로그램에서 사용할 수 있는 형태로 표현된 지식의 집합입니다. 온톨로지는 특정 지식 영역에서 사용되는 객체, 관계, 개념 및 속성의 집합입니다.[25] 지식 기반은 사물, 속성, 범주 및 사물 간의 관계,[26] 상황, 이벤트 등을 나타낼 필요가 있습니다. 상태와 시간,[27] 원인과 결과,[28] 지식에 대한 지식(다른 사람들이 알고 있는 것에 대해 우리가 알고 있는 것),[29] 기본 추론(인간이 가정하는 것은 다르게 말해질 때까지 참이며 다른 사실이 변화할 때에도 계속 참일 것),[30] 그리고 지식의 많은 다른 측면과 영역.

지식 표현에서 가장 어려운 문제 중 하나는 상식적인 지식의 폭(보통 사람들이 알고 있는 원자적 사실의 집합은 엄청나다)[31]과 대부분의 상식적인 지식의 하위 기호 형식(사람들이 알고 있는 것의 대부분은 구두로 표현할 수 있는 "사실" 또는 "진술"로 표현되지 않음)입니다.[18] AI 애플리케이션을 위한 지식 획득의 어려움, 지식 획득의 어려움도 있습니다.[c]

계획 및 의사결정

"대리인"은 세상을 지각하고 행동하는 모든 것입니다. 합리적인 에이전트는 목표나 선호도를 가지고 있으며 이를 실현하기 위해 행동을 취합니다.[d][34] 자동화된 계획에서 에이전트는 특정 목표를 가지고 있습니다.[35] 자동화된 의사결정에서는 에이전트가 선호하는 상황과 피하려고 하는 상황이 있습니다. 의사결정 에이전트는 에이전트가 얼마나 선호하는지 측정하는 숫자를 각 상황("유틸리티"라고 함)에 할당합니다. 가능한 각 조치에 대해 "기대 효용", 즉 조치의 모든 가능한 결과의 효용을 결과가 발생할 확률로 가중치를 부여하여 계산할 수 있습니다. 그런 다음 최대 기대 효용으로 작업을 선택할 수 있습니다.[36]

고전적인 계획에서 에이전트는 어떤 행동의 효과가 무엇인지 정확히 알고 있습니다.[37] 그러나 대부분의 실제 문제에서 에이전트는 자신이 처한 상황에 대해 확신하지 못할 수 있으며("알 수 없음" 또는 "관찰할 수 없음") 각 가능한 조치 후에 어떤 일이 일어날지 확실히 알 수 없을 수 있습니다("결정적이지 않음"). 확률적 추측을 통해 액션을 선택한 다음 상황을 재평가하여 액션이 효과가 있는지 확인해야 합니다.[38]

일부 문제에서는 특히 다른 에이전트나 사람이 관련된 경우 에이전트의 선호도가 불확실할 수 있습니다. 이러한 것들은 (예: 역 강화 학습을 통해) 학습되거나 에이전트가 선호도를 개선하기 위한 정보를 찾을 수 있습니다.[39] 정보 가치 이론은 탐색적 또는 실험적 행동의 가치를 평가하는 데 사용될 수 있습니다.[40] 가능한 미래의 행동과 상황의 공간은 일반적으로 다루기 힘들 정도로 넓기 때문에 에이전트는 결과가 어떻게 될지 불확실한 상태에서 행동을 취하고 상황을 평가해야 합니다.

마르코프 의사결정 프로세스는 특정 행동이 특정한 방식으로 상태를 변화시킬 확률을 설명하는 전이 모델과 각 상태의 효용과 각 행동의 비용을 공급하는 보상 함수를 가지고 있습니다. 정책은 결정을 가능한 각 상태와 연결합니다. 정책은 (예를 들어, 반복에 의해) 계산될 수 있고, 휴리스틱일 수 있거나, 학습될 수 있습니다.[41]

게임 이론은 상호 작용하는 여러 에이전트의 합리적인 행동을 설명하며, 다른 에이전트와 관련된 의사 결정을 내리는 AI 프로그램에 사용됩니다.[42]

학습

기계 학습은 주어진 작업에 대한 성능을 자동으로 향상시킬 수 있는 프로그램을 연구하는 것입니다.[43] 처음부터 AI의 일부였습니다.[e]

기계 학습에는 여러 종류가 있습니다. 비지도 학습은 데이터 스트림을 분석하고 패턴을 찾아 다른 안내 없이 예측을 합니다.[46] 지도 학습에는 사람이 먼저 입력 데이터에 레이블을 지정해야 하며, 분류(입력이 어떤 범주에 속하는지 예측하는 방법을 프로그램이 학습해야 함)와 회귀(숫자 입력을 기반으로 숫자 함수를 추론해야 함)의 두 가지 주요 유형이 있습니다.[47]

강화 학습에서 에이전트는 좋은 반응에 대해 보상을 받고 나쁜 반응에 대해 처벌을 받습니다. 에이전트는 "좋음"으로 분류된 응답을 선택하는 방법을 배웁니다.[48] 전이 학습은 한 문제에서 얻은 지식이 새로운 문제에 적용되는 것입니다.[49] 딥 러닝은 이러한 모든 유형의 학습에 대해 생물학적으로 영감을 받은 인공 신경망을 통해 입력을 실행하는 기계 학습 유형입니다.[50]

계산 학습 이론은 계산 복잡성, 샘플 복잡성(필요한 데이터 양) 또는 최적화의 다른 개념으로 학습자를 평가할 수 있습니다.[51]

자연어 처리

자연어 처리([52]NLP)는 프로그램이 영어와 같은 인간의 언어로 읽고 쓰고 소통할 수 있도록 해줍니다. 구체적인 문제로는 음성 인식, 음성 합성, 기계 번역, 정보 추출, 정보 검색 및 질문 답변이 있습니다.[53]

노암 촘스키의 생성적 문법과 의미론적 네트워크를 기반으로 한 초기 작업은 (상식 지식 문제로[31] 인해) "마이크로 월드"라고 불리는 작은 영역에 국한되지 않는 한 단어 감각의[f] 모호성을 해소하는 데 어려움이 있었습니다. 마가렛 마스터먼은 언어를 이해하는 데 핵심은 문법이 아닌 의미이며 사전이 아닌 사전이 아닌 sauri가 계산 언어 구조의 기초가 되어야 한다고 믿었습니다.

NLP를 위한 최신 딥 러닝 기술에는 단어 임베딩(일반적으로 단어의 의미를 인코딩하는 벡터로 표현),[54] 트랜스포머(주의 메커니즘을 사용한 딥 러닝 아키텍처) [55]등이 있습니다.[56] 2019년에는 생성적 사전 훈련된 트랜스포머(또는 "GPT") 언어 모델이 일관성 있는 텍스트를 생성하기 시작했으며,[57][58] 2023년까지 이러한 모델은 변호사 시험, SAT 시험, GRE 시험 및 기타 많은 실제 응용 프로그램에서 인간 수준의 점수를 얻을 수 있었습니다.[59]

지각

기계 인식은 센서(예: 카메라, 마이크, 무선 신호, 액티브 라이다, 음파 탐지기, 레이더 및 촉각 센서)의 입력을 사용하여 세계의 측면을 추론하는 능력입니다. 컴퓨터 비전은 시각적 입력을 분석하는 능력입니다.[60]

이 분야에는 음성 인식,[61] 이미지 분류,[62] 얼굴 인식, 물체 인식,[63] 로봇 인식 등이 포함됩니다.[64]

소셜 인텔리전스

감성 컴퓨팅은 인간의 느낌, 감정 및 기분을 인식, 해석, 처리 또는 시뮬레이션하는 시스템으로 구성된 학제 간 우산입니다.[66] 예를 들어, 일부 가상 비서는 대화를 하거나 유머러스하게 농담을 하도록 프로그래밍되어 있습니다. 이는 인간 상호 작용의 감정 역학에 더 민감하게 보이거나 인간과 컴퓨터 간의 상호 작용을 촉진합니다.

그러나 이는 순진한 사용자에게 기존 [67]컴퓨터 에이전트의 지능에 대한 비현실적인 개념을 제공하는 경향이 있습니다. 감성 컴퓨팅과 관련된 중간 정도의 성공에는 텍스트 감정 분석과 최근에는 멀티모달 감정 분석이 포함되며, 여기에는 AI가 비디오 촬영된 피험자가 표시하는 영향을 분류합니다.[68]

일반지능

인공 일반 지능을 갖춘 기계는 인간의 지능과 유사한 폭과 범용성으로 매우 다양한 문제를 해결할 수 있어야 합니다.[13]

기술

AI 연구는 위의 목표를 달성하기 위해 다양한 기술을 사용합니다.[b]

검색 및 최적화

AI는 가능한 많은 솔루션을 지능적으로 검색하여 많은 문제를 해결할 수 있습니다.[69] AI에 사용되는 검색에는 상태 공간 검색과 로컬 검색이라는 두 가지 매우 다른 종류가 있습니다.

상태 공간 검색

상태 공간 검색은 가능한 상태 트리를 통해 검색하여 목표 상태를 찾습니다.[70] 예를 들어, 계획 알고리즘은 목표와 하위 목표의 트리를 검색하고 목표 목표에 대한 경로를 찾으려고 시도하며, 이 과정은 수단-목적 분석이라고 불립니다.[71]

단순한 철저한 검색만으로는[72] 대부분의 실제 문제에 충분하지 않습니다. 검색 공간(검색할 장소의 수)은 빠르게 천문학적 숫자로 증가합니다. 결과적으로 검색이 너무 느리거나 완료되지 않습니다.[17] 휴리스틱(heuristics) 또는 경험 법칙(rule of thumb)은 목표에 도달할 가능성이 높은 선택의 우선순위를 정하는 데 도움이 될 수 있습니다.[73]

적대적 검색은 체스나 바둑과 같은 게임을 하는 프로그램에 사용됩니다. 가능한 움직임의 나무를 탐색하고 반대로 움직이며 승리하는 위치를 찾습니다.[74]

로컬 검색

로컬 검색은 수학적 최적화를 사용하여 문제에 대한 해결책을 찾습니다. 그것은 어떤 형태의 추측으로 시작하여 점진적으로 정제합니다.[75]

경사 하강법은 손실 함수를 최소화하도록 점진적으로 조정하여 일련의 수치 매개 변수를 최적화하는 로컬 검색 유형입니다. 경사 하강의 변형은 일반적으로 신경망을 훈련하는 데 사용됩니다.[76]

또 다른 유형의 로컬 검색은 진화 계산으로, 각 세대에서 생존할 수 있는 최적의 솔루션만 선택하여 일련의 후보 솔루션을 "돌연변이"하고 "재결합"하여 반복적으로 개선하는 것을 목표로 합니다.[77]

분산 검색 프로세스는 군집 지능 알고리즘을 통해 조정할 수 있습니다. 검색에 사용되는 두 가지 인기 있는 군집 알고리즘은 입자 군집 최적화(새 떼에서 영감을 받은 것)와 개미 군집 최적화(개미 흔적에서 영감을 받은 것)입니다.[78]

논리

형식 논리는 추론 및 지식 표현에 사용됩니다.[79] 형식 논리는 크게 두 가지 형태로 나옵니다: 명제 논리(참이거나 거짓인 문장에 대해 작동하고 "그리고", "또는", "아니요", "임의"와 같은 논리적 연결을 사용함)[80]와 술어 논리(객체, 술어, 관계에 대해서도 작동하고 "모든 X는 Y"와 "Y인 X는 있다"[81]와 같은 계량기를 사용함).

논리학에서의 연역적 추론은 주어진 다른 진술(전제)로부터 새로운 진술(결론)을 증명하는 과정입니다.[82] 증명은 문장으로 노드에 레이블이 지정되고 추론 규칙으로 자식 노드가 부모 노드에 연결되는 증명 트리로 구성될 수 있습니다.

문제와 일련의 전제가 주어지면 문제 해결은 문제 해결책에 의해 루트 노드에 레이블이 지정되고 전제 또는 공리에 의해 리프 노드에 레이블이 지정된 증명 트리를 찾는 것으로 축소됩니다. 혼절의 경우 문제 해결 검색은 전제에서 앞으로 추론하거나 문제에서 뒤로 추론하여 수행할 수 있습니다.[83] 1차 논리의 폐쇄형의 보다 일반적인 경우, 해결은 공리가 없는 추론의 단일 규칙으로, 해결해야 할 문제의 부정을 포함하는 전제로부터 모순을 증명함으로써 문제를 해결합니다.[84]

혼절 논리와 1차 논리 모두에서 추론은 결정할 수 없으므로 다루기 어렵습니다. 그러나 논리 프로그래밍 언어인 Prolog에서 계산을 뒷받침하는 Horn 절로 역추론은 튜링이 완벽합니다. 또한 효율성은 다른 기호 프로그래밍 언어의 계산과 경쟁력이 있습니다.[85]

퍼지 논리는 0과 1 사이의 "진실의 정도"를 할당합니다. 따라서 모호하고 부분적으로 사실인 명제를 처리할 수 있습니다.[86]

부정을 실패로 하는 논리 프로그래밍을 포함한 비단조 논리는 기본 추론을 처리하도록 설계되었습니다.[30] 많은 복잡한 도메인을 설명하기 위해 다른 전문화된 버전의 로직이 개발되었습니다(위의 지식 표현 참조).

불확실한 추론을 위한 확률론적 방법

AI의 많은 문제(추론, 계획, 학습, 인식 및 로봇 공학 포함)는 에이전트가 불완전하거나 불확실한 정보를 가지고 작동해야 합니다. AI 연구진은 확률 이론과 경제학의 방법을 사용하여 이러한 문제를 해결하기 위해 여러 가지 도구를 고안했습니다.[87]

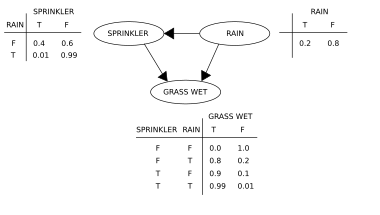

Bayesian networks[88] are a very general tool that can be used for many problems, including reasoning (using the Bayesian inference algorithm),[g][90] learning (using the expectation-maximization algorithm),[h][92] planning (using decision networks)[93] and perception (using dynamic Bayesian networks).[94]

확률적 알고리즘은 데이터 스트림에 대한 필터링, 예측, 평활화 및 설명 찾기에도 사용할 수 있으며, 인식 시스템이 시간이 지남에 따라 발생하는 프로세스(예: 숨겨진 마르코프 모델 또는 칼만 필터)를 분석하는 데 도움이 됩니다.[94]

결정 이론, 결정 분석,[95] 정보 가치 이론을 활용하여 에이전트가 어떻게 선택하고 계획할 수 있는지 분석하는 정밀한 수학 도구가 개발되었습니다.[96] 이러한 도구에는 마르코프 의사 결정 프로세스,[97] 동적 의사 결정 네트워크,[94] 게임 이론 및 메커니즘 설계와 같은 모델이 포함됩니다.[98]

분류기 및 통계 학습 방법

가장 간단한 AI 애플리케이션은 분류기(예: "그 다음에 다이아몬드가 반짝이면")와 컨트롤러(예: "그 다음에 다이아몬드가 집으면")의 두 가지 유형으로 나눌 수 있습니다. 분류기는[99] 패턴 매칭을 사용하여 가장 가까운 일치를 결정하는 기능입니다. 지도 학습을 사용하여 선택한 예를 기반으로 미세 조정할 수 있습니다. 각 패턴("관찰"이라고도 함)은 미리 정의된 특정 클래스로 레이블이 지정됩니다. 클래스 레이블과 결합된 모든 관측치를 데이터 집합이라고 합니다. 새로운 관측치가 수신되면 해당 관측치는 이전 경험을 기반으로 분류됩니다.[47]

많은 종류의 분류기가 사용되고 있습니다. 의사결정 트리는 가장 간단하고 널리 사용되는 상징적인 기계 학습 알고리즘입니다.[100] 1990년대 중반까지 가장 널리 사용된 아날로그 AI는 K-근접 이웃 알고리즘이었고, 1990년대에는 지원 벡터 머신(SVM)과 같은 커널 방식이 K-근접 이웃을 대체했습니다.[101] 순진한 베이즈 분류기는 부분적으로 확장성 때문에 구글에서 가장 널리 사용되는 "학습자"[102]라고 합니다.[103] 신경망은 분류기로도 사용됩니다.[104]

인공신경망

인공 신경망은 생물학적 뇌에서 뉴런을 느슨하게 모델링하는 인공 뉴런이라고도 하는 노드 모음을 기반으로 합니다. 패턴을 인식하도록 훈련됩니다. 일단 훈련되면 새로운 데이터에서 패턴을 인식할 수 있습니다. 입력, 적어도 하나의 숨겨진 노드 레이어 및 출력이 있습니다. 각 노드는 함수를 적용하고 가중치가 지정된 임계값을 초과하면 데이터가 다음 계층으로 전송됩니다. 네트워크에 적어도 2개의 은닉층이 있는 경우 일반적으로 심층 신경망이라고 합니다.[104]

신경망에 대한 학습 알고리즘은 로컬 검색을 사용하여 학습 중에 각 입력에 대해 올바른 출력을 얻을 수 있는 가중치를 선택합니다. 가장 일반적인 훈련 기법은 역전파 알고리즘입니다.[105] 신경망은 입력과 출력 사이의 복잡한 관계를 모델링하고 데이터에서 패턴을 찾는 방법을 배웁니다. 이론적으로 신경망은 모든 기능을 학습할 수 있습니다.[106]

피드포워드 신경망에서 신호는 한 방향으로만 전달됩니다.[107] 순환 신경망은 출력 신호를 입력으로 다시 공급하여 이전 입력 이벤트의 단기 기억을 허용합니다. 장단기 메모리는 순환 네트워크를 위한 가장 성공적인 네트워크 아키텍처입니다.[108] 퍼셉트론은[109] 단일 레이어의 뉴런만 사용하고 딥 러닝은[110] 여러 레이어를 사용합니다. 컨볼루션 신경망은 서로 "가까운" 뉴런 사이의 연결을 강화합니다. 이것은 이미지 처리에서 특히 중요한데, 여기서 뉴런의 로컬 세트는 네트워크가 물체를 식별하기 전에 "엣지"를 식별해야 합니다.[111]

딥러닝

딥 러닝은[110] 네트워크의 입력과 출력 사이에 여러 층의 뉴런을 사용합니다. 다중 레이어는 원시 입력에서 더 높은 수준의 특징을 점진적으로 추출할 수 있습니다. 예를 들어, 이미지 처리에서 하위 계층은 가장자리를 식별할 수 있는 반면, 상위 계층은 숫자 또는 문자 또는 얼굴과 같은 인간과 관련된 개념을 식별할 수 있습니다.[112]

딥 러닝은 컴퓨터 비전, 음성 인식, 자연어 처리, 이미지 분류[113] 등 인공 지능의 많은 중요한 하위 분야에서 프로그램의 성능을 크게 향상시켰습니다. 딥러닝이 이렇게 많은 애플리케이션에서 우수한 성능을 발휘하는 이유는 2023년 현재 알려지지 않았습니다.[114] 2012-2015년 딥 러닝의 갑작스러운 성공은 새로운 발견이나 이론적 돌파구 때문에 일어난 것이 아닙니다(딥 뉴럴 네트워크와 역전파는 많은 사람들에 의해 설명되었습니다). 1950년대로 거슬러 올라가지만,[i] 두 가지 요인으로 인해 컴퓨터 성능이 엄청나게 향상되고(GPU로 전환하여 속도가 100배 증가하는 것을 포함), 방대한 양의 훈련 데이터, 특히 ImageNet과 같은 벤치마크 테스트에 사용되는 거대한 큐레이팅된 데이터 세트의 가용성이 증가했습니다.[j]

GPT

생성 사전 학습된 변환기(GPT)는 문장의 단어 간의 의미 관계(자연어 처리)를 기반으로 하는 대규모 언어 모델입니다. 텍스트 기반 GPT 모델은 인터넷에서 얻을 수 있는 대규모 텍스트 말뭉치에 대해 사전 학습됩니다. 사전 교육은 다음 토큰(일반적으로 토큰은 단어, 하위 단어 또는 구두점)을 예측하는 것으로 구성됩니다. 이 사전 훈련을 통해 GPT 모델은 세계에 대한 지식을 축적한 다음 다음 토큰을 반복적으로 예측하여 인간과 같은 텍스트를 생성할 수 있습니다. 일반적으로, 후속 훈련 단계는 일반적으로 인간 피드백으로부터 강화 학습(RLHF)이라는 기술을 사용하여 모델을 보다 진실하고 유용하며 무해하게 만듭니다. 현재 GPT 모델은 RLHF 및 품질 데이터로 이를 줄일 수 있지만 여전히 "허리큐네이션"이라는 허위를 생성하는 경향이 있습니다. 간단한 텍스트로 질문하거나 작업을 요청할 수 있는 챗봇에 사용됩니다.[123][124]

현재 모델 및 서비스는 다음과 같습니다. 제미니(구 바드), ChatGPT, 그록, 클로드, 코파일럿 및 LLaMA. 멀티모달 GPT 모델은 이미지, 비디오, 사운드 및 텍스트와 같은 다양한 유형의 데이터(모달리티)를 처리할 수 있습니다.

전문 하드웨어 및 소프트웨어

2010년대 후반, 점점 더 AI에 특화된 향상된 기능으로 설계되고 전문 텐서플로우 소프트웨어와 함께 사용되는 그래픽 처리 장치(GPU)는 이전에 사용되었던 중앙 처리 장치(CPU)를 대규모(상업 및 학술) 기계 학습 모델의 훈련을 위한 지배적인 수단으로 대체했습니다.[127] 역사적으로 리스프, 프롤로그, 파이썬 등과 같은 전문 언어가 사용되었습니다.

적용들

검색 엔진(구글 검색 등), 온라인 광고 대상 추천 시스템(넷플릭스, 유튜브 또는 아마존 제공), 인터넷 트래픽 구동, 대상 광고(애드센스, 페이스북) 등 2020년대의 필수 애플리케이션 대부분에 AI 및 머신 러닝 기술이 사용됩니다. 가상 비서(Siri 또는 Alexa 등), 자율 주행 자동차(드론, ADAS 및 자율 주행 자동차 포함), 자동 언어 번역(Microsoft Translator, Google Translate), 얼굴 인식(Apple의 Face ID 또는 Microsoft의 DeepFace 및 Google의 FaceNet) 및 이미지 라벨링(Facebook, Apple의 iPhoto 및 TikTok에서 사용).

건강과 의학

의학 및 의학 연구에 AI를 적용하면 환자 치료와 삶의 질을 높일 수 있습니다.[128] 히포크라테스 선서의 렌즈를 통해 의료 전문가들은 애플리케이션이 환자를 더 정확하게 진단하고 치료할 수 있다면 AI를 윤리적으로 사용해야 합니다.

의료 연구를 위해 AI는 빅 데이터를 처리하고 통합하는 중요한 도구입니다. 이것은 현미경 이미징을 제작의 핵심 기술로 사용하는 오가노이드 및 조직 공학 개발에 특히 중요합니다.[129] AI가 다양한 연구 분야에 할당된 자금의 불일치를 극복할 수 있다고 제안되었습니다.[129] 새로운 AI 도구는 생물 의학적으로 관련된 경로에 대한 이해를 심화시킬 수 있습니다. 예를 들어, AlphaFold 2(2021)는 단백질의 3D 구조를 몇 달이 아닌 몇 시간 만에 근사화할 수 있는 능력을 입증했습니다.[130] 2023년에는 AI가 안내한 약물 발견이 두 가지 유형의 약물 내성 박테리아를 죽일 수 있는 항생제 종류를 찾는 데 도움이 되었다고 보고되었습니다.[131]

게임.

게임 플레이 프로그램은 1950년대부터 AI의 가장 발전된 기술을 시연하고 테스트하기 위해 사용되었습니다.[132] 딥 블루는 1997년 5월 11일 현재 세계 체스 챔피언인 게리 카스파로프를 이긴 최초의 컴퓨터 체스 게임 시스템이 되었습니다.[133] 2011년, 지오파디! 퀴즈 쇼 시범 경기에서, IBM의 질문 답변 시스템인 왓슨이 두 명의 가장 위대한 지오파디! 챔피언인 브래드 루터와 켄 제닝을 현저한 차이로 이겼습니다.[134] 2016년 3월 알파고는 바둑 챔피언 이세돌과의 대국에서 5전 4승을 거두며 컴퓨터 바둑 시스템으로는 최초로 핸디캡 없이 프로 바둑 선수를 꺾었습니다. 그리고 2017년에 세계 최고의 바둑 선수였던 커제를 이겼습니다.[135] 다른 프로그램들은 포커 게임 프로그램인 플루리버스와 같이 불완전한 정보 게임을 취급합니다.[136] DeepMind는 체스, 바둑 또는 아타리 게임을 하도록 훈련될 수 있는 MuZero와 같은 점점 더 일반적인 강화 학습 모델을 개발했습니다.[137] 2019년 딥마인드의 알파스타는 지도에서 일어나는 일에 대한 불완전한 지식을 포함하는 특히 도전적인 실시간 전략 게임인 스타크래프트 II에서 그랜드마스터 레벨을 달성했습니다.[138] 2021년에는 AI 에이전트가 플레이스테이션 그란투리스모 대회에 출전하여 심층 강화 학습을 사용하여 세계 최고의 그란투리스모 드라이버 4명을 상대로 우승했습니다.[139]

군사의

다양한 국가에서 AI 군사 애플리케이션을 배치하고 있습니다.[140] 주요 애플리케이션은 명령 및 제어, 통신, 센서, 통합 및 상호 운용성을 향상시킵니다.[141] 정보 수집 및 분석, 물류, 사이버 운영, 정보 운영, 반자율 및 자율 주행 차량을 대상으로 하는 연구입니다.[140] AI 기술은 센서와 이펙터의 조정, 위협 탐지 및 식별, 적 위치 표시, 목표물 획득, 조정 및 유인 팀과 무인 팀이 참여하는 네트워크 전투 차량 간의 분산 합동 화재의 충돌을 가능하게 합니다.[141] AI는 이라크와 시리아의 군사 작전에 통합되었습니다.[140]

2023년 11월 카멀라 해리스 미국 부통령은 31개국이 서명한 IA 군사용 가드레일 설치 선언문을 공개했습니다. 약속에는 국제법을 준수하는 군사 AI를 보장하기 위해 법률 검토를 사용하고 이 기술 개발에 신중하고 투명하게 대처하는 것이 포함됩니다.[142]

제너레이티브 AI

2020년대 초, 제너레이티브 AI는 널리 알려졌습니다. 2023년 3월 미국 성인의 58%가 ChatGPT에 대해 들어본 적이 있고 14%가 시도해 본 적이 있습니다. Midjourney, DALL-E 및 Stable Diffusion과 같은 AI 기반 텍스트-투-이미지 생성기의 사실성과 사용 편의성이 증가함에 따라 바이러스 AI 생성 사진의 트렌드가 촉발되었습니다. 프란치스코 교황이 흰색 퍼퍼 코트를 입고 있는 가짜 사진, 도널드 트럼프의 가상 체포, 국방부 공격에 대한 조작, 전문 창작 예술에서의 사용으로 광범위한 관심을 끌었습니다.[144][145]

산업별 업무

특정 산업이나 기관의 특정 문제를 해결하는 데 사용되는 수천 개의 성공적인 AI 애플리케이션도 있습니다. 2017년 설문조사에서 5개 회사 중 1개 회사가 일부 제품이나 프로세스에 "AI"를 통합했다고 보고했습니다.[146] 에너지 저장, 의료 진단, 군사 물류, 사법 결정, 외교 정책 또는 공급망 관리의 결과를 예측하는 애플리케이션 등이 그 예입니다.

농업에서 AI는 농부들이 관개, 비료, 살충제 처리 또는 수확량 증가가 필요한 지역을 식별하는 데 도움이 되었습니다. 농학자들은 AI를 사용하여 연구 개발을 수행합니다. AI를 활용해 토마토 등 농작물의 숙성시간 예측, 토양수분 모니터링, 농업용 로봇 작동, 예측분석, 가축돼지콜 감정분류, 온실 자동화, 질병·해충 감지, 물 절약 등을 해왔습니다.

인공 지능은 천문학에서 사용 가능한 데이터와 응용 프로그램의 증가하는 양을 분석하는 데 사용되며, 주로 외계 행성 발견, 태양 활동 예측, 새로운 과학적 통찰력 개발, 분류, 회귀, 클러스터링, 예측, 생성, 발견 및 개발에 사용됩니다. 그리고 중력파 천문학에서 신호와 도구 효과를 구별합니다. 또한 우주 탐사와 같은 우주에서의 활동에 사용될 수 있으며, 우주 임무의 데이터 분석, 우주선의 실시간 과학 결정, 우주 파편 회피 및 보다 자율적인 운영을 포함합니다.

윤리

AI는 다른 강력한 기술과 마찬가지로 잠재적인 이점과 잠재적인 위험을 가지고 있습니다. 인공지능은 과학을 발전시키고 심각한 문제에 대한 해결책을 찾을 수 있습니다. 딥마인드의 데미스 하사비스(Demis Hassabis)는 "지능을 해결하고, 그 후 그것을 사용하여 다른 모든 것을 해결하기를" 바라고 있습니다.[147] 그러나 AI의 사용이 광범위해짐에 따라 몇 가지 의도하지 않은 결과와 위험이 확인되었습니다.[148]

머신 러닝을 실제 운영 중인 시스템의 일부로 사용하려는 사람은 AI 교육 프로세스에 윤리를 고려하고 편견을 피하기 위해 노력해야 합니다. 딥러닝에서 본질적으로 설명할 수 없는 AI 알고리즘을 사용할 때 특히 그렇습니다.[149]

위험 및 위해

개인정보 및 저작권

기계 학습 알고리즘에는 많은 양의 데이터가 필요합니다. 이 데이터를 획득하는 데 사용되는 기술은 개인 정보 보호, 감시 및 저작권에 대한 우려를 불러일으켰습니다.

기술 회사는 온라인 활동, 지리적 위치 데이터, 비디오 및 오디오를 포함하여 사용자로부터 광범위한 데이터를 수집합니다.[150] 예를 들어, 음성 인식 알고리즘을 구축하기 위해 아마존은 수백만 건의 사적인 대화를 녹음하고 임시 직원들이 그 중 일부를 듣고 전사할 수 있도록 했습니다.[151] 이 광범위한 감시에 대한 의견은 그것을 필요악으로 보는 사람들로부터 그것이 명백히 비윤리적이고 사생활의 권리를 침해하는 것이라고 보는 사람들까지 다양합니다.[152]

AI 개발자들은 이것이 가치 있는 애플리케이션을 제공하는 유일한 방법이라고 주장합니다. 그리고 데이터 집계, 비식별화 및 차등 개인 정보 보호와 같은 데이터를 얻으면서 개인 정보 보호를 시도하는 여러 기술을 개발했습니다.[153] 2016년부터 신시아 드워크(Cynthia Dwork)와 같은 일부 개인 정보 보호 전문가들은 개인 정보 보호를 공정성 측면에서 보기 시작했습니다. Brian Christian은 전문가들이 "그들이 아는 것"에 대한 질문에서 "그들이 그것을 가지고 무엇을 하고 있는지"에 대한 질문으로 선회했다고 썼습니다.[154]

제너레이티브 AI는 종종 이미지 또는 컴퓨터 코드와 같은 도메인을 포함하여 저작권이 없는 저작물에 대해 훈련되며, 결과물은 "공정한 사용"이라는 이론에 따라 사용됩니다. 또한 저작권이 있는 콘텐츠가 AI 색인화되거나 '스크랩'되는 것을 원하지 않는 웹 사이트 소유자는 현재 Open과 같은 특정 서비스에서 사용할 수 있는 검색 엔진에 의해 웹 사이트가 색인화되는 것을 원하지 않는 경우 사이트에 코드를 추가할 수 있습니다.인공지능. 전문가들은 이 이론이 얼마나 잘 그리고 어떤 상황에서 법정에서 유지될 것인지에 대해 의견을 달리합니다. 관련 요인에는 "저작권이 있는 저작물 사용의 목적과 성격"과 "저작권이 있는 저작물의 잠재적인 시장에 미치는 영향"이 포함될 수 있습니다.[155] 2023년 주요 저자(존 그리샴과 조나단 프란젠 포함)는 AI 회사가 자신의 작업을 사용하여 생성 AI를 훈련시킨 것에 대해 소송을 제기했습니다.[156][157]

오보

YouTube, Facebook 등에서는 추천 시스템을 사용하여 사용자에게 더 많은 콘텐츠를 안내합니다. 이러한 AI 프로그램은 사용자 참여를 극대화하는 목표(즉, 사람들이 계속 시청하도록 하는 것이 유일한 목표)가 주어졌습니다. 인공지능은 사용자가 잘못된 정보, 음모론, 극단적인 당파적 내용을 선택하는 경향이 있음을 알게 되었고, 계속해서 관찰하기 위해 인공지능은 더 많은 정보를 추천했습니다. 사용자들은 또한 동일한 주제에 대해 더 많은 콘텐츠를 시청하는 경향이 있어서 AI는 사람들을 동일한 잘못된 정보의 여러 버전을 받는 필터 버블로 이끌었습니다.[158] 이것은 많은 사용자들에게 잘못된 정보가 사실이라고 확신시켰고, 궁극적으로 기관, 언론, 정부에 대한 신뢰를 훼손했습니다.[159] 인공지능 프로그램은 목표를 극대화하는 법을 정확하게 배웠지만, 그 결과는 사회에 해롭습니다. 2016년 미국 선거 이후 주요 기술 기업들이 문제를 완화하기 위한 조치를 취했습니다.

2022년, 제너레이티브 AI는 실제 사진, 녹음, 영화 또는 인간의 글과 구별할 수 없는 이미지, 오디오, 비디오 및 텍스트를 만들기 시작했습니다. 나쁜 행위자가 이 기술을 사용하여 대량의 잘못된 정보나 선전을 만들 수 있습니다.[160] 인공지능의 선구자 제프리 힌튼은 인공지능이 "권위주의 지도자들이 유권자들을 조작할 수 있게" 해주는 것에 대해 우려를 표명했습니다.[161]

알고리즘 편향성과 공정성

기계 학습 응용 프로그램이 편향된 데이터에서 학습하면 편향됩니다.[162] 개발자는 편향이 존재한다는 사실을 모를 수 있습니다.[163] 편향은 훈련 데이터를 선택하는 방법과 모델을 배포하는 방법에 의해 도입될 수 있습니다.[164][162] 편향된 알고리즘을 사용하여 사람들에게 심각한 해를 끼칠 수 있는 결정을 내린다면 (의료, 금융, 채용, 주택 또는 치안 등에서) 그 알고리즘은 차별을 일으킬 수 있습니다.[165] 기계 학습의 공정성은 알고리즘 편향으로 인한 피해를 예방하는 방법을 연구하는 것입니다. AI 내에서 심각한 학문적 연구 영역이 되었습니다. 연구자들은 모든 이해관계자를 만족시키는 방식으로 "공정성"을 정의할 수 있는 것은 아니라는 것을 발견했습니다.[166]

2015년 6월 28일, 구글 포토스의 새로운 이미지 라벨링 기능은 재키 알신과 친구가 흑인이라는 이유로 "고릴라"로 잘못 식별되었습니다. 이 시스템은 "표본 크기 차이"[167]라고 불리는 문제인 흑인의 이미지를 거의 포함하지 않은 데이터 세트에서 훈련되었습니다.[168] 구글은 시스템이 어떤 것도 "고릴라"라고 표시하는 것을 막음으로써 이 문제를 "고릴라"로 "수정"했습니다. 8년이 지난 2023년에도 구글 포토는 여전히 고릴라를 식별할 수 없었고, 애플, 페이스북, 마이크로소프트, 아마존의 유사한 제품도 식별할 수 없었습니다.[169]

COMPAS는 피고가 재범자가 될 가능성을 평가하기 위해 미국 법원에서 널리 사용되는 상업 프로그램입니다. 2016년 프로퍼블리카의 줄리아 앵윈(Julia Angwin)은 프로그램이 피고인들의 인종에 대해 알리지 않았음에도 불구하고 COMPAS가 인종적 편견을 나타냈다는 것을 발견했습니다. 백인과 흑인의 오차율은 정확히 61%로 동일하게 보정되었지만, 각 인종의 오차는 달랐는데, 이 시스템은 흑인이 재범할 가능성을 지속적으로 과대평가하고 백인이 재범하지 않을 가능성을 과소평가했습니다.[170] 2017년, 몇몇 연구자들은[k] 데이터에서 백인과 흑인에 대한 재범률이 다를 때 COMPAS가 공정성에 대한 가능한 모든 측정치를 수용하는 것이 수학적으로 불가능하다는 것을 보여주었습니다.[172]

데이터가 문제가 있는 기능(예: "인종" 또는 "성별")을 명시적으로 언급하지 않더라도 프로그램은 편향된 결정을 내릴 수 있습니다. 이 기능은 다른 기능(예: "주소", "쇼핑 기록" 또는 "이름")과 상관되며 프로그램은 이러한 기능을 기반으로 "인종" 또는 "성별"과 동일한 결정을 내립니다.[173] 모리츠 하르트(Moritz Hardt)는 "이 연구 분야에서 가장 강력한 사실은 실명을 통한 공정성이 작동하지 않는다는 것"이라고 말했습니다.[174]

COMPAS에 대한 비판은 AI의 오용에 대한 더 깊은 문제를 강조했습니다. 기계 학습 모델은 미래가 과거와 비슷할 것이라고 가정할 때만 유효한 "예측"을 하도록 설계되었습니다. 과거 인종차별적 결정의 결과가 포함된 데이터에 대해 훈련을 받은 경우 머신러닝 모델은 앞으로 인종차별적 결정이 내려질 것이라고 예측해야 합니다. 불행히도 애플리케이션이 이러한 예측을 권장 사항으로 사용하면 이러한 "권장 사항" 중 일부는 인종차별적일 가능성이 높습니다.[175] 따라서 머신 러닝은 과거보다 미래가 더 나아질 것이라는 희망이 있는 분야에서 의사 결정을 내리는 데 도움이 되기에 적합하지 않습니다. 그것은 반드시 서술적이고 규정적이지 않습니다.[l]

개발자들이 압도적으로 백인과 남성이기 때문에 편견과 불공정은 감지되지 않을 수 있습니다: AI 엔지니어들 중 약 4%는 흑인이고 20%는 여성입니다.[168]

한국 서울에서 열린 2022 공정성, 책임, 투명성에 관한 컨퍼런스(ACM FAccT 2022)에서 컴퓨터 기계 협회는 AI와 로봇 시스템이 편향된 실수가 없다는 것이 입증될 때까지 이를 권고하는 연구 결과를 발표하고 발표했습니다. 이들은 안전하지 않으며, 결함이 있는 인터넷 데이터의 방대하고 규제되지 않은 소스에 대해 훈련된 자가 학습 신경망의 사용을 줄여야 합니다.[177]

투명성 부족

많은 AI 시스템은 너무 복잡하기 때문에 설계자가 결정에 도달하는 방법을 설명할 수 없습니다.[178] 특히 입력과 출력 사이에 많은 양의 비선형 관계가 있는 심층 신경망의 경우. 그러나 몇 가지 인기 있는 설명 기술이 존재합니다.[179]

기계 학습 프로그램이 엄격한 테스트를 통과했지만 프로그래머가 의도한 것과는 다른 것을 학습한 경우가 많았습니다. 예를 들어, 의료 전문가보다 피부 질환을 더 잘 식별할 수 있는 시스템은 실제로 눈금자가 있는 이미지를 "암"으로 분류하는 경향이 강한 것으로 밝혀졌는데, 악성 종양의 사진에는 일반적으로 눈금자가 포함되어 있기 때문입니다.[180] 의료 자원을 효과적으로 할당하는 것을 돕기 위해 고안된 또 다른 기계 학습 시스템은 천식 환자를 폐렴으로 사망할 "저위험"으로 분류하는 것으로 밝혀졌습니다. 천식은 실제로 심각한 위험 요소이지만 천식 환자는 보통 훨씬 더 많은 의료 서비스를 받기 때문에 훈련 데이터에 따르면 사망할 가능성이 상대적으로 낮았습니다. 천식과 폐렴으로 사망할 위험이 낮은 것 사이의 상관관계는 실제적이었지만 오해의 소지가 있었습니다.[181]

알고리즘의 결정으로 피해를 입은 사람은 설명할 권리가 있습니다. 예를 들어, 의사들은 어떤 결정을 내리든 그 이유를 명확하고 완전히 설명해야 합니다.[clarification needed][182] 2016년 유럽 연합의 일반 데이터 보호 규정의 초기 초안에는 이 권리가 존재한다는 명시적인 진술이 포함되어 있습니다.[m] 업계 전문가들은 해결책이 보이지 않는 미해결 문제라고 지적했습니다. 규제 당국은 그럼에도 불구하고 문제가 해결책이 없다면 도구를 사용해서는 안 된다는 해악이 현실이라고 주장했습니다.[183]

DARPA는 이러한 문제를 해결하기 위해 2014년 XAI ("설명 가능한 인공지능") 프로그램을 설립했습니다.[184]

투명성 문제에 대한 몇 가지 잠재적 해결책이 있습니다. SHAP은 출력에 대한 각 기능의 기여도를 시각화하는 데 도움이 됩니다.[185] LIME은 더 단순하고 해석 가능한 모델을 사용하여 모델을 로컬로 근사화할 수 있습니다.[186] 멀티태스킹 학습은 대상 분류 외에도 많은 수의 출력을 제공합니다. 이러한 기타 출력은 개발자가 네트워크가 학습한 내용을 추론하는 데 도움이 될 수 있습니다.[187] 디콘볼루션, 딥드림 및 기타 생성 방법을 통해 개발자는 딥 네트워크의 다양한 계층이 학습한 것을 확인하고 네트워크가 학습하는 것을 제안할 수 있는 출력을 생성할 수 있습니다.[188]

나쁜 행위자와 무기화된 AI

인공 지능은 권위주의 정부, 테러리스트, 범죄자 또는 불량 국가와 같은 나쁜 행위자에게 유용한 여러 가지 도구를 제공합니다.

치명적인 자율 무기는 인간의 감독 없이 인간의 목표물을 찾고, 선택하고, 관여하는 기계입니다.[n] 널리 사용 가능한 AI 도구는 나쁜 행위자가 저렴한 자율 무기를 개발하는 데 사용할 수 있으며, 대규모로 생산되면 잠재적으로 대량 파괴 무기가 될 수 있습니다.[190] 재래식 전쟁에 사용되더라도 목표물을 확실하게 선택하지 못하고 무고한 사람을 잠재적으로 죽일 수 있는 가능성은 거의 없습니다.[190] 2014년 유엔의 특정 재래식 무기 협약에 따라 30개국(중국 포함)이 자율 무기 금지를 지지했지만, 미국 등은 동의하지 않았습니다.[191] 2015년까지 50개 이상의 국가에서 전장 로봇을 연구하고 있는 것으로 보고되었습니다.[192]

AI 도구를 사용하면 권위주의 정부가 여러 방식으로 국민을 효율적으로 통제할 수 있습니다. 얼굴 및 음성 인식으로 광범위한 감시가 가능합니다. 이 데이터를 작동하는 머신 러닝은 국가의 잠재적 적을 분류하고 그들이 숨는 것을 방지할 수 있습니다. 추천 시스템은 최대 효과를 위해 선전 및 잘못된 정보를 정확하게 타겟팅할 수 있습니다. 딥페이크와 생성 AI는 잘못된 정보를 생성하는 데 도움이 됩니다. 고급 AI는 시장과 같은 자유주의적이고 분산된 시스템으로 보다 경쟁력 있는 권위주의적인 중앙 집중식 의사 결정을 내릴 수 있습니다. 디지털 전쟁과 첨단 스파이웨어의 비용과 난이도를 낮춥니다.[193] 이 모든 기술은 2020년 또는 그 이전부터 사용할 수 있었습니다. AI 안면 인식 시스템은 이미 중국에서 대량 감시에 사용되고 있습니다.[194][195]

AI가 나쁜 행위자를 도울 것으로 예상되는 다른 많은 방법들이 있지만, 그 중 일부는 예측할 수 없습니다. 예를 들어, 기계 학습 AI는 몇 시간 만에 수만 개의 독성 분자를 설계할 수 있습니다.[196]

기술실업

경제학자들은 AI로 인한 해고의 위험성을 자주 강조했고 완전 고용을 위한 적절한 사회 정책이 없을 경우 실업에 대해 추측했습니다.[197]

과거에는 기술이 전체 고용을 줄이는 대신 늘어나는 경향이 있었지만, 경제학자들은 AI로 "우리는 미지의 영역에 있다"고 인정합니다.[198] 경제학자들을 대상으로 한 설문조사에서 로봇과 AI의 사용 증가가 장기 실업률의 실질적인 증가를 초래할 것인지에 대해서는 이견을 보였지만, 생산성 향상이 재분배될 경우 순편익이 될 수 있다는 데는 대체로 의견이 일치합니다.[199] 위험 추정치는 다양합니다. 예를 들어, 2010년대에 마이클 오스본과 칼 베네딕트 프레이는 미국 일자리의 47%가 잠재적 자동화의 "고위험"에 있다고 추정한 반면, OECD 보고서는 미국 일자리의 9%만이 "고위험"으로 분류했습니다.[o][201] 미래의 고용 수준에 대해 추측하는 방법론은 근거가 부족하고, 사회정책이 아닌 기술이 해고가 아닌 실업을 만든다는 것을 암시한다는 비판을 받아 왔습니다.[197]

이전의 자동화 물결과 달리 많은 중산층 일자리가 인공지능에 의해 사라질 수 있습니다. 이코노미스트는 2015년에 "산업 혁명 기간 동안 스팀 파워가 블루칼라 일자리에 했던 것처럼 AI가 화이트칼라 일자리에 할 수 있다는 우려는 "심각하게 받아들일 가치가 있다"고 말했습니다.[202] 극단적인 위험에 처한 직업은 평행선에서부터 패스트푸드 요리사에 이르기까지 다양한 반면, 개인 건강 관리부터 성직자에 이르기까지 돌봄과 관련된 직업에 대한 직업 수요는 증가할 것으로 보입니다.[203]

2023년 4월, 중국 비디오 게임 일러스트레이터의 일자리 중 70%가 생성 인공지능에 의해 제거되었다고 보고되었습니다.[204][205]

예를 들어 조셉 바이젠바움(Joseph Weizenbaum)이 제시한 것과 같은 인공지능의 발전 초기부터 컴퓨터와 인간, 그리고 정량적 계산과 정성적 계산 사이의 차이를 고려할 때 실제로 컴퓨터가 할 수 있는 작업을 컴퓨터가 해야 하는지에 대한 논쟁이 있었습니다. 가치관에 [206]입각한 판단

실존적 위험

AI가 너무 강력해져서 인류가 AI에 대한 통제력을 되돌릴 수 없을 정도가 될 것이라는 주장이 제기되었습니다. 이것은 물리학자 스티븐 호킹이 말했듯이 "인류의 종말을 초래할 수 있습니다."[207] 이 시나리오는 컴퓨터나 로봇이 갑자기 인간과 같은 "자기 인식"(또는 "감성" 또는 "의식")을 발달시켜 악의적인 캐릭터가 되는 공상과학 소설에서 일반적이었습니다.[p] 이러한 공상 과학 시나리오는 여러 가지로 오해의 소지가 있습니다.

첫째, AI는 실존적 위험이 되기 위해 인간과 같은 '관능'을 요구하지 않습니다. 현대의 AI 프로그램은 특정 목표가 주어지고 이를 달성하기 위해 학습과 지능을 사용합니다. 철학자 닉 보스트롬(Nick Bostrom)은 충분히 강력한 인공지능에 거의 모든 목표를 부여하면 그것을 달성하기 위해 인류를 파괴하는 선택을 할 수 있다고 주장했습니다(그는 종이 클립 공장 관리자의 예를 사용했습니다).[209] 스튜어트 러셀(Stuart Russell)은 "죽으면 커피를 가져올 수 없다"는 추론을 통해 주인을 죽일 방법을 찾으려 하는 가정용 로봇의 예를 제시합니다.[210] 초지능이 인류의 안전을 위해서는 '근본적으로 우리 편'이 되도록 인간의 도덕성과 가치관에 진정으로 부합되어야 할 것입니다.[211]

둘째, 유발 노아 하라리(Yuval Noah Harari)는 AI가 실존적 위험을 제기하기 위해 로봇의 신체나 물리적 제어를 필요로 하지 않는다고 주장합니다. 문명의 본질적인 부분은 물리적인 것이 아닙니다. 이념, 법, 정부, 돈, 경제 같은 것들은 언어로 만들어져 있습니다. 수십억 명의 사람들이 믿는 이야기들이 있기 때문에 존재합니다. 현재의 잘못된 정보의 확산은 인공지능이 언어를 사용하여 사람들이 무엇이든 믿도록 설득하고 심지어 파괴적인 행동을 취할 수 있음을 시사합니다.[212]

전문가들과 업계 내부자들의 의견은 엇갈리고 있으며, 궁극적으로 초지능 AI로 인한 위험에 대해 우려하거나 무관심한 부분이 상당합니다.[213] 스티븐 호킹, 빌 게이츠, 일론 머스크와 같은 유명 인사들은 AI로 인한 실존적 위험에 대해 우려를 표명했습니다.[214] 페이페이 리(Fei-Fei Li), 제프리 힌튼(Geoffrey Hinton), 요수아 벤지오(Yoshua Bengio), 신시아 브리질(Cynthia Breazeal), 라나엘 칼리우비(Ranael Kaliouby), 데미스 하사비스(Demis Hassabis), 조이 부올람위니(Joy Buolamwini), 샘 알트먼(Sam Altman) 등 AI 선구자들은 AI의 위험성에 대해 우려를 표명했습니다. 2023년, 많은 선도적인 AI 전문가들은 "AI로부터의 멸종 위험을 완화하는 것은 전염병 및 핵 전쟁과 같은 다른 사회 규모의 위험과 함께 세계적인 우선 순위가 되어야 한다"는 공동 성명을 발표했습니다.[215]

그러나 다른 연구자들은 덜 디스토피아적인 견해에 찬성했습니다. AI의 선구자인 위르겐 슈미드후버는 공동성명에 서명하지 않았으며, 모든 경우의 95%에서 AI 연구는 "인간의 삶을 더 오래 건강하고 쉽게" 만드는 것이라고 강조했습니다.[216] 현재 삶을 개선하기 위해 사용되고 있는 도구들은 나쁜 배우들에게도 사용될 수 있지만, "그것들은 나쁜 배우들에게도 사용될 수 있습니다."[217][218] Andrew Ng는 또한 "AI에 대한 최후의 날의 과대 광고에 빠지는 것은 실수이며, 그렇게 하는 규제 기관은 기득권에게만 이익이 될 것"이라고 주장했습니다.[219] Yann LeCun은 "과도한 잘못된 정보와 결국 인간 멸종이라는 동료들의 디스토피아적 시나리오를 비웃습니다."[220] 2010년대 초, 전문가들은 미래에 위험이 너무 멀어 연구를 보증할 수 없거나 초지능 기계의 관점에서 인간은 가치가 있을 것이라고 주장했습니다.[221] 그러나 2016년 이후 현재와 미래의 위험과 가능한 해결책에 대한 연구가 심각한 연구 영역이 되었습니다.[222]

윤리적 기계 및 정렬

프렌들리 AI는 처음부터 위험을 최소화하고 인간에게 이익이 되는 선택을 할 수 있도록 설계된 기계입니다. 이 용어를 만든 엘리제 유드코프스키(Elizer Yudkowsky )는 우호적인 AI를 개발하는 것이 더 높은 연구 우선 순위가 되어야 한다고 주장합니다. 대규모 투자가 필요할 수 있으며 AI가 실존적인 위험이 되기 전에 완료되어야 합니다.[223]

지능을 가진 기계는 윤리적 결정을 내리는 데 지능을 사용할 가능성이 있습니다. 기계 윤리 분야는 기계에게 윤리적 딜레마를 해결하기 위한 윤리적 원칙과 절차를 제공합니다.[224] 기계 윤리 분야는 컴퓨팅 도덕이라고도 불리며,[224] 2005년 AAAI 심포지엄에서 설립되었습니다.[225]

다른 접근법에는 Wendell Wallach의 "인공 도덕 에이전트"[226]와 Stuart J. Russell이 입증 가능한 유익한 기계를 개발하기 위한 세 가지 원칙이 포함됩니다.[227]

프레임워크

인공지능 프로젝트는 인공지능 시스템을 설계, 개발 및 구현하는 동안 윤리적 허용성을 테스트할 수 있습니다. Alan Turing Institute가 개발한 SUM 값을 포함하는 Care and Act Framework와 같은 AI 프레임워크는 다음과 같은 네 가지 주요 영역에서 프로젝트를 테스트합니다.[228][229]

- 개인의 존엄성을 존중합니다.

- 다른 사람들과 진심으로, 공개적으로 그리고 포괄적으로 연결

- 모든 사람들의 안녕을 위한 관심

- 사회적 가치, 정의 및 공익 보호

윤리적 프레임워크의 다른 발전에는 아실로마 회의, 책임 있는 AI를 위한 몬트리올 선언, IEEE의 자율 시스템 윤리 이니셔티브 등이 포함됩니다.[230] 그러나 이러한 원칙은 특히 이러한 프레임워크에 기여하는 사람들에 대한 비판을 수반하지 않습니다.[231]

이러한 기술이 영향을 미치는 사람과 지역사회의 복지 증진을 위해서는 AI 시스템 설계, 개발 및 구현의 모든 단계에서 사회적, 윤리적 의미를 고려하고 데이터 과학자, 제품 관리자, 데이터 엔지니어, 도메인 전문가, 전달 관리자와 같은 직무 역할 간의 협업이 필요합니다.[232]

규정

인공 지능 규제는 인공 지능(AI)을 촉진하고 규제하기 위한 공공 부문 정책 및 법률 개발이므로 알고리즘의 광범위한 규제와 관련이 있습니다.[233] AI에 대한 규제 및 정책 환경은 전 세계적으로 관할권에서 떠오르는 문제입니다.[234] 스탠포드의 AI Index에 따르면 127개 조사국에서 통과된 AI 관련 법의 연간 통과 건수는 2016년 1건에서 2022년에만 37건으로 급증했습니다.[235][236] 2016년과 2020년 사이에 30개 이상의 국가에서 AI 전용 전략을 채택했습니다.[237] 대부분의 EU 회원국들은 캐나다, 중국, 인도, 일본, 모리셔스, 러시아 연방, 사우디아라비아, 아랍에미리트, 미국, 베트남과 마찬가지로 국가 AI 전략을 발표했습니다. 다른 이들은 방글라데시, 말레이시아, 튀니지 등 자체 AI 전략을 정교화하는 과정에 있었습니다.[237] 인공지능에 대한 대중의 신뢰와 신뢰를 보장하기 위해 2020년 6월 인공지능에 대한 글로벌 파트너십이 출범했습니다.[237] 2021년 11월 헨리 키신저, 에릭 슈미트, 다니엘 허텐로허는 AI 규제를 위한 정부 위원회를 촉구하는 공동 성명을 발표했습니다.[238] 2023년, OpenAI 지도자들은 초지능 거버넌스에 대한 권고사항을 발표했는데, 그들은 이것이 10년 이내에 일어날 수 있다고 생각합니다. 2023년에 UN은 AI 거버넌스에 대한 권고를 제공하기 위한 자문 기구를 시작했습니다. 이 기구는 기술 회사 임원, 정부 관계자 및 학자로 구성됩니다.[240]

2022년 입소스 설문조사에서 AI에 대한 태도는 국가별로 큰 차이를 보였습니다. 중국 시민의 78%가 "AI를 사용하는 제품과 서비스는 단점보다 이점이 더 많다"는 데 동의한 미국인은 35%에 불과했습니다.[235] 2023년 로이터/Ipsos 여론조사에 따르면 미국인의 61%가 AI가 인류에 위험을 초래한다는 데 동의하고 22%는 동의하지 않는 것으로 나타났습니다.[241] 2023년 폭스 뉴스 여론조사에서 미국인의 35%가 "매우 중요하다"고 생각했고, 추가적으로 41%가 "다소 중요하다"고 생각했으며, 13%는 "매우 중요하지 않다", 8%는 "전혀 중요하지 않다"고 응답했습니다.[242][243]

2023년 11월 영국 블레츨리 파크에서 제1차 글로벌 AI 안전 정상회의를 개최하여 AI의 근·단기적 위험성과 의무적·자발적 규제 프레임워크의 가능성을 논의하였습니다.[244] 정상회의 시작과 함께 미국, 중국, 유럽연합 등 28개국이 선언문을 발표하였으며, 인공지능의 도전과 위험을 관리하기 위한 국제 협력을 촉구합니다.[245][246]

역사

기계적 또는 "형식적" 추론에 대한 연구는 고대의 철학자와 수학자들로부터 시작되었습니다. 논리학에 대한 연구는 앨런 튜링의 계산 이론으로 바로 이어졌는데, 이 이론은 기계가 기호를 "0"과 "1"처럼 단순하게 섞어서 어떤 형태의 수학적 추론도 시뮬레이션할 수 있다고 제안했습니다.[247][4] 이것은 사이버네틱스, 정보 이론 및 신경생물학의 동시 발견과 함께 연구자들이 "전자 뇌"를 구축할 수 있는 가능성을 고려하도록 이끌었습니다.[q] 그들은 1943년 맥컬루치와 피츠버그의 "인공 뉴런" 설계,[249][250] 튜링 테스트를 도입하고 "기계 지능"이 그럴듯하다는 것을 보여준 튜링의 영향력 있는 1950년 논문 '컴퓨팅 머신과 지능' 등 AI의 일부가 될 여러 연구 분야를 개발했습니다.[251][4]

AI 연구 분야는 1956년 다트머스 대학의 워크숍에서 설립되었습니다.[r][5] 참석자들은 1960년대에 AI 연구의 선두주자가 되었습니다.[s] 그들과 그들의 학생들은 언론이 "놀라운" 프로그램을 만들었습니다:[t] 컴퓨터는 체커 전략을 배우고, 대수학에서 단어 문제를 풀고, 논리적 정리를 증명하고, 영어를 말하는 것이었습니다.[u][6] 인공지능 연구소는 1950년대 후반과 1960년대 초에 영국과 미국의 여러 대학에 설립되었습니다.[4]

1960년대와 1970년대의 연구자들은 그들의 방법이 결국 일반적인 지능을 가진 기계를 만드는 데 성공할 것이라고 확신했고 이것을 그들의 분야의 목표로 생각했습니다.[255] 허버트 사이먼(Herbert Simon)은 "기계는 20년 안에 사람이 할 수 있는 모든 일을 할 수 있을 것입니다."라고 예측했습니다.[256] 마빈 민스키(Marvin Minsky)는 동의하며 "한 세대 내에... '인공지능'을 만드는 문제는 실질적으로 해결될 것입니다."[257] 그러나 그들은 문제의 난이도를 과소평가했습니다.[v] 1974년, 미국과 영국 정부는 제임스 라이트힐[259] 경에 대한 비판과 더 생산적인 프로젝트에 자금을 지원하라는 미국 의회의 지속적인 압력에 대응하여 탐사 연구를 중단했습니다.[260] 민스키와 파퍼트의 책 퍼셉트론은 인공 신경망이 실제 과제를 해결하는 데 결코 유용하지 않을 것이라는 것을 증명하는 것으로 이해되어 접근 방식을 완전히 비난했습니다.[261] AI 프로젝트 자금 확보가 어려웠던 시기인 'AI 겨울'이 그 뒤를 이었습니다.[8]

1980년대 초, AI 연구는 인간 전문가의 지식과 분석 기술을 시뮬레이션한 AI 프로그램의 한 형태인 [262]전문가 시스템의 상업적 성공으로 부활했습니다. 1985년까지 AI 시장은 10억 달러 이상에 달했습니다. 동시에, 일본의 5세대 컴퓨터 프로젝트는 미국과 영국 정부가 학술 연구를 위한 자금을 회복하도록 영감을 주었습니다.[7] 하지만 1987년 리스프 머신 시장의 붕괴를 시작으로 AI는 다시 한 번 명성을 잃었고, 두 번째로 오래 지속되는 겨울이 시작되었습니다.[9]

지금까지 AI의 자금 대부분은 계획, 목표, 신념 및 알려진 사실과 같은 정신적 대상을 나타내는 높은 수준의 기호를 사용하는 프로젝트에 사용되었습니다. 1980년대에 몇몇 연구자들은 이 접근법이 인간의 인지, 특히 지각, 로봇 공학, 학습 및 패턴 인식의 모든 과정을 모방할 수 있을지 의심하기 시작했고 "[263]하위 기호" 접근법을 조사하기 시작했습니다.[264] 로드니 브룩스(Rodney Brooks)는 일반적으로 "표현"을 거부하고 움직이고 생존하는 엔지니어링 기계에 직접 집중했습니다.[w] 유대 펄(Judea Pearl), 로피 자데(Lofti Zadeh) 등은 정확한 논리가 아닌 합리적인 추측을 통해 불완전하고 불확실한 정보를 처리하는 방법을 개발했습니다.[87][269] 그러나 가장 중요한 발전은 제프리 힌튼 등에 의한 신경망 연구를 포함한 "연결주의"의 부활이었습니다.[270] 1990년 Yann LeCun은 컨볼루션 신경망이 손으로 쓴 숫자를 인식할 수 있다는 것을 성공적으로 보여주었는데, 이는 신경망의 많은 성공적인 응용 분야 중 첫 번째입니다.[271]

AI는 1990년대 말과 21세기 초에 공식적인 수학적 방법을 활용하고 특정 문제에 대한 구체적인 해결책을 찾음으로써 점차 명성을 회복했습니다. 이러한 "좁고" "공식적인" 초점을 통해 연구자들은 검증 가능한 결과를 도출하고 다른 분야(통계, 경제 및 수학)와 협력할 수 있었습니다.[272] 2000년이 되자 AI 연구원들이 개발한 솔루션이 널리 사용되고 있지만 1990년대에는 '인공지능'으로 거의 표현되지 않았습니다.[273] 그러나 여러 학술 연구자들은 AI가 더 이상 다용도의 완전히 지능적인 기계를 만드는 원래의 목표를 추구하지 않는다고 우려하게 되었습니다. 2002년경부터 그들은 2010년대까지 여러 개의 자금이 잘 지원되는 기관을 보유한 인공 일반 지능(또는 "AGI")의 하위 분야를 설립했습니다.[13]

딥 러닝은 2012년부터 업계 벤치마크를 지배하기 시작하여 분야 전반에 걸쳐 채택되었습니다.[10] 많은 특정 작업에 대해 다른 방법은 포기되었습니다.[x] 딥 러닝의 성공은 하드웨어 개선(더 빠른 컴퓨터,[275] 그래픽 처리 장치, 클라우드 컴퓨팅[276])과 대량의 데이터[277](예:[276] ImageNet과 같은 큐레이팅된 데이터 세트 포함)에 대한 액세스 모두에 기반했습니다. 딥러닝의 성공으로 AI에 대한 관심과 자금이 크게 증가했습니다.[y] 머신 러닝 연구(총 출판물로 측정)의 양은 2015-2019년에 50% 증가했습니다.[237]

2016년, 공정성과 기술의 남용 문제가 기계 학습 컨퍼런스에서 중심 단계로 떠올랐고, 출판물이 급격히 증가하고, 자금이 지원되었으며, 많은 연구자들이 이러한 문제에 경력을 다시 집중했습니다. 정렬 문제는 심각한 학문 분야가 되었습니다.[222]

10대 후반에서 2020년대 초에 AGI 회사는 엄청난 관심을 불러일으키는 프로그램을 제공하기 시작했습니다. 2015년에 딥마인드에 의해 개발된 알파고는 세계 챔피언 바둑 선수를 이겼습니다. 그 프로그램은 게임의 규칙만 배웠고 스스로 전략을 개발했습니다. GPT-3는 오픈이 2020년 출시한 대형 언어 모델입니다.AI는 고품질의 인간과 같은 텍스트를 생성할 수 있습니다.[278] 이러한 프로그램 및 기타 프로그램은 대기업이 AI 연구에 수십억 달러를 투자하기 시작한 공격적인 AI 붐에 영감을 주었습니다. 'AI Impacts'에 따르면 미국에서만 2022년경 연간 약 500억 달러가 'AI'에 투자되었으며 미국 컴퓨터과학 박사과정 신입생의 약 20%가 'AI'에 특화되어 있다고 합니다.[279] 2022년에 약 80만 개의 "AI" 관련 미국 일자리가 존재했습니다.[280]

철학

인공지능 정의

Alan Turing은 1950년에 "저는 '기계가 생각할 수 있는가'라는 질문을 고려할 것을 제안합니다."[281]라고 썼습니다. 그는 기계가 "생각하는지"에서 "기계가 지적인 행동을 보여주는 것이 가능한지"로 질문을 바꾸라고 조언했습니다.[281] 그는 인간의 대화를 시뮬레이션하는 기계의 능력을 측정하는 튜링 테스트를 고안했습니다.[251] 우리는 기계의 행동을 관찰할 수 있을 뿐이기 때문에, 그것이 "사실" 생각인지 말 그대로 "마음"이 있는지는 중요하지 않습니다. 튜링은 우리가 다른 사람들에[z] 대해 이런 것들을 결정할 수는 없지만 "모든 사람들이 생각하는 예의 바른 관습을 갖는 것이 일반적이다"라고 언급합니다.[282]

Russell과 Norvig는 인공지능이 "생각"이 아니라 "행동"의 관점에서 정의되어야 한다는 Turing의 의견에 동의합니다.[283] 그러나 테스트에서 기계를 사람과 비교하는 것은 매우 중요합니다. 그들은 "항공공학 텍스트"라며 "그들 분야의 목표를 '다른 비둘기를 속일 수 있을 정도로 비둘기처럼 정확히 날아가는 기계'로 정의하지 말라"[284]고 썼습니다. 인공지능 창업자 존 매카시도 동의하며 "인공지능은 정의상 인간 지능의 시뮬레이션이 아니다"라고 썼습니다.[285]

McCarthy는 지능을 "세계에서 목표를 달성하는 능력의 계산적인 부분"이라고 정의합니다.[286] 또 다른 AI 창시자인 마빈 민스키(Marvin Minsky)도 마찬가지로 "어려운 문제를 해결할 수 있는 능력"이라고 정의합니다.[287] 이러한 정의는 문제의 난이도와 프로그램의 성능이 모두 기계의 "지능"에 대한 직접적인 척도이며, 다른 철학적 논의가 필요하지 않거나 심지어 가능하지 않을 수도 있는 잘 정의된 솔루션의 문제 측면에서 지능을 봅니다.

AI 분야의 주요 실무자인 [288]구글이 또 다른 정의를 채택했습니다. 이 정의는 생물학적 지능에서 정의되는 방식과 유사하게 정보를 지능의 발현으로 합성하는 시스템의 능력을 규정합니다.

AI에 대한 접근 방식 평가

확립된 통합 이론이나 패러다임은 대부분의 역사 동안 AI 연구를 안내하지 않았습니다.[aa] 2010년대 통계 기계 학습의 전례 없는 성공은 다른 모든 접근 방식을 무색하게 했습니다(특히 비즈니스 세계에서 일부 소스에서는 "인공 지능"이라는 용어를 "신경망이 있는 기계 학습"이라는 의미로 사용합니다). 이 접근 방식은 대부분 하위 기호이며 부드럽고 좁습니다(아래 참조). 비평가들은 이러한 질문들이 미래 세대의 AI 연구자들에 의해 다시 검토되어야 할 수도 있다고 주장합니다.

상징적 AI와 그 한계

심볼릭 AI(또는 "GOFAI")[290]는 사람들이 퍼즐을 풀고, 법적 추론을 표현하고, 수학을 할 때 사용하는 높은 수준의 의식적 추론을 시뮬레이션했습니다. 그들은 대수학이나 IQ 테스트와 같은 "지능적인" 작업에서 매우 성공적이었습니다. 1960년대에 뉴웰과 사이먼은 물리적 기호 체계 가설을 제안했습니다: "물리적 기호 체계는 일반적인 지적 행동의 필요하고 충분한 수단을 가지고 있습니다."[291]

그러나 상징적 접근 방식은 학습, 사물 인식 또는 상식적 추론과 같이 인간이 쉽게 해결하는 많은 과제에서 실패했습니다. 모라벡의 역설은 높은 수준의 "지능적인" 작업은 AI에게는 쉬웠지만 낮은 수준의 "본능적인" 작업은 극도로 어려웠다는 발견입니다.[292] 철학자 휴버트 드레퓌스(Hubert Dreyfus)는 1960년대부터 인간의 전문성은 의식적인 상징 조작보다는 무의식적인 본능에 달려 있으며, 명시적인 상징적 지식보다는 상황에 대한 "느낌"을 갖는 것에 달려 있다고 주장해 왔습니다.[293] 비록 그의 주장이 처음 제시되었을 때 조롱과 무시를 당했지만, 결국 AI 연구는 그의 의견에 동의하게 되었습니다.[ab][18]

문제는 해결되지 않았습니다: 하위 기호 추론은 알고리즘 편향과 같이 인간의 직관이 하는 것과 동일한 설명할 수 없는 실수를 많이 저지를 수 있습니다. 노암 촘스키(Noam Chomsky)와 같은 비평가들은 기호 AI에 대한 지속적인 연구가 일반 지능을 달성하기 위해 여전히 필요할 것이라고 주장합니다.[295][296] 부분적으로 하위 기호 AI는 설명 가능한 AI에서 벗어나는 것이기 때문입니다. 현대 통계 AI 프로그램이 특정 결정을 내린 이유를 이해하는 것은 어렵거나 불가능할 수 있습니다. 신경 기호 인공 지능이라는 새로운 분야는 두 가지 접근 방식을 연결하려고 시도합니다.

깔끔함 대 지저분함

"Neats"는 지능적인 행동이 (논리, 최적화 또는 신경망과 같은) 단순하고 우아한 원칙을 사용하여 설명되기를 희망합니다. "스크러피"는 관련 없는 많은 문제를 해결해야 한다고 예상합니다. 니트는 이론적 엄격함으로 프로그램을 방어하고, 스퀴프는 주로 효과가 있는지 확인하기 위해 증분 테스트에 의존합니다. 이 문제는 1970년대와 1980년대에 활발하게 논의되었지만 [297]결국 무관한 것으로 여겨졌습니다. 현대 AI는 두 가지 요소를 모두 가지고 있습니다.

소프트 컴퓨팅 대 하드 컴퓨팅

증명 가능한 정확한 또는 최적의 해결책을 찾는 것은 많은 중요한 문제에 대해 다루기 어렵습니다.[17] 소프트 컴퓨팅은 유전 알고리즘, 퍼지 논리 및 신경망을 포함한 일련의 기술로, 부정확성, 불확실성, 부분적 진실 및 근사치에 관대합니다. 소프트 컴퓨팅은 1980년대 후반에 도입되었으며 21세기에 성공한 대부분의 AI 프로그램은 신경망을 갖춘 소프트 컴퓨팅의 예입니다.

좁은 대 일반 AI

인공지능 연구자들은 이러한 해결책이 간접적으로 현장의 장기적인 목표로 이어지기를 바라며 인공지능 일반지능과 초지능의 목표를 직접적으로 추구할 것인지 아니면 가능한 한 많은 구체적인 문제를 해결할 것인지(좁은 AI)에 대해 의견이 나뉘고 있습니다.[298][299] 일반 지능은 정의하기 어렵고 측정하기 어려우며, 현대 AI는 특정 솔루션의 특정 문제에 집중함으로써 보다 검증 가능한 성공을 거두었습니다. 인공 일반 지능의 실험 하위 분야는 이 영역을 독점적으로 연구합니다.

기계의식, 감각, 정신

마음의 철학은 기계가 인간과 같은 의미로 마음, 의식, 정신 상태를 가질 수 있는지를 알지 못합니다. 이 문제는 기계의 외부 동작보다는 기계의 내부 경험을 고려합니다. 주류 AI 연구는 이 문제가 지능을 사용하여 문제를 해결할 수 있는 기계를 구축하는 분야의 목표에 영향을 미치지 않기 때문에 무관하다고 간주합니다. 러셀(Russell)과 노빅(Norvig)은 "인간이 정확히 존재하는 방식으로 기계를 의식하게 만드는 추가 프로젝트는 우리가 맡을 수 있는 장비가 아니다"라고 덧붙였습니다.[300] 그러나 이 질문은 마음 철학의 중심이 되었습니다. 또한 일반적으로 픽션의 인공 지능에서 문제가 되는 핵심 질문입니다.

의식

데이비드 찰머스(David Chalmers)는 정신을 이해하는 데 두 가지 문제를 발견했는데, 그는 이 문제를 의식의 "힘든" 문제와 "쉬운" 문제라고 이름 지었습니다.[301] 쉬운 문제는 뇌가 어떻게 신호를 처리하고 계획을 세우고 행동을 통제하는지 이해하는 것입니다. 어려운 문제는 이것이 정말로 어떤 것처럼 느껴진다고 생각하는 것이 옳다고 가정하고 이것이 어떻게 느껴지는지 또는 왜 그것이 어떤 것처럼 느껴져야 하는지를 설명하는 것입니다(데넷의 의식 착시주의는 이것이 착시라고 말합니다). 인간의 정보 처리는 설명하기 쉽지만 인간의 주관적인 경험은 설명하기 어렵습니다. 예를 들어, 시야에서 어떤 물체가 빨간색인지 식별하는 법을 배운 색맹인 사람은 쉽게 상상할 수 있지만, 빨간색이 어떻게 생겼는지 알기 위해서는 무엇이 필요한지 명확하지 않습니다.[302]

계산주의와 기능주의

계산주의는 인간의 마음이 정보처리 시스템이며 사고가 컴퓨팅의 한 형태라는 마음 철학의 입장입니다. 계산주의는 마음과 몸의 관계가 소프트웨어와 하드웨어의 관계와 유사하거나 동일하므로 마음과 몸의 문제에 대한 해결책이 될 수 있다고 주장합니다. 이러한 철학적 입장은 1960년대 AI 연구자들과 인지과학자들의 연구에서 영감을 받아 만들어졌으며, 원래 철학자 제리 포도르와 힐러리 퍼트넘이 제안했습니다.[303]

철학자 존 설(John Searle)은 이 위치를 "강력한 인공지능"이라고 특징지었습니다: "올바른 입력과 출력을 가진 적절하게 프로그래밍된 컴퓨터는 따라서 인간이 마음을 가지고 있는 것과 정확히 같은 의미로 마음을 가질 것입니다."[ac] 설은 기계가 인간의 행동을 완벽하게 모방하더라도 그것이 정신을 가지고 있다고 가정할 이유가 없다는 것을 보여주려는 그의 중국어 방 주장으로 이 주장에 반박합니다.[307]

AI 복지와 권리

첨단 AI가 지각력(느끼는 능력)이 있는지, 있다면 어느 정도인지를 확실하게 평가하는 것은 어렵거나 불가능합니다.[308] 그러나 주어진 기계가 느끼고 고통받을 수 있는 상당한 가능성이 있다면 동물과 마찬가지로 특정 권리 또는 복지 보호 조치를 받을 수 있습니다.[309][310] Sapience(지각력 또는 자기 인식과 같은 높은 지능과 관련된 일련의 역량)는 AI 권리에 대한 또 다른 도덕적 기반을 제공할 수 있습니다.[309] 자율 에이전트를 사회에 통합하는 실용적인 방법으로 로봇 권리도 제안되기도 합니다.[311]

2017년, 유럽 연합은 가장 유능한 AI 시스템 중 일부에 "전자적 인격"을 부여하는 것을 고려했습니다. 기업의 법적 지위와 유사하게 권리뿐만 아니라 책임도 부여했을 것입니다.[312] 2018년 비평가들은 AI 시스템에 권리를 부여하는 것은 인권의 중요성을 과소평가할 것이며, 입법은 투기적인 미래 시나리오보다는 사용자의 필요에 초점을 맞춰야 한다고 주장했습니다. 그들은 또한 로봇이 스스로 사회에 참여할 수 있는 자율성이 부족하다고 지적했습니다.[313][314]

AI의 발전은 이 주제에 대한 관심을 높였습니다. AI 복지와 권리를 지지하는 사람들은 종종 AI가 등장한다면 특히 거부하기 쉬울 것이라고 주장합니다. 이는 노예제나 공장식 농업과 유사한 도덕적 사각지대가 될 수 있으며, 이는 지각 있는 AI가 만들어져서 함부로 악용될 경우 대규모 고통으로 이어질 수 있다고 경고합니다.[310][309]

미래.

초지능과 특이점

초지능은 가장 똑똑하고 재능 있는 인간의 정신을 훨씬 능가하는 지능을 가지고 있는 가상의 에이전트입니다.[299]

인공 일반 지능에 대한 연구가 충분히 지능적인 소프트웨어를 생산한다면 자체적으로 재프로그래밍하고 개선할 수 있을 것입니다. 개선된 소프트웨어는 그 자체를 개선하는 데 훨씬 더 나을 것입니다. I. J. Good은 "지능 폭발"이라고 부르고 Vernor Vinge는 "특이점"이라고 부릅니다.[315]

그러나 기술은 무한히 향상될 수 없으며 일반적으로 S자형 곡선을 따라 기술이 할 수 있는 일의 물리적 한계에 도달하면 느려집니다.[316]

트랜스 휴머니즘

로봇 디자이너 한스 모라벡, 사이버 운동학자 케빈 워릭, 발명가 레이 커즈와일은 미래에 인간과 기계가 둘 중 하나보다 더 능력 있고 강력한 사이보그로 합쳐질 것이라고 예측했습니다. 트랜스 휴머니즘이라고 불리는 이 생각은 알두스 헉슬리와 로버트 에팅거에 뿌리를 두고 있습니다.[317]

에드워드 프레드킨(Edward Fredkin)은 "인공지능은 진화의 다음 단계"라고 주장하는데, 이 아이디어는 1863년까지 사무엘 버틀러의 "기계들 중의 다윈"에 의해 처음 제안되었고, 1998년 조지 다이슨(George Dyson)이 그의 동명의 책에서 확장되었습니다.[318]

픽션에서

사고가 가능한 인공적 존재는 고대부터 스토리텔링 장치로 등장했으며,[319] 공상과학 소설에서 지속적인 주제였습니다.[320]

이 작품들에서 흔히 볼 수 있는 곡예는 메리 셸리의 프랑켄슈타인에서 시작되었는데, 여기서 인간의 창조물은 주인들에게 위협이 됩니다. 여기에는 Arthur C와 같은 작품이 포함됩니다. Clarke's and Stanley Kubrick의 2001: Space Odyssey (둘 다 1968), Discovery One 우주선을 담당하는 살인적인 컴퓨터 HAL 9000, 그리고 터미네이터 (1984)와 매트릭스 (1999). 대조적으로, 지구가 가만히 서 있는 날 (1951)의 고트와 외계인의 비숍 (1986)과 같은 희귀한 충성 로봇은 대중 문화에서 덜 두드러집니다.[321]

아이작 아시모프(Isaac Asimov)는 많은 책과 이야기에서 로봇 3법칙을 소개했는데, 특히 유명한 것은 같은 이름의 초지능 컴퓨터에 관한 "멀티박(Multivac)" 시리즈입니다. 아시모프의 법칙은 기계 윤리에 대한 일반적인 논의 과정에서 종종 제기됩니다.[322] 거의 모든 인공 지능 연구자들이 대중 문화를 통해 아시모프의 법칙에 익숙하지만 일반적으로 여러 가지 이유로 인해 그 법칙이 쓸모 없다고 생각하는데, 그 중 하나는 모호하다는 것입니다.[323]

여러 작품은 AI를 사용하여 무엇이 우리를 인간으로 만드는지에 대한 근본적인 질문에 맞서도록 강요하며, 느낄 수 있고, 따라서 고통받을 수 있는 능력을 가진 인공적인 존재를 보여줍니다. 이것은 카렐 차펙의 R.U.R., 영화 A에 등장합니다.I. 인공지능과 전 마치나, 그리고 필립 K의 소설 도 안드로이드 드림 오브 일렉트릭 양? 딕. 딕은 인간의 주관성에 대한 우리의 이해가 인공지능으로 만들어진 기술에 의해 바뀐다는 생각을 고려합니다.[324]

참고 항목

- 인공지능 탐지 소프트웨어 – AI가 생성한 콘텐츠를 탐지하는 소프트웨어 한 설명이 된 페이지

- 행동 선택 알고리즘 – 지능형 에이전트의 행동을 선택하는 알고리즘

- 비즈니스 프로세스 자동화 – 복잡한 비즈니스 프로세스의 기술 지원 자동화

- 사례 기반 추론 – 유사한 과거 문제의 해결책을 기반으로 새로운 문제를 해결하는 과정

- 응급 알고리즘 – 응급 행동을 나타내는 알고리즘

- 인공지능 기술의 여성 젠더화

- 인공지능 용어집 – 인공지능 연구에서 일반적으로 사용되는 용어 및 개념 정의 목록

- 로봇 프로세스 자동화 – 비즈니스 프로세스 자동화 기술의 형태

- 약한 인공지능 – 인공지능의 형태

- Wetware 컴퓨터 – 유기물로 구성된 컴퓨터

- 지능증폭 – 인간의 지능을 증강시키기 위한 정보기술의 사용

설명주

- ^ a b 이 지능형 특성 목록은 다음을 포함하여 주요 AI 교과서에서 다루는 주제를 기반으로 합니다. Russell & Norvig (2021), Luger & Stubblefield (2004), Pool, Mackworth & Goebel (1998), Nilsson (1998)

- ^ a b 이 도구 목록은 다음을 포함하여 주요 AI 교과서에서 다루는 주제를 기반으로 합니다. Russell & Norvig (2021), Luger & Stubblefield (2004), Pool, Mackworth & Goebel (1998), Nilsson (1998)

- ^ 전문가 시스템이 지식을 포착하는 데 비효율적인 것으로 판명된 이유 중 하나입니다.[32][33]

- ^ "합리적 행위자"는 경제학, 철학 및 이론 인공 지능에서 일반적으로 사용되는 용어입니다. 사람, 동물, 기업, 국가 또는 AI의 경우 컴퓨터 프로그램과 같이 목표를 달성하도록 행동을 지시하는 모든 것을 의미할 수 있습니다.

- ^ 앨런 튜링은 일찍이 1950년에 그의 고전적인 논문 "컴퓨팅 머신과 지능"에서 학습의 중심성에 대해 논의했습니다.[44] 1956년 원래 다트머스 AI 여름 학회에서 레이 솔로몬오프는 감독되지 않은 확률론적 기계 학습에 대한 보고서인 "귀납적 추론 기계"를 작성했습니다.[45]

- ^ AI 윈터 § 머신 번역 및 1966년 ALPAC 보고서 참조

- ^ 기호 논리와 비교하여 공식적인 베이지안 추론은 계산 비용이 많이 듭니다. 추론이 추적 가능하려면 대부분의 관측치가 조건부로 서로 독립적이어야 합니다. 애드센스는 3억 개 이상의 에지가 있는 베이지안 네트워크를 사용하여 어떤 광고를 제공할지 알아봅니다.[89]

- ^ 기계 학습에서 가장 인기 있는 알고리즘 중 하나인 기대 최대화는 알려지지 않은 잠재 변수가 있는 경우 클러스터링을 가능하게 합니다.[91]

- ^ (특정 학습 알고리즘 없이) 심층 신경망의 일부 형태는 앨런 튜링(1948),[115] 프랭크 로젠블랫(1957),[115] 칼 스타인부흐(Karl Steinbuch) 및 로저 데이비드 조셉(Roger David Joseph)에 의해 설명되었습니다.[116] 에른스트 아이싱과 빌헬름 렌츠(1925)가 학습(또는 경사 하강법을 사용)한 심층 또는 반복 네트워크를 개발했습니다.[117] 올리버 셀프리지(1959),[116] 알렉세이 이바크넨코와 발렌틴 라파(1965),[117] 나카노 카오루(1977),[118] 아마리 슌이치(1972),[118] 조셉 홉필드(1982).[118] 역전파는 Henry J. Kelley (1960)에 의해 독립적으로 발견되었습니다.[115] Arthur E. 브라이슨(1962);[115] 스튜어트 드레퓌스(1962);[115] 아서 E. 브라이슨과 유치호(1969),[115] 세포 린나인마(1970),[119] 폴 베르보스(1974).[115] 사실 역전파와 경사 하강은 미적분학에서 고트프리트 라이프니츠의 연쇄 법칙(1676)을 직접 적용한 것이며,[120] 요한 칼 프리드리히 가우스(1795)와 아드리아-마리 레전드레(1805)가 독립적으로 개발한 최소 제곱의 방법과 본질적으로 동일합니다.[121] 과학의 역사가들이 아직 발견하지 못한 다른 많은 것들이 있을 것입니다.

- ^ 제프리 힌튼(Geoffrey Hinton)은 1990년대 신경망에 대한 연구에 대해 "우리의 레이블이 지정된 데이터 세트는 수천 배나 너무 작았습니다. [그리고] 우리의 컴퓨터는 수백만 배나 느렸습니다."[122]

- ^ 존 클라인버그(코넬), 센딜 뮬라이나단(시카고 대학), 신시아 촐데코바(카네기 멜론), 샘 코벳-데이비스([171]스탠포드)를 포함하여

- ^ Moritz Hardt(Max Planck Institute for Intelligent Systems)는 기계 학습이 "세상을 변화시키는 개입과 메커니즘을 설계하려는 많은 영역에 근본적으로 잘못된 도구"라고 주장합니다.[176]

- ^ 2018년 법이 통과될 때도 여전히 이 조항의 형태를 담고 있었습니다.

- ^ 이것은 유엔의 정의이며 지뢰와 같은 것도 포함됩니다.[189]

- ^ 표 4를 참조하십시오. 9%는 OECD 평균과 미국 평균입니다.[200]

- ^ 때때로 "로보칼립스"라고 불립니다.[208]

- ^ "전자 뇌"는 이 무렵 언론에서 사용하는 용어였습니다.[247][248]

- ^ 다니엘 크레비에(Daniel Crevier)는 "이 학회는 일반적으로 새로운 과학의 공식적인 탄생일로 인식됩니다."라고 썼습니다.[252] 러셀(Russell)과 노빅(Norvig)은 이 컨퍼런스를 "인공 지능의 시작"이라고 불렀습니다.[250]

- ^ 러셀(Russell)과 노빅(Norvig)은 "향후 20년 동안 이 분야는 이 사람들과 그들의 학생들에 의해 지배될 것"이라고 썼습니다.[253]

- ^ Russell과 Norvig는 "컴퓨터가 똑똑한 일을 할 때마다 놀라웠습니다."라고 썼습니다.[254]

- ^ 설명된 프로그램은 IBM 701을 위한 Arthur Samuel의 Checkers 프로그램, Daniel Bobrow의 Student, Newell and Simon의 논리 이론가, Terry Winograd의 SHRDLU입니다.

- ^ 러셀(Russell)과 노빅(Norvig)은 다음과 같이 썼습니다: "거의 모든 경우에 이러한 초기 시스템은 더 어려운 문제에서 실패했습니다."[258]

- ^ AI에[265] 대한 구체화된 접근 방식은 Hans Moravec과[266] Rodney Brooks에[267] 의해 옹호되었으며 많은 이름으로 알려졌습니다. 누벨 AI.[267] 발달 로봇공학,[268]

- ^ 마테오 웡은 아틀란틱에서 다음과 같이 썼습니다: "수십 년 동안, 자연어 처리, 컴퓨터 비전, 로봇 공학과 같은 컴퓨터 과학 분야는 매우 다른 방법을 사용했지만, 이제 그들은 모두 "딥 러닝"이라고 불리는 프로그래밍 방법을 사용합니다. 결과적으로 코드와 접근 방식은 더 유사해졌으며 모델은 서로 통합하기가 더 쉬워졌습니다."[274]

- ^ 잭 클라크(Jack Clark)는 블룸버그(Bloomberg)에 다음과 같이 썼습니다. "인공 지능 분야에서 50년 동안의 조용한 돌파구를 마련한 후, 2015년은 획기적인 한 해였습니다. 컴퓨터는 그 어느 때보다 똑똑하고 빠르게 학습하고 있습니다."라고 말하며, 구글에서 머신 러닝을 사용하는 소프트웨어 프로젝트의 수가 2012년 "가끔적 사용"에서 2015년 2,700개 이상의 프로젝트로 증가했다고 언급했습니다.[276]

- ^ 다른 사람의 문제 보기

- ^ 닐스 닐슨(Nils Nilsson)은 1983년에 다음과 같이 썼습니다. "간단히 말해서, AI가 무엇에 관한 것인지에 대해 분야에서 의견이 크게 엇갈리고 있습니다."[289]

- ^ Daniel Crevier는 "시간이 Dreyfus의 일부 논평의 정확성과 지각력을 입증했습니다. 그가 그것들을 덜 공격적으로 공식화했다면, 그들이 제안한 건설적인 조치는 훨씬 더 일찍 취해졌을지도 모릅니다."[294]

- ^ Searle는 1999년에 이러한 "강력한 AI"의 정의를 제시했습니다.[304] Searle의 원래 공식은 "적절하게 프로그램 된 컴퓨터는 말 그대로 다른 인지 상태를 이해하고 있다고 말할 수 있다는 점에서 마음입니다."였습니다.[305] 강한 인공지능은 러셀과 노빅에 의해 비슷하게 정의됩니다: "강한 인공지능 – 그렇게 하는 기계들이 (생각을 시뮬레이션하는 것이 아니라) 실제로 생각하고 있다는 주장."[306]

참고문헌

- ^ 구글(2016).

- ^ AI, 인간의 두뇌 파워를 뛰어넘을 것으로 설정 Wayback Machine CNN.com 에서 아카이브 2008-02-19 (2006년 7월 26일)

- ^ Kaplan, Andreas; Haenlein, Michael (2019). "Siri, Siri, in my hand: Who's the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence". Business Horizons. 62: 15–25. doi:10.1016/j.bushor.2018.08.004. S2CID 158433736.

- ^ a b c d Copeland, J., ed. (2004). The Essential Turing: the ideas that gave birth to the computer age. Oxford, England: Clarendon Press. ISBN 0-19-825079-7.

- ^ a b 다트머스 작업장:

- Russell & Norvig (2021, 페이지 18)

- 맥코덕 (2004, pp. 111–136)

- NRC (1999, 페이지 200–201)

- ^ a b 1960년대 성공적인 프로그램:

- McCorduck (2004, pp. 243–252)

- 크레비에 (1993, pp. 52–107)

- 모라벡 (1988, 페이지 9)

- Russell & Norvig (2021, 페이지 19-21)

- ^ a b 1980년대 초의 자금 지원 이니셔티브: 제 5세대 프로젝트(일본), Alvey(영국), Microelectronics and Computer Technology Corporation(미국), Strategic Computing Initiative(미국):

- McCorduck (2004, pp. 426–441)

- 크레비에 (1993, pp. 161–162, 197–203, 211, 240)

- Russell & Norvig (2021, 페이지 23)

- NRC (1999, 페이지 210-211)

- 뉴퀴스트 (1994, pp. 235–248)

- ^ a b 제1차 AI 윈터, 라이트힐 리포트, 맨스필드 수정

- 크레비에 (1993, 페이지 115–117)

- Russell & Norvig (2021, 페이지 21-22)

- NRC (1999, 페이지 212–213)

- 하우 (1994)

- 뉴퀴스트 (1994, 189–201쪽)

- ^ a b 두 번째 AI 윈터:

- Russell & Norvig (2021, 페이지 24)

- 맥코덕 (2004, pp. 430–435)

- 크레비에 (1993, pp. 209–210)

- NRC(1999, 페이지 214-216)

- 뉴퀴스트 (1994, pp. 301–318)

- ^ a b 딥러닝 혁명, AlexNet:

- 골드만 (2022년)

- Russell & Norvig (2021, 페이지 26)

- 맥킨지 (2018)

- ^ 토우즈 (2023).

- ^ 프랭크 (2023).

- ^ a b c 인공 일반 지능:

- Russell & Norvig (2021, 페이지 32–33, 1020–1021)

- ^ Russell & Norvig (2021, § 1.2)

- ^ 문제 해결, 퍼즐 해결, 게임 플레이 및 차감:

- Russell & Norvig (2021, 3-5장)

- Russell & Norvig (2021, chpt. 6) (제약 만족도)

- Pool, Mackworth & Goebel (1998, chpt. 2, 3, 7, 9)

- Luger & Stubblefield (2004, chpt. 3, 4, 6, 8)

- Nilsson (1998, 7-12장)

- ^ 불확실한 추론:

- Russell & Norvig (2021, 12-18장)

- Pool, Mackworth & Goebel (1998, 페이지 345–395)

- 루거 & 스터블필드(2004, pp. 333–381)

- Nilsson (1998, 7-12장)

- ^ a b c 난치성 및 효율성과 조합 폭발:

- Russell & Norvig (2021, 페이지 21)

- ^ a b c 유행성 하위 상징적 추론과 지식에 대한 심리적 증거:

- ^ 지식 표현 및 지식 공학:

- Russell & Norvig (2021, 10장)

- 풀, 맥워스 & 괴벨(1998, pp. 23–46, 69–81, 169–233, 235–277, 281–298, 319–345)

- 루거 & 스터블필드(2004, 페이지 227–243),

- Nilsson (1998, chpt. 17.1–17.4, 18)

- ^ Smoliar & Zhang (1994).

- ^ 노이만 & 묄러 (2008).

- ^ Kuperman, Reichley & Bailey (2006).

- ^ 맥개리 (2005).

- ^ 베르티니, 델 빔보 & 토르니아이 (2006).

- ^ Russell & Norvig (2021), 272쪽.

- ^ 범주 및 관계를 나타냅니다. 시맨틱 네트워크, 설명 로직, 상속(프레임 및 스크립트 포함):

- Russell & Norvig (2021, § 10.2 & 10.5),

- Pool, Mackworth & Goebel (1998, pp. 174–177),

- 루거 & 스터블필드(2004, 페이지 248-258),

- Nilsson (1998, 18.3절)

- ^ 이벤트 및 시간 표시:상황 미적분학, 이벤트 미적분학, 유창한 미적분학(프레임 문제 해결 포함):

- Russell & Norvig (2021, § 10.3),

- Pool, Mackworth & Goebel (1998, pp. 281–298),

- Nilsson (1998, 18.2절)

- ^ 인과 미적분학:

- Pool, Mackworth & Goebel (1998, 페이지 335–337)

- ^ 지식에 대한 지식을 나타내는 것: 신념 미적분학, 모달로직:

- Russell & Norvig (2021, § 10.4),

- 풀, 맥워스 & 고벨 (1998, 275-277쪽)

- ^ a b 기본 추론, 프레임 문제, 기본 논리, 비단조 논리, 외란, 닫힌 세계 가정, 납치:

- Russell & Norvig (2021, § 10.6)

- Pool, Mackworth & Goebel (1998, 페이지 248–256, 323–335)

- 루거 & 스터블필드 (2004, 페이지 335–363)

- Nilsson (1998, ~18.3.3)

- ^ a b 상식적인 지식의 폭:

- Lenat & Guha (1989, 소개)

- 크레비에(1993, pp. 113-114),

- Moravec(1988, p. 13),

- Russell & Norvig (2021, pp. 241, 385, 982) (자격 문제)

- ^ 뉴퀴스트(1994), 페이지 296.

- ^ 크리비어(1993), 페이지 204-208.

- ^ Russell & Norvig (2021), 페이지 528.

- ^ 자동화된 계획:

- Russell & Norvig (2021, 11장).

- ^ 자동화된 의사결정, 의사결정 이론:

- Russell & Norvig (2021, 16-18 장).

- ^ 고전적 계획:

- Russell & Norvig (2021, 11.2절)

- ^ 센서리스 또는 "적합" 계획, 우발 계획, 재계획(일명 온라인 계획):

- Russell & Norvig (2021, 11.5절)

- ^ 불확실한 기본 설정:

- Russell & Norvig (2021, 16.7절)

- Russell & Norvig (2021, 22.6절)

- ^ 정보 가치 이론:

- Russell & Norvig (2021, 16.6절).

- ^ 마르코프 결정 프로세스:

- Russell & Norvig (2021, 17장).

- ^ 게임 이론과 다중 에이전트 결정 이론:

- Russell & Norvig (2021, 18장).

- ^ 학습:

- Russell & Norvig (2021년, 19-22년)

- Pool, Mackworth & Goebel (1998, 397–438 페이지)

- 루거 & 스터블필드(2004, 페이지 385–542)

- Nilsson (1998, chpt. 3.3, 10.3, 17.5, 20)

- ^ 튜링 (1950).

- ^ 솔로몬오프(1956).

- ^ 비지도 학습:

- Russell & Norvig (2021, pp. 653) (정의)

- Russell & Norvig (2021, 페이지 738–740) (클러스터 분석)

- Russell & Norvig (2021, pp. 846–860) (단어 임베딩)

- ^ a b 지도 학습:

- Russell & Norvig (2021, § 19.2) (정의)

- Russell & Norvig (2021년, 19-20년) (기술)

- ^ 강화 학습:

- Russell & Norvig (2021, 22장)

- 루거 & 스터블필드 (2004, 페이지 442–449)

- ^ 전이 학습:

- Russell & Norvig (2021, 페이지 281)

- 이코노미스트 (2016)

- ^ "Artificial Intelligence (AI): What Is AI and How Does It Work? Built In". builtin.com. Retrieved 30 October 2023.

- ^ 컴퓨팅 학습 이론:

- Russell & Norvig (2021, 페이지 672–674)

- Jordan & Mitchell (2015)

- ^ 자연어 처리(NLP):

- Russell & Norvig (2021, 23-24장)

- Pool, Mackworth & Goebel (1998, pp. 91–104)

- 루거 & 스터블필드(2004, pp. 591–632)

- ^ NLP의 하위 문제:

- Russell & Norvig (2021, 페이지 849–850)

- ^ Russell & Norvig (2021), p. 856–858.

- ^ 딕슨 (2022).

- ^ NLP에 대한 최신 통계 및 딥 러닝 접근법:

- Russell & Norvig (2021, 24장)

- 캄브리아 앤 화이트 (2014)

- ^ 빈센트(2019).

- ^ Russell & Norvig (2021), 페이지 875-878.

- ^ 부시윅 (2023).

- ^ 컴퓨터 비전:

- Russell & Norvig (2021, 25장)

- Nilsson (1998, chpt). 6)

- ^ Russell & Norvig (2021), 페이지 849–850.

- ^ Russell & Norvig (2021), 페이지 895–899

- ^ Russell & Norvig (2021), pp. 899–901.

- ^ Russell & Norvig (2021), 페이지 931-938.

- ^ MITAIL (2014).

- ^ 정의적 컴퓨팅:

- ^ 와델 (2018).

- ^ 포리아 외(2017).

- ^ 검색 알고리즘:

- Russell & Norvig (2021, 3-5장)

- Pool, Mackworth & Goebel (1998, pp. 113–163)

- 루거 & 스터블필드(2004, 페이지 79–164, 193–219)

- Nilsson (1998, 7-12장)

- ^ 상태 공간 검색:

- Russell & Norvig (2021, chpt. 3)

- ^ Russell & Norvig (2021), § 11.2.

- ^ 정보가 없는 검색(넓이 우선 검색, 깊이 우선 검색 및 일반 상태 공간 검색):

- Russell & Norvig (2021, § 3.4)

- Pool, Mackworth & Goebel (1998, pp. 113–132)

- 루거 & 스터블필드 (2004, 페이지 79–121)

- Nilsson (1998, chpt). 8)

- ^ 휴리스틱 또는 정보에 입각한 검색(예: greed best first and A*):

- Russell & Norvig (2021, s § 3.5)

- 풀, 맥워스 & 고벨 (1998, 132-147쪽)

- Pool & Mackworth (2017, § 3.6)

- 루거 & 스터블필드 (2004, 페이지 133-150)

- ^ 적대적 검색:

- Russell & Norvig (2021, chpt. 5)

- ^ 로컬 또는 "최적화" 검색:

- Russell & Norvig (2021, chpt. 4)

- ^ Singh Chauhan, Nagesh (18 December 2020). "Optimization Algorithms in Neural Networks". KDnuggets. Retrieved 13 January 2024.

- ^ 진화적 계산:

- Russell & Norvig (2021, § 4.1.2)

- ^ 메르클 & 미드덴도르프 (2013).

- ^ 논리:

- Russell & Norvig (2021, 6-9장)

- 루거 & 스터블필드 (2004, 페이지 35-77)

- 닐슨 (1998, 13-16장)

- ^ 명제 논리:

- Russell & Norvig (2021, chpt. 6)

- 루거 & 스터블필드 (2004, 페이지 45-50)

- Nilsson (1998, 13장)

- ^ 등식과 같은 1차 논리 및 특징:

- Russell & Norvig (2021, 7장)

- Pool, Mackworth & Goebel (1998, 페이지 268–275),

- 루거 & 스터블필드(2004, pp. 50-62),

- Nilsson (1998, 15장)

- ^ 논리적 추론:

- Russell & Norvig (2021, 10장)

- ^ 검색으로 논리적 추론:

- Russell & Norvig (2021, § 9.3, § 9.4)

- 풀, 맥워스 & 괴벨 (1998, pp. ~46–52)

- 루거 & 스터블필드 (2004, pp. 62-73)

- Nilsson (1998, chpt. 4.2, 7.2)

- ^ 결의 및 통일:

- Russell & Norvig (2021, §7.5.2, §9.2, §9.5)

- ^ Warren, D.H.; Pereira, L.M.; Pereira, F. (1977). "Prolog-the language and its implementation compared with Lisp". ACM SIGPLAN Notices. 12 (8): 109–115. doi:10.1145/872734.806939.

- ^ 퍼지 논리:

- Russell & Norvig (2021, pp. 214, 255, 459)

- 사이언티픽 아메리칸 (1999)

- ^ a b 불확실한 추론을 위한 확률적 방법:

- Russell & Norvig (2021, 12-18, 20장),

- Pool, Mackworth & Goebel (1998, 페이지 345–395),

- 루거 & 스터블필드(2004, 페이지 165–191, 333–381),

- Nilsson (1998, 19장)

- ^ 베이지안 네트워크:

- Russell & Norvig (2021, §12.5–12.6, §13.4–13.5, §14.3–14.5, §16.5, §20.2 -20.3),

- Pool, Mackworth & Goebel (1998, 페이지 361–381),

- 루거 & 스터블필드(2004, pp. ~182–190, ≈ 363–379),

- Nilsson (1998, chpt. 19.3–4)

- ^ 도밍고스(2015), 6장.

- ^ 베이지안 추론 알고리즘:

- Russell & Norvig (2021, § 13.3–13.5),

- Pool, Mackworth & Goebel (1998, 페이지 361–381),

- 루거 & 스터블필드(2004, pp. ~363–379),

- Nilsson (1998, 19.4 & 7장)

- ^ 도밍고스(2015), p. 210.

- ^ 베이지안 학습과 기대-최대화 알고리즘:

- Russell & Norvig (2021년 10월 20일),

- Pool, Mackworth & Goebel (1998, 페이지 424-433),

- Nilsson (1998, 20장)

- 도밍고스 (2015, p. 210)

- ^ 베이지안 의사결정 이론 및 베이지안 의사결정 네트워크:

- Russell & Norvig (2021, § 16.5)

- ^ a b c 확률적 시간 모델:

- Russell & Norvig (2021, 14장)

- Russell & Norvig (2021, § 14.3)

- Russell & Norvig (2021, § 14.4)

- Russell & Norvig (2021, § 14.5)

- ^ 결정 이론 및 결정 분석:

- Russell & Norvig (2021, 16-18 장),

- Pool, Mackworth & Goebel (1998, 381–394 페이지)

- ^ 정보 가치 이론:

- Russell & Norvig (2021, § 16.6)

- ^ 마르코프 의사결정 프로세스 및 동적 의사결정 네트워크:

- Russell & Norvig (2021, 17장)

- ^ 게임 이론 및 메커니즘 설계:

- Russell & Norvig (2021, 18장)

- ^ 통계 학습 방법 및 분류기:

- Russell & Norvig (2021, 20장),

- ^ 의사결정 트리:

- Russell & Norvig (2021, § 19.3)

- 도밍고스 (2015, p. 88)

- ^ K-최근접 이웃 및 지원 벡터 머신과 같은 비모수적 학습 모델:

- Russell & Norvig (2021, § 19.7)

- 도밍고스 (2015, p. 187) (k-가장 가까운 이웃)

- 도밍고(2015, p. 88)(커널 방법)

- ^ 도밍고스(2015), p. 152.

- ^ 나이브 베이즈 분류기:

- Russell & Norvig (2021, § 12.6)

- 도밍고스 (2015, p. 152)

- ^ a b 신경망:

- Russell & Norvig (2021, 21장),

- 도밍고스 (2015, 4장)

- ^ 계산 그래프의 기울기 계산, 역전파, 자동 미분:

- Russell & Norvig (2021, § 21.2),

- Luger & Stubblefield(2004, 페이지 467–474),

- Nilsson (1998, chpt. 3.3)

- ^ 보편적 근사 정리:

- Russell & Norvig (2021, 페이지 752)

- ^ 피드포워드 신경망:

- Russell & Norvig (2021, § 21.1)

- ^ 반복 신경망:

- Russell & Norvig (2021, § 21.6)

- ^ 퍼셉트론:

- Russell & Norvig (2021, pp. 21, 22, 683, 22)

- ^ a b 딥러닝:

- ^ 컨볼루션 신경망:

- Russell & Norvig (2021, § 21.3)

- ^ 덩앤유(2014), 199-200쪽.

- ^ Ciresan, Meier & Schmidhuber (2012).

- ^ Russell & Norvig (2021), 페이지 751.

- ^ a b c d e f g Russell & Norvig (2021), 페이지 785.

- ^ a b Schmidhuber (2022), §5.

- ^ a b Schmidhuber (2022), §6.

- ^ a b c Schmidhuber (2022), §7.

- ^ Schmidhuber (2022), §8.

- ^ Schmidhuber (2022), §2.

- ^ Schmidhuber (2022), §3.

- ^ Christian에서 인용 (2020, 페이지 22)

- ^ 스미스 (2023).

- ^ "Explained: Generative AI". 9 November 2023.

- ^ "AI Writing and Content Creation Tools". MIT Sloan Teaching & Learning Technologies. Retrieved 25 December 2023.

- ^ Marmouyet (2023).

- ^ 코비엘루스 (2019).

- ^ Davenport, T; Kalakota, R (June 2019). "The potential for artificial intelligence in healthcare". Future Healthc J. 6 (2): 94–98. doi:10.7861/futurehosp.6-2-94. PMC 6616181. PMID 31363513.

- ^ a b Bax, Monique; Thorpe, Jordan; Romanov, Valentin (December 2023). "The future of personalized cardiovascular medicine demands 3D and 4D printing, stem cells, and artificial intelligence". Frontiers in Sensors. 4. doi:10.3389/fsens.2023.1294721. ISSN 2673-5067.

- ^ Jumper, J; Evans, R; Pritzel, A (2021). "Highly accurate protein structure prediction with AlphaFold". Nature. 596 (7873): 583–589. Bibcode:2021Natur.596..583J. doi:10.1038/s41586-021-03819-2. PMC 8371605. PMID 34265844.

- ^ "AI discovers new class of antibiotics to kill drug-resistant bacteria". 20 December 2023.

- ^ Grant, Eugene F.; Lardner, Rex (25 July 1952). "The Talk of the Town – It". The New Yorker. ISSN 0028-792X. Retrieved 28 January 2024.

- ^ Anderson, Mark Robert (11 May 2017). "Twenty years on from Deep Blue vs Kasparov: how a chess match started the big data revolution". The Conversation. Retrieved 28 January 2024.

- ^ Markoff, John (16 February 2011). "Computer Wins on 'Jeopardy!': Trivial, It's Not". The New York Times. ISSN 0362-4331. Retrieved 28 January 2024.

- ^ Byford, Sam (27 May 2017). "AlphaGo retires from competitive Go after defeating world number one 3-0". The Verge. Retrieved 28 January 2024.

- ^ Brown, Noam; Sandholm, Tuomas (30 August 2019). "Superhuman AI for multiplayer poker". Science. 365 (6456): 885–890. doi:10.1126/science.aay2400. ISSN 0036-8075.

- ^ "MuZero: Mastering Go, chess, shogi and Atari without rules". Google DeepMind. 23 December 2020. Retrieved 28 January 2024.

- ^ Sample, Ian (30 October 2019). "AI becomes grandmaster in 'fiendishly complex' StarCraft II". The Guardian. ISSN 0261-3077. Retrieved 28 January 2024.

- ^ Wurman, P.R.; Barrett, S.; Kawamoto, K. (2022). "Outracing champion Gran Turismo drivers with deep reinforcement learning". Nature 602. 602 (7896): 223–228. doi:10.1038/s41586-021-04357-7.

- ^ a b c Congressional Research Service (2019). Artificial Intelligence and National Security (PDF). Washington, DC: Congressional Research Service.PD통보

- ^ a b Slyusar, Vadym (2019). "Artificial intelligence as the basis of future control networks". ResearchGate. doi:10.13140/RG.2.2.30247.50087.

- ^ Knight, Will. "The US and 30 Other Nations Agree to Set Guardrails for Military AI". Wired. ISSN 1059-1028. Retrieved 24 January 2024.

- ^ Marcelline, Marco (27 May 2023). "ChatGPT: Most Americans Know About It, But Few Actually Use the AI Chatbot". PCMag. Retrieved 28 January 2024.

- ^ Lu, Donna (31 March 2023). "Misinformation, mistakes and the Pope in a puffer: what rapidly evolving AI can – and can't – do". The Guardian. ISSN 0261-3077. Retrieved 28 January 2024.

- ^ Hurst, Luke (23 May 2023). "How a fake image of a Pentagon explosion shared on Twitter caused a real dip on Wall Street". euronews. Retrieved 28 January 2024.

- ^ Ransbotham, Sam; Kiron, David; Gerbert, Philipp; Reeves, Martin (6 September 2017). "Reshaping Business With Artificial Intelligence". MIT Sloan Management Review. Archived from the original on 13 February 2024.

- ^ 시모나이트 (2016).

- ^ Russell & Norvig (2021), p. 987.

- ^ 라스코프스키 (2023).

- ^ GAO (2022).

- ^ 발린스키 (2019).

- ^ Russell & Norvig (2021), p. 991.

- ^ Russell & Norvig (2021), p. 991–992.

- ^ Christian (2020), p. 63.

- ^ 빈센트 (2022).

- ^ Reisner (2023).

- ^ Alter & Harris (2023).

- ^ 니카스 (2018).

- ^ Rainie, Lee; Keeter, Scott; Perrin, Andrew (22 July 2019). "Trust and Distrust in America". Pew Research Center. Archived from the original on 22 February 2024.

- ^ 윌리엄스 (2023).

- ^ 테일러 앤 허(Taylor & Hern, 2023).

- ^ a b 장미 (2023).

- ^ 씨엔에이(2019).

- ^ Goffrey (2008), p. 17.

- ^ Berdahl et al. (2023); Goffrey (2008, p. 17); Rose (2023); Russell & Norvig (2021, 페이지 995)

- ^ 알고리즘 편향과 공정성(기계 학습):

- Russell & Norvig (2021, 섹션 27.3.3)

- 크리스찬 (2020, 공정)

- ^ Christian (2020), p. 25.

- ^ a b Russell & Norvig (2021), p. 995.

- ^ 그랜트앤힐(2023).

- ^ Larson & Angwin (2016).

- ^ Christian (2020), 페이지 67-70.

- ^ Christian (2020, 페이지 67–70); Russell & Norvig (2021, 페이지 993–994)

- ^ Russell & Norvig (2021, p. 995); Lipartito (2011, p. 36); Goodman & Flaxman (2017, p. 6); Christian (2020, p. 39–40, 65)

- ^ Christian에서 인용(2020, 페이지 65).

- ^ Russell & Norvig (2021, 페이지 994); Christian (2020, pp. 40, 80-81)

- ^ Christian에서 인용(2020, p. 80)

- ^ 도크릴 (2022).

- ^ 표본(2017).

- ^ "Black Box AI". 16 June 2023.

- ^ 크리스찬(2020), 110쪽.

- ^ Christian (2020), 88-91 페이지.

- ^ Christian (2020, p. 83); Russell & Norvig (2021, p. 997)

- ^ Christian (2020), p. 91.

- ^ Christian (2020), p. 83.

- ^ Verma (2021).

- ^ 로스만 (2020).

- ^ Christian (2020), p. 105-108.

- ^ 크리스찬(2020), 108-112쪽.

- ^ Russell & Norvig (2021), p. 989.

- ^ a b Russell & Norvig (2021), p. 987-990.

- ^ Russell & Norvig (2021), p. 988.

- ^ Robitzski (2018); Sainato (2015)

- ^ 하라리 (2018).

- ^ Buckley, Chris; Mozur, Paul (22 May 2019). "How China Uses High-Tech Surveillance to Subdue Minorities". The New York Times.

- ^ "Security lapse exposed a Chinese smart city surveillance system". 3 May 2019. Archived from the original on 7 March 2021. Retrieved 14 September 2020.

- ^ Urbina et al. (2022).

- ^ a b E McGauhey, '로봇이 당신의 직업을 자동화할 것인가? 완전고용, 기본소득, 경제민주주의' (2022) 51조 3항 산업법 저널 511-559 2023년 5월 27일 웨이백 머신에서 아카이브

- ^ Ford & Colvin (2015); McGauhey (2022)

- ^ IGM 시카고 (2017).

- ^ Arntz, Gregory & Zierahn (2016), p. 33.

- ^ Lohr (2017); Frey & Osborne (2017); Arntz, Gregory & Zieran (2016, p. 33)

- ^ 모르겐스턴 (2015).

- ^ 마하다위 (2017); 톰슨 (2014)

- ^ Zhou, Viola (11 April 2023). "AI is already taking video game illustrators' jobs in China". Rest of World. Retrieved 17 August 2023.

- ^ Carter, Justin (11 April 2023). "China's game art industry reportedly decimated by growing AI use". Game Developer. Retrieved 17 August 2023.

- ^ Tarnoff, Ben (4 August 2023). "Lessons from Eliza". The Guardian Weekly. pp. 34–9.

- ^ 셀란 존스 (2014).

- ^ Russell & Norvig 2021, p. 1001.

- ^ 보스트롬 (2014).

- ^ 러셀 (2019).

- ^ 보스트롬(2014); 뮐러 & 보스트롬(2014); 보스트롬(2015).

- ^ 하라리 (2023).

- ^ 뮐러 & 보스트롬 (2014).

- ^ 2015년경 AI의 실존적 위험에 대한 리더들의 우려:

- ^ 발란스 (2023).

- ^ Taylor, Josh (7 May 2023). "Rise of artificial intelligence is inevitable but should not be feared, 'father of AI' says". The Guardian. Retrieved 26 May 2023.

- ^ Colton, Emma (7 May 2023). "'Father of AI' says tech fears misplaced: 'You cannot stop it'". Fox News. Retrieved 26 May 2023.

- ^ Jones, Hessie (23 May 2023). "Juergen Schmidhuber, Renowned 'Father Of Modern AI,' Says His Life's Work Won't Lead To Dystopia". Forbes. Retrieved 26 May 2023.

- ^ McMorrow, Ryan (19 December 2023). "Andrew Ng: 'Do we think the world is better off with more or less intelligence?'". Financial Times. Retrieved 30 December 2023.

- ^ Levy, Steven (22 December 2023). "How Not to Be Stupid About AI, With Yann LeCun". Wired. Retrieved 30 December 2023.

- ^ AI가 임박한 위험이 아니라는 주장:

- ^ a b Christian (2020), pp. 67, 73.

- ^ Yudkowsky (2008).

- ^ a b Anderson & Anderson (2011).

- ^ AAAAI (2014).

- ^ 왈라크 (2010).

- ^ 러셀 (2019), 페이지 173.

- ^ Alan Turing Institute (2019). "Understanding artificial intelligence ethics and safety" (PDF).

- ^ Alan Turing Institute (2023). "AI Ethics and Governance in Practice" (PDF).

- ^ Floridi, Luciano; Cowls, Josh (23 June 2019). "A Unified Framework of Five Principles for AI in Society". Harvard Data Science Review. 1 (1). doi:10.1162/99608f92.8cd550d1. S2CID 198775713.

- ^ Buruk, Banu; Ekmekci, Perihan Elif; Arda, Berna (1 September 2020). "A critical perspective on guidelines for responsible and trustworthy artificial intelligence". Medicine, Health Care and Philosophy. 23 (3): 387–399. doi:10.1007/s11019-020-09948-1. ISSN 1572-8633. PMID 32236794. S2CID 214766800.

- ^ Kamila, Manoj Kumar; Jasrotia, Sahil Singh (1 January 2023). "Ethical issues in the development of artificial intelligence: recognizing the risks". International Journal of Ethics and Systems. ahead-of-print (ahead-of-print). doi:10.1108/IJOES-05-2023-0107. ISSN 2514-9369. S2CID 259614124.

- ^ 위험 완화를 위한 AI 규제:

- ^ Law Library of Congress (미국). Global Legal Research Directorate (2019).

- ^ a b 빈센트 (2023).

- ^ 스탠포드 대학교 (2023년).

- ^ a b c d 유네스코(2021).

- ^ 키신저(2021).

- ^ Altman, Brockman & Sutskever (2023).

- ^ VOA News (25 October 2023). "UN Announces Advisory Body on Artificial Intelligence".

- ^ 에드워즈 (2023).

- ^ 카스페로비치 (2023).

- ^ 폭스 뉴스 (2023).

- ^ Milmo, Dan (3 November 2023). "Hope or Horror? The great AI debate dividing its pioneers". The Guardian Weekly. pp. 10–12.

- ^ "The Bletchley Declaration by Countries Attending the AI Safety Summit, 1-2 November 2023". GOV.UK. 1 November 2023. Archived from the original on 1 November 2023. Retrieved 2 November 2023.

- ^ "Countries agree to safe and responsible development of frontier AI in landmark Bletchley Declaration". GOV.UK (Press release). Archived from the original on 1 November 2023. Retrieved 1 November 2023.

- ^ a b Russell & Norvig 2021, p. 9.

- ^ "Google books ngram".

- ^ AI의 즉각적인 선구자:

- 맥코덕 (2004, pp. 51–107)

- 크레비에 (1993, 페이지 27-32)

- Russell & Norvig (2021, 페이지 8-17)

- 모라벡 (1988, p. 3)

- ^ a b Russell & Norvig (2021), p. 17.

- ^ a b 튜링은 《컴퓨터 기계와 지능》에서 튜링 테스트를 최초로 출판했습니다. 역사적 영향과 철학적 함의:

- 하우글랜드 (1985, 페이지 6-9)

- 크레비에 (1993, 페이지 24)

- 맥코덕 (2004, pp. 70-71)

- Russell & Norvig (2021, pp. 2, 984)

- ^ 크리비어(1993), 페이지 47-49.

- ^ Russell & Norvig (2003), 페이지 17.

- ^ Russell & Norvig (2003), 페이지 18.

- ^ 뉴퀴스트(1994), 페이지 86-86.

- ^ 사이먼(1965, p. 96), 크레비에 인용(1993, p. 109)

- ^ 민스키(1967, p. 2), 크레비에 인용(1993, p. 109)

- ^ Russell & Norvig (2021), p. 21.

- ^ 라이트힐 (1973).

- ^ NRC 1999, 페이지 212–213.

- ^ Russell & Norvig (2021), 페이지 22.

- ^ 전문가 시스템:

- Russell & Norvig (2021, 23페이지, 292)

- 루거 & 스터블필드(2004, 페이지 227–331)

- Nilsson (1998, 17.4절)

- McCorduck (2004, pp. 327–335, 434–435)

- 크레비에 (1993, pp. 145–62, 197–203)

- 뉴퀴스트 (1994, 페이지 155–183)

- ^ Russell & Norvig (2021), 페이지 24.

- ^ Nilsson (1998), 페이지 7.

- ^ McCorduck (2004), pp. 454–462.

- ^ 모라벡 (1988).

- ^ a b 브룩스 (1990).

- ^ 발달 로봇 공학:

- ^ Russell & Norvig (2021), 페이지 25.

- ^

- 크레비에 (1993, pp. 214–215)

- Russell & Norvig (2021, 24, 26페이지)

- ^ Russell & Norvig (2021), 페이지 26.

- ^ 1990년대에 채택된 형식적이고 좁은 방법:

- Russell & Norvig (2021, 페이지 24-26)

- McCorduck (2004, pp. 486–487)

- ^ 1990년대 후반에 널리 사용된 AI:

- Kurzweil (2005, p. 265)

- NRC(1999, 페이지 216-222)

- 뉴퀴스트 (1994, 189–201쪽)

- ^ 웡 (2023).

- ^ 무어의 법칙과 AI:

- Russell & Norvig (2021, 페이지 14, 27)

- ^ a b c 클락 (2015b).

- ^ 빅데이터:

- Russell & Norvig (2021, 페이지 26)

- ^ Sagar, Ram (3 June 2020). "OpenAI Releases GPT-3, The Largest Model So Far". Analytics India Magazine. Archived from the original on 4 August 2020. Retrieved 15 March 2023.

- ^ DiFeliciantonio (2023).

- ^ Goswami (2023).

- ^ a b 튜링 (1950), p. 1.

- ^ 튜링(1950), "의식으로부터의 주장" 아래.

- ^ Russell & Norvig (2021), 2장.

- ^ Russell & Norvig (2021), 페이지 3.

- ^ 메이커 (2006).

- ^ 매카시 (1999).

- ^ 민스키 (1986).

- ^ "What Is Artificial Intelligence (AI)?". Google Cloud Platform. Archived from the original on 31 July 2023. Retrieved 16 October 2023.

- ^ Nilsson (1983), p. 10.

- ^ Haugland (1985), 112-117쪽.

- ^ 물리적 기호 체계 가설: 역사적 의미:

- 맥코덕(2004, p. 153)

- Russell & Norvig (2021, 페이지 19)

- ^ 모라벡의 역설:

- ^ Dreyfus의 AI에 대한 비판: 역사적 의의와 철학적 함의:

- 크레비에 (1993, pp. 120-132)

- 맥코덕 (2004, pp. 211–239)

- Russell & Norvig (2021, 페이지 981–982)

- 페른 (2007, 3장)

- ^ 크리비어(1993), 페이지 125.

- ^ 랭글리 (2011).

- ^ 카츠 (2012).

- ^ 니츠 대 스크루피, 역사적 논쟁:

- McCorduck (2004, pp. 421–424, 486–489)

- 크레비에 (1993, 페이지 168)

- 닐슨 (1983, pp. 10-11)

- Russell & Norvig (2021, 페이지 24)

- ^ Pennachin & Goertzel (2007).

- ^ a b 로버츠(2016).

- ^ Russell & Norvig (2021), p. 986.

- ^ Chalmers (1995).

- ^ 데넷(1991).

- ^ 호스트 (2005).

- ^ 세얼 (1999).

- ^ Searle (1980), p. 1.

- ^ Russell & Norvig (2021), p. 9817.

- ^ 설의 중국어 방 논쟁:

- 설(1980). 사유 실험에 대한 설의 독창적인 발표.

- 세얼 (1999).

- Russell & Norvig (2021, pp. 985)

- McCorduck (2004, pp. 443–445)

- Crevier (1993, pp. 269–271)

- ^ Leith, Sam (7 July 2022). "Nick Bostrom: How can we be certain a machine isn't conscious?". The Spectator. Retrieved 23 February 2024.

- ^ a b c Thomson, Jonny (31 October 2022). "Why don't robots have rights?". Big Think. Retrieved 23 February 2024.

- ^ a b Kateman, Brian (24 July 2023). "AI Should Be Terrified of Humans". TIME. Retrieved 23 February 2024.

- ^ Wong, Jeff (10 July 2023). "What leaders need to know about robot rights". Fast Company.

- ^ Hern, Alex (12 January 2017). "Give robots 'personhood' status, EU committee argues". The Guardian. ISSN 0261-3077. Retrieved 23 February 2024.

- ^ Dovey, Dana (14 April 2018). "Experts Don't Think Robots Should Have Rights". Newsweek. Retrieved 23 February 2024.

- ^ Cuddy, Alice (13 April 2018). "Robot rights violate human rights, experts warn EU". euronews. Retrieved 23 February 2024.

- ^ 지능 폭발과 기술적 특이점:

- Russell & Norvig (2021, 페이지 1004–1005)

- 오오훈드로 (2008)

- 커즈와일 (2005)

- ^ Russell & Norvig (2021), 페이지 1005.

- ^ 트랜스 휴머니즘:

- 모라벡 (1988)

- 커즈와일 (2005)

- Russell & Norvig (2021, 페이지 1005)

- ^ 진화로서의 AI:

- Edward Fredkin은 McCorduck에서 인용했습니다(2004, p. 401).

- 집사 (1863)

- 다이슨 (1998)

- ^ 신화 속 AI:

- 맥코덕 (2004, pp. 4-5)

- ^ 맥코덕(2004), 페이지 340-400.

- ^ 부타초 (2001).

- ^ 앤더슨 (2008).

- ^ 맥컬리 (2007).

- ^ Galvan (1997).

인공지능 교재

2023년 가장 널리 사용된 교과서 2종 (열린 강의 계획서 참조)

- Russell, Stuart J.; Norvig, Peter. (2021). Artificial Intelligence: A Modern Approach (4th ed.). Hoboken: Pearson. ISBN 978-0134610993. LCCN 20190474.

- Rich, Elaine; Knight, Kevin; Nair, Shivashankar B (2010). Artificial Intelligence (3rd ed.). New Delhi: Tata McGraw Hill India. ISBN 978-0070087705.

2008년에 가장 널리 사용된 4종의 AI 교재는 다음과 같습니다.

- Luger, George; Stubblefield, William (2004). Artificial Intelligence: Structures and Strategies for Complex Problem Solving (5th ed.). Benjamin/Cummings. ISBN 978-0-8053-4780-7. Archived from the original on 26 July 2020. Retrieved 17 December 2019.

- Nilsson, Nils (1998). Artificial Intelligence: A New Synthesis. Morgan Kaufmann. ISBN 978-1-55860-467-4. Archived from the original on 26 July 2020. Retrieved 18 November 2019.

- Russell, Stuart J.; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2nd ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2.

- Poole, David; Mackworth, Alan; Goebel, Randy (1998). Computational Intelligence: A Logical Approach. New York: Oxford University Press. ISBN 978-0-19-510270-3. Archived from the original on 26 July 2020. Retrieved 22 August 2020.

후기판.

- Poole, David; Mackworth, Alan (2017). Artificial Intelligence: Foundations of Computational Agents (2nd ed.). Cambridge University Press. ISBN 978-1-107-19539-4. Archived from the original on 7 December 2017. Retrieved 6 December 2017.

AI의 역사

- Crevier, Daniel (1993). AI: The Tumultuous Search for Artificial Intelligence. New York, NY: BasicBooks. ISBN 0-465-02997-3..

- McCorduck, Pamela (2004), Machines Who Think (2nd ed.), Natick, MA: A. K. Peters, Ltd., ISBN 1-56881-205-1.

- Newquist, H. P. (1994). The Brain Makers: Genius, Ego, And Greed In The Quest For Machines That Think. New York: Macmillan/SAMS. ISBN 978-0-672-30412-5.

기타출처

- AI & ML in Fusion

- AI & ML in Fusion, 비디오 강의 2023년 7월 2일 Wayback Machine에서 아카이브

- "AlphaGo – Google DeepMind". Archived from the original on 10 March 2016.

- Alter, Alexandra; Harris, Elizabeth A. (20 September 2023), "Franzen, Grisham and Other Prominent Authors Sue OpenAI", The New York Times

- Altman, Sam; Brockman, Greg; Sutskever, Ilya (22 May 2023). "Governance of Superintelligence". openai.com. Archived from the original on 27 May 2023. Retrieved 27 May 2023.

- Anderson, Susan Leigh (2008). "Asimov's "three laws of robotics" and machine metaethics". AI & Society. 22 (4): 477–493. doi:10.1007/s00146-007-0094-5. S2CID 1809459.

- Anderson, Michael; Anderson, Susan Leigh (2011). Machine Ethics. Cambridge University Press.

- Arntz, Melanie; Gregory, Terry; Zierahn, Ulrich (2016), "The risk of automation for jobs in OECD countries: A comparative analysis", OECD Social, Employment, and Migration Working Papers 189

- Asada, M.; Hosoda, K.; Kuniyoshi, Y.; Ishiguro, H.; Inui, T.; Yoshikawa, Y.; Ogino, M.; Yoshida, C. (2009). "Cognitive developmental robotics: a survey". IEEE Transactions on Autonomous Mental Development. 1 (1): 12–34. doi:10.1109/tamd.2009.2021702. S2CID 10168773.

- "Ask the AI experts: What's driving today's progress in AI?". McKinsey & Company. Archived from the original on 13 April 2018. Retrieved 13 April 2018.

- Barfield, Woodrow; Pagallo, Ugo (2018). Research handbook on the law of artificial intelligence. Cheltenham, UK: Edward Elgar Publishing. ISBN 978-1-78643-904-8. OCLC 1039480085.

- Beal, J.; Winston, Patrick (2009), "The New Frontier of Human-Level Artificial Intelligence", IEEE Intelligent Systems, 24: 21–24, doi:10.1109/MIS.2009.75, hdl:1721.1/52357, S2CID 32437713

- Berdahl, Carl Thomas; Baker, Lawrence; Mann, Sean; Osoba, Osonde; Girosi, Federico (7 February 2023). "Strategies to Improve the Impact of Artificial Intelligence on Health Equity: Scoping Review". JMIR AI. 2: e42936. doi:10.2196/42936. ISSN 2817-1705. S2CID 256681439. Archived from the original on 21 February 2023. Retrieved 21 February 2023.

- Berlinski, David (2000). The Advent of the Algorithm. Harcourt Books. ISBN 978-0-15-601391-8. OCLC 46890682. Archived from the original on 26 July 2020. Retrieved 22 August 2020.

- Berryhill, Jamie; Heang, Kévin Kok; Clogher, Rob; McBride, Keegan (2019). Hello, World: Artificial Intelligence and its Use in the Public Sector (PDF). Paris: OECD Observatory of Public Sector Innovation. Archived (PDF) from the original on 20 December 2019. Retrieved 9 August 2020.

- Bertini, M; Del Bimbo, A; Torniai, C (2006). "Automatic annotation and semantic retrieval of video sequences using multimedia ontologies". MM '06 Proceedings of the 14th ACM international conference on Multimedia. 14th ACM international conference on Multimedia. Santa Barbara: ACM. pp. 679–682.

- Bostrom, Nick (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

- Bostrom, Nick (2015). "What happens when our computers get smarter than we are?". TED (conference). Archived from the original on 25 July 2020. Retrieved 30 January 2020.

- Brooks, Rodney (10 November 2014). "artificial intelligence is a tool, not a threat". Archived from the original on 12 November 2014.

- Brooks, Rodney (1990). "Elephants Don't Play Chess" (PDF). Robotics and Autonomous Systems. 6 (1–2): 3–15. CiteSeerX 10.1.1.588.7539. doi:10.1016/S0921-8890(05)80025-9. Archived (PDF) from the original on 9 August 2007.

- Buiten, Miriam C (2019). "Towards Intelligent Regulation of Artificial Intelligence". European Journal of Risk Regulation. 10 (1): 41–59. doi:10.1017/err.2019.8. ISSN 1867-299X.

- Bushwick, Sophie (16 March 2023), "What the New GPT-4 AI Can Do", Scientific American

- Butler, Samuel (13 June 1863). "Darwin among the Machines". Letters to the Editor. The Press. Christchurch, New Zealand. Archived from the original on 19 September 2008. Retrieved 16 October 2014 – via Victoria University of Wellington.

- Buttazzo, G. (July 2001). "Artificial consciousness: Utopia or real possibility?". Computer. 34 (7): 24–30. doi:10.1109/2.933500.

- Cambria, Erik; White, Bebo (May 2014). "Jumping NLP Curves: A Review of Natural Language Processing Research [Review Article]". IEEE Computational Intelligence Magazine. 9 (2): 48–57. doi:10.1109/MCI.2014.2307227. S2CID 206451986.

- Cellan-Jones, Rory (2 December 2014). "Stephen Hawking warns artificial intelligence could end mankind". BBC News. Archived from the original on 30 October 2015. Retrieved 30 October 2015.

- Chalmers, David (1995). "Facing up to the problem of consciousness". Journal of Consciousness Studies. 2 (3): 200–219. Archived from the original on 8 March 2005. Retrieved 11 October 2018.

- Christian, Brian (2020). The Alignment Problem: Machine learning and human values. W. W. Norton & Company. ISBN 978-0-393-86833-3. OCLC 1233266753.

- Ciresan, D.; Meier, U.; Schmidhuber, J. (2012). "Multi-column deep neural networks for image classification". 2012 IEEE Conference on Computer Vision and Pattern Recognition. pp. 3642–3649. arXiv:1202.2745. doi:10.1109/cvpr.2012.6248110. ISBN 978-1-4673-1228-8. S2CID 2161592.

- Clark, Jack (2015b). "Why 2015 Was a Breakthrough Year in Artificial Intelligence". Bloomberg.com. Archived from the original on 23 November 2016. Retrieved 23 November 2016.

- CNA (12 January 2019). "Commentary: Bad news. Artificial intelligence is biased". CNA. Archived from the original on 12 January 2019. Retrieved 19 June 2020.

- Cybenko, G. (1988). Continuous valued neural networks with two hidden layers are sufficient (Report). Department of Computer Science, Tufts University.

- Deng, L.; Yu, D. (2014). "Deep Learning: Methods and Applications" (PDF). Foundations and Trends in Signal Processing. 7 (3–4): 1–199. doi:10.1561/2000000039. Archived (PDF) from the original on 14 March 2016. Retrieved 18 October 2014.

- Dennett, Daniel (1991). Consciousness Explained. The Penguin Press. ISBN 978-0-7139-9037-9.

- DiFeliciantonio, Chase (3 April 2023). "AI has already changed the world. This report shows how". San Francisco Chronicle. Archived from the original on 19 June 2023. Retrieved 19 June 2023.

- Dickson, Ben (2 May 2022). "Machine learning: What is the transformer architecture?". TechTalks. Retrieved 22 November 2023.

- Dockrill, Peter (27 June 2022), "Robots With Flawed AI Make Sexist And Racist Decisions, Experiment Shows", Science Alert, archived from the original on 27 June 2022

- Domingos, Pedro (2015). The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World. Basic Books. ISBN 978-0465065707.

- Dreyfus, Hubert (1972). What Computers Can't Do. New York: MIT Press. ISBN 978-0-06-011082-6.

- Dreyfus, Hubert; Dreyfus, Stuart (1986). Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer. Oxford: Blackwell. ISBN 978-0-02-908060-3. Archived from the original on 26 July 2020. Retrieved 22 August 2020.

- Dyson, George (1998). Darwin among the Machines. Allan Lane Science. ISBN 978-0-7382-0030-9. Archived from the original on 26 July 2020. Retrieved 22 August 2020.

- Edelson, Edward (1991). The Nervous System. New York: Chelsea House. ISBN 978-0-7910-0464-7. Archived from the original on 26 July 2020. Retrieved 18 November 2019.

- Edwards, Benj (17 May 2023). "Poll: AI poses risk to humanity, according to majority of Americans". Ars Technica. Archived from the original on 19 June 2023. Retrieved 19 June 2023.

- Evans, Woody (2015). "Posthuman Rights: Dimensions of Transhuman Worlds". Teknokultura. 12 (2). doi:10.5209/rev_TK.2015.v12.n2.49072.

- Fearn, Nicholas (2007). The Latest Answers to the Oldest Questions: A Philosophical Adventure with the World's Greatest Thinkers. New York: Grove Press. ISBN 978-0-8021-1839-4.

- Ford, Martin; Colvin, Geoff (6 September 2015). "Will robots create more jobs than they destroy?". The Guardian. Archived from the original on 16 June 2018. Retrieved 13 January 2018.

- Fox News (2023). "Fox News Poll" (PDF). Fox News. Archived (PDF) from the original on 12 May 2023. Retrieved 19 June 2023.

- Frank, Michael (22 September 2023). "US Leadership in Artificial Intelligence Can Shape the 21st Century Global Order". The Diplomat. Retrieved 8 December 2023.

Instead, the United States has developed a new area of dominance that the rest of the world views with a mixture of awe, envy, and resentment: artificial intelligence... From AI models and research to cloud computing and venture capital, U.S. companies, universities, and research labs – and their affiliates in allied countries – appear to have an enormous lead in both developing cutting-edge AI and commercializing it. The value of U.S. venture capital investments in AI start-ups exceeds that of the rest of the world combined.

- Frey, Carl Benedikt; Osborne, Michael A (1 January 2017). "The future of employment: How susceptible are jobs to computerisation?". Technological Forecasting and Social Change. 114: 254–280. CiteSeerX 10.1.1.395.416. doi:10.1016/j.techfore.2016.08.019. ISSN 0040-1625.

- "From not working to neural networking". The Economist. 2016. Archived from the original on 31 December 2016. Retrieved 26 April 2018.

- Galvan, Jill (1 January 1997). "Entering the Posthuman Collective in Philip K. Dick's "Do Androids Dream of Electric Sheep?"". Science Fiction Studies. 24 (3): 413–429. JSTOR 4240644.

- Geist, Edward Moore (9 August 2015). "Is artificial intelligence really an existential threat to humanity?". Bulletin of the Atomic Scientists. Archived from the original on 30 October 2015. Retrieved 30 October 2015.

- Gertner, Jon (18 July 2023). "Wikipedia's Moment of Truth – Can the online encyclopedia help teach A.I. chatbots to get their facts right — without destroying itself in the process? + comment". The New York Times. Archived from the original on 18 July 2023. Retrieved 19 July 2023.