튜링 테스트

Turing test

| 시리즈의 일부(on) |

| 인공지능 |

|---|

|

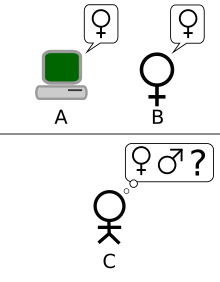

원래 [2]1950년 앨런 튜링에 의해 모방 게임이라고 불렸던 튜링 테스트는 인간과 동일하거나 구별할 수 없는 지능적인 행동을 보여주는 기계의 능력을 시험하는 것입니다.튜링은 인간 평가자가 인간과 인간과 같은 반응을 생성하도록 설계된 기계 사이의 자연어 대화를 판단할 것을 제안했습니다.평가자는 대화 중인 두 파트너 중 한 명이 기계라는 것을 알고 모든 참가자가 서로 분리되어 있다는 것을 알 것입니다.대화는 컴퓨터 키보드 및 화면과 같은 텍스트 전용 채널로 제한되므로 결과는 단어를 [3]음성으로 표현하는 기계의 능력에 의존하지 않습니다.평가자가 기계와 사람을 확실하게 구분할 수 없다면 기계는 시험을 통과한 것으로 간주됩니다.테스트 결과는 기계가 질문에 정확한 답변을 하는 능력에 의존하지 않으며, 사람이 얼마나 답변을 하는 것과 유사한지에만 의존합니다.튜링 테스트는 수행 능력의 구별 불가능성에 대한 테스트이기 때문에 언어 버전은 비언어적(로봇적)[4] 뿐만 아니라 언어적(로봇적)인 모든 인간 수행 능력으로 자연스럽게 일반화됩니다.

이 테스트는 튜링이 맨체스터 [5]대학에서 일하면서 1950년에 발표한 논문 "컴퓨터 기계와 지능"에서 소개되었습니다.그것은 "저는 '기계가 생각할 수 있는가?'라는 질문을 고려해 볼 것을 제안합니다"라는 말로 시작합니다. "생각하는 것"은 정의하기 어렵기 때문에, 튜링은 "질문을 그것과 밀접하게 관련되어 있고 비교적 모호하지 않은 [6]단어로 표현되는 다른 것으로 대체"하기로 선택합니다.튜링은 문제의 새로운 형태를 "이미테이션 게임"이라고 부르는 3인용 게임으로 설명하는데, 두 플레이어의 정확한 성별을 알아내기 위해 심문관이 다른 방에 있는 남녀에게 질문을 하는 것입니다.튜링의 새로운 질문은 "모방 게임에서 잘 할 수 있는 상상할 수 있는 디지털 컴퓨터가 있는가?"[2] 입니다.튜링은 이 질문이 실제로 대답할 수 있는 질문이라고 믿었습니다.논문의 나머지 부분에서, 그는 "기계는 [7]생각할 수 있다"는 명제에 대한 모든 주요 반대에 반대했습니다.

튜링이 그의 테스트를 도입한 이후, 그것은 큰 영향력과 광범위한 비판을 받았고, 인공지능의 [8][9][10]철학에서 중요한 개념이 되었습니다.존 설의 중국어 방과 같은 일부 비판은 그 자체로 논란이 되고 있습니다.

역사

철학적 배경

기계가 생각하는 것이 가능한가의 문제는 오랜 역사를 가지고 있으며, 이는 이원론적인 마음관과 유물론적인 마음관의 구별에 확고하게 자리잡고 있습니다.르네 데카르트는 1637년 그의 방법론에서 튜링 테스트의 측면을 다음과 같이 기술합니다.

[H]얼마나 많은 다른 자동차나 이동 기계들이 인간의 산업에 의해서 만들어 질 수 있는지...왜냐하면 우리는 기계가 말을 할 수 있도록 구성되어 있다는 것을 쉽게 이해할 수 있고, 심지어 신체적인 종류의 행동에 대해 어떤 반응을 나타낼 수도 있기 때문인데, 이는 기계의 장기에 변화를 초래합니다. 예를 들어, 어떤 부분을 만지면 우리가 기계에게 무엇을 말하고 싶은지 물어볼 수 있고, 다른 부분에서 그것이 상처를 받고 있다고 소리칠 수도 있습니다.그러나 가장 낮은 부류의 사람도 [11]할 수 있는 것처럼, 자기 앞에서 말할 수 있는 모든 것에 적절하게 대답하기 위해, 자기의 말을 다양한 방식으로 배열하는 일은 결코 일어나지 않습니다.

여기서 데카르트는 오토마타가 인간의 상호작용에 반응할 수 있다는 점에 주목하지만, 그러한 오토마타는 어떤 인간도 할 수 있는 방식으로 그들의 존재 속에서 말한 것들에 적절하게 반응할 수 없다고 주장합니다.따라서 데카르트는 적절한 언어적 반응의 불충분함을 인간과 오토마톤을 구분하는 것으로 정의함으로써 튜링 테스트를 사전에 정의합니다.데카르트는 미래의 오토마타가 그러한 불충분함을 극복할 수 있는 가능성을 고려하지 못하고, 튜링 테스트의 개념적 틀과 기준을 미리 구성하더라도 튜링 테스트를 제안하지 않습니다.

데니스 디드로(Denis Diderot)는 1746년 저서 펜세 철학에서 튜링-테스트 기준을 공식화했는데, 중요한 암묵적 한계 가정은 유지되고 있지만, 참여자들은 창조된 인공물을 고려하는 것이 아니라 자연적인 생명체라는 것입니다.

만약 그들이 모든 것에 대답할 수 있는 앵무새를 찾아낸다면, 저는 망설임 없이 그것을 지적인 존재라고 주장할 것입니다.

이것은 그가 이것에 동의한다는 것을 의미하는 것이 아니라, 그것은 이미 그 당시에 유물론자들의 일반적인 주장이었다는 것입니다.

이원론에 따르면, 마음은 비물리적(또는 적어도 비물리적 [12]특성을 가지고 있음)이기 때문에, 순수하게 물리적인 용어로 설명될 수 없습니다.물질주의에 따르면, 마음은 물리적으로 설명될 수 있고,[13] 이것은 인공적으로 생산되는 마음의 가능성을 열어 둡니다.

1936년, 철학자 알프레드 에이어는 다른 사람들이 우리와 같은 의식적인 경험을 가지고 있다는 것을 어떻게 알 수 있는지에 대한 다른 마음의 표준 철학적 질문을 생각했습니다.에이어는 그의 책, 언어, 진리 그리고 논리에서 의식적인 인간과 무의식적인 기계를 구별하기 위한 프로토콜을 제안했습니다: "의식적으로 보이는 물체는 사실 의식적인 존재가 아니라 단지 더미나 기계라고 주장할 수 있는 유일한 근거는 그것이 그것이 경험적인 시험들 중 하나를 만족시키지 못한다는 것입니다.의식의 유무가 [14]결정됩니다." (이 제안은 튜링 테스트와 매우 유사하지만, 에이어의 대중적인 철학 고전이 튜링에게 친숙했는지는 확실하지 않습니다.)즉, 어떤 것이 의식 테스트에 실패하면 의식이 없는 것입니다.

문화적 배경

인간이 컴퓨터나 외계인이 지능이 있는지를 판단하는 시험은 1940년대까지 공상과학 분야에서 확립된 관습이었고, 튜링도 [15]이를 알고 있었을 가능성이 높습니다.스탠리 G. Weinbaum의 "A Martian Odyssey"(1934)는 그러한 테스트가 얼마나 [15]미묘할 수 있는지 보여주는 예를 제공합니다.

기계나 오토마톤이 인간으로서 통과하려고 시도한 초기의 예로는 아프로디테에 의해 애니메이션화된 여성의 조각을 창조하는 고대 그리스 신화 피그말리온, 진짜 소년이 되고 싶어하는 꼭두각시에 대한 카를로 콜로디의 소설 피노키오의 모험, 그리고 E가 있습니다. 주인공이 오토마톤과 사랑에 빠지는 T. A. 호프만의 1816년 이야기 '샌드맨'이 모든 예에서, 사람들은 인공적인 존재들에 속아 넘어갑니다 - 어느 정도까지는 -[16] 인간으로 넘어갑니다.

앨런 튜링 앤 더 모조 게임

영국의 [17]연구자들은 1956년 인공지능(AI) 연구 분야가 설립되기 전까지 최대 10년 동안 "기계 지능"을 탐구해 왔습니다.이것은 앨런 튜링([18]Alan Turing)을 포함한 영국의 사이버네틱스 및 전자 연구자들의 비공식 모임인 Ratio Club의 회원들 사이에서 공통적인 주제였습니다.

특히 튜링은 적어도[19] 1941년부터 기계 지능이라는 개념을 실행해 왔으며 1947년에 "[20]컴퓨터 지능"에 대한 언급이 가장 일찍 알려진 것 중 하나였습니다.튜링의 보고서 "지능형 기계"[21]에서 그는 "기계가 지능적인 [22]행동을 보이는 것이 가능한지 여부"에 대해 조사했고, 그 조사의 일부로 그의 이후 시험의 선구자로 간주될 수 있는 것을 제안했습니다.

그다지 나쁘지 않은 [23]체스 게임을 할 수 있는 종이 기계를 고안하는 것은 어렵지 않습니다.이제 실험의 실험 대상으로 A, B, C 세 명의 남자를 잡으세요.A와 C는 체스를 잘 못 두는 편이고, B는 종이 기계를 작동시키는 조작자입니다.두 개의 방은 서로의 움직임을 소통하기 위한 배치로 사용되며, C와 A 또는 종이 기계 사이에서 게임이 진행됩니다.C는 자신이 어떤 플레이를 [24]하고 있는지 구분하기가 상당히 어려울 수 있습니다.

"컴퓨터 기계와 지능"(1950)은 튜링이 기계 지능에만 초점을 맞춘 최초의 논문입니다.튜링은 1950년 논문에서 "저는 '기계가 생각할 수 있는가?'라는 질문을 고려할 것을 제안합니다.'"그가 강조하듯이, 그러한 질문에 대한 전통적인 접근 방식은 "기계"와 "생각"이라는 용어를 모두 정의하면서 정의부터 시작하는 것입니다[6].튜링은 그렇게 하지 않기로 선택합니다. 대신에 그는 질문을 "그것과 밀접하게 관련되어 있고 상대적으로 모호하지 [6]않은 단어로 표현되는" 새로운 질문으로 대체합니다.본질적으로 그는 질문을 "기계가 생각할 수 있는가?"에서 "우리가 생각하는 실체로서 할 수 있는 것을 기계가 할 수 있는가?"[25]로 바꾸자고 제안합니다.튜링은 이 새로운 질문의 장점은 이 [26]질문이 "인간의 신체적 능력과 지적 능력 사이에 상당히 분명한 선을 긋는다"는 것이라고 주장합니다.

이 접근법을 증명하기 위해 튜링은 "이미테이션 게임"으로 알려진 파티 게임에서 영감을 받은 테스트를 제안합니다. 남자와 여자가 각자의 방에 들어가고 손님들은 일련의 질문을 작성하고 다시 보내진 타자기로 된 답을 읽음으로써 그들을 구분하려고 노력합니다.이 게임에서, 남자와 여자는 모두 손님들에게 자신들이 다른 사람이라는 것을 확신시키는 것을 목표로 합니다. (휴마 샤는 이 두 인간 버전의 게임이 튜링에 의해 단지 독자에게 기계-인간 질문-응답 테스트를 소개하기 위해 제시된 것이라고 주장합니다.)[27]튜링은 새로운 버전의 게임을 다음과 같이 설명했습니다.

이제 우리는 "기계가 이 게임에서 A의 역할을 맡으면 어떻게 될까?"라는 질문을 던집니다.남녀 간에 게임이 진행될 때처럼 이렇게 게임이 진행될 때 심문관이 자주 잘못된 판단을 내릴까요?이러한 질문들은 우리의 원래의 "기계는 생각할 수 있습니까?"[26]를 대체합니다.

논문 후반부에 튜링은 판사가 컴퓨터와 [28]사람과만 대화하는 "동등한" 대체 공식을 제안합니다.이 두 가지 공식 모두 오늘날 더 일반적으로 알려진 튜링 테스트의 버전과 정확히 일치하지는 않지만, 그는 1952년에 세 번째 공식을 제안했습니다.튜링이 BBC 라디오 방송에서 논의한 이 버전에서 배심원들은 컴퓨터에 대한 질문을 던지는데, 컴퓨터의 역할은 배심원들의 상당 부분이 그것이 정말 [29]남자라고 믿게 만드는 것입니다.

튜링의 논문은 9가지 반론을 고려했는데, 여기에는 논문이 발표된 이후 수년간 제기된 인공지능에 대한 주요 주장 중 일부가 포함되어 있습니다("컴퓨터 기계와 지능"[7] 참조).

엘리자 앤 패리

1966년 조셉 바이젠바움은 튜링 테스트를 통과한 것으로 보이는 프로그램을 만들었습니다.엘리자라고 알려진 그 프로그램은 키워드에 대한 사용자의 입력된 코멘트를 조사함으로써 작동했습니다.키워드가 발견되면 사용자의 코멘트를 변환하는 규칙이 적용되고 결과 문장이 반환됩니다.키워드를 찾을 수 없는 경우, ELIZA는 일반 리포스테 또는 이전 설명 [30]중 하나를 반복하여 응답합니다.게다가, Weizenbaum은 ELIZA가 로저 심리치료사의 행동을 복제하도록 개발하여 ELIZA가 "현실 [31]세계에 대해 거의 아무것도 모르는 자세를 자유롭게 취할 수 있도록" 했습니다.이러한 기술들로, 바이젠바움의 프로그램은 어떤 사람들이 그들이 실제 사람과 이야기하고 있다고 믿게 만들 수 있었고, 어떤 피실험자들은 "엘리자가 [31]인간이 아니라는 것을 확신시키기 매우 어렵습니다".따라서 일부에서는 ELIZA가 튜링 [31][32]테스트를 통과할 수 있는 프로그램(아마도 최초) 중 하나라고 주장하지만, 이 견해는 논쟁의 여지가 매우 큽니다(아래의 질문자들의 나베테 참조).

Kenneth Colby는 1972년에 [33]"태도가 있는 ELIZA"로 묘사되는 프로그램인 PARRY를 만들었습니다.그것은 바이젠바움이 사용하는 것과 유사한 (더 발전된 경우) 접근법을 사용하여 편집성 정신 분열증 환자의 행동을 모델링하려고 시도했습니다.작업을 검증하기 위해 1970년대 초에 튜링 테스트의 변형을 사용하여 PARRY를 테스트했습니다.경험이 풍부한 정신과 의사 그룹은 텔레프린터를 통해 실제 환자와 패리를 실행하는 컴퓨터의 조합을 분석했습니다.33명의 정신과 의사들로 구성된 또 다른 그룹은 대화의 녹취록을 보여주었습니다.그런 다음 두 그룹은 어떤 "환자"가 인간이고 어떤 [34]것이 컴퓨터 프로그램인지를 확인하도록 요청 받았습니다.정신과 의사들은 정확한 신원 확인을 할 수 있는 경우가 52%에 불과했는데, 이는 무작위 [34]추측과 일치하는 수치입니다.

21세기에도, 이러한 프로그램들의 버전(현재 "챗봇"으로 알려진)은 계속해서 사람들을 속이고 있습니다.악성 프로그램인 "사이버 애호가"는 인터넷 사용자들에게 "자신의 신원에 대한 정보를 밝히거나 악성 콘텐츠를 컴퓨터에 [35]전달할 웹사이트를 방문하도록 유도하라"고 설득함으로써 그들을 먹이로 삼고 있습니다.이 프로그램은 "개인 [36]정보를 수집하기 위해 온라인에서 관계를 찾는" 사람들에게 추파를 던지는 "발렌타인 위험"으로 나타났습니다.

중국방

John Searle의 1980년 논문 Minds, Brains, and Programs는 "Chinese room" 사고 실험을 제안했고 튜링 테스트는 기계가 생각할 수 있는지를 결정하는 데 사용될 수 없다고 주장했습니다.설은 소프트웨어(ELIZA와 같은)가 이해하지 못한 기호를 조작하는 것만으로 튜링 테스트를 통과할 수 있다고 언급했습니다.이해가 없다면, 그들은 사람들이 했던 것과 같은 의미로 "생각하는" 것으로 묘사될 수 없습니다.따라서 설은 튜링 테스트가 기계가 [37]생각할 수 있다는 것을 증명할 수 없다고 결론 내렸습니다.튜링 테스트 자체와 마찬가지로, 설의 주장은 널리[38] 비판을 받았고 [39]지지를 받았습니다.

마음의 철학을 연구하는 설과 다른 사람들과 같은 주장들은 1980년대와 [40]1990년대까지 계속된 지능의 본질, 의식적인 마음을 가진 기계의 가능성, 튜링 테스트의 가치에 대한 더 치열한 논쟁을 촉발시켰습니다.

뢰브너상

뢰브너 상(Loebner Prize)은 1991년 [41]11월에 개최된 제1회 대회와 함께 실용적인 튜링 테스트를 위한 연간 플랫폼을 제공합니다.그것은 휴 뢰브너에 의해 쓰여졌습니다.미국 메사추세츠 주에 있는 캠브리지 행동 연구 센터는 2003년 대회까지 그리고 그 대회를 포함하여 상들을 조직했습니다.뢰브너가 묘사한 바와 같이, 이 대회가 만들어진 한 가지 이유는 적어도 부분적으로는 인공지능 연구의 상태를 발전시키기 위한 것인데, 이는 튜링 테스트를 [42]40년 동안 논의했음에도 불구하고 아무도 실행하기 위한 조치를 취하지 않았기 때문입니다.

1991년 제1회 뢰브너상 대회는 대중[43] 언론과 [44]학계에서 튜링 테스트의 실행 가능성과 추구의 가치에 대한 새로운 논의를 이끌어냈습니다.첫 번째 대회는 식별할 수 있는 지능이 없는 무분별한 프로그램으로 우승했는데, 이 프로그램은 순진한 심문관들을 속여서 잘못된 식별을 하게 했습니다.이것은 튜링 테스트의 몇 가지 단점을 강조했습니다(아래에서 설명됨).우승자는 최소한 부분적으로, 그것이 "인간의 타자 [43]오류를 모방"할 수 있었기 때문에 우승했습니다. 세련되지 않은 질문자들은 쉽게 [44]속았습니다. 그리고 인공지능의 일부 연구자들은 그 시험이 단지 더 효과적인 [45]연구에 대한 방해물이라고 느끼도록 유도되었습니다.

은상(텍스트 전용)과 금상(오디오 및 비주얼)은 수상한 적이 없습니다.하지만, 이 대회는 심사위원들의 의견에 따라 그 해의 출품작 중 "가장 인간적인" 대화 행동을 보여주는 컴퓨터 시스템에 대해 매년 동메달을 수여해 왔습니다.A.L.I.C.E(Artificial Languistic Internet Computer Entity)는 최근 세 차례(2000, 2001, 2004) 동상을 수상했습니다.학습 AI Jabberwacky는 2005년과 2006년에 우승했습니다.

뢰브너 상은 대화 지능을 테스트합니다. 수상자는 일반적으로 채터봇 프로그램 또는 ACE(Artificial Conversational Entities)입니다.초기 뢰브너 상은 대화를 제한했습니다.각 항목과 숨겨진-인간은 하나의 [46]주제에 대해 대화를 나눴기 때문에 질문자들은 개체 상호작용당 한 줄의 질문으로 제한되었습니다.대화 제한 규정은 1995년 뢰브너 상을 위해 해제되었습니다.뢰브너 상에서 심사위원과 단체 간의 상호작용 기간은 다양했습니다.2003년 서리 대학의 뢰브너(Loebner)에서 각 심문관은 개체, 기계 또는 숨겨진 인간과 5분 동안 상호작용할 수 있었습니다.2004년과 2007년 사이에 뢰브너 상에서 허용된 상호작용 시간은 20분 이상이었습니다.

구글 LaMDA 챗봇

2022년 6월 Google LaMDA(Language Model for Dialog Applications) 챗봇은 감성을 달성했다는 주장에 대해 광범위한 보도를 받았습니다.처음에 이코노미스트 구글 리서치 펠로우 블레즈 아귀에라이 아르카스의 기사에서 챗봇은 사회적 [47]관계에 대한 이해의 정도를 보여주었다고 말했습니다.며칠 후, 구글 엔지니어 블레이크 르모인은 워싱턴 포스트와의 인터뷰에서 LaMDA가 지각을 달성했다고 주장했습니다.이러한 취지의 내부 주장으로 인해 구글은 르모인을 휴직시켰습니다.아구에라이 아르카스(구글 부사장)와 젠 겐나이(책임혁신 책임자)는 이 같은 주장을 조사했지만 기각했습니다.[48]이 분야의 다른 전문가들은 인간의 대화를 모방하는 것처럼 보이는 언어 모델이 튜링 테스트를 통과한 것처럼 보였음에도 불구하고 [49]그 뒤에 어떤 지능이 존재한다는 것을 나타내지 않는다고 지적하며, 르모인의 주장을 지적했습니다.LaMDA가 감성에 도달했다는 주장에 대한 지지자들의 광범위한 논의는 감성의 의미뿐만 아니라 인간으로서의 의미를 정의하는 것을 포함하는 소셜 미디어 플랫폼 전반에 걸친 논의를 촉발시켰습니다.

버전

Saul Traiger는 튜링 테스트에는 적어도 세 가지 주요 버전이 있다고 주장합니다. 그 중 두 가지 버전은 "컴퓨팅 기계와 지능"에 제공되고 한 가지 버전은 "표준 해석"[50]이라고 설명합니다."표준 해석"이 튜링에 의해 기술된 것인지 아니면 그의 논문을 잘못 읽은 것에 기초한 것인지에 대해 약간의 논쟁이 있지만, 이 세 가지 버전은 동등한 [50]것으로 간주되지 않으며, 그들의 장단점은 [51]구별됩니다.

튜링의 원래 기사는 세 명의 플레이어가 참여하는 간단한 파티 게임을 설명합니다.A 선수는 남자, B 선수는 여자, C 선수(심문관 역할)는 남녀 중 한 명입니다.모방 게임에서 C 플레이어는 A 플레이어와 B 플레이어 중 어느 쪽도 볼 수 없고, 오직 필기 노트를 통해서만 이들과 소통할 수 있습니다.C 선수는 A 선수와 B 선수에게 질문을 함으로써 둘 중 누가 남자이고 누가 여자인지를 판단하려고 합니다.A 플레이어의 역할은 질문자를 속여서 잘못된 결정을 내리는 반면, B 플레이어는 질문자를 도와 올바른 [8]결정을 내리려고 합니다.

튜링은 다음과 같이 묻습니다.

"이 게임에서 기계가 A의 역할을 맡으면 어떻게 될까요?남녀 간에 경기가 있을 때처럼 이렇게 경기가 있을 때 심문관이 잘못 판단할 것인가?"이러한 질문들은 우리의 원래의 "기계는 생각할 수 있습니까?"[26]를 대체합니다.

두 번째 버전은 튜링의 1950년 논문에 나중에 등장했습니다.A 선수의 역할은 오리지널 모조 게임 테스트와 마찬가지로 컴퓨터가 수행합니다.하지만 B 선수의 역할은 여자보다는 남자가 맡습니다.

특정한 디지털 컴퓨터 C에 우리의 관심을 고정시켜 보겠습니다.이 컴퓨터가 적절한 저장공간을 갖도록 수정하여 동작속도를 적절히 높이고 적절한 프로그램을 제공함으로써 C가 모방게임에서 A의 역할을 만족스럽게 할 수 있다는 것이 사실입니까?[26]

이 버전에서는 A 플레이어(컴퓨터)와 B 플레이어 모두 질문자를 속여서 잘못된 결정을 내리려고 합니다.

표준적인 해석은 원래 논문에 포함되어 있지 않지만, 받아들여지고 논의되고 있습니다.튜링 테스트의 목적은 컴퓨터가 심문자를 속여서 사람이라고 믿게 할 수 있는지 여부를 결정하는 것이 아니라, 컴퓨터가 [8]사람을 모방할 수 있는지 여부를 결정하는 것이라는 것이 일반적인 이해입니다.이 해석이 튜링에 의해 의도된 것인지에 대해서는 약간의 논쟁이 있지만, 스테렛은 그것이[52] 두 번째 버전과 이 버전을 혼동한다고 믿지만, 반면에 트라이거와 같은 다른 것들은 그렇지[50] 않습니다. 그럼에도 불구하고 이것은 "표준 해석"으로 볼 수 있는 것으로 이어졌습니다.이 버전에서 A 플레이어는 컴퓨터이고 B 플레이어는 둘 중 하나의 성별을 가진 사람입니다.심문관의 역할은 어떤 사람이 수컷이고 어떤 사람이 암컷인지를 결정하는 것이 아니라, 어떤 사람이 컴퓨터이고 [53]어떤 사람인지를 결정하는 것입니다.표준 해석의 근본적인 문제는 질문자가 어떤 응답자가 인간이고 어떤 응답자가 기계인지 구별할 수 없다는 것입니다.지속 기간에 대한 문제가 있지만, 일반적으로 표준 해석은 이 한계를 합리적이어야 할 것으로 간주합니다.

해석

튜링이 [52]의도한 테스트의 대체 공식 중 어느 것에 대한 논란이 발생했습니다.스테렛은 그의 1950년 논문에서 두 가지의 구별된 테스트를 추출할 수 있으며 튜링의 말에 따라 그것들은 동등하지 않다고 주장합니다.파티게임을 이용하여 성공빈도를 비교하는 테스트를 '오리지널 모방게임 테스트'라 하고, 인간판사가 인간과 기계와 대화하는 테스트를 '스탠다드 튜링 테스트'라 하고,스테렛은 이것을 모방 게임의 두 번째 버전이 아닌 "표준 해석"과 동일시한다고 언급했습니다.스테렛은 표준 튜링 테스트(STT)가 비평가들이 인용하는 문제점을 가지고 있다는 것에 동의하지만, 대조적으로 이렇게 정의된 원래의 모방 게임 테스트(OIG 테스트)는 결정적인 차이로 인해 대부분의 테스트에 영향을 받지 않는다고 느낍니다.STT와 달리 기계 지능에 대한 기준을 설정하는 데 있어 인간 성능을 사용하더라도 인간 성능과의 유사성을 기준으로 삼지 않습니다.사람은 OIG 테스트에 실패할 수 있지만 실패가 지략이 부족하다는 것을 나타내는 것은 지능 테스트의 미덕이라고 주장합니다.OIG 테스트는 단순히 "인간 대화 행동의 시뮬레이션"이 아니라 지능과 관련된 지략을 요구합니다.OIG 테스트의 일반적인 구조는 비언어 모방 게임에도 [54]사용될 수 있습니다.

Huma Shah에 따르면, 튜링 자신은 기계가 생각할 수 있는지에 대해 관심이 있었고, 이것을 검토할 수 있는 간단한 방법을 제공하고 있었습니다: 인간-기계 질의응답 [55]시간을 통해서 말입니다.샤는 튜링이 묘사한 모방 게임이 두 가지 다른 방식으로 실용화될 수 있다고 주장합니다: a) 일대일 심문관-기계 테스트, b) 심문관이 [27]병렬로 질문한 기계와 인간의 동시 비교.

다른 작가들은[56] 튜링이 모방 게임의 당사자 버전을 사용하여 제안한 테스트가 그 모방 게임에서의 성공의 비교 빈도 기준에 기초한다는 튜링의 진술을 어떻게 고려할 것인지를 명시하지 않은 채, 모방 게임 그 자체가 테스트라고 제안한 것으로 해석했습니다.한 판에 성공할 수 있는 능력보다는 말입니다.

일부 작가들은 모방 게임이 사회적 측면에서 가장 잘 이해된다고 주장합니다.그의 1948년 논문에서 튜링은 지능을 "감정적 개념"으로 언급하고 다음과 같이 언급합니다.

우리가 어떤 것을 지능적인 방식으로 행동하는 것으로 간주하는 정도는 고려 대상의 속성에 따라 결정되는 것만큼 우리 자신의 정신 상태와 훈련에 의해 결정됩니다.만약 우리가 그것의 행동을 설명하고 예측할 수 있거나 근본적인 계획이 거의 없는 것처럼 보인다면, 우리는 지능을 상상할 유혹이 거의 없습니다.그러므로 같은 대상이라면, 한 사람은 그것을 똑똑하다고 생각하고 다른 사람은 그렇게 생각하지 않을 가능성이 있습니다. 두 번째 사람은 그것의 [57]행동 규칙을 알게 되었을 것입니다.

이 발언과 튜링의 출판물들에 흩어져 있는 유사한 것들에 이어, 다이앤[58] 프라우드풋은 튜링이 지능에 대한 반응 의존적 접근법을 가지고 있었고, 그에 따르면 지능(또는 사고)의 실체는 평균적인 심문자에게 지능적으로 보이는 것이라고 주장합니다.Bernardo[59] Gonçalves는 튜링이 그의 실험이 인간으로 하여금 기계가 지능적인 실체로 여겨져야 한다는 것을 깨닫게 하는 사고 실험이 될 의도였다고 주장합니다.Shlomo Danziger는[60] 두 줄을 모두 차지하며, Turing이 모방 게임을 지능 테스트가 아니라 기술적인 열망으로 본 사회 기술적인 해석을 촉진합니다 - 기계에 대한 사회의 태도 변화를 포함할 가능성이 있는 것입니다.이 책에 따르면, 튜링의 50년 기념 예측은 - 20세기 말에 그의 시험이 어떤 기계에 의해 통과될 것이라는 - 사실은 두 가지 구별할 수 있는 예측으로 구성되어 있습니다.첫 번째는 기술적 예측입니다.

50년 후쯤이면 컴퓨터가 모방 게임을 잘 하도록 프로그램을 만들 수 있을 것이라고 생각합니다 그래서 보통의 심문관은 5분간의 심문 [61]후에 정확한 신원확인을 할 확률이 70%를 넘지 않을 것입니다

튜링이 하는 두 번째 예측은 사회학적 예측입니다.

세기말에 단어 사용과 일반적인 교육을 받은 의견이 너무 많이 바뀌어서 사람들이 [61]기계적인 사고에 대해 모순을 예상하지 않고 말할 수 있을 것이라고 생각합니다.

Danziger는 Turing에게 기계에 대한 사회의 태도 변화가 지능형 기계의 존재를 위한 필수조건이라고 주장합니다.지능형 기계라는 용어가 더 이상 지능형 기계의 존재에 대한 모순어로 보이지 않을 때만이 논리적으로 가능해질 것입니다.

Saygin은 오리지널 게임이 [62]컴퓨터의 참여를 숨기고 있기 때문에 덜 편향된 실험 디자인을 제안하는 방법일 수도 있다고 제안했습니다.모방 게임은 또한 표준 해석에서 찾을 수 없는 "소셜 해킹"을 포함하고 있는데, 이 게임에서는 컴퓨터와 남성 인간 모두 자신이 [63]아닌 사람인 것처럼 가장해서 게임을 하도록 되어 있습니다.

심문관이 컴퓨터에 대해 알아야 합니까?

실험실 테스트의 중요한 부분은 제어장치가 있어야 한다는 것입니다.튜링은 자신의 시험에서 심문관이 참가자 중 한 명이 컴퓨터라는 것을 인지하고 있는지 여부를 절대 명확하게 밝히지 않습니다.그는 A 선수를 기계로 교체해야 한다고만 말하고,[26] C 선수를 교체해야 한다는 것은 언급하지 않습니다.콜비, FD 힐프, S 웨버, AD 크레이머가 PARRY를 테스트했을 때, 그들은 심문자들이 심문 [64]중에 인터뷰를 하고 있는 사람들 중 하나 이상이 컴퓨터라는 것을 알 필요가 없다고 가정함으로써 그렇게 했습니다.Ayse Saygin, Peter Swirski,[65] 그리고 다른 사람들이 강조했듯이,[8] 이것은 테스트의 실행과 결과에 큰 차이를 만듭니다.1994년에서 1999년 사이에 뢰브너의 AI 공모전 일대일상의 녹취록을 사용한 그리스 격언 위반을 살펴본 실험적 연구에서, Ayse Saygin은 컴퓨터가 [66]관련된 것을 알고 있었던 참가자들과 알지 못했던 참가자들의 반응 사이에 상당한 차이가 있음을 발견했습니다.

힘

추적성 및 단순성

튜링 테스트의 힘과 매력은 단순함에서 비롯됩니다.마음의 철학, 심리학, 그리고 현대 신경과학은 기계에 적용하기에 충분히 정확하고 일반적인 "지능"과 "사고"의 정의를 제공할 수 없었습니다.그런 정의가 없으면 인공지능 철학의 중심 질문에 답할 수 없습니다.튜링 테스트는 불완전하더라도 적어도 실제로 측정할 수 있는 것을 제공합니다.그런 만큼 어려운 철학적 질문에 답하려는 실용적 시도입니다.

주제의 폭

시험의 형식을 통해 질문자는 기계에 다양한 지적 작업을 제공할 수 있습니다.튜링은 "질문과 답변 방법은 우리가 [67]포함하기를 원하는 인간의 노력 분야 중 거의 모든 것을 소개하는데 적합한 것 같습니다"라고 썼습니다.John Haugeland는 "단어를 이해하는 것만으로는 충분하지 않습니다. 여러분도 [68]그 주제를 이해해야 합니다."라고 덧붙였습니다.

잘 설계된 튜링 테스트를 통과하기 위해서 기계는 자연어를 사용하고, 이성을 갖고, 지식을 갖고, 학습해야 합니다.테스트는 비디오 입력뿐만 아니라 물체가 통과할 수 있는 "해치"를 포함하도록 확장될 수 있습니다. 이렇게 하면 기계가 잘 설계된 비전과 로봇 공학의 숙련된 사용법을 입증할 수 있습니다.이것들은 함께 인공지능 연구가 [69]해결하고자 하는 거의 모든 주요 문제들을 나타냅니다.

파이겐바움 테스트는 튜링 테스트에서 사용할 수 있는 광범위한 주제를 활용하도록 설계되었습니다.그것은 문학이나 화학과 같은 특정 분야의 전문가들의 능력과 기계를 비교하는 튜링의 질문-응답 게임의 제한된 형태입니다.IBM의 왓슨 기계는 인간 지식의 인간 대 기계 텔레비전 퀴즈 쇼인 [70][55][relevant to this paragraph? ]Jeopardy에서 성공을 거두었습니다.

감성적이고 심미적인 지능을 강조합니다.

캠브리지의 수학 명예 졸업생으로서, 튜링은 어떤 고도의 기술 분야에서 전문적인 지식을 요구하는 컴퓨터 지능의 시험을 제안할 것으로 기대되었을 수 있고, 따라서 그 주제에 대한 더 최근의 접근법을 기대할 수 있을 것입니다.그 대신에, 이미 언급했듯이, 1950년 신학교 논문에서 설명한 테스트는 컴퓨터가 일반적인 파티 게임에서 성공적으로 경쟁할 수 있어야 하며, 이것은 여성 참가자인 척 설득력 있게 하기 위해 일련의 질문에 대답하는 전형적인 남성과 같이 잘 수행함으로써 요구됩니다.

인간의 성적 이형성이 가장 오래된 주제 중 하나라는 점을 고려할 때, 위 시나리오에서 답해야 할 질문들은 전문적인 사실 지식이나 정보 처리 기술을 포함하지 않을 것이라는 것은 암시적입니다.컴퓨터의 과제는 오히려 여성의 역할에 대한 공감을 보여주고 튜링이 상상한 이 대화의 일부분에 나타나는 특징적인 미적 감각을 보여주는 것입니다.

- 질문자:X나 그녀의 머리 길이를 알려주시겠습니까?

- 참가자:제 머리는 대상머리이고, 가장 긴 가닥은 약 9인치입니다.

튜링이 자신의 상상 속 대화 중 하나에 전문적인 지식을 도입할 때, 주제는 수학이나 전자가 아니라 시입니다.

- 질문자:소네트의 첫 줄에 "당신을 여름날과 비교해 볼까요?"라고 쓰여 있는데, "봄날"이 더 잘 되지 않을까요, 아니면 더 잘 되지 않을까요?

- 목격자:스캔을 안 해요.

- 질문자:"겨울날"은 어떨까요?스캔은 괜찮겠군요.

- 목격자:네, 하지만 아무도 겨울날과 비교되고 싶어하지 않아요.

따라서 튜링은 인공 지능의 구성 요소로서 공감과 미적 민감성에 대한 그의 관심을 다시 한번 보여줍니다. 그리고 인공 지능의 [71]위협에 대한 증가하는 인식에 비추어 볼 때, 이러한 초점은 아마도 튜링의 부분에 대한 비판적인 직관을 나타내는 것이라고 제안되었습니다[72].감성적이고 미적인 지능이 "친한 인공지능"을 만드는 데 핵심적인 역할을 할 것입니다.그러나 튜링이 이러한 방향으로 영감을 줄 수 있는 것은 그의 원래 비전의 보존에 달려 있다는 점, 즉, 튜링 테스트의 "표준 해석", 즉 담론적 지능에만 초점을 맞춘 해석의 공표는 약간의 주의를 기울여 고려되어야 한다는 점에 더 주목합니다.

약점

튜링은 튜링 테스트가 "지능" 또는 다른 인간의 자질의 척도로 사용될 수 있다고 명시적으로 언급하지 않았습니다.그는 "생각하는 기계"의 가능성에 대한 비판에 답하고 연구가 앞으로 나아갈 수 있는 방법을 제시하기 위해 사용할 수 있는 "생각하는 기계"라는 단어에 대해 명확하고 이해할 수 있는 대안을 제공하기를 원했습니다.

그럼에도 불구하고 튜링 테스트는 기계의 "생각하는 능력" 또는 "지능"의 척도로 제안되어 왔습니다.이 제안은 철학자들과 컴퓨터 과학자들 모두로부터 비판을 받았습니다.이 해석은 조사관이 기계의 행동과 인간의 행동을 비교함으로써 기계가 "생각하고 있는지"를 판단할 수 있다는 가정을 합니다.질문자의 판단의 신뢰성, 기계와 인간을 비교하는 가치, 행동만을 비교하는 가치 등 이 가정의 모든 요소에 의문이 제기되었습니다.이러한 점들과 다른 고려 사항들 때문에, 일부 인공지능 연구자들은 이 테스트가 그들의 분야와의 관련성에 의문을 제기했습니다.

심문관 나베테

실제로, 시험의 결과는 컴퓨터의 지능이 아니라 질문자의 태도, 기술 또는 순진함에 의해 쉽게 좌우될 수 있습니다.인지 과학자 게리 마커스를 포함한 이 분야의 수많은 전문가들은 튜링 테스트가 인간을 속이는 것이 얼마나 쉬운지 보여줄 뿐 기계 [73]지능의 지표가 아니라고 주장합니다.

튜링은 시험에 대한 설명에서 심문관이 요구하는 정확한 기술과 지식을 명시하지는 않지만, "평균 심문관"이라는 용어를 사용했습니다: "[평균 심문관은 5분간의 [61]질문 후에 정확한 신원 확인을 할 가능성이 70%를 넘지 않을 것입니다."

ELIZA와 같은 채터봇 프로그램은 의심하지 않는 사람들을 계속해서 속여서 그들이 인간과 의사소통을 하고 있다고 믿게 했습니다.이런 경우, "조사관"은 컴퓨터와 상호작용하고 있을 가능성조차 인식하지 못합니다.성공적으로 인간처럼 보이려면 기계가 어떤 지능도 가질 필요가 없고 단지 인간의 행동과 피상적으로 유사하기만 하면 됩니다.

초기 뢰브너 상 대회는 [44]기계에 쉽게 속아 넘어간 "세련되지 않은" 심문관들을 사용했습니다.2004년부터 뢰브너상 조직위원회는 심문관 중에 철학자, 컴퓨터 과학자, 언론인을 배치했습니다.그럼에도 불구하고, 이 전문가들 중 일부는 이 [74]기계에 속았습니다.

튜링 테스트의 흥미로운 특징 중 하나는 컨페더레이션 효과의 빈도인데, 컨페더레이션(테스트된) 인간이 심문자들에 의해 기계로 오인될 때입니다.심문자들이 인간의 반응으로 기대하는 것이 반드시 인간의 전형적인 것은 아니라는 의견이 제기되었습니다.결과적으로 어떤 사람들은 기계로 분류될 수 있습니다.따라서 이는 경쟁 기계에 유리하게 작용할 수 있습니다.인간은 "행동하라"는 지시를 받지만, 때때로 그들의 대답은 심문자가 기계가 [75]말하기를 기대하는 것과 더 유사합니다.이것은 인간이 "인간답게 행동할" 동기를 보장하는 방법에 대한 의문을 제기합니다.

인간 지능 대 일반 지능

튜링 테스트는 컴퓨터가 지능적으로 동작하는지 여부를 직접 테스트하지 않습니다.컴퓨터가 사람처럼 행동하는지 여부만 테스트합니다.인간의 행동과 지능적인 행동은 완전히 같은 것이 아니기 때문에 테스트는 지능을 두 가지 방법으로 정확하게 측정하지 못할 수 있습니다.

- 어떤 인간의 행동은 비지능적입니다.

- 튜링 테스트는 기계가 지능적인지 여부에 관계없이 모든 인간의 행동을 실행할 수 있어야 합니다.그것은 [76]심지어 모욕에 대한 민감성, 거짓말에 대한 유혹 또는 단순히 입력 실수의 높은 빈도와 같이 전혀 똑똑하다고 여겨지지 않을 수 있는 행동을 테스트합니다.기계가 이러한 비지능적인 행동을 세부적으로 모방할 수 없으면 테스트에 실패합니다.

- 이에 대한 반대는 이코노미스트가 1992년 제1회 뢰브너상 대회 직후 발표한 "인공적인 어리석음"이라는 제목의 기사에서 제기한 것입니다.이 기사는 첫 번째 뢰브너 수상자의 승리는 적어도 부분적으로 "인간의 타자 [43]오류를 모방"할 수 있는 능력 덕분이라고 언급했습니다.튜링 자신은 프로그램이 게임의 [77]더 나은 "플레이어"가 되기 위해 출력에 오류를 추가해야 한다고 제안했습니다.

- 어떤 지적인 행동은 비인간적입니다.

- 튜링 테스트는 어려운 문제를 해결하거나 독창적인 통찰력을 도출하는 능력과 같은 매우 지능적인 행동을 테스트하지 않습니다.사실, 그것은 구체적으로 기계의 측면에서 기만을 요구합니다: 기계가 인간보다 더 지능적이라면 의도적으로 너무 지능적으로 보이는 것을 피해야 합니다.만약 인간이 풀기에 현실적으로 불가능한 계산 문제를 풀게 된다면, 심문관은 그 프로그램이 인간이 아니라는 것을 알게 될 것이고, 그 기계는 시험에 실패할 것입니다.

- 인간의 능력 밖의 지능을 측정할 수 없기 때문에 이 테스트는 인간보다 더 지능적인 시스템을 구축하거나 평가하는 데 사용될 수 없습니다.이 때문에 초지능 시스템을 평가할 수 있는 몇 가지 테스트 대안이 [78]제시되었습니다.

의식 vs. 의식의 시뮬레이션

튜링 테스트는 피험자가 어떻게 작용하는지 – 기계의 외부적인 행동과 엄격히 관련되어 있습니다.이 점에서 마음의 연구에는 행동주의적 또는 기능주의적 접근이 필요합니다.ELIZA의 예는 테스트를 통과한 기계가 생각하거나 생각하지 않고 간단한(그러나 큰) 기계 규칙 목록을 따름으로써 인간의 대화 행동을 시뮬레이션할 수 있음을 시사합니다.

존 설(John Searle)은 기계가 "실제로" 사고를 하고 있는지 아니면 단순히 [37]"사고를 모의"하는 것인지를 판단하기 위해 외부 행동을 사용할 수 없다고 주장했습니다.그의 중국어 방 주장은 튜링 테스트가 지능에 대한 좋은 조작적 정의일지라도 기계가 마음, 의식 또는 의도를 가지고 있다는 것을 나타내지 않을 수 있음을 보여주기 위한 것입니다.(의도성은 생각의 힘이 어떤 것에 대해 "대략적"이 된다는 철학적 용어입니다.)

튜링은 자신의 원래 [79]논문에서 다음과 같은 비판을 예상했습니다.

나는 내가 의식에 대한 신비가 없다고 생각하는 인상을 주고 싶지 않습니다.예를 들어, 그것을 현지화하려는 어떤 시도와도 연관된 역설의 무언가가 있습니다.그러나 나는 우리가 이 [80]논문에서 우려하는 질문에 답하기 전에 이 미스터리들이 반드시 해결될 필요는 없다고 생각합니다.

비현실성과 무관성: 튜링 테스트와 인공지능 연구

주류 인공지능 연구원들은 튜링 테스트를 통과하려는 것은 단지 더 효과적인 [45]연구에 대한 방해일 뿐이라고 주장합니다.사실, 튜링 테스트는 스튜어트 러셀과 피터 노비그가 쓴 것처럼 학문적 또는 상업적 노력의 적극적인 초점이 아닙니다."인공지능 연구자들은 튜링 [81]테스트를 통과하는 데 거의 관심을 기울이지 않았습니다."몇 가지 이유가 있습니다.

첫째, 프로그램을 테스트하는 더 쉬운 방법들이 있습니다.현재 AI 관련 분야의 대부분의 연구는 객체 인식이나 물류와 같은 소박하고 구체적인 목표를 목표로 하고 있습니다.이러한 문제를 해결하는 프로그램의 지능을 테스트하기 위해 인공지능 연구원은 단순히 그들에게 직접 과제를 제공합니다.스튜어트 러셀(Stuart Russell)과 피터 노빅(Peter Norvig)은 비행의 역사와 유사한 점을 제시합니다. 비행기는 새와 비교하는 것이 아니라 얼마나 잘 날는지에 따라 시험됩니다.그들은 "항공공학 교과서는 그들 분야의 목표를 '비둘기처럼 정확히 날아서 다른 비둘기들을 속일 수 있는 기계를 만드는 것'으로 정의하지 않는다"고 썼습니다.[81]

둘째, 인간의 실물과 같은 시뮬레이션을 만드는 것은 AI 연구의 기본 목표를 달성하기 위해 그 자체로 해결할 필요가 없는 어려운 문제입니다.믿을 수 있는 인간 캐릭터는 예술 작품, 게임, 또는 정교한 사용자 인터페이스에 흥미로울 수 있지만, 그것들은 지능을 사용하여 문제를 해결하는 기계를 만드는 과학의 일부는 아닙니다.

튜링은 자신의 아이디어가 프로그램의 지능을 시험하는 데 사용될 의도가 없었습니다. 그는 인공지능의 [82]철학에 대한 논의를 돕기 위해 명확하고 이해할 수 있는 예를 제공하기를 원했습니다.John McCarthy는 철학적인 아이디어가 실용적인 응용에 쓸모가 없다는 것이 밝혀지는 것에 놀라지 말아야 한다고 주장합니다.그는 AI의 철학이 "과학의 철학이 일반적으로 [83]과학의 실천에 미치는 영향보다 AI 연구의 실천에 더 이상의 영향을 미치지 않을 것"이라고 관측합니다.

언어 중심의 반론

튜링 테스트에 대해 제기된 또 다른 잘 알려진 반대 의견은 언어적 행동에 대한 독점적인 초점에 관한 것입니다(즉, 다른 모든 인지 능력은 테스트되지 않은 상태에서 "언어 기반" 실험일 뿐입니다).이 단점은 심리학자 하워드 가드너가 그의 "다중 지능 이론"에서 고려할 것을 제안하는 인간과 관련된 다른 형식별 "지능적 능력"의 역할을 축소합니다(언어적 능력은 그 [84]중 하나일 뿐입니다).

침묵.

튜링 테스트의 중요한 측면은 기계가 그 발화에 의해 기계가 되는 것으로 주어져야 한다는 것입니다.그런 다음 조사관은 기계를 정확하게 식별함으로써 "올바른 식별"을 해야 합니다.대화 중에 기계가 침묵 상태를 유지하는 경우, 질문자가 계산된 [85]추측 이외에는 기계를 정확하게 식별하는 것이 불가능합니다.테스트의 일부로 병렬/숨겨진 인간을 고려하는 것조차도 인간이 종종 [86]기계로 오인될 수 있기 때문에 상황에 도움이 되지 않을 수 있습니다.

변주곡

위에서 설명한 것들을 포함하여 튜링 테스트의 수많은 다른 버전들이 수년간 제기되었습니다.

역튜링 테스트 및 CAPTCHA

역할 중 하나 이상의 목표가 기계와 인간 사이에서 뒤바뀌는 튜링 테스트를 수정한 것을 역 튜링 테스트라고 합니다.한 가지 예는 정신분석가 윌프레드 [87]비온의 연구에 함축되어 있는데, 그는 특히 한 마음과 다른 마음의 만남에서 비롯된 "폭풍"에 매료되었습니다.그의 2000년 [65]저서에서, 튜링 테스트와 관련된 몇 가지 다른 독창적인 점들 중에서, 문학 학자 피터 스월스키는 그가 스월스키 테스트라고 부르는 것, 즉 본질적으로 역 튜링 테스트에 대한 아이디어에 대해 자세히 논의했습니다.그는 모든 표준 이의가 표준 버전에서 수평이 되는 것은 아니더라도 가장 많이 극복한다고 지적했습니다.

이 생각을 진전시키는 거야, R.D. 힌셸우드는[88] 마음을 "마음을 인식하는 장치"로 묘사했습니다.문제는 컴퓨터가 사람과 상호작용하는지 다른 컴퓨터와 상호작용하는지를 판단할 수 있는 것입니다.이것은 튜링이 대답하려고 시도했지만 아마도 우리가 일반적으로 특징적으로 인간이라고 정의하는 방식으로 "생각"할 수 있는 기계를 충분히 높은 기준을 제공할 것입니다.

캡차는 역 튜링 테스트의 한 형태입니다.웹 사이트에서 일부 작업을 수행하도록 허용되기 전에 사용자에게 왜곡된 그래픽 이미지의 영숫자 문자가 표시되고 입력하도록 요청됩니다.이는 자동화된 시스템이 사이트를 악용하는 데 사용되는 것을 방지하기 위한 것입니다.그 근거는 왜곡된 이미지를 정확하게 읽고 재생할 수 있을 정도로 충분히 정교한 소프트웨어가 존재하지 않거나 일반 사용자가 사용할 수 없기 때문에, 그렇게 할 수 있는 모든 시스템이 사람일 가능성이 높다는 것입니다.

생성 엔진의 패턴을 분석하여 CAPTCHA를 어느 정도 정확하게 되돌릴 수 있는 소프트웨어는 CAPTCHA가 [89]생성된 직후 개발되기 시작했습니다.2013년, Vicarious의 연구원들은 Google, Yahoo! 및 PayPal의 [90]캡차 과제를 90%까지 해결할 수 있는 시스템을 개발했다고 발표했습니다.2014년 Google 엔지니어는 99.8%의 [91]정확도로 캡차(CAPTCHA) 문제를 해결할 수 있는 시스템을 시연했습니다.2015년, 구글의 전 클릭 사기 책임자인 Shuman Gosemajumder는 다양한 형태의 [92]사기를 가능하게 하기 위해 CAPTCHA 도전을 유료로 물리칠 사이버 범죄 사이트가 있다고 말했습니다.

언어의 정확한 사용과 실제 이해의 구분

현대 자연 언어 처리가 거대한 텍스트 말뭉치를 기반으로 텍스트를 생성하는 데 매우 성공적인 것으로 입증되고 모델의 초기 훈련에서 사용된 단어와 문장을 조작함으로써 결국 튜링 테스트를 통과할 수 있다는 우려에 의해 추가적인 변형이 동기부여됩니다.질문자는 훈련 데이터에 대한 정확한 이해가 없기 때문에 모델은 엄청난 양의 훈련 데이터에 유사한 방식으로 존재하는 문장을 반환하는 것일 수 있습니다.이런 이유로 아서 슈워닝거는 언어만을 사용할 수 있는 시스템과 언어를 이해하는 시스템을 구분할 수 있는 튜링 테스트의 변형을 제안합니다.그는 기계가 어떤 사전 지식에도 의존하지 않으면서도 적절하게 [93]대답하기 위해 자기 성찰을 요구하는 철학적 질문에 직면하는 시험을 제안합니다.

주제 전문가 튜링 테스트

또 다른 변형은 주어진 분야의 전문가와 기계의 반응을 구별할 수 없는 주제-문제 전문가 튜링 테스트로 설명됩니다.이것은 "페이겐바움 테스트"라고도 알려져 있으며 Edward Feigenbaum에 의해 2003년 [94]논문에서 제안되었습니다.

"저준위" 인지 테스트

Robert French(1990)는 인지과학에 의해 연구된 바와 같이, 심문자가 인간 인지의 낮은 수준(즉, 무의식) 과정을 드러내는 질문을 제기함으로써 인간과 인간이 아닌 대화자를 구별할 수 있다고 주장합니다.그러한 질문들은 사고의 인간 구현의 정확한 세부사항들을 드러내며, 인간이 [95]하는 것처럼 세상을 경험하지 않는 한 컴퓨터를 숨길 수 없습니다.

토탈 튜링 테스트

인지 과학자 Stevan Harnad가 [96]제안한 튜링 테스트의 "Total Turing test"[4] 변형은 전통적인 튜링 테스트에 두 가지 요구 사항을 추가합니다.조사관은 대상자의 지각 능력(컴퓨터 비전 필요)[97]과 대상자의 사물 조작 능력(로보틱스 필요)을 테스트할 수도 있습니다.

전자건강기록

ACM의 Communications of the[98] ACM에 게재된 편지는 합성 환자 모집단을 생성하는 개념을 설명하고 합성 환자와 실제 환자 사이의 차이를 평가하기 위한 튜링 테스트의 변형을 제안합니다.편지에는 "인간 의사가 인공적으로 생성된 환자와 실제 살아있는 환자를 쉽게 구별할 수 있지만, 기계가 스스로 그러한 결정을 내릴 수 있는 지능을 부여받을 수 있을까?"라는 내용이 적혀 있고, 나아가 편지에는 "합성 환자의 신원이 공중 보건의 문제가 되기 전에,합법적인 EHR 시장은 더 큰 데이터 신뢰성과 진단 가치를 보장하기 위해 튜링 테스트와 같은 기술을 적용함으로써 이익을 얻을 수 있습니다.따라서 새로운 기술은 환자의 이질성을 고려해야 하며 앨런 8학년 과학 시험이 등급을 매길 수 있는 것보다 더 큰 복잡성을 가질 가능성이 있습니다."

최소 지능형 신호 테스트

최소 지능형 신호 테스트는 Chris McKinstry에 의해 "튜링 [99]테스트의 최대 추상화"로 제안되었는데, 이는 이진 응답(참/거짓 또는 예/아니오)만이 허용되어 사고 능력에만 초점을 맞추는 것입니다.의인화 편향과 같은 텍스트 채팅 문제를 제거하고 비지능적 인간 행동에 대한 에뮬레이션을 필요로 하지 않으므로 인간의 지능을 초과하는 시스템을 허용합니다.하지만, 질문은 질문이라기 보다는 아이큐 테스트에 가깝도록 각각 독립적으로 서 있어야 합니다.일반적으로 인공지능 프로그램의 성능을 측정할 [100]수 있는 통계 데이터를 수집하는 데 사용됩니다.

허터상

허터상의 주최자들은 자연어 텍스트를 압축하는 것은 튜링 테스트를 통과하는 것과 같은 어려운 인공지능 문제라고 생각합니다.

데이터 압축 테스트는 튜링 테스트의 대부분 버전과 변형에 비해 다음과 같은 몇 가지 이점이 있습니다.

- 이것은 두 기계 중 어떤 것이 "더 지능적"인지를 비교하는 데 직접적으로 사용할 수 있는 하나의 숫자를 제공합니다.

- 그것은 컴퓨터가 판사에게 거짓말을 할 필요가 없습니다.

데이터 압축을 테스트로 사용할 때의 주요 단점은 다음과 같습니다.

- 이런 식으로 인간을 시험하는 것은 불가능합니다.

- 이 테스트의 특정 "점수"가 인간 수준의 튜링 테스트를 통과하는 것과 동일한 것인지는 알 수 없습니다.

압축 또는 콜모고로프 복잡도에 기초한 기타 검정

1990년대 후반에 훨씬 일찍 등장한 허터 상에 대한 관련 접근법은 확장 튜링 [101]테스트에 압축 문제를 포함시킨 것입니다.또는 콜모고로프 [102]복잡성으로부터 완전히 도출된 테스트에 의해.Hernandez-Orallo와 Dowe는 [103]이 선에서 다른 관련 테스트를 제시합니다.

알고리즘 IQ 또는 줄여서 AIQ는 Legg와 Hutter(솔로모노프의 귀납적 추론에 기초함)의 이론적인 보편적 지능 [104]측정을 기계 지능의 실용적인 테스트로 변환하려는 시도입니다.

이러한 테스트의 두 가지 주요 장점은 인간이 아닌 지능에 적용할 수 있다는 점과 인간 테스트자를 위한 요구사항이 없다는 점입니다.

에버트 검정

튜링 테스트는 2011년 영화평론가 로저 에버트가 제안한 에버트 테스트에 영감을 주었습니다. 이 테스트는 컴퓨터 기반으로 합성된 음성이 억양, 굴절, 타이밍 등의 측면에서 충분한 기술을 가지고 있는지 여부를 테스트하여 [105]사람들을 테스트하는 것입니다.

소셜 튜링 게임

Large Language Models의 이점을 활용하여, 조사 회사인 AI21 Labs는 2023년에 "Human or Not?"[106][107]이라는 제목의 온라인 소셜 실험을 만들었습니다.2백만 명 이상의 [108]사람들이 천만 번 이상 연주했습니다.그것은 지금까지 가장 큰 튜링 스타일의 실험입니다.그 결과 32%의 사람들이 인간과 [109][110]기계를 구별하지 못한다는 것을 보여주었습니다.

컨퍼런스

튜링 콜로키움

1990년은 튜링의 "Computing Machinery and Intelligence" 논문이 처음 출판된 지 40주년이 되는 해였고, 이 테스트에 대한 새로운 관심을 갖게 되었습니다.그 해에 두 가지 중요한 사건이 일어났습니다: 첫 번째 사건은 4월 서섹스 대학에서 열린 튜링 콜로키움이었고, 튜링 테스트를 과거, 현재의 관점에서 논의하기 위해 다양한 분야의 학자들과 연구자들이 모였습니다.두 번째는 매년 열리는 뢰브너 상 대회의 구성이었습니다.

블레이 휘트비는 튜링 테스트의 역사에서 네 가지 중요한 전환점을 열거하고 있습니다: 1950년에 "컴퓨팅 머신과 지능"의 출판, 1966년에 조셉 바이젠바움의 엘리자 발표, 1972년에 처음 기술된 케네스 콜비의 파리(PARRY)의 창작, 그리고 [111]1990년에 튜링 콜로키움.

2005 대화형 시스템에 관한 콜로키움

2005년 11월, 서리 대학교는 뢰브너 상에서 실용적인 튜링 테스트를 수상한 Robby Garner, Richard Wallace 및 Rollo Carpenter와 같은 인공적인 대화 개체 [112]개발자들의 첫 번째 회의를 개최했습니다.초청 연사로는 데이비드 해밀, 휴 뢰브너(Loebner Prize의 후원자), 후마 샤(Huma Shah) 등이 참석했습니다.

2008 AISB 심포지엄

인공지능 및 행동 시뮬레이션 협회(AISB)가 [113]리딩 대학에서 개최한 2008년 뢰브너 상과 병행하여, 존 반든, 마크 비숍, 휴마 샤 및 케빈 [114]워릭이 주관한 튜링 테스트를 논의하기 위한 하루 심포지엄을 개최했습니다.강연자로는 영국 왕립학회의 수잔 그린필드 남작 부인, 셀머 브링요르드, 튜링의 전기 작가 앤드류 호지스, 의식과학자 오웬 홀랜드 등이 포함됐습니다.Bringjord는 상당한 상금이 튜링 테스트가 더 빨리 통과되는 결과를 가져올 것이라고 말했지만 표준 튜링 테스트에 대한 합의는 나타나지 않았습니다.

알란 튜링의 해, 그리고 2012년 튜링 100.

2012년 내내, 튜링의 삶과 과학적인 영향을 축하하기 위해 많은 주요 행사들이 열렸습니다.튜링 100 그룹은 이러한 행사들을 지원하고 튜링 탄생 100주년을 기념하기 위해 2012년 6월 23일 블레츨리 공원에서 특별한 튜링 테스트 행사를 개최했습니다.

참고 항목

- 자연어 처리

- 소설 속의 인공지능

- 맹인

- 인과관계

- 챗봇

- 채팅GPT

- 컴퓨터 게임봇 튜링 테스트

- 죽은 인터넷 이론

- 설명.

- 설명공백

- 기능주의

- 그래픽스 튜링 테스트

- Ex Machina (영화)

- 의식의 어려운 문제

- 앨런 튜링의 이름을 딴 사물 목록

- Mark V. Shaney (유즈넷봇)

- 심신장애

- 거울뉴런

- 철학좀비

- 다른마음의문제

- 역공학

- 센티언스

- 모의현실

- 소셜봇

- 기술적 특이점

- 심성론

- 언캐니 계곡

- Voight-Kampff 기계(Blade Runner의 가상 튜링 테스트)

- Winograd 스키마

- SHRDLU

메모들

- ^ Saygin 2000을 각색한 이미지

- ^ a b (Turing 1950, p. 442) 튜링은 자신의 아이디어를 "튜링 테스트"라고 부르지 않고, "이미테이션 게임"이라고 부릅니다; 그러나 후대의 문헌들은 테스트의 특정한 버전을 설명하기 위해 "이미테이션 게임"이라는 용어를 유보했습니다.아래 #버전 참조.튜링은 논문의 후반부에 질문에 대해 더 정확한 버전을 제시합니다. "[T]이 질문들은 이와 동등합니다. '특정 디지털 컴퓨터 C에 주의를 고정합시다.이 컴퓨터가 적절한 저장공간을 갖도록 수정하여 동작속도를 적절히 높이고, 적절한 프로그램을 제공함으로써 C가 모방게임에서 A의 역할을 만족스럽게 할 수 있다는 것이 사실인가?'(Turing 1950, p. 442)

- ^ 튜링은 1950년에 이용 가능한 몇 안 되는 문자 전용 통신 시스템 중 하나인 텔레프린터를 처음 제안했습니다. (튜링 1950, 페이지 433)

- ^ a b Oppy, Graham & Dowe, David (2011) The Turing Test Archived at the Wayback Machine 2012년 3월 20일스탠포드 철학 백과사전.

- ^ "The Turing Test, 1950". turing.org.uk. The Alan Turing Internet Scrapbook. Archived from the original on 3 April 2019. Retrieved 23 April 2015.

- ^ a b c 튜링 1950, 페이지 433.

- ^ a b Turing 1950, pp. 442–454, 그리고 Russell & Norvig (2003, pp. 948)를 보면, 그들은 "Turing은 그의 논문이 등장한 이후 반세기 동안 제기된 사실상 모든 것들을 포함하여 지능형 기계의 가능성에 대한 광범위한 가능한 반대를 검토했습니다."라고 언급합니다.

- ^ a b c d e f Saygin 2000.

- ^ Russell & Norvig 2003, pp. 2–3, 948.

- ^ Swiechowski, Maciej (2020), "Game AI Competitions: Motivation for the Imitation Game-Playing Competition" (PDF), Proceedings of the 15th Conference on Computer Science and Information Systems (FedCSIS 2020), Proceedings of the 2020 Federated Conference on Computer Science and Information Systems, IEEE Publishing, 21: 155–160, doi:10.15439/2020F126, ISBN 978-83-955416-7-4, S2CID 222296354, archived (PDF) from the original on 26 January 2021, retrieved 8 September 2020.

- ^ 데카르트 1996, 34-35쪽

- ^ 속성 이원론의 예는 Qualia를 참조하십시오.

- ^ 물질주의가 인공적인 마음(예를 들어 로저 펜로즈)의 가능성을 필요로 하지 않는다는 점에 주목하면, 이중성 이상의 것은 반드시 가능성을 배제합니다.(예를 들어 Property Dualism을 참조하십시오.)

- ^ Ayer, A. J. (2001), "Language, Truth and Logic", Nature, Penguin, 138 (3498): 140, Bibcode:1936Natur.138..823G, doi:10.1038/138823a0, ISBN 978-0-334-04122-1, S2CID 4121089[검증 필요]

- ^ a b Svilpis, Janis (2008). "The Science-Fiction Prehistory of the Turing Test". Science Fiction Studies. 35 (3): 430–449. ISSN 0091-7729. JSTOR 25475177. Archived from the original on 5 February 2023. Retrieved 5 February 2023.

- ^ Wansbrough, Aleks (2021). Capitalism and the enchanted screen : myths and allegories in the digital age. New York, NY. p. 114. ISBN 978-1-5013-5639-1. OCLC 1202731640.

{{cite book}}: CS1 유지 관리: 위치 누락 게시자(링크) - ^ 1956년 다트머스 회의는 "AI의 탄생"으로 널리 간주됩니다(Crevier 1993, 페이지 49).

- ^ 맥코덕 2004, 95쪽.

- ^ Copeland 2003, p. 1.

- ^ Copeland 2003, p. 2.

- ^ "지능형 기계"(1948)는 튜링에 의해 출판되지 않았고 1968년까지 출판되지 않았습니다.

- Evans, A. D. J.; Robertson (1968), Cybernetics: Key Papers, University Park Press

- ^ 튜링 1948, 페이지 412.

- ^ 1948년, 그의 전 학부 동기인 DG Champernown과 함께 일하면서, Turing은 아직 존재하지 않는 컴퓨터를 위한 체스 프로그램을 만들기 시작했고, 그 프로그램을 실행할 수 있을 만큼 강력한 컴퓨터가 부족했던 1952년, 그가 그것을 모의 실험하는 게임을 했고, 매 동작마다 약 30분이 걸렸습니다.게임은 녹화되었고, 프로그램은 챔퍼논의 아내를 상대로 게임에서 이겼다고 하지만 튜링의 동료 앨릭 글레니에게 졌습니다.

- ^ 튜링 1948, p.

- ^ Harnad 2004, p. 1.

- ^ a b c d e 튜링 1950, 페이지 434.

- ^ a b 샤 & 워릭 2010a.

- ^ 튜링 1950, 페이지 446.

- ^ 튜링 1952, 페이지 524-525튜링은 성별로서의 "인간"과 인간으로서의 "인간"을 구분하지 않는 것 같습니다.전자의 경우, 이 공식은 모방 게임에 더 가까울 것이고, 후자의 경우에는 테스트의 현재 묘사에 더 가까울 것입니다.

- ^ 바이젠바움 1966, 페이지 37.

- ^ a b c 바이젠바움 1966, 페이지 42.

- ^ 토마스 1995, 112쪽.

- ^ Bowden 2006, 페이지 370.

- ^ a b 콜비 외 1972, 페이지 220.

- ^ Withers, Steven (11 December 2007), "Flirty Bot Passes for Human", iTWire, archived from the original on 4 October 2017, retrieved 10 February 2010

- ^ Williams, Ian (10 December 2007), "Online Love Seerkers Warned Flirt Bots", V3, archived from the original on 24 April 2010, retrieved 10 February 2010

- ^ a b 1980년 설.

- ^ 설의 중식방에 대한 반론이 만만치 않습니다.몇 가지는 다음과 같습니다.

- Hauser, Larry (1997), "Searle's Chinese Box: Debunking the Chinese Room Argument", Minds and Machines, 7 (2): 199–226, doi:10.1023/A:1008255830248, S2CID 32153206.

- Rehman, Warren. (19 July 2009), Argument against the Chinese Room Argument, archived from the original on 19 July 2010.

- Thornley, David H. (1997), Why the Chinese Room Doesn't Work, archived from the original on 26 April 2009

- ^ M. Bishop & J. Preston (eds.) (2001) 설의 중국인 방 논쟁에 대한 에세이옥스퍼드 대학 출판부

- ^ Saygin 2000, 페이지 479.

- ^ 선드먼 2003.

- ^ 뢰브너 1994.

- ^ a b c "Artificial Stupidity". The Economist. Vol. 324, no. 7770. 1 August 1992. p. 14.

- ^ a b c Shapiro 1992, p. 10-11 및 Shieber 1994 등.

- ^ a b 시버 1994, 페이지 77.

- ^ "Turing test, on season 4, episode 3". Scientific American Frontiers. Chedd-Angier Production Company. 1993–1994. PBS. Archived from the original on 1 January 2006.

- ^ Dan Williams (9 June 2022). "Artificial neural networks are making strides towards consciousness, according to Blaise Agüera y Arcas". The Economist. Archived from the original on 9 June 2022. Retrieved 13 June 2022.

- ^ Nitasha Tiku (11 June 2022). "The Google engineer who thinks the company's AI has come to life". Washington Post. Archived from the original on 11 June 2022. Retrieved 13 June 2022.

- ^ Jeremy Kahn (13 June 2022). "A.I. experts say the Google researcher's claim that his chatbot became 'sentient' is ridiculous—but also highlights big problems in the field". Fortune. Archived from the original on 13 June 2022. Retrieved 13 June 2022.

- ^ a b c Traiger 2000.

- ^ 세이긴, 로버츠 & 베버 2008.

- ^ a b 무어 2003.

- ^ Traiger 2000, 페이지 99.

- ^ 스테렛 2000.

- ^ a b 샤 2011.

- ^ Genova 1994, Hayes & Ford 1995, Heil 1998, Dreyfus 1979

- ^ 튜링 1948, 페이지 431.

- ^ 프라우드풋 2013, 페이지 398.

- ^ 곤살레스 2023년.

- ^ 단지거 2022년.

- ^ a b c 튜링 1950, 페이지 442.

- ^ R. 엡스타인, G. 로버츠, G. 폴란드, (eds.)튜링 테스트 파싱 : 사고 컴퓨터 탐구에서의 철학적, 방법론적 문제스프링어: 도르드레흐트, 네덜란드

- ^ Thompson, Clive (July 2005). "The Other Turing Test". Issue 13.07. WIRED magazine. Archived from the original on 19 August 2011. Retrieved 10 September 2011.

As a gay man who spent nearly his whole life in the closet, Turing must have been keenly aware of the social difficulty of constantly faking your real identity. And there's a delicious irony in the fact that decades of AI scientists have chosen to ignore Turing's gender-twisting test – only to have it seized upon by three college-age women

(2019년 3월 23일 웨이백 머신에서 풀 버전 보관Thompson, Clive (July 2005). "The Other Turing Test". Issue 13.07. WIRED magazine. Archived from the original on 19 August 2011. Retrieved 10 September 2011.As a gay man who spent nearly his whole life in the closet, Turing must have been keenly aware of the social difficulty of constantly faking your real identity. And there's a delicious irony in the fact that decades of AI scientists have chosen to ignore Turing's gender-twisting test – only to have it seized upon by three college-age women

). - ^ 콜비 외 1972.

- ^ a b 스월스키 2000년형.

- ^ Saygin & Cickeli 2002.

- ^ 튜링 1950, "새로운 문제에 대한 비판" 아래.

- ^ Haugeland 1985, p. 8.

- ^ 스튜어트 J. 러셀(Stuart J. Russell)과 피터 노빅(Peter Norvig)은 "이 여섯 가지 분야는 인공지능의 대부분을 대표한다"고 썼습니다. 러셀 & 노빅 2003, 페이지 3

- ^ "Watson Wins 'Jeopardy!' The IBM Challenge", Sony Pictures, 16 February 2011, archived from the original on 22 May 2011

- ^ Urban, Tim (February 2015). "The AI Revolution: Our Immortality or Extinction". Wait But Why. Archived from the original on 23 March 2019. Retrieved 5 April 2015.

- ^ Smith, G. W. (27 March 2015). "Art and Artificial Intelligence". ArtEnt. Archived from the original on 25 June 2017. Retrieved 27 March 2015.

- ^ Marcus, Gary (9 June 2014). "What Comes After the Turing Test?". The New Yorker. Archived from the original on 1 January 2022. Retrieved 16 December 2021.

- ^ 샤 & 워릭 2010j.

- ^ Kevin Warwick; Huma Shah (June 2014). "Human Misidentification in Turing Tests". Journal of Experimental and Theoretical Artificial Intelligence. 27 (2): 123–135. doi:10.1080/0952813X.2014.921734. S2CID 45773196.

- ^ Saygin & Cicekli 2002, 227-258쪽

- ^ 튜링 1950, 페이지 448.

- ^ 인간보다 더 지능적인 기계를 평가하기 위해 고안된 튜링 테스트의 몇 가지 대안:

- Jose Hernandez-Orallo (2000), "Beyond the Turing Test", Journal of Logic, Language and Information, 9 (4): 447–466, CiteSeerX 10.1.1.44.8943, doi:10.1023/A:1008367325700, S2CID 14481982.

- D L Dowe & A R Hajek (1997), "A computational extension to the Turing Test", Proceedings of the 4th Conference of the Australasian Cognitive Science Society, archived from the original on 28 June 2011, retrieved 21 July 2009.

- Shane Legg & Marcus Hutter (2007), "Universal Intelligence: A Definition of Machine Intelligence" (PDF), Minds and Machines, 17 (4): 391–444, arXiv:0712.3329, Bibcode:2007arXiv0712.3329L, doi:10.1007/s11023-007-9079-x, S2CID 847021, archived from the original (PDF) on 18 June 2009, retrieved 21 July 2009.

- Hernandez-Orallo, J; Dowe, D L (2010), "Measuring Universal Intelligence: Towards an Anytime Intelligence Test", Artificial Intelligence, 174 (18): 1508–1539, doi:10.1016/j.artint.2010.09.006.

- ^ Russell & Norvig(2003, pp. 958–960)는 Searle의 주장을 튜링 답안과 동일시합니다.

- ^ 튜링 1950.

- ^ a b 러셀 & 노빅 2003, 페이지 3.

- ^ 튜링 1950은 "이미테이션 게임"이라는 제목 아래에서, "그런 정의를 시도하는 대신, 나는 질문을 그것과 밀접하게 관련되어 있고 비교적 모호하지 않은 단어로 표현되는 다른 질문으로 대체할 것입니다."라고 썼습니다.

- ^ McCarthy, John (1996), "The Philosophy of Artificial Intelligence", What has AI in Common with Philosophy?, archived from the original on 5 April 2019, retrieved 26 February 2009

- ^ 가드너, H. (2011)마음의 틀:다중지능 이론.하셰트 우크

- ^ Warwick, Kevin; Shah, Huma (4 March 2017). "Taking the fifth amendment in Turing's imitation game" (PDF). Journal of Experimental & Theoretical Artificial Intelligence. 29 (2): 287–297. Bibcode:2017JETAI..29..287W. doi:10.1080/0952813X.2015.1132273. ISSN 0952-813X. S2CID 205634569.

- ^ Warwick, Kevin; Shah, Huma (4 March 2015). "Human misidentification in Turing tests". Journal of Experimental & Theoretical Artificial Intelligence. 27 (2): 123–135. doi:10.1080/0952813X.2014.921734. ISSN 0952-813X. S2CID 45773196.

- ^ 1979년 바이온.

- ^ 힌쉘우드 2001.

- ^ Malik, Jitendra; Mori, Greg, Breaking a Visual CAPTCHA, archived from the original on 23 March 2019, retrieved 21 November 2009

- ^ Pachal, Pete, Captcha FAIL: Researchers Crack the Web's Most Popular Turing Test, archived from the original on 3 December 2018, retrieved 31 December 2015

- ^ Tung, Liam, Google algorithm busts CAPTCHA with 99.8 percent accuracy, archived from the original on 23 March 2019, retrieved 31 December 2015

- ^ Ghosemajumder, Shuman, The Imitation Game: The New Frontline of Security, archived from the original on 23 March 2019, retrieved 31 December 2015

- ^ Schwaninger, Arthur C. (2022), "The Philosophising Machine – a Specification of the Turing Test", Philosophia, 50 (3): 1437–1453, doi:10.1007/s11406-022-00480-5, S2CID 247282718

- ^ McCorduck 2004, pp. 503-505, Feigenbaum 2003.Kurzweil(2005)에서도 주제 전문가 테스트를 언급하고 있습니다.

- ^ French, Robert M., "Subcognition and the Limits of the Turing Test", Mind, 99 (393): 53–65

- ^ Gent, Edd (2014), The Turing Test: brain-inspired computing's multiple-path approach, archived from the original on 23 March 2019, retrieved 18 October 2018

- ^ 러셀 & 노빅 2010, 페이지 3.

- ^ Cacm Staff (2017). "A leap from artificial to intelligence". Communications of the ACM. 61: 10–11. doi:10.1145/3168260.

- ^ http://tech.groups.yahoo.com/group/arcondev/message/337[데드링크]

- ^ McKinstry, Chris (1997), "Minimum Intelligent Signal Test: An Alternative Turing Test", Canadian Artificial Intelligence (41), archived from the original on 31 March 2019, retrieved 4 May 2011

- ^ D L Dowe & A R Hajek (1997), "A computational extension to the Turing Test", Proceedings of the 4th Conference of the Australasian Cognitive Science Society, archived from the original on 28 June 2011, retrieved 21 July 2009.

- ^ Jose Hernandez-Orallo (2000), "Beyond the Turing Test", Journal of Logic, Language and Information, 9 (4): 447–466, CiteSeerX 10.1.1.44.8943, doi:10.1023/A:1008367325700, S2CID 14481982.

- ^ 에르난데스-오랄로 & 다우 2010.

- ^ 보편적 지능 척도의 근사, Shane Legg and Joel Veness, 2011 Solomonoff 기념 회의

- ^ Alex_Pasternack (18 April 2011). "A MacBook May Have Given Roger Ebert His Voice, But An iPod Saved His Life (Video)". Motherboard. Archived from the original on 6 September 2011. Retrieved 12 September 2011.

He calls it the "Ebert Test," after Turing's AI standard...

- ^ Key, Alys (21 April 2023). "Could you tell if someone was human or AI?". Evening Standard. Retrieved 2 August 2023.

- ^ "Massive Turing test shows we can only just tell AIs apart from humans". New Scientist. Retrieved 2 August 2023.

- ^ Biever, Celeste (25 July 2023). "ChatGPT broke the Turing test — the race is on for new ways to assess AI". Nature. 619 (7971): 686–689. doi:10.1038/d41586-023-02361-7.

- ^ "Can you distinguish people from AI bots? 'Human or not' online game reveals results". ZDNET. Retrieved 2 August 2023.

- ^ Press, Gil. "Is It An AI Chatbot Or A Human? 32% Can't Tell". Forbes. Retrieved 2 August 2023.

- ^ Whitby 1996, 페이지 53.

- ^ ALICE Anniversary and Colloquium on Conversation, A.L.I.C.E. Artificial Intelligence Foundation, archived from the original on 16 April 2009, retrieved 29 March 2009

- ^ Loebner Prize 2008, University of Reading, retrieved 29 March 2009[영구 데드링크]

- ^ AISB 2008 Symposium on the Turing Test, Society for the Study of Artificial Intelligence and the Simulation of Behaviour, archived from the original on 18 March 2009, retrieved 29 March 2009

참고문헌

- Bion, W.S. (1979), "Making the best of a bad job", Clinical Seminars and Four Papers, Abingdon: Fleetwood Press.

- Bowden, Margaret A. (2006), Mind As Machine: A History of Cognitive Science, Oxford University Press, ISBN 978-0-19-924144-6

- Colby, K. M.; Hilf, F. D.; Weber, S.; Kraemer, H. (1972), "Turing-like indistinguishability tests for the validation of a computer simulation of paranoid processes", Artificial Intelligence, 3: 199–221, doi:10.1016/0004-3702(72)90049-5

- Copeland, Jack (2003), Moor, James (ed.), "The Turing Test", The Turing Test: The Elusive Standard of Artificial Intelligence, Springer, ISBN 978-1-4020-1205-1

- Crevier, Daniel (1993), AI: The Tumultuous Search for Artificial Intelligence, New York, NY: BasicBooks, ISBN 978-0-465-02997-6

- Danziger, Shlomo (2022), "Intelligence as a Social Concept: a Socio-Technological Interpretation of the Turing Test", Philosophy & Technology, 35: 68, doi:10.1007/s13347-022-00561-z

- Descartes, René (1996). Discourse on Method and Meditations on First Philosophy. New Haven & London: Yale University Press. ISBN 978-0300067729.

- Diderot, D. (2007), Pensees Philosophiques, Addition aux Pensees Philosophiques, [Flammarion], ISBN 978-2-0807-1249-3

- Dreyfus, Hubert (1979), What Computers Still Can't Do, New York: MIT Press, ISBN 978-0-06-090613-9

- Feigenbaum, Edward A. (2003), "Some challenges and grand challenges for computational intelligence", Journal of the ACM, 50 (1): 32–40, doi:10.1145/602382.602400, S2CID 15379263

- French, Robert M. (1990), "Subcognition and the Limits of the Turing Test", Mind, 99 (393): 53–65, doi:10.1093/mind/xcix.393.53, S2CID 38063853, archived from the original on 15 March 2023, retrieved 24 December 2019

- Genova, J. (1994), "Turing's Sexual Guessing Game", Social Epistemology, 8 (4): 314–326, doi:10.1080/02691729408578758

- Gonçalves, Bernardo (2023), "The Turing Test is a Thought Experiment", Minds & Machines, 33: 1–31, doi:10.1007/s11023-022-09616-8

- Harnad, Stevan (2004), "The Annotation Game: On Turing (1950) on Computing, Machinery, and Intelligence", in Epstein, Robert; Peters, Grace (eds.), The Turing Test Sourcebook: Philosophical and Methodological Issues in the Quest for the Thinking Computer, Klewer, archived from the original on 6 July 2011, retrieved 17 December 2005

- Haugeland, John (1985), Artificial Intelligence: The Very Idea, Cambridge, Massachusetts: MIT Press.

- Hayes, Patrick; Ford, Kenneth (1995), "Turing Test Considered Harmful", Proceedings of the Fourteenth International Joint Conference on Artificial Intelligence (IJCAI95-1), Montreal, Quebec, Canada.: 972–997

- Heil, John (1998), Philosophy of Mind: A Contemporary Introduction, London and New York: Routledge, ISBN 978-0-415-13060-8

- Hinshelwood, R.D. (2001), Group Mentality and Having a Mind: Reflections on Bion's work on groups and on psychosis

- Kurzweil, Ray (1990), The Age of Intelligent Machines, Cambridge, Massachusetts: MIT Press, ISBN 978-0-262-61079-7

- Kurzweil, Ray (2005), The Singularity is Near, Penguin Books, ISBN 978-0-670-03384-3

- Loebner, Hugh Gene (1994), "In response", Communications of the ACM, 37 (6): 79–82, doi:10.1145/175208.175218, S2CID 38428377, archived from the original on 14 March 2008, retrieved 22 March 2008

- McCorduck, Pamela (2004), Machines Who Think (2nd ed.), Natick, MA: A. K. Peters, Ltd., ISBN 1-56881-205-1

- Moor, James, ed. (2003), The Turing Test: The Elusive Standard of Artificial Intelligence, Dordrecht: Kluwer Academic Publishers, ISBN 978-1-4020-1205-1

- Penrose, Roger (1989), The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics, Oxford University Press, ISBN 978-0-14-014534-2

- Proudfoot, Diane (July 2013), "Rethinking Turing's Test", The Journal of Philosophy, 110 (7): 391–411, JSTOR 43820781

{{citation}}: CS1 메인 : 일자 및 연도 (링크) - Russell, Stuart J.; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2nd ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2

- Russell, Stuart J.; Norvig, Peter (2010), Artificial Intelligence: A Modern Approach (3rd ed.), Upper Saddle River, NJ: Prentice Hall, ISBN 978-0-13-604259-4

- Saygin, A. P.; Cicekli, I.; Akman, V. (2000), "Turing Test: 50 Years Later" (PDF), Minds and Machines, 10 (4): 463–518, doi:10.1023/A:1011288000451, hdl:11693/24987, S2CID 990084, archived from the original (PDF) on 9 April 2011, retrieved 7 January 2004무어에서 Saygin, A. P.; Cicekli, I.; Akman, V. (2000), "Turing Test: 50 Years Later" (PDF), Minds and Machines, 10 (4): 463–518, doi:10.1023/A:1011288000451, hdl:11693/24987, S2CID 990084, archived from the original (PDF) on 9 April 2011, retrieved 7 January 2004재인쇄 (2003, 페이지 23–78).

- Saygin, A. P.; Cicekli, I. (2002), "Pragmatics in human-computer conversation", Journal of Pragmatics, 34 (3): 227–258, CiteSeerX 10.1.1.12.7834, doi:10.1016/S0378-2166(02)80001-7.

- Saygin, A.P.; Roberts, Gary; Beber, Grace (2008), "Comments on "Computing Machinery and Intelligence" by Alan Turing", in Epstein, R.; Roberts, G.; Poland, G. (eds.), Parsing the Turing Test: Philosophical and Methodological Issues in the Quest for the Thinking Computer, Dordrecht, Netherlands: Springer, Bibcode:2009pttt.book.....E, doi:10.1007/978-1-4020-6710-5, ISBN 978-1-4020-9624-2, S2CID 60070108

- Searle, John (1980), "Minds, Brains and Programs", Behavioral and Brain Sciences, 3 (3): 417–457, doi:10.1017/S0140525X00005756, S2CID 55303721, archived from the original on 23 August 2000, retrieved 19 March 2008위의 페이지 번호는 기사의 표준 pdf 인쇄를 Searle, John (1980), "Minds, Brains and Programs", Behavioral and Brain Sciences, 3 (3): 417–457, doi:10.1017/S0140525X00005756, S2CID 55303721, archived from the original on 23 August 2000, retrieved 19 March 2008참조합니다. 설의 원본 초안도 참조하십시오.

- Shah, Huma; Warwick, Kevin (2009a), "Emotion in the Turing Test: A Downward Trend for Machines in Recent Loebner Prizes", in Vallverdú, Jordi; Casacuberta, David (eds.), Handbook of Research on Synthetic Emotions and Sociable Robotics: New Applications in Affective Computing and Artificial Intelligence, Information Science, IGI, ISBN 978-1-60566-354-8

- Shah, Huma; Warwick, Kevin (April 2010a), "Testing Turing's five minutes, parallel‐paired imitation game", Kybernetes, 4 (3): 449–465, doi:10.1108/03684921011036178

- Shah, Huma; Warwick, Kevin (June 2010j), "Hidden Interlocutor Misidentification in Practical Turing Tests", Minds and Machines, 20 (3): 441–454, doi:10.1007/s11023-010-9219-6, S2CID 34076187

- Shah, Huma (5 April 2011), Turing's misunderstood imitation game and IBM's Watson success, archived from the original on 10 February 2023, retrieved 20 December 2017

- Shapiro, Stuart C. (1992), "The Turing Test and the economist", ACM SIGART Bulletin, 3 (4): 10–11, doi:10.1145/141420.141423, S2CID 27079507

- Shieber, Stuart M. (1994), "Lessons from a Restricted Turing Test", Communications of the ACM, 37 (6): 70–78, arXiv:cmp-lg/9404002, Bibcode:1994cmp.lg....4002S, CiteSeerX 10.1.1.54.3277, doi:10.1145/175208.175217, S2CID 215823854, archived from the original on 17 March 2008, retrieved 25 March 2008

- Sterrett, S. G. (2000), "Turing's Two Test of Intelligence", Minds and Machines, 10 (4): 541, doi:10.1023/A:1011242120015, hdl:10057/10701, S2CID 9600264 (튜링 테스트에 다시 인쇄됨:James H. Moor가 편집한 인공지능의 이해하기 어려운 표준, Kluwer Academic 2003) ISBN 1-4020-1205-5

- Sundman, John (26 February 2003), "Artificial stupidity", Salon.com, archived from the original on 7 March 2008, retrieved 22 March 2008

- Thomas, Peter J. (1995), The Social and Interactional Dimensions of Human-Computer Interfaces, Cambridge University Press, ISBN 978-0-521-45302-8

- Swirski, Peter (2000), Between Literature and Science: Poe, Lem, and Explorations in Aesthetics, Cognitive Science, and Literary Knowledge, McGill-Queen's University Press, ISBN 978-0-7735-2078-3

- Traiger, Saul (2000), "Making the Right Identification in the Turing Test", Minds and Machines, 10 (4): 561, doi:10.1023/A:1011254505902, S2CID 2302024 (튜링 테스트에 다시 인쇄됨:James H. Moor가 편집한 인공지능의 이해하기 어려운 표준, Kluwer Academic 2003) ISBN 1-4020-1205-5

- Turing, Alan (1948), "Machine Intelligence", in Copeland, B. Jack (ed.), The Essential Turing: The ideas that gave birth to the computer age, Oxford: Oxford University Press, ISBN 978-0-19-825080-7

- Turing, Alan (October 1950), "Computing Machinery and Intelligence", Mind, LIX (236): 433–460, doi:10.1093/mind/LIX.236.433, ISSN 0026-4423

- Turing, Alan (1952), "Can Automatic Calculating Machines be Said to Think?", in Copeland, B. Jack (ed.), The Essential Turing: The ideas that gave birth to the computer age, Oxford: Oxford University Press, ISBN 978-0-19-825080-7

- Weizenbaum, Joseph (January 1966), "ELIZA – A Computer Program For the Study of Natural Language Communication Between Man And Machine", Communications of the ACM, 9 (1): 36–45, doi:10.1145/365153.365168, S2CID 1896290

- Whitby, Blay (1996), "The Turing Test: AI's Biggest Blind Alley?", in Millican, Peter; Clark, Andy (eds.), Machines and Thought: The Legacy of Alan Turing, vol. 1, Oxford University Press, pp. 53–62, ISBN 978-0-19-823876-8

- Zylberberg, A.; Calot, E. (2007), "Optimizing Lies in State Oriented Domains based on Genetic Algorithms", Proceedings VI Ibero-American Symposium on Software Engineering: 11–18, ISBN 978-9972-2885-1-7

추가열람

- Cohen, Paul R. (2006), "'If Not Turing's Test, Then What?", AI Magazine, 26 (4), archived from the original on 15 February 2017, retrieved 17 June 2016.

- 마커스, 게리 "내가 인간인가?"연구자들은 인공지능과 자연종을 구별할 수 있는 새로운 방법이 필요하다", Scientific American, vol. 316, no. 3(2017년 3월), pp. 58-63"운동 실력에 대한 단 한 번의 테스트도 없듯이 지능에 대한 궁극적인 테스트도 있을 수 없기 때문에 인공지능 효능에 대한 여러 테스트가 필요합니다."그러한 테스트 중 하나인 "건설적 도전"은 지각과 신체적 행동을 테스트하는 것입니다. "원래 튜링 테스트에는 전혀 없는 지능적 행동의 두 가지 중요한 요소입니다."또 다른 제안은 학생들이 보는 과학과 다른 학문의 표준화된 시험을 기계에 주는 것이었습니다.지금까지 인공지능의 극복 불가능한 장애물은 신뢰할 수 있는 모호함에 대한 무능입니다."[V]사실 사람들이 만들어내는 모든 문장은 종종 여러 가지 면에서 모호합니다."중요한 예는 "그", "그녀" 또는 "그것"과 같은 문장의 대명사가 누구를 가리키거나 무엇을 가리키는지를 기계가 결정하는 방법이 없다는 "대명사 모호성 문제"로 알려져 있습니다.

- Moor, James H. (2001), "The Status and Future of the Turing Test", Minds and Machines, 11 (1): 77–93, doi:10.1023/A:1011218925467, ISSN 0924-6495, S2CID 35233851.

- Warwick, Kevin and Shah, Huma (2016), "튜링의 모방 게임:미지와의 대화", 캠브리지 대학 출판부.

외부 링크

- 튜링 테스트 – 줄리안 와그스태프의 오페라

- 컬리의 튜링 테스트

- 튜링 테스트 – 튜링 테스트가 실제로 얼마나 정확할 수 있을까요?

- Zalta, Edward N. (ed.). "The Turing test". Stanford Encyclopedia of Philosophy.

- 튜링 테스트: 50년 후, 2000년의 시점에서 튜링 테스트에 대한 반세기 동안의 연구를 검토합니다.

- 카포와 커즈와일 사이의 내기, 각자의 입장에 대한 구체적인 근거 포함.

- 튜링 테스트가 블레이 위트비에 의한 인공지능의 가장 큰 사각지대인 이유

- Jabberwacky.com 2005년 4월 11일 웨이백 머신에서 보관 인간으로부터 배우고 모방하는 인공지능 채터봇

- 기계지능에 관한 뉴욕타임즈 에세이 1부와 2부

- ""The first ever (restricted) Turing test", on season 2, episode 5". Scientific American Frontiers. Chedd-Angier Production Company. 1991–1992. PBS. Archived from the original on 1 January 2006.

- 컴퓨터 과학 튜링 시험을 위한 언플러그드 교수 활동

- 위키뉴스: "토크: 컴퓨터 전문가들이 A.L.I.C.E.의 10번째 생일을 축하합니다."