F-점수

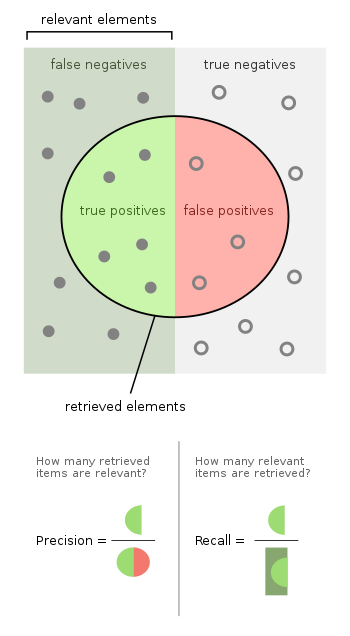

F-score이항분류에 대한 통계적 분석에서 F-점수 또는 F-measure는 시험의 정확도를 측정하는 척도다.시험의 정밀도와 회수로부터 계산하는데, 여기서 정밀도는 참 양성 결과의 수를 정확하게 식별되지 않은 결과를 포함한 모든 양성 결과의 수로 나눈 값이며, 리콜은 참 양성 결과의 수를 양성으로 식별했어야 하는 모든 표본의 수로 나눈 값이다.정밀도는 양의 예측값으로도 알려져 있으며, 리콜은 진단 이항 분류에서 민감도로도 알려져 있다.

F1 점수는 정밀도와 회수율의 조화 평균이다.보다 일반적인 점수는 추가 가중치를 적용하여 정밀도나 리콜을 다른 점수보다 높게 평가한다.

F-점수의 가능한 최고치는 1.0으로 완벽한 정밀도와 리콜을 나타내며, 정밀도나 리콜이 0일 경우 가능한 최저치는 0이다.F1 점수는 쇠렌센-디체 계수 또는 주사위 유사 계수(DSC)로도 알려져 있다.[citation needed]

어원

F-measure라는 이름은 제4차 메시지 이해 회의(MUC-4, 1992년)에 소개되었을 때 반 리즈베르겐의 저서에서 다른 F 함수를 따서 명명된 것으로 생각된다.[1]

정의

이 섹션은 검증을 위해 추가 인용구가 필요하다.(2018년 12월)(이과 시기 |

전통적인 F-측정 또는 균형 F-점수(F1 점수)는 정밀도와 회수율의 조화 평균이다.

- {}{{\ {tp}

Fβ

양의 실제 인자 β를 사용하는 보다 일반적인 F 인 F 은는) 정밀도만큼 중요한 β를 선택한다.

- .

유형 I 및 유형 II 오류의 측면에서 이는 다음과 같이 된다.

β에 일반적으로 사용되는 두 개의 값은 정밀도보다 높은 리콜 무게인 2와 정밀도보다 낮은 리콜 무게인 0.5이다.

F-measurement는 {\{\beta 정밀성만큼 중요한 β를 부착하는 사용자에 대해 검색의 효과를 측정"[2]하도록 도출되었다.반리즈베르겐의 실효성 측정에 근거한 것이다.

- = -(+ 1 - r)- 1 {}}{)^{-

이들의 관계는 = - E 이며, 서 + 2{\{1

진단 테스트

이는 리콜을 흔히 '감성'이라고 부르는 이항분류 분야와 관련이 있다.

| 예측조건 | 출처:[3][4][5][6][7][8][9][10] | ||||

| 총인구 = P + N | 양수(PP) | 음수(PN) | 정보 제공, BM(Bookmaker Information) = TPR + TNR − 1 | 유병 임계값(PT) =√TPR × FPR − FPR/TPR − FPR | |

| 양수(P) | 참 양성(TP), 때리다 | 거짓 음성(FN), II형 오류입니다, 아가씨 과소평가 | 참 양수율(TPR), 리콜, 민감도(SEN), 탐지 확률, 적중률, 검정력 = TP/P= 1 − FNR | 거짓 음률(FNR), 요금을 잘못 매기다 = FN/P= 1 − TPR | |

| 음수(N) | 거짓 양성(FP), I형 오류, 잘못된 경보, 과대평가 | True Negative(TN), 거절을 바로잡다 | 거짓 양성률(FPR), 거짓 경보, 낙오 확률 = FP/N= 1 − TNR | 참 음률(TNR), 특수성(SPC), 선택성 = TN/N= 1 − FPR | |

| 유병률 = P/P + N | 양의 예측 값(PPV), 정밀한 = TP/PP = 1 − FDR | 거짓누락률(FOR) = FN/PN= 1 − NPV | 양의 우도비(LR+) = TPR/FPR | 음우도비(LR-) = FNR/TNR | |

| 정확도(ACC) = TP + TN/P + N | FDR(False Discovery Rate) = FP/PP= 1 − PPV | 음의 예측 값(NPV) = TN/PN = 1 - FOR | 마크니스(MK), 델타P(Δp) = PPV + NPV − 1 | 진단 오즈비(DOR) = LR+/LR- | |

| 균형적 정확도(BA) = TPR + TNR/2 | F1 점수 = 2 PPV × TPR/PPV + TPR = 2 TP/2 TP + FP + FN | 팔크스-말라우스 지수(FM) = √PPV×TPR | MCC(Matthews 상관 계수) = √TPR×TNR×PPV×NPV − √FNR×FPR×FOR×FDR | 위협 점수(TS), 중요 성공 지수(CSI), 자카드 지수 = TP/TP + FN + FP | |

계층 불균형에 대한 F-점수의 의존성

윌리엄스는[11] 양성 대 음성 테스트 사례의 비율 r 에 대해 정밀 리콜 곡선의 명시적인 의존성을 보여 주었으며, 따라서 점을 얻었다.이것은 등급비율이 다른 다른 문제들에 대한 F-점수의 비교가 문제가 된다는 것을 의미한다.이 문제를 해결하는 한 가지 방법(예: Siblini et al, 2020[12] 참조)은 그러한 비교를 할 때 표준 등급 비율 을 사용하는 것이다.

적용들

F-점수는 검색, 문서 분류, 조회 분류 성능 측정에 정보 검색 분야에서 자주 사용된다.[13]초기 작품들은 주로 F1 점수에 초점을 맞췄지만, 대규모 검색엔진의 확산으로 성능 목표가 정밀도나[14] 리콜에 더 중점을 두도록 바뀌었고, F 은(는) 넓은 적용에서 볼 수 있다.

F-점수는 기계학습에도 사용된다.[15]그러나 F- 측정은 진정한 부정적인 점을 고려하지 않기 때문에 이항 분류기의 성능을 평가하기 위해 Matthews 상관 계수, Informentness 또는 Cohen의 카파 같은 측정을 선호할 수 있다.[16]

F-점수는 명명된 실체 인식 및 단어 세분화 평가와 [17]같이 자연어 처리 문헌에 널리 사용되어 왔다.

비판

데이비드 핸드 등은1 F 점수가 정밀도와 리콜에 동등한 중요성을 부여하기 때문에 널리 사용되는 것을 비판한다.실무에서 서로 다른 유형의 오분류는 다른 비용을 발생시킨다.정밀도와 리콜의 상대적 중요성이 문제의 한 측면인 셈이다.[18]

다비데 치코와 주세페 쥬르만에 따르면 F1 점수는 이진평가 분류에서 매튜스 상관 계수(MCC)보다 진실성이 떨어지고 정보성이 떨어진다.[19]

데이비드 파워스와 상관 카파 대책과-의, 별도의 multiclass 대책 정보 주장하지만 진정한 클래스와 진정한 클래스는 분급기 예측 예측 예측하는 예측 가능성 양쪽 방향을 평가하 대칭이 F1과 따라서 불균형한 수업에 오해의 소지가 있으며, TrueNegatives을 무시하다고 지적했다.r두 방향에 대한 mediumity와 Markness(중간도와 표시)의 기하학적 평균이 상관 관계라는 점에 유의하십시오.[20]

파울크스-말라우스 지수와의 차이

F-measure는 회수율과 정밀도의 조화 평균이지만, Fowlkes-Mallows 지수는 기하 평균이다.[21]

멀티클래스구분

F-점수는 2개 이상의 등급(멀티클라스 분류)의 분류 문제를 평가하는 데도 사용된다.이 설정에서 최종 점수는 마이크로 평균화(클래스 주파수 편중) 또는 매크로 평균화(모든 클래스를 동등하게 중요한 것으로 간주)로 얻는다.매크로 평균화의 경우, 신청자는 두 가지 공식을 사용했다: (산술) 등급별 정밀도 및 회수 평균의 F-점수 또는 등급별 F-점수의 산술 평균. 여기서 후자는 더 바람직한 특성을 보인다.[22]

참고 항목

참조

- ^ Sasaki, Y. (2007). "The truth of the F-measure" (PDF).

- ^ Van Rijsbergen, C. J. (1979). Information Retrieval (2nd ed.). Butterworth-Heinemann.

- ^ Fawcett, Tom (2006). "An Introduction to ROC Analysis" (PDF). Pattern Recognition Letters. 27 (8): 861–874. doi:10.1016/j.patrec.2005.10.010.

- ^ Piryonesi S. Madeh; El-Diraby Tamer E. (2020-03-01). "Data Analytics in Asset Management: Cost-Effective Prediction of the Pavement Condition Index". Journal of Infrastructure Systems. 26 (1): 04019036. doi:10.1061/(ASCE)IS.1943-555X.0000512.

- ^ Powers, David M. W. (2011). "Evaluation: From Precision, Recall and F-Measure to ROC, Informedness, Markedness & Correlation". Journal of Machine Learning Technologies. 2 (1): 37–63.

- ^ Ting, Kai Ming (2011). Sammut, Claude; Webb, Geoffrey I. (eds.). Encyclopedia of machine learning. Springer. doi:10.1007/978-0-387-30164-8. ISBN 978-0-387-30164-8.

- ^ Brooks, Harold; Brown, Barb; Ebert, Beth; Ferro, Chris; Jolliffe, Ian; Koh, Tieh-Yong; Roebber, Paul; Stephenson, David (2015-01-26). "WWRP/WGNE Joint Working Group on Forecast Verification Research". Collaboration for Australian Weather and Climate Research. World Meteorological Organisation. Retrieved 2019-07-17.

- ^ Chicco D, Jurman G (January 2020). "The advantages of the Matthews correlation coefficient (MCC) over F1 score and accuracy in binary classification evaluation". BMC Genomics. 21 (1): 6-1–6-13. doi:10.1186/s12864-019-6413-7. PMC 6941312. PMID 31898477.

- ^ Chicco D, Toetsch N, Jurman G (February 2021). "The Matthews correlation coefficient (MCC) is more reliable than balanced accuracy, bookmaker informedness, and markedness in two-class confusion matrix evaluation". BioData Mining. 14 (13): 1-22. doi:10.1186/s13040-021-00244-z. PMC 7863449. PMID 33541410.

- ^ Tharwat A. (August 2018). "Classification assessment methods". Applied Computing and Informatics. doi:10.1016/j.aci.2018.08.003.

- ^ Williams, Christopher K. I. (2021). "The Effect of Class Imbalance on Precision-Recall Curves". Neural Computation. 33 (4): 853–857. arXiv:2007.01905. doi:10.1162/neco_a_01362. PMID 33513323.

- ^ Siblini, W.; Fréry, J.; He-Guelton, L.; Oblé, F.; Wang, Y. Q. (2020). "Master your metrics with calibration". In M. Berthold; A. Feelders; G. Krempl (eds.). Advances in Intelligent Data Analysis XVIII. Springer. pp. 457–469. arXiv:1909.02827. doi:10.1007/978-3-030-44584-3_36.

- ^ Beitzel., Steven M. (2006). On Understanding and Classifying Web Queries (Ph.D. thesis). IIT. CiteSeerX 10.1.1.127.634.

- ^ X. Li; Y.-Y. Wang; A. Acero (July 2008). Learning query intent from regularized click graphs. Proceedings of the 31st SIGIR Conference. doi:10.1145/1390334.1390393. S2CID 8482989.

- ^ 참조, 예: [1]의 평가를 참조하십시오.

- ^ Powers, David M. W (2015). "What the F-measure doesn't measure". arXiv:1503.06410 [cs.IR].

- ^ Derczynski, L. (2016). Complementarity, F-score, and NLP Evaluation. Proceedings of the International Conference on Language Resources and Evaluation.

- ^ Hand, David. "A note on using the F-measure for evaluating record linkage algorithms - Dimensions". app.dimensions.ai. doi:10.1007/s11222-017-9746-6. hdl:10044/1/46235. S2CID 38782128. Retrieved 2018-12-08.

- ^ Chicco D, Jurman G (January 2020). "The advantages of the Matthews correlation coefficient (MCC) over F1 score and accuracy in binary classification evaluation". BMC Genomics. 21 (6): 6. doi:10.1186/s12864-019-6413-7. PMC 6941312. PMID 31898477.

- ^ Powers, David M W (2011). "Evaluation: From Precision, Recall and F-Score to ROC, Informedness, Markedness & Correlation". Journal of Machine Learning Technologies. 2 (1): 37–63. hdl:2328/27165.

- ^ Tharwat A (August 2018). "Classification assessment methods". Applied Computing and Informatics. 17 (ahead-of-print): 168–192. doi:10.1016/j.aci.2018.08.003.

- ^ J. Opitz; S. Burst (2019). "Macro F1 and Macro F1". arXiv:1911.03347 [stat.ML].

,

,