정밀도 및 회수

Precision and recall패턴 인식, 정보 검색, 객체 검출 및 분류(기계 학습), 정밀도 및 호출은 수집, 말뭉치 또는 샘플 공간에서 검색된 데이터에 적용되는 성능 지표입니다.

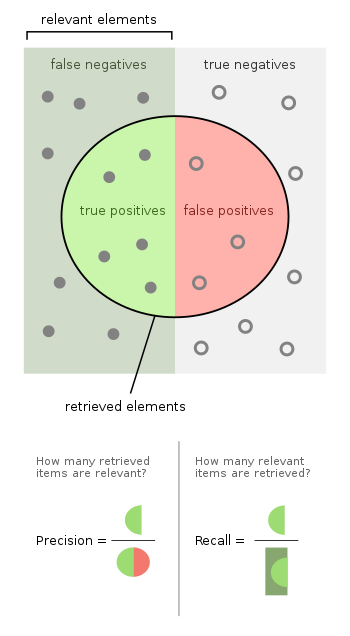

정밀도(양수 예측값이라고도 함)는 검색된 인스턴스 중 관련 인스턴스의 비율이며, 리콜(감도라고도 함)은 검색된 관련 인스턴스의 비율입니다.따라서 정밀도와 리콜은 모두 관련성에 기초한다.

디지털 사진에서 개(관련 요소)를 인식하기 위한 컴퓨터 프로그램을 고려합니다.10마리의 고양이와 12마리의 개가 포함된 사진을 처리하면, 이 프로그램은 8마리의 개를 식별한다.개로 식별된 8가지 요소 중 5가지만이 실제로 개이고, 나머지 3가지 요소는 고양이이다.7마리의 개가 누락되었고(허위 부정), 7마리의 고양이가 올바르게 제외되었다(진정한 부정).프로그램의 정밀도는 5/8(진정한 긍정/선택된 요소)이며, 리콜은 5/12(진정한 긍정/관련 요소)입니다.

검색 엔진이 30페이지(관련된 페이지 20페이지)를 반환하고 40페이지(관련된 페이지 40페이지)를 반환하지 못했을 때 정밀도는 20/30 = 2/3이며, 리콜은 20/60 = 1/3로 결과가 얼마나 완성되었는지 알 수 있습니다.

통계에서 가설 테스트 접근방식을 채택하는 경우, 이 경우 귀무 가설은 개가 아니라 개가 아니라 완전한 정밀도, 유형 I 및 유형 II 오류의 부재(즉, 각각 100%의 완벽한 특이성과 민감도)와 완벽한 회수(잘못된 음성 없음)에 각각 해당된다..

보다 일반적으로, 리콜은 단순히 타입 II 오류율을 보완하는 것이다. 즉, 타입 II 오류율을 1에서 뺀 것이다.정밀도는 유형 I 오류율과 관련이 있지만, 관련 항목과 관련 없는 항목을 확인하는 사전 분포에 따라 달라지기 때문에 약간 더 복잡합니다.

위의 고양이와 개의 예에는 타입 I 오류율이 3/8인 경우 8 - 5 = 3 타입 I 오류가 포함되었고 타입 II 오류율이 7/12인 경우 12 - 5 = 7 타입 II 오류가 포함되었습니다.정밀도는 품질의 척도로 볼 수 있고, 리콜은 양의 척도로 볼 수량의 척도로 볼 수 있습니다.정밀도가 높으면 알고리즘이 관련 없는 결과보다 더 많은 관련 결과를 반환하고, 리콜이 높으면 알고리즘이 관련 결과의 대부분을 반환하는 것을 의미합니다(관련되지 않은 결과도 반환되는지 여부).

서론

정보 검색에서 인스턴스는 문서이며 검색어가 지정된 관련 문서 세트를 반환하는 작업이 있습니다.리콜은 검색을 통해 검색된 관련 문서의 수를 기존 관련 문서의 총 수로 나눈 것이며 정밀도는 검색을 통해 검색된 관련 문서의 수를 해당 검색에 의해 검색된 문서의 총 수로 나눈 것입니다.

분류 작업에서 클래스의 정밀도는 참 긍정의 수(즉, 양의 클래스에 속하는 것으로 올바르게 라벨링된 항목의 수)를 양의 클래스에 속하는 것으로 라벨링된 요소의 총 수(즉, 참 긍정과 거짓 긍정의 합계)로 나눈 값이다.g)을 클릭합니다.이 문맥에서 리콜은 실제 양의 클래스에 속하는 요소의 총 수로 나눈 참 양의 수로 정의된다(즉, 참 양의 수와 거짓 음의 합계는 양의 클래스에 속한다고 라벨링되지 않았지만 그래야만 했던 항목이다).

정보 검색에서 1.0의 완전 정밀도는 검색에 의해 검색된 모든 결과가 관련이 있음을 의미하며 1.0의 완전 리콜 점수는 검색에 의해 검색된 모든 관련 문서를 의미합니다(그러나 관련 없는 문서가 얼마나 많은지는 알 수 없음).lso를 취득했습니다).

정밀도와 리콜은 단독으로 사용할 때 특별히 유용한 지표가 아니다.예를 들어, 모든 항목을 검색하는 것만으로 완벽한 기억을 할 수 있습니다.마찬가지로 매우 가능성이 높은 항목을 극소수만 선택하면 거의 완벽한 정밀도를 얻을 수 있습니다.

분류 작업에서 클래스 C의 정밀도 점수가 1.0이면 클래스 C에 속하는 것으로 표시된 모든 항목이 실제로 클래스 C에 속한다는 것을 의미한다(그러나 올바르게 라벨이 부착되지 않은 클래스 C의 항목 수에 대해서는 아무 말도 하지 않음). 반면 1.0의 리콜은 클래스 C의 모든 항목이 클래스 C에 속하는 것으로 표시되었음을 의미한다(그러나 클래스 C의 모든 항목이 클래스 C에 속한다는 것은 아니다).다른 세분류에 속하는 항목 중 얼마나 많은 항목도 C)에 속하는 것으로 잘못 표기되었는지에 대한 힌지.

종종 정밀도와 리콜 사이에는 역관계가 존재하며, 이 경우 하나를 증가시켜 다른 하나를 감소시킬 수 있습니다.뇌수술은 트레이드오프의 실례를 제공한다.뇌외과 의사가 환자의 뇌에서 암종양을 제거하는 것을 생각해보자.남아있는 암세포는 종양을 재생시키기 때문에 의사는 모든 종양세포를 제거할 필요가 있다.반대로, 외과의사는 건강한 뇌세포를 제거해서는 안 된다. 왜냐하면 그것은 환자를 뇌 기능에 장애를 남기기 때문이다.그 외과의사는 그가 모든 암세포를 확실하게 추출하기 위해 그가 제거하는 뇌의 부위에서 더 자유로울 수 있다.이 결정은 리콜을 증가시키지만 정밀도는 감소시킵니다.반면에, 외과의사는 암세포만을 추출하기 위해 그가 제거하는 뇌세포에서 더 보수적일 수 있다.이 결정은 정밀도는 높지만 리콜은 감소합니다.즉, 회수율이 높을수록 건강한 세포를 제거할 가능성이 높아지고(음성 결과), 모든 암세포를 제거할 가능성이 높아진다(양성 결과).정밀도가 높으면 건강한 세포를 제거할 가능성이 감소하지만(양성 결과), 모든 암세포를 제거할 가능성(음성 결과)도 감소합니다.

일반적으로 정밀도와 리콜 점수는 따로 논의되지 않는다.대신, 한 측정치에 대한 값 중 하나를 다른 측정치의 고정 수준(예: 0.75)에 대해 비교하거나 두 값을 모두 단일 측정치로 결합한다.정밀도와 호출의 조합인 측정의 예로는 F-측정(정밀과 호출의 가중 고조파 평균) 또는 기회 보정 변형의 기하 평균인 Matthews 상관 계수(DeltaP')와 Markness(DeltaP)[1][2]가 있다.정확도는 정밀도 및 역정밀(편향 가중치)의 가중 산술 평균일 뿐 아니라 호출 및 역정밀(유병률 [1]가중치)의 가중 산술 평균입니다.역 정밀도 및 역호출은 단순히 양의 레이블과 음의 레이블이 교환되는 역 문제의 정밀도 및 호출입니다(실제 클래스와 예측 레이블 모두에 해당).호출과 역호출, 또는 동등한 양의 비율과 거짓 양의 비율은 ROC 곡선으로 서로에 대해 자주 플롯되며 작동 지점 트레이드오프를 탐색하기 위한 원칙적인 메커니즘을 제공합니다.정보 검색 외에서는, 리콜, 정밀도, F 측정의 적용은 분할표의 진정한 음의 셀을 무시하기 때문에 결함이 있다고 주장되고 있으며,[1] 예측의 편중화를 통해 쉽게 조작된다.첫 번째 문제는 Accuracy를 사용하여 '해결'되고 두 번째 문제는 기회 구성요소를 할인하여 Cohen의 Kappa로 재규격화함으로써 '해결'되지만, 이는 더 이상 그래픽으로 트레이드오프를 탐구할 기회를 제공하지 못합니다.그러나 정보성 및 표시성은 리콜 [3]및 정밀도의 카파 유사 재정규화이며, 기하 평균 매튜스 상관 계수는 디디베이션된 F-척도와 같이 작용한다.

정의(정보 검색 컨텍스트)

정보 검색 컨텍스트에서 정밀도 및 호출은 검색된 문서 세트(예를 들어 쿼리를 위한 웹 검색 엔진에 의해 생성된 문서 리스트) 및 관련 문서 세트(예를 들어 특정 토픽과 관련된 인터넷 상의 모든 문서 리스트), [4]관련성 측면에서 정의된다.

정확

정보 검색 분야에서 정밀도는 조회와 관련된 검색된 문서의 비율입니다.

예를 들어, 문서 집합의 텍스트 검색에서 정밀도는 올바른 결과 수를 반환된 모든 결과 수로 나눈 값입니다.

Precision은 검색된 모든 문서를 고려하지만 시스템에서 반환되는 최상위 결과만 고려하여 지정된 컷오프 순위에서 평가할 수도 있습니다.이 측정값을 n 또는 P@n에서의 정밀도라고 합니다.

정밀도는 검색에서 반환되는 모든 관련 문서의 백분율인 리콜과 함께 사용됩니다.시스템에 대한 단일 측정을 제공하기 위해 F 점수(또는 f-measure)에서1 두 측정이 함께 사용되는 경우가 있습니다.

정보검색 분야에서 '정밀'의 의미와 용도는 과학기술의 다른 분야에서의 정확도 및 정밀도의 정의와 다르다.

리콜

정보 검색에서 리콜은 성공적으로 검색된 관련 문서의 비율입니다.

예를 들어, 문서 집합의 텍스트 검색의 경우 리콜은 올바른 결과 수를 반환해야 하는 결과 수로 나눈 값입니다.

이항 분류에서 호출은 감도라고 합니다.조회에 의해 관련 문서가 검색될 확률로 볼 수 있습니다.

쿼리에 대한 응답으로 모든 문서를 반환하여 100% 리콜을 달성하는 것은 간단한 일입니다.따라서 리콜만으로는 충분하지 않습니다.예를 들어 정밀도를 계산하여 관련 없는 문서의 수도 측정해야 합니다.

정의(분류 컨텍스트)

분류 태스크의 경우 true positive, true negative, false positive 및 false negative(정의는 유형 I 및 유형 II 오류 참조)라는 용어는 테스트 대상 분류기의 결과를 신뢰할 수 있는 외부 판단과 비교합니다.양수 및 음수라는 용어는 분류자의 예측(예상치라고도 함)을 나타내며 참 및 거짓이라는 용어는 해당 예측이 외부 판단(예상치라고도 함)에 해당하는지 여부를 나타냅니다.

어떤 조건에서 P 양의 경우와 N 개의 음의 경우로부터 실험을 정의해 봅시다.4가지 결과는 다음과 같이 2×2 분할표 또는 혼란 행렬로 공식화할 수 있다.

| 예측 상태 | 출처:[5][6][7][8][9][10][11][12][13] | ||||

| 총인구 = P + N | 긍정(PP) | 네거티브(PN) | 정보성, 장부 제작자 정보성(BM) = TPR + TNR - 1 | 유병률 임계값(PT) = × - - displaystyle {\ | |

| 플러스(P) | True Positive (TP; 참, 때리다 | False Negative(FN; 거짓 음성), 타입 II 오류입니다. 과소 평가 | True Positive Rate(TPR), 리콜, 감도(SEN), 검출 확률, 적중률, 전력 =TP/P= 1 - FNR | False Negative Rate(FNR; 거짓 네거티브레이트), 미스 레이트 = FN/P= 1 - TPR | |

| 네거티브(N | False Positive(FP; 거짓 긍정), 유형 I 오류, 잘못된 경보, 과대 평가 | True Negative(TN; 트루 네거티브), 정정 거부 | False Positive Rate(FPR; 거짓 양수율), 허위 경보 발생 확률, 탈락 = FP/N= 1 - TNR | True Negative Rate(TNR; 참 마이너스 레이트), 특이성(SPC), 선택성 = TN/N= 1 - FPR | |

| 유병률 = P/P + N | 양의 예측값(PPV), 정확 = TP/PP = 1 - FDR | 허위누락률(FOR) = FN/PN= 1 - NPV | 양의 우도비(LR+) = TPR/FPR | 음우도비(LR-) = FNR/TNR | |

| 정확도(ACC) = TP + TN/P + N | FDR(False Discovery Rate) = FP/PP= 1 - PPV | 음의 예측값(NPV) = TN/PN = 1 - FOR | 마크니스(MK), 델타P(δP) = PPV + NPV - 1 | 진단 승산비(DOR) = LR+/LR- | |

| 균형 정확도(BA) = TPR + TNR/2 | F1 스코어 = PPV × TPR/PPV + TPR = TP/2 TP + FP + FN | Fowlkes – Mallows 색인(FM) = × \ | Matthews 상관 계수(MCC) = × × ×\ \scriptstyle \{\ ×× {\ | 위협 점수(TS), 중요 성공 지수(CSI), 자카드 지수 = TP/TP + FN + FP | |

출처:포싯(2006년),[14] 피료네시와 엘-디라비(2020년),[15] 파워스([16]2011년), [17]팅(2011년), CAWCR,[18] D. 치코&G. 주르만(2020년,[19][20] 2021년), 타르와트(2018년).[21]발라일라 (2020)[22] |

정밀도 및 호출은 다음과 같이 [23]정의됩니다.

이 문맥에서 리콜은 진정한 양의 비율 또는 민감도라고도 하며, 정밀도는 양의 예측값(PPV)이라고도 한다. 분류에 사용된 다른 관련 척도는 진정한 음의 비율과 [23]정확성을 포함한다.진정한 음의 비율은 특이성이라고도 불립니다.

불균형 데이터

정확도는 불균형 데이터 세트에 대해 잘못된 메트릭이 될 수 있습니다.음수 값이 95개이고 양수 값이 5개인 표본을 고려합니다.이 경우 모든 값을 음수로 분류하면 0.95의 정확도 점수를 얻을 수 있습니다.이 문제를 겪지 않는 메트릭이 많이 있습니다.예를 들어, 균형 정확도(bACC[24])는 참 양의 예측과 참 음의 예측을 각각 양의 샘플 수와 음의 샘플 수로 정규화하고 합계를 두 개로 나눕니다.

이전 예제(95개의 음수 및 5개의 양수 표본)의 경우 모두 음수로 분류하면 0.5개의 균형 정확도 점수(최대 bACC 점수는 1개)가 제공되며, 이는 균형 데이터 집합에서 랜덤 추측의 예상 값과 동일합니다.FN의 비용이 FP와 동일하다고 가정하면 데이터의 실제 라벨이 불균형인지 여부에 관계없이 균형 잡힌 정확도는 모델의 전체적인 성능 메트릭으로 작용할 수 있습니다.

또 하나의 메트릭은 Predicted Positive Condition Rate(PPCR; 예측 포지티브컨디션 레이트)입니다.이것은, 플래그가 붙여진 총인구의 퍼센티지를 나타냅니다.예를 들어, 1,000,000개의 문서 중 30개의 결과(검색된 문서)를 반환하는 검색 엔진의 경우 PPCR은 0.003%입니다.

Saito와 Rehmsmeier에 따르면 불균형 데이터에 대한 이항 분류기를 평가할 때 정밀도-호출 그림이 ROC 그림보다 더 유용합니다.이러한 시나리오에서 ROC 플롯은 분류 [25]성능의 신뢰성에 대한 결론과 관련하여 시각적으로 기만적일 수 있다.

위의 접근법과 달리, 혼돈 매트릭스 요소에 가중치를 부여하여 불균형 스케일링을 직접 적용하는 경우, 표준 메트릭 정의는 불균형 데이터 [26]세트의 경우에도 여전히 적용됩니다.가중치 부여 절차는 혼돈 매트릭스 요소를 고려된 각 클래스의 지지 세트에 관련짓는다.

확률론적 해석

정밀도와 호출을 비율이 아닌 [27]확률 추정으로 해석할 수도 있습니다.

- 정밀도는 검색된 문서 풀에서 무작위로 선택된 문서가 관련될 수 있는 추정 확률입니다.

- 리콜은 관련 문서 풀에서 무작위로 선택된 문서가 검색될 추정 확률입니다.

또 다른 해석은 정밀도는 관련 검색의 평균 확률이고 리콜은 여러 검색 쿼리에 걸쳐 전체 검색의 평균 확률이라는 것이다.

F-measure

정밀도와 호출을 결합한 척도는 정밀도와 호출의 조화 평균, 전통적인 F-측정 또는 균형 F-점수입니다.

이 척도는 두 숫자가 가까울 때의 대략적인 평균이며, 보다 일반적으로 두 숫자의 경우 기하 평균의 제곱을 산술 평균으로 나눈 것과 일치합니다.F 점수가 평가 지표로서의 [1]편향으로 인해 특정 상황에서 비판받을 수 있는 몇 가지 이유가 있다.호출과 정밀도의 가중치가 균등하기 때문에 1F_}) 도 합니다.

이는 인 FβF_{\ 측정의 특수한 경우β(\이다.

그 밖에 으로되는 F 스타일 F 척도는 스타일 }) 와 0.5( 스타일.5} 척도로, 리콜보다 정밀도를 중시한다.

F-척도는 van Rijsbergen(1979)이 도출한 것으로, 는 "정확도보다β(\를 더 중요하게 하는 사용자에 대한 검색 효과를 측정한다."반 리즈베르겐의 효과 1 - P + - R {\ } = {{\frac alpha {1-\frac {1-\에 기초한다.이들의 관계는 1 - α {\}=이며, 서 1+ 2{\= 1 + \ {1 + \displayfrac {2

목표로서의 제한

정보 검색 시스템의 성능 메트릭에는 ROC 곡선(AUC)[28] 아래 영역과 같은 다른 매개변수 및 전략이 있습니다.

「 」를 참조해 주세요.

레퍼런스

- ^ a b c d Powers, David M W (2011). "Evaluation: From Precision, Recall and F-Measure to ROC, Informedness, Markedness & Correlation" (PDF). Journal of Machine Learning Technologies. 2 (1): 37–63. Archived from the original (PDF) on 2019-11-14.

- ^ Perruchet, P.; Peereman, R. (2004). "The exploitation of distributional information in syllable processing". J. Neurolinguistics. 17 (2–3): 97–119. doi:10.1016/s0911-6044(03)00059-9. S2CID 17104364.

- ^ Powers, David M. W. (2012). "The Problem with Kappa". Conference of the European Chapter of the Association for Computational Linguistics (EACL2012) Joint ROBUS-UNSUP Workshop.

- ^ * Kent, Allen; Berry, Madeline M.; Luehrs, Jr., Fred U.; Perry, J.W. (1955). "Machine literature searching VIII. Operational criteria for designing information retrieval systems". American Documentation. 6 (2): 93. doi:10.1002/asi.5090060209.

- ^ Balayla, Jacques (2020). "Prevalence threshold (ϕe) and the geometry of screening curves". PLoS One. 15 (10). doi:10.1371/journal.pone.0240215.

- ^ Fawcett, Tom (2006). "An Introduction to ROC Analysis" (PDF). Pattern Recognition Letters. 27 (8): 861–874. doi:10.1016/j.patrec.2005.10.010.

- ^ Piryonesi S. Madeh; El-Diraby Tamer E. (2020-03-01). "Data Analytics in Asset Management: Cost-Effective Prediction of the Pavement Condition Index". Journal of Infrastructure Systems. 26 (1): 04019036. doi:10.1061/(ASCE)IS.1943-555X.0000512.

- ^ Powers, David M. W. (2011). "Evaluation: From Precision, Recall and F-Measure to ROC, Informedness, Markedness & Correlation". Journal of Machine Learning Technologies. 2 (1): 37–63.

- ^ Ting, Kai Ming (2011). Sammut, Claude; Webb, Geoffrey I. (eds.). Encyclopedia of machine learning. Springer. doi:10.1007/978-0-387-30164-8. ISBN 978-0-387-30164-8.

- ^ Brooks, Harold; Brown, Barb; Ebert, Beth; Ferro, Chris; Jolliffe, Ian; Koh, Tieh-Yong; Roebber, Paul; Stephenson, David (2015-01-26). "WWRP/WGNE Joint Working Group on Forecast Verification Research". Collaboration for Australian Weather and Climate Research. World Meteorological Organisation. Retrieved 2019-07-17.

- ^ Chicco D, Jurman G (January 2020). "The advantages of the Matthews correlation coefficient (MCC) over F1 score and accuracy in binary classification evaluation". BMC Genomics. 21 (1): 6-1–6-13. doi:10.1186/s12864-019-6413-7. PMC 6941312. PMID 31898477.

- ^ Chicco D, Toetsch N, Jurman G (February 2021). "The Matthews correlation coefficient (MCC) is more reliable than balanced accuracy, bookmaker informedness, and markedness in two-class confusion matrix evaluation". BioData Mining. 14 (13): 1-22. doi:10.1186/s13040-021-00244-z. PMC 7863449. PMID 33541410.

- ^ Tharwat A. (August 2018). "Classification assessment methods". Applied Computing and Informatics. doi:10.1016/j.aci.2018.08.003.

- ^ Fawcett, Tom (2006). "An Introduction to ROC Analysis" (PDF). Pattern Recognition Letters. 27 (8): 861–874. doi:10.1016/j.patrec.2005.10.010.

- ^ Piryonesi S. Madeh; El-Diraby Tamer E. (2020-03-01). "Data Analytics in Asset Management: Cost-Effective Prediction of the Pavement Condition Index". Journal of Infrastructure Systems. 26 (1): 04019036. doi:10.1061/(ASCE)IS.1943-555X.0000512.

- ^ Powers, David M. W. (2011). "Evaluation: From Precision, Recall and F-Measure to ROC, Informedness, Markedness & Correlation". Journal of Machine Learning Technologies. 2 (1): 37–63.

- ^ Ting, Kai Ming (2011). Sammut, Claude; Webb, Geoffrey I. (eds.). Encyclopedia of machine learning. Springer. doi:10.1007/978-0-387-30164-8. ISBN 978-0-387-30164-8.

- ^ Brooks, Harold; Brown, Barb; Ebert, Beth; Ferro, Chris; Jolliffe, Ian; Koh, Tieh-Yong; Roebber, Paul; Stephenson, David (2015-01-26). "WWRP/WGNE Joint Working Group on Forecast Verification Research". Collaboration for Australian Weather and Climate Research. World Meteorological Organisation. Retrieved 2019-07-17.

- ^ Chicco D.; Jurman G. (January 2020). "The advantages of the Matthews correlation coefficient (MCC) over F1 score and accuracy in binary classification evaluation". BMC Genomics. 21 (1): 6-1–6-13. doi:10.1186/s12864-019-6413-7. PMC 6941312. PMID 31898477.

- ^ Chicco D.; Toetsch N.; Jurman G. (February 2021). "The Matthews correlation coefficient (MCC) is more reliable than balanced accuracy, bookmaker informedness, and markedness in two-class confusion matrix evaluation". BioData Mining. 14 (13): 1-22. doi:10.1186/s13040-021-00244-z. PMC 7863449. PMID 33541410.

- ^ Tharwat A. (August 2018). "Classification assessment methods". Applied Computing and Informatics. doi:10.1016/j.aci.2018.08.003.

- ^ Balayla, Jacques (2020). "Prevalence threshold (ϕe) and the geometry of screening curves". PLoS One. 15 (10). doi:10.1371/journal.pone.0240215.

- ^ a b Olson, David L. 및 Delen, Dursun(2008)고급 데이터 마이닝 기술, Springer, 제1호(2008년 2월 1일), 138페이지, ISBN 3-540-76916-1

- ^ Mower, Jeffrey P. (2005-04-12). "PREP-Mt: predictive RNA editor for plant mitochondrial genes". BMC Bioinformatics. 6: 96. doi:10.1186/1471-2105-6-96. ISSN 1471-2105. PMC 1087475. PMID 15826309.

- ^ Saito, Takaya; Rehmsmeier, Marc (2015-03-04). Brock, Guy (ed.). "The Precision-Recall Plot Is More Informative than the ROC Plot When Evaluating Binary Classifiers on Imbalanced Datasets". PLOS ONE. 10 (3): e0118432. Bibcode:2015PLoSO..1018432S. doi:10.1371/journal.pone.0118432. ISSN 1932-6203. PMC 4349800. PMID 25738806.

- Suzanne Ekelund (March 2017). "Precision-recall curves – what are they and how are they used?". Acute Care Testing.

- ^ Tripicchio, Paolo; Camacho-Gonzalez, Gerardo; D'Avella, Salvatore (2020). "Welding defect detection: coping with artifacts in the production line". The International Journal of Advanced Manufacturing Technology. 111 (5): 1659–1669. doi:10.1007/s00170-020-06146-4. S2CID 225136860.

- ^ Fatih Cakir, Kun He, Xide Xia, Brian Kulis, Stan Sclaroff, Deep Metric Learning to Ranking, In Proc.IEEE 컴퓨터 비전 및 패턴 인식 회의(CVPR), 2019.

- ^ Zygmunt Zajcc.AUC에 대해 알고 싶었던 것http://fastml.com/what-you-wanted-to-know-about-auc/

- Baeza-Yates, Ricardo, Ribeiro-Neto, Bertier(1999년).현대 정보 검색.뉴욕, 뉴욕: ACM Press, Adison-Wesley, Seiten 75 ff.ISBN 0-201-39829-X

- Hjörland, Birger (2010);관련 개념의 기초, 미국정보과학기술학회 저널, 61(2), 217-237

- Makhoul, John; Kubala, Francis; Schwartz, Richard; Weischedel, Ralph; 1999; 정보 추출을 위한 퍼포먼스 측정, 1999년 2월 VA Herndon, DARPA Broadcast News Workshop에서의 진행

- Van Rijbergen, Cornelis Joost "Keith"(1979년)정보검색, 런던, GB; 보스턴, 매사추세츠: 버터워스, 제2판, ISBN 0-408-70929-4

,

,