비디오 게임에서의 머신러닝

Machine learning in video games비디오 게임에서는 비플레이어 캐릭터(NPC) 제어부터 절차적 콘텐츠 생성(PCG)까지 다양한 인공지능 기법이 다양하게 활용되고 있다.머신러닝(machine learning)은 특정 프로그래밍 없이 기계가 작동하도록 하기 위해 알고리즘과 통계적 모델을 사용하는 데 초점을 맞춘 인공지능의 하위 집합체다.검색 나무나 전문가 시스템 등 기존 인공지능 방식과는 확연히 대비된다.

게임 분야의 머신러닝 기법에 대한 정보는 대부분의 게임 회사들이 그들의 지적 재산에 대한 구체적인 정보를 발표하지 않기로 선택하기 때문에 대부분 연구 프로젝트를 통해 대중에게 알려져 있다.게임에서 가장 널리 알려진 머신러닝의 적용은 복잡한 전략 게임에서 전문 인간 플레이어와 경쟁하는 딥러닝 에이전트의 사용일 가능성이 높다.아타리/ALE, 둠, 마인크래프트, 스타크래프트, 카레이싱 등 게임에서 머신러닝의 응용이 상당했다.[1]체스나 바둑과 같이 원래 비디오 게임으로 존재하지 않았던 다른 게임들도 머신러닝의 영향을 받았다.[2]

관련 기계 학습 기법의 개요

심오한 학문

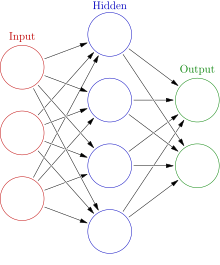

딥러닝은 복잡한 과제를 해결하는 법을 배우는 인공신경망(ANN) 활용에 집중하는 머신러닝의 서브셋이다.딥러닝은 입력에서 정보를 점진적으로 추출하기 위해 ANN과 기타 기법의 여러 레이어를 사용한다.이러한 복잡한 계층화 접근법 때문에 딥러닝 모델은 종종 훈련하고 계속 실행하기 위한 강력한 기계가 필요하다.

콘볼루션 신경망

콘볼루션 신경 네트워크(CNN)는 영상 데이터를 분석하는 데 자주 사용되는 특수 ANN이다.이러한 유형의 네트워크는 위치에 의존하지 않는 패턴인 번역 불변형 패턴을 학습할 수 있다.CNN은 이러한 패턴을 계층 구조로 학습할 수 있는데, 이는 이전의 경련 계층이 작은 지역 패턴을 학습하는 반면, 후기 계층은 이전 패턴에 기반한 더 큰 패턴을 학습한다는 것을 의미한다.[3]시각 데이터를 학습하는 CNN의 능력은 그것을 게임에서 딥러닝을 위한 흔히 사용되는 도구로 만들었다.[4][5]

재발 신경망

재발 신경망은 데이터의 시퀀스를 한 번에 처리하는 것이 아니라 한 번에 한 부분씩 순서대로 처리하도록 설계된 ANN의 일종이다.RNN은 출력을 생성하기 위해 현재 시퀀스 부분과 이전 시퀀스 부분의 메모리를 함께 사용하여 시퀀스의 각 부분에 걸쳐 실행된다.이러한 유형의 ANN은 언어 인식 및 시간적 순서에 크게 의존하는 기타 문제와 같은 작업에 매우 효과적이다.내부 구성이 다른 RNN에는 몇 가지 유형이 있다. 기본 구현은 소멸하는 구배 문제로 인해 장기 메모리 부족으로 어려움을 겪기 때문에 새로운 구현에서는 거의 사용되지 않는다.[3]

장단기억기

장기단기억장치(LSTM) 네트워크는 단순한 RNN에서 볼 수 있는 소멸 구배 문제를 다루도록 설계된 RNN의 구체적인 구현으로, 현재 부품의 출력을 계산할 때 입력된 시퀀스의 이전 부분에 대해 점차 "잊어버릴" 수 있다.LSTMs는 장기 데이터를 추적하기 위해 추가 입출력 장치를 사용하는 정교한 시스템을 추가함으로써 이 문제를 해결한다.[3]LSTM은 다양한 분야에서 매우 강력한 성과를 거두고 있으며, 몇몇 기념비적인 딥러닝 요원들에 의해 게임에서 사용되었다.[6][4]

강화학습

강화 학습은 보상 및/또는 처벌을 사용하여 대리인을 교육하는 과정이다.에이전트에게 경기에서 이긴 것에 대한 긍정적인 보상을 주거나 패한 것에 대한 부정적인 보상을 주는 것과 같은, 에이전트가 보상받거나 벌을 받는 방법은 그 문제에 크게 좌우된다.강화학습은 머신러닝 분야에서 많이 사용되며 Q러닝, 정책검색, 딥큐네트웍스 등의 방법으로 볼 수 있다.게임과 로보틱스 분야에서 모두 강세를 보였다.[7]

신경진화

신경 진화는 신경망과 진화 알고리즘의 사용을 포함한다.신경진화 모델은 대부분의 신경망처럼 구배 강하를 사용하는 대신에 진화 알고리즘을 사용하여 네트워크의 뉴런을 업데이트한다.연구자들은 이 과정이 국소적 최소치에서 고착될 가능성이 적고 잠재적으로 예술 딥러닝 기법의 상태보다 빠를 수 있다고 주장한다.[8]

딥러닝 에이전트

머신러닝(machine learning) 에이전트는 설계 게임 플레이의 일환으로 비디오 게임에 의도적으로 첨가되는 NPC의 기능보다는 인간 플레이어를 대신하는 데 이용되어 왔다.딥러닝 요원들은 인간과 다른 인공지능 요원과 경쟁할 때 인상적인 결과를 얻었다.[2][9]

체스

체스는 턴 기반 전략 게임으로 보드 공간의 계산 복잡성 때문에 어려운 AI 문제로 꼽힌다.비슷한 전략 게임은 종종 미니맥스 트리 검색의 어떤 형태로든 해결된다.ax Tree Search)로 해결된다.이런 유형의 AI 요원들은 1997년 딥 블루 대 가리 카스파로프 경기와 같은 프로 인간 선수들을 물리친 것으로 알려져 있다.이후 머신러닝(machine learning) 요원들이 기존 AI 요원들보다 더 큰 성공을 거뒀다.

가다

바둑은 체스보다 훨씬 더 어려운 AI 문제로 꼽히는 또 다른 턴 기반 전략 게임이다.바둑의 주 공간은 체스의 10^120 보드 주들에 비해 10^170 가능한 보드 주이다.최근 딥러닝 모델 이전에 인공지능 바둑 요원들은 인간 아마추어 수준의 플레이밖에 할 수 없었다.[5]

알파고

구글의 2015년 알파고는 인공지능(AI) 요원이 바둑 프로선수를 제친 첫 사례였다.[5]알파고는 딥러닝 모델을 사용하여 몬테카를로 나무 탐색(MCTS)의 무게를 훈련시켰다.딥러닝 모델은 2 ANN, 상대방에 의한 잠재적 움직임의 가능성을 예측하는 정책 네트워크, 주어진 상태의 승리 가능성을 예측하는 가치 네트워크로 구성되었다.딥러닝 모델은 에이전트가 바닐라 MCTS보다 더 효율적으로 잠재적인 게임 상태를 탐색할 수 있게 해준다.이 네트워크는 처음에는 인간 플레이어의 게임에 대해 훈련되었고, 그 다음에는 자신과의 게임에 의해 더 훈련되었다.

알파고 제로

알파고의 또 다른 구현인 알파고 제로(AlphaGo Zero)는 자신과의 플레이를 통해 온전히 훈련할 수 있었다.이전 에이전트의 역량에 맞춰 빠르게 훈련할 수 있었다.[10]

스타크래프트 시리즈

스타크래프트와 후속작 스타크래프트2는 AI 연구의 인기 환경이 된 실시간 전략(RTS) 비디오 게임이다.블리자드와 딥마인드는 AI 연구가 이뤄질 수 있는 공공 스타크래프트2 환경을 출시하기 위해 협력했다.[11]비록 대부분의 에이전트들이 속임수가 가능하거나 게임에서 숙련된 플레이어로 디폴트 AI를 능가하는 데 어려움을 겪지만, 두 게임 모두에서 다양한 딥러닝 방법이 테스트되었다.[1]

알파스타

알파스타는 AI 에이전트가 프로 스타크래프트2 선수를 인게임 장점 없이 제친 첫 번째였다.에이전트의 딥러닝 네트워크는 처음에는 단순화된 줌아웃 버전의 게이미티로부터 입력을 받았으나, 나중에 다른 인간 플레이어와 같이 카메라를 사용하여 플레이하도록 업데이트되었다.개발자들은 모델의 코드나 아키텍처를 공개하지는 않았지만 관계형 딥보강 학습, 장기간의 기억력, 자동억제적 정책 헤드, 포인터 네트워크, 중앙집중적 가치 기준 등 여러 가지 아트 머신 학습 기법의 상태를 나열했다.[4]알파스타는 처음에 감독된 학습으로 훈련을 받았고, 기본적인 전략을 배우기 위해 많은 인간 게임의 재생을 보았다.그리고 나서 그것은 다른 버전의 자신에 대해 훈련되었고 강화 학습을 통해 향상되었다.최종 버전은 매우 성공적이었지만, 단지 프로토스 미러 매치업에서 특정 지도에서 플레이하도록 훈련되었다.

도타2길

도타2는 멀티플레이어 온라인 배틀 아레나(MOBA) 게임이다.기존 AI 요원들은 다른 복잡한 게임과 마찬가지로 전문 휴먼 플레이어와 같은 수준으로 경쟁할 수 없었다.도타2에서 시도된 AI 에이전트 관련 정보는 유일하게 공개돼 있다.인공지능의 딥러닝 파이브 요원

오픈AI 파이브

OpenAI Five는 각각의 영웅을 배우기 위해 별도의 LSTM 네트워크를 활용했다.GPU 256개와 CPU 코어 128,000개가 포함된 시스템에서 실행되는 Proximal Policy Learning으로 알려진 강화 학습 기법을 사용하여 교육했다.[6]5명이 몇 달 동안 훈련해 매일 180여 년간의 경기 경험을 쌓은 뒤 프로 선수들과 맞대결을 벌였다.[12][13]결국 2019년 시리즈에서 2018 도타2 e스포츠 챔피언 팀을 꺾을 수 있었다.

행성 섬멸

플래니터리 전멸은 대규모 전쟁에 초점을 맞춘 실시간 전략 게임이다.개발자들은 그들의 기본 AI 에이전트에 ANN을 사용한다.[14]

슈프림 커맨더

슈프림 커맨더 2는 실시간 전략(RTS) 비디오 게임이다.이 게임은 MLP(Multilayer Perceptrons)를 사용하여 마주친 적 부대에 대한 소대의 반응을 제어한다.총 4개의 MLP가 사용되고 있으며, 각 소대 유형별로 1개씩 육해공 폭격기 전투기가 사용된다.[15]

일반화 게임

한 게임 이상의 게임을 할 수 있는 머신러닝 에이전트를 만들려는 시도가 있었다.이러한 "일반" 게임 에이전트는 그들 사이의 공유된 속성을 바탕으로 게임을 이해하도록 훈련된다.

알파제로

알파제로(AlphaZero)는 쇼기, 체스, 바둑을 둘 수 있는 알파고제로의 변형판이다.변형된 에이전트는 게임의 기본 규칙만 가지고 시작하며, 또한 전적으로 자기 학습을 통해 훈련되기도 한다.딥마인드는 이 일반화 에이전트가 바둑의 이전 버전뿐만 아니라 나머지 두 게임에서 상위 에이전트들과 경쟁할 수 있도록 훈련시킬 수 있었다.[2]

딥러닝 요원의 장단점

머신러닝 에이전트는 많은 게임 디자인 코스에서 다루지 않는 경우가 많다.이전 게임에서 머신러닝 에이전트를 사용한 것은 2015년판 알파고에서도 수백 대의 CPU와 GPU가 투입돼 강력한 수준으로 훈련했기 때문에 그다지 실용적이지 않았을 수 있다.[2]이것은 잠재적으로 매우 효과적인 딥러닝 요원의 창설을 대기업이나 극히 부유한 개인들로 제한한다.신경망 기반 접근법의 광범위한 훈련 시간은 또한 이러한 강력한 기계에 몇 주가 걸릴 수 있다.[4]

ANN 기반 모델을 효과적으로 훈련시키는 문제는 강력한 하드웨어 환경을 넘어선다; 데이터를 표현하고 그로부터 의미 있는 것들을 배울 수 있는 좋은 방법을 찾는 것 또한 종종 어려운 문제다.ANN 모델은 종종 매우 특정한 데이터에 과도하게 적합하고 더 일반화된 사례에서 낮은 성능을 발휘한다.알파스타는 프로 선수들을 꺾을 수 있음에도 불구하고 미러 프로토스 매치업을 할 때 한 지도에서만 할 수 있다는 약점을 보여준다.[4]오픈AI 파이브도 이런 약점을 보여주고 있는데, 전체 경기 중 극히 제한된 히어로풀에 맞닥뜨려야 프로 선수를 이길 수 있었다.[13]이 사례는 딥러닝 에이전트가 보다 일반화된 상황에서 수행하도록 훈련하는 것이 얼마나 어려울 수 있는지를 보여준다.

머신러닝 에이전트는 다양한 게임에서 큰 성공을 거두었다.[12][2][4]하지만 너무 유능한 에이전트는 신인이나 캐주얼 선수들에게 게임을 너무 어렵게 만드는 위험도 감수한다.연구 결과, 선수의 기량 수준을 너무 상회하는 도전이 낮은 선수의 즐거움을 망친다는 것이 밝혀졌다.[16]이러한 고도로 훈련된 요원들은 주어진 경기에서 많은 시간을 경험하는 매우 숙련된 인간 선수들에게만 바람직할 것이다.이러한 요소들을 고려할 때, 고도로 효과적인 딥러닝 에이전트는 숙련된 인간 플레이어의 대체 연습 옵션으로 기능할 수 있는 경쟁 구도가 큰 게임에서 바람직한 선택일 가능성이 높다.

컴퓨터 비전 기반 플레이어

컴퓨터 비전(Computer vision)은 디지털 이미지나 비디오에 대한 높은 수준의 이해를 얻기 위해 컴퓨터를 훈련시키는 데 초점을 맞춘다.많은 컴퓨터 비전 기술들 또한 기계 학습의 형태를 포함하고 있으며, 다양한 비디오 게임에 적용되어 왔다.이 컴퓨터 비전의 응용은 시각 데이터를 이용한 게임 이벤트 해석에 초점을 맞추고 있다.인공지능(AI) 요원들이 모델프리 기법을 활용해 내부 게임 논리와 직접 연결되지 않고 비디오 데이터만 입력으로 활용해 게임을 익힌 사례도 있다.

퐁

안드레이 카파시는 화면 데이터만으로 퐁을 연주할 수 있는 훈련을 받을 수 있다는 것을 숨겨진 레이어 하나만 가진 비교적 사소한 신경 네트워크가 증명했다.[17][18]

아타리 경기

2013년 DeepMind 팀은 화면 데이터에서 다양한 아타리 비디오 게임인 Beamrider, Breakout, Enduro, Pong, Q*bert, Seaquest, Space Invider를 실행하기 위해 심층 Q-Learning의 사용을 시연했다.[19]연구팀은 무제로라는 학습 알고리즘을 만들어 규칙을 '학습'하고 화면 데이터를 바탕으로 50여 종의 아타리 게임의 우승 전략을 개발했다.[20][21]

둠

둠(1993)은 1인칭 슈터(FPS) 게임이다.카네기 멜론 대학의 학생 연구원들은 컴퓨터 비전 기술을 사용하여 게임에서 나오는 이미지 픽셀 입력만으로 게임을 할 수 있는 에이전트를 만들었다.학생들은 경련신경망(CNN) 레이어를 이용해 들어오는 영상 데이터를 해석하고 게임 이동 출력을 담당하는 반복 신경망으로 유효한 정보를 출력했다.[22]

슈퍼마리오

게임을 하기 위한 다른 시각 기반 딥 러닝 기법에는 슈퍼 마리오 브라더스 게임도 포함되어 있다.영상 입력만 사용하고 심층 Q-러닝은 교육에 사용한다.[17]

게임 내 절차적 콘텐츠 생성을 위한 머신러닝

머신러닝(machine learning)은 콘텐츠 추천 및 생성에 활용하기 위한 연구를 해왔다.절차적 컨텐츠 생성은 데이터를 수동으로 생성하기 보다는 알고리즘적으로 생성하는 과정이다.이런 종류의 콘텐츠는 인간 개발자들의 끊임없는 추가에 의존하지 않고 게임에 재생성을 더하기 위해 사용된다.PCG는 다양한 종류의 콘텐츠 생성에 다양한 게임에서 사용되어 왔는데, 그 예로는 보더랜드 2의 무기,[23] 마인크래프트의[24] 모든 세계 배치, 노 맨스 스카이(No Man's Sky)의 전 우주 배치 등이 있다.[25]PCG에 대한 일반적인 접근법에는 그래머, 검색 기반 알고리즘 및 로직 프로그래밍을 포함하는 기술이 포함된다.[26]이러한 접근법은 인간이 가능한 콘텐츠의 범위를 수동으로 정의하도록 요구한다. 즉, 인간 개발자는 어떤 특징이 생성되는 유효한 콘텐츠를 구성하는지를 결정한다.머신러닝은 이론적으로 이러한 특징을 교육할 수 있는 예를 들 때 학습할 수 있기 때문에 콘텐츠 설계의 세부사항을 구체화하는 개발자들의 복잡한 단계를 크게 줄인다.[27]콘텐츠 생성을 위해 사용되는 머신러닝 기법으로는 롱단기메모리(LSTM) 리커런트신경망(Recurrent Neural Networks, RNN), 제너레이션 렉토리얼 네트워크(Generatheral Network, GAN), K-평균 클러스터링 등이 있다.이러한 모든 기법이 ANN을 이용하는 것은 아니지만, 딥러닝의 급속한 발전은 그렇게 하는 기법의 잠재력을 크게 증가시켰다.[27]

은하 군비 경쟁

갤럭틱 암스 레이스는 신경진화 동력 PCG를 이용해 플레이어를 위한 독특한 무기를 만들어내는 우주 사격 비디오 게임이다.이 게임은 2010년 인디 게임 챌린지의 결승전 진출자로 2009년 IEEE 컴퓨터 인텔리전스 및 게임 콘퍼런스에서 관련 연구논문이 최우수 논문상을 수상했다.개발자들은 cgNEAT라는 신경진화의 형태를 사용해 각 플레이어의 개인적 선호도에 따라 새로운 콘텐츠를 생성한다.[28]

생성된 각 항목은 CPPN(Compositional Pattern Producting Network)으로 알려진 특별한 ANN으로 표현된다.게임의 진화 단계 동안 cgNEAT는 플레이어 사용 및 기타 게임 플레이 메트릭스를 기반으로 현재 항목의 적합성을 계산하며, 이 피트니스 점수를 사용하여 새 항목을 생성하기 위해 어떤 CPPN을 재현할지 결정한다.엔딩 결과는 선수의 기호에 따른 새로운 무기 효과의 발생이다.

슈퍼 마리오 브라더스.

슈퍼 마리오 브라더스.여러 연구자가 PCG 수준 생성을 시뮬레이션하기 위해 사용해 왔다.다양한 방법을 사용한 다양한 시도.2014년 버전에서는 n-gram을 사용하여 훈련된 버전과 유사한 수준을 생성했으며, 이후 MCTS를 사용하여 생성을 안내함으로써 개선되었다.[29]이들 세대는 플레이어 이동과 같은 게임 플레이 지표를 고려할 때 최적이 아닌 경우가 많았는데, 2017년 별도의 연구 프로젝트는 마르코프 체인을 사용하여 플레이어 이동에 기반한 수준을 생성함으로써 이 문제를 해결하려고 했다.[30]이 프로젝트들은 인간 실험의 대상이 아니었으며 인간의 놀이성 기준을 충족하지 못할 수도 있다.

젤다의 전설

젤다의 전설의 PCG 레벨 제작은 산타 크루즈 캘리포니아 대학의 연구원들에 의해 시도되었다.이 시도는 베이지안 네트워크를 사용하여 기존 수준에서 높은 수준의 지식을 습득하고 PCA(주요 구성요소 분석)는 이러한 수준의 서로 다른 낮은 수준의 특징을 나타내기 위해 사용되었다.[31]연구원들은 PCA를 사용하여 생성된 수준과 인간이 만든 수준을 비교했고, 그것들이 매우 유사한 것으로 간주된다는 것을 발견했다.이 테스트에는 생성된 레벨에 대한 재생성 또는 인체 테스트가 포함되지 않았다.

음악 생성

음악은 종종 비디오 게임에서 보여지고 다른 상황들과 이야기 포인트들의 분위기에 영향을 미치는 중요한 요소가 될 수 있다.머신러닝은 음악 생성의 실험적인 분야에서 사용되어 왔다; 그것은 독특하게 구조화되지 않은 원시 데이터를 처리하고 다양한 음악 분야에 적용될 수 있는 높은 수준의 표현을 형성하는데 적합하다.[32]대부분의 시도된 방법들은 어떤 형태로든 ANN을 사용하는 것을 포함한다.방법으로는 기본적인 피드포워드 신경망, 오토엔코더, 제한된 볼츠만 기계, 반복적인 신경망, 콘볼루션 신경망, 생성적 대립망(GAN), 다중 방법을 사용하는 복합 아키텍처의 사용이 있다.[32]

VRAE 비디오 게임 멜로디 상징 음악 생성 시스템

2014년 '변종 리커렌트 오토엔코더'에 관한 연구 논문은 8개의 다른 비디오 게임에서 나온 노래들을 바탕으로 음악을 만들어내려고 시도했다.이 프로젝트는 순수하게 비디오 게임 음악으로 수행되는 몇 안 되는 것 중 하나이다.프로젝트의 신경망은 훈련된 게임의 데이터와 매우 유사한 데이터를 생성할 수 있었다.[33]생성된 데이터는 양질의 음악으로 번역되지 않았다.

참조

- ^ a b Justesen, Niels; Bontrager, Philip; Togelius, Julian; Risi, Sebastian (2019). "Deep Learning for Video Game Playing". IEEE Transactions on Games. 12: 1–20. arXiv:1708.07902. doi:10.1109/tg.2019.2896986. ISSN 2475-1502. S2CID 37941741.

- ^ a b c d e Silver, David; Hubert, Thomas; Schrittwieser, Julian; Antonoglou, Ioannis; Lai, Matthew; Guez, Arthur; Lanctot, Marc; Sifre, Laurent; Kumaran, Dharshan (2018-12-06). "A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play" (PDF). Science. 362 (6419): 1140–1144. Bibcode:2018Sci...362.1140S. doi:10.1126/science.aar6404. ISSN 0036-8075. PMID 30523106. S2CID 54457125.

- ^ a b c Chollet, Francois (2017-10-28). Deep learning with Python. ISBN 9781617294433. OCLC 1019988472.

- ^ a b c d e f "AlphaStar: Mastering the Real-Time Strategy Game StarCraft II". DeepMind. Retrieved 2019-06-04.

- ^ a b c Silver, David; Huang, Aja; Maddison, Chris J.; Guez, Arthur; Sifre, Laurent; van den Driessche, George; Schrittwieser, Julian; Antonoglou, Ioannis; Panneershelvam, Veda (January 2016). "Mastering the game of Go with deep neural networks and tree search". Nature. 529 (7587): 484–489. Bibcode:2016Natur.529..484S. doi:10.1038/nature16961. ISSN 0028-0836. PMID 26819042. S2CID 515925.

- ^ a b "OpenAI Five". OpenAI. 2018-06-25. Retrieved 2019-06-04.

- ^ Russell, Stuart J. (Stuart Jonathan) (2015). Artificial intelligence : a modern approach. Norvig, Peter (Third Indian ed.). Noida, India. ISBN 9789332543515. OCLC 928841872.

- ^ Clune, Jeff; Stanley, Kenneth O.; Lehman, Joel; Conti, Edoardo; Madhavan, Vashisht; Such, Felipe Petroski (2017-12-18). "Deep Neuroevolution: Genetic Algorithms Are a Competitive Alternative for Training Deep Neural Networks for Reinforcement Learning". arXiv:1712.06567 [cs.NE].

- ^ Zhen, Jacky Shunjie; Watson, Ian (2013), "Neuroevolution for Micromanagement in the Real-Time Strategy Game Starcraft: Brood War", Lecture Notes in Computer Science, Springer International Publishing, pp. 259–270, CiteSeerX 10.1.1.703.5110, doi:10.1007/978-3-319-03680-9_28, ISBN 9783319036793

- ^ Silver, David; Schrittwieser, Julian; Simonyan, Karen; Antonoglou, Ioannis; Huang, Aja; Guez, Arthur; Hubert, Thomas; Baker, Lucas; Lai, Matthew (October 2017). "Mastering the game of Go without human knowledge" (PDF). Nature. 550 (7676): 354–359. Bibcode:2017Natur.550..354S. doi:10.1038/nature24270. ISSN 0028-0836. PMID 29052630. S2CID 205261034.

- ^ Tsing, Rodney; Repp, Jacob; Ekermo, Anders; Lawrence, David; Brunasso, Anthony; Keet, Paul; Calderone, Kevin; Lillicrap, Timothy; Silver, David (2017-08-16). "StarCraft II: A New Challenge for Reinforcement Learning". arXiv:1708.04782 [cs.LG].

- ^ a b "OpenAI Five". OpenAI. Retrieved 2019-06-04.

- ^ a b "How to Train Your OpenAI Five". OpenAI. 2019-04-15. Retrieved 2019-06-04.

- ^ xavdematos. "Meet the computer that's learning to kill and the man who programmed the chaos". Engadget. Retrieved 2019-06-04.

- ^ http://www.gameaipro.com/GameAIPro/GameAIPro_Chapter30_Using_Neural_Networks_to_Control_Agent_Threat_Response.pdf

- ^ Sweetser, Penelope; Wyeth, Peta (2005-07-01). "GameFlow". Computers in Entertainment. 3 (3): 3. doi:10.1145/1077246.1077253. ISSN 1544-3574. S2CID 2669730.

- ^ a b Jones, M. Tim (June 7, 2019). "Machine learning and gaming". IBM Developer. Retrieved 2020-02-03.

- ^ "Deep Reinforcement Learning: Pong from Pixels". karpathy.github.io. Retrieved 2020-02-03.

- ^ Mnih, Volodymyr; Kavukcuoglu, Koray; Silver, David; Graves, Alex; Antonoglou, Ioannis; Wierstra, Daan; Riedmiller, Martin (2013-12-19). "Playing Atari with Deep Reinforcement Learning". arXiv:1312.5602 [cs.LG].

- ^ Bonifacic, Igor (December 23, 2020). "DeepMind's latest AI can master games without being told their rules". Engadget. Retrieved December 23, 2020.

- ^ Schrittwieser, Julian; Antonoglou, Ioannis; Hubert, Thomas; Simonyan, Karen; Sifre, Laurent; Schmitt, Simon; Guez, Arthur; Lockhart, Edward; Hassabis, Demis; Graepel, Thore; Lillicrap, Timothy; Silver, David (2020). "Mastering Atari, Go, chess and shogi by planning with a learned model". Nature. 588 (7839): 604–609. arXiv:1911.08265. Bibcode:2020Natur.588..604S. doi:10.1038/s41586-020-03051-4. PMID 33361790. S2CID 208158225.

- ^ Lample, Guillaume; Chaplot, Devendra Singh (2017). "Playing FPS Games with Deep Reinforcement Learning". Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence. AAAI'17. San Francisco, California, USA: AAAI Press: 2140–2146. arXiv:1609.05521. Bibcode:2016arXiv160905521L.

- ^ Yin-Poole, Wesley (2012-07-16). "How many weapons are in Borderlands 2?". Eurogamer. Retrieved 2019-06-04.

- ^ "Terrain generation, Part 1". The Word of Notch. Retrieved 2019-06-04.

- ^ Parkin, Simon. "A Science Fictional Universe Created by Algorithms". MIT Technology Review. Retrieved 2019-06-04.

- ^ Togelius, Julian; Shaker, Noor; Nelson, Mark J. (2016), "Introduction", Procedural Content Generation in Games, Springer International Publishing, pp. 1–15, doi:10.1007/978-3-319-42716-4_1, ISBN 9783319427140

- ^ a b Summerville, Adam; Snodgrass, Sam; Guzdial, Matthew; Holmgard, Christoffer; Hoover, Amy K.; Isaksen, Aaron; Nealen, Andy; Togelius, Julian (September 2018). "Procedural Content Generation via Machine Learning (PCGML)". IEEE Transactions on Games. 10 (3): 257–270. arXiv:1702.00539. doi:10.1109/tg.2018.2846639. ISSN 2475-1502. S2CID 9950600.

- ^ Hastings, Erin J.; Guha, Ratan K.; Stanley, Kenneth O. (September 2009). "Evolving content in the Galactic Arms Race video game" (PDF). 2009 IEEE Symposium on Computational Intelligence and Games. IEEE: 241–248. doi:10.1109/cig.2009.5286468. ISBN 9781424448142. S2CID 16598064.

- ^ Summerville, Adam. "MCMCTS PCG 4 SMB: Monte Carlo Tree Search to Guide Platformer Level Generation". www.aaai.org. Retrieved 2019-06-04.

- ^ Snodgrass, Sam; Ontañón, Santiago (August 2017). "Player Movement Models for Video Game Level Generation". Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence. California: International Joint Conferences on Artificial Intelligence Organization: 757–763. doi:10.24963/ijcai.2017/105. ISBN 9780999241103.

- ^ Summerville, James. "Sampling Hyrule: Multi-Technique Probabilistic Level Generation for Action Role Playing Games". www.aaai.org. Retrieved 2019-06-04.

- ^ a b Pachet, François-David; Hadjeres, Gaëtan; Briot, Jean-Pierre (2017-09-05). "Deep Learning Techniques for Music Generation - A Survey". arXiv:1709.01620 [cs.SD].

- ^ van Amersfoort, Joost R.; Fabius, Otto (2014-12-20). "Variational Recurrent Auto-Encoders". arXiv:1412.6581 [stat.ML].