컴퓨터 비전

Computer vision| 에 관한 시리즈의 일부 |

| 인공지능 |

|---|

컴퓨터 비전 작업에는 디지털 이미지를 획득, 처리, 분석 및 이해하는 방법, 예를 들어 의사 결정의 형태로 수치 또는 기호 정보를 생성하기 위해 실제 세계에서 고차원 데이터를 추출하는 방법이 포함됩니다.[1][2][3][4] 이러한 맥락에서 이해한다는 것은 시각적 이미지(인간 유사체의 망막에 대한 입력)를 사고 과정에 적합하고 적절한 행동을 이끌어낼 수 있는 세계에 대한 설명으로 변환하는 것을 의미합니다. 이러한 이미지 이해는 기하학, 물리학, 통계학, 학습이론의 도움을 받아 구축된 모델을 활용하여 이미지 데이터에서 상징적인 정보를 분리하는 것으로 볼 수 있습니다.

컴퓨터 비전의 과학 분야는 이미지에서 정보를 추출하는 인공 시스템 이면의 이론과 관련이 있습니다. 이미지 데이터는 비디오 시퀀스, 여러 카메라의 뷰, 3D 스캐너의 다차원 데이터, LiDaR 센서의 3D 포인트 클라우드 또는 의료 스캔 장치와 같은 다양한 형태를 취할 수 있습니다. 컴퓨터 비전의 기술 분야는 이론과 모델을 컴퓨터 비전 시스템 구축에 적용하고자 합니다.

컴퓨터 비전의 하위 영역에는 장면 재구성, 객체 감지, 이벤트 감지, 활동 인식, 비디오 추적, 객체 인식, 3D 자세 추정, 학습, 인덱싱, 모션 추정, 시각 서보, 3D 장면 모델링 및 이미지 복원이 포함됩니다.

컴퓨터 비전 기술을 채택하는 것은 단 하나의 포인트 솔루션이 없기 때문에 조직에서 부담이 될 수 있습니다. 컴퓨터 비전 애플리케이션을 쉽게 배포하고 관리할 수 있는 통합 및 분산 플랫폼 또는 운영 체제를 제공하는 회사는 거의 없습니다.

정의.

컴퓨터 비전은 디지털 이미지 또는 비디오에서 높은 수준의 이해를 얻기 위해 컴퓨터를 만드는 방법을 다루는 학제 간 분야입니다. 공학의 관점에서 인간 시각 시스템이 할 수 있는 작업을 자동화하고자 합니다.[5][6][7] "컴퓨터 비전은 단일 이미지 또는 일련의 이미지에서 유용한 정보를 자동으로 추출, 분석 및 이해하는 것과 관련이 있습니다. 그것은 자동 시각적 이해를 달성하기 위한 이론적, 알고리즘적 기반의 개발을 포함합니다."[8] 컴퓨터 비전은 과학 분야로서 이미지에서 정보를 추출하는 인공 시스템 이면의 이론과 관련이 있습니다. 이미지 데이터는 비디오 시퀀스, 여러 카메라의 뷰 또는 의료 스캐너의 다차원 데이터와 같은 다양한 형태를 취할 수 있습니다.[9] 기술 분야로서 컴퓨터 비전은 컴퓨터 비전 시스템 구축에 이론과 모델을 적용하고자 합니다. 머신 비전은 특히 공장 자동화의 맥락에서 시스템 엔지니어링 분야를 의미하며, 최근에는 컴퓨터 비전과 머신 비전이라는 용어가 더 큰 수준으로 수렴되고 있습니다.[10]: 13

역사

1960년대 후반, 인공 지능을 개척하던 대학에서 컴퓨터 비전이 시작되었습니다. 로봇에게 지능적인 행동을 허용하기 위한 디딤돌로서 인간의 시각 시스템을 모방하기 위한 것이었습니다.[11] 1966년에는 학부 여름 프로젝트를 [12]통해 컴퓨터에 카메라를 부착하고 "본 것을 설명"하도록 함으로써 이를 달성할 수 있다고 믿었습니다.[13][14]

당시 컴퓨터 비전이 널리 퍼져 있던 디지털 영상 처리 분야와 구별되는 점은 완전한 장면 이해를 목표로 영상에서 3차원 구조를 추출하고자 하는 열망이었습니다. 1970년대의 연구는 이미지에서 가장자리 추출, 선 라벨링, 비 다면체 및 다면체 모델링, 더 작은 구조의 상호 연결로 물체를 표현하는 것, 광학 흐름 및 움직임 추정을 포함하여 오늘날 존재하는 많은 컴퓨터 비전 알고리즘의 초기 기반을 형성했습니다.[11]

그 다음 10년 동안은 컴퓨터 비전의 보다 엄격한 수학적 분석과 정량적 측면에 기반한 연구가 이루어졌습니다. 여기에는 스케일 공간의 개념, 음영, 질감 및 초점과 같은 다양한 단서에서 모양을 추론하는 것, 뱀으로 알려진 윤곽 모델이 포함됩니다. 연구자들은 또한 이러한 많은 수학적 개념들이 정규화 및 마르코프 랜덤 필드와 동일한 최적화 프레임워크 내에서 처리될 수 있다는 것을 깨달았습니다.[15] 1990년대까지 이전의 연구 주제 중 일부는 다른 주제보다 더 활성화되었습니다. 투영 3-D 재구성에 대한 연구는 카메라 보정에 대한 더 나은 이해로 이어졌습니다. 카메라 보정을 위한 최적화 방법이 등장하면서 이미 사진측량 분야에서 번들 조정 이론에서 많은 아이디어가 탐구되었다는 것을 깨달았습니다. 이로 인해 여러 이미지에서 장면을 희소하게 3D 재구성하는 방법이 생겼습니다. 밀도 높은 스테레오 대응 문제와 추가적인 멀티뷰 스테레오 기술에 대한 진전이 이루어졌습니다. 동시에 그래프 컷의 변형을 사용하여 이미지 분할을 해결했습니다. 이 10년은 또한 통계 학습 기술이 실제로 이미지에서 얼굴을 인식하는 데 처음으로 사용되었습니다(아이겐페이스 참조). 1990년대 말에 컴퓨터 그래픽과 컴퓨터 비전 분야 간의 상호작용이 증가하면서 중요한 변화가 나타났습니다. 여기에는 이미지 기반 렌더링, 이미지 모핑, 뷰 보간, 파노라마 이미지 스티칭 및 초기 라이트 필드 렌더링이 포함되었습니다.[11]

최근 연구에서는 기계 학습 기술 및 복잡한 최적화 프레임워크와 함께 사용되는 기능 기반 방법이 다시 등장했습니다.[16][17] 딥 러닝 기술의 발전은 컴퓨터 비전 분야에 더욱 활기를 불어넣었습니다. 분류,[18] 분할 및 광학 흐름에 이르는 작업에 대한 여러 벤치마크 컴퓨터 비전 데이터 세트에서 딥 러닝 알고리즘의 정확도는 이전 방법을 능가했습니다.[citation needed][19]

관련분야

고체 물리학

고체 물리학은 컴퓨터 비전과 밀접한 관련이 있는 또 다른 분야입니다. 대부분의 컴퓨터 비전 시스템은 일반적으로 가시광선 또는 적외선 형태의 전자기 방사선을 감지하는 이미지 센서에 의존합니다. 센서는 양자 물리학을 사용하여 설계되었습니다. 빛이 표면과 상호작용하는 과정은 물리학을 이용하여 설명됩니다. 물리학은 대부분의 이미징 시스템의 핵심 부분인 광학의 거동을 설명합니다. 정교한 이미지 센서는 이미지 형성 과정에 대한 완전한 이해를 제공하기 위해 양자 역학을 필요로 하기도 합니다.[11] 또한 물리학의 다양한 측정 문제는 컴퓨터 비전, 예를 들어 유체의 움직임을 사용하여 해결할 수 있습니다.

신경생물학

신경생물학은 컴퓨터 비전 알고리즘의 발전에 큰 영향을 미쳤습니다. 지난 세기 동안 인간과 다양한 동물 모두의 시각적 자극을 처리하는 데 전념하는 눈, 뉴런 및 뇌 구조에 대한 광범위한 연구가 있었습니다. 이로 인해 특정 시력 관련 작업을 해결하기 위해 자연 시력 시스템이 어떻게 작동하는지에 대한 거칠지만 복잡한 설명이 이루어졌습니다. 이러한 결과는 컴퓨터 비전 내에서 인공 시스템이 다양한 복잡성 수준에서 생물학적 시스템의 처리 및 행동을 모방하도록 설계되는 하위 분야로 이어졌습니다. 또한 컴퓨터 비전 내에서 개발된 학습 기반 방법 중 일부(예: 신경망 및 딥 러닝 기반 이미지 및 특징 분석 및 분류)는 신경생물학에 배경을 두고 있습니다. 1970년대 후쿠시마 쿠니히코에 의해 개발된 신경 네트워크인 네오코그니트론은 신경생물학, 특히 주요 시각 피질에서 직접 영감을 얻은 컴퓨터 비전의 초기 예입니다.

컴퓨터 비전 연구의 일부 가닥은 생물학적 비전 연구와 밀접한 관련이 있습니다. 실제로 많은 AI 연구가 인간 지능에 대한 연구와 시각 정보를 해석하고 통합 및 활용하기 위해 저장된 지식을 사용하는 것과 밀접하게 관련되어 있습니다. 생물학적 시력 분야는 인간과 다른 동물의 시각 인식 이면의 생리적 과정을 연구하고 모델링합니다. 반면 컴퓨터 비전은 인공 비전 시스템 뒤에 소프트웨어와 하드웨어로 구현된 알고리즘을 개발하고 설명합니다. 생물학적 비전과 컴퓨터 비전 간의 학제 간 교류는 두 분야 모두에 유익한 것으로 입증되었습니다.[21]

신호처리

컴퓨터 비전과 관련된 또 다른 분야는 신호 처리입니다. 1변수 신호, 일반적으로 시간적 신호의 처리를 위한 많은 방법은 컴퓨터 비전에서 2변수 신호 또는 다변수 신호의 처리로 자연스러운 방식으로 확장될 수 있습니다. 그러나 이미지의 특수성 때문에 컴퓨터 비전 내에서 개발된 많은 방법들은 일변수 신호의 처리에 있어 상대가 없는 방법들이 있습니다. 이는 신호의 다차원성과 함께 신호 처리의 하위 분야를 컴퓨터 비전의 일부로 정의합니다.

로봇 내비게이션은 때때로 로봇 시스템이 환경을 탐색하기 위한 자율 경로 계획이나 심의를 다룹니다.[22] 이러한 환경을 탐색하려면 이러한 환경에 대한 자세한 이해가 필요합니다. 컴퓨터 비전 시스템에 의해 환경에 대한 정보가 제공되어 비전 센서 역할을 하고 환경과 로봇에 대한 높은 수준의 정보를 제공할 수 있습니다.

기타 필드

위에서 언급한 컴퓨터 비전에 대한 견해 외에도 관련 연구 주제의 많은 부분이 순수 수학적 관점에서 연구될 수 있습니다. 예를 들어, 컴퓨터 비전의 많은 방법들은 통계, 최적화 또는 기하학에 기초합니다. 마지막으로 이 분야의 상당 부분은 컴퓨터 비전의 구현 측면, 즉 소프트웨어와 하드웨어의 다양한 조합에서 기존 방법을 구현할 수 있는 방법, 또는 성능을 너무 많이 잃지 않고 처리 속도를 높이기 위해 이러한 방법을 수정할 수 있는 방법에 할애됩니다. 컴퓨터 비전은 패션 전자 상거래, 재고 관리, 특허 검색, 가구 및 미용 산업에서도 사용됩니다.[citation needed]

구별

컴퓨터 비전과 가장 밀접한 관련이 있는 분야는 이미지 처리, 이미지 분석 및 기계 비전입니다. 이들이 다루는 기술과 응용 분야의 범위가 상당히 겹칩니다. 이는 이러한 분야에서 사용되고 개발되는 기본 기법이 유사하다는 것을 의미하며, 이는 이름이 다른 분야가 하나뿐이라는 것으로 해석할 수 있습니다. 한편, 연구회, 과학저널, 학회, 기업들이 이러한 분야 중 하나에 특별히 속하는 것으로 제시하거나 마케팅하는 것이 필요한 것으로 보이며, 따라서 각 분야를 다른 분야와 구별하는 다양한 특성이 제시되고 있습니다. 이미지 처리에서는 입력이 이미지이고 출력이 이미지인 반면, 컴퓨터 비전에서는 이미지 또는 비디오를 입력으로 사용하고 출력은 향상된 이미지, 이미지의 내용에 대한 이해 또는 이러한 이해를 기반으로 한 컴퓨터 시스템의 동작일 수 있습니다.

컴퓨터 그래픽은 3D 모델로부터 이미지 데이터를 생성하고, 컴퓨터 비전은 이미지 데이터로부터 3D 모델을 생성하는 경우가 많습니다.[23] 증강 현실에서 탐구되는 것과 같이 두 학문의 조합을 향한 추세도 있습니다.

다음과 같은 특성은 관련이 있는 것으로 보이지만 보편적으로 인정되는 것으로 간주해서는 안 됩니다.

- 이미지 처리 및 이미지 분석은 2D 이미지, 예를 들어 대비 향상과 같은 픽셀 단위 작업, 에지 추출 또는 노이즈 제거와 같은 로컬 작업 또는 이미지 회전과 같은 기하학적 변환에 의해 한 이미지를 다른 이미지로 변환하는 방법에 초점을 맞추는 경향이 있습니다. 이러한 특성화는 이미지 처리/분석이 이미지 내용에 대한 가정을 요구하지도 않고 해석을 생성하지도 않는다는 것을 의미합니다.

- 컴퓨터 비전에는 2D 이미지에서 3D 분석이 포함됩니다. 이것은 예를 들어, 하나 또는 여러 이미지에서 3D 장면에 대한 구조 또는 기타 정보를 재구성하는 방법과 같이 하나 또는 여러 이미지에 투영된 3D 장면을 분석합니다. 컴퓨터 비전은 종종 이미지에 묘사된 장면에 대한 다소 복잡한 가정에 의존합니다.

- 머신 비전은 산업 응용 분야에서 이미징 기반 자동 검사, 공정 제어 및 로봇 안내를[24] 제공하기 위해 다양한 기술과 방법을 적용하는 과정입니다.[21] 기계 비전은 주로 비전 기반 검사, 측정 또는 피킹(빈 피킹과[25] 같은)을 위한 비전 기반 로봇 및 시스템과 같은 제조 분야의 응용 분야에 초점을 맞추는 경향이 있습니다. 이는 이미지 센서 기술과 제어 이론이 로봇을 제어하기 위한 이미지 데이터 처리와 종종 통합되고 하드웨어와 소프트웨어의 효율적인 구현을 통해 실시간 처리가 강조된다는 것을 의미합니다. 또한 조명과 같은 외부 조건은 일반 컴퓨터 비전보다 기계 비전에서 더 많이 제어될 수 있으며 종종 다른 알고리즘을 사용할 수 있음을 의미합니다.

- 주로 이미지를 생성하는 과정에 중점을 두지만 때로는 이미지의 처리 및 분석도 다루는 이미징이라는 분야도 있습니다. 예를 들어, 의료 영상에는 의료 애플리케이션의 이미지 데이터 분석에 대한 상당한 작업이 포함됩니다.

- 마지막으로 패턴 인식은 주로 통계적 접근과 인공신경망을 기반으로 일반적으로 신호로부터 정보를 추출하기 위해 다양한 방법을 사용하는 분야입니다.[26] 이 분야의 상당 부분은 이러한 방법을 이미지 데이터에 적용하는 데 전념하고 있습니다.

사진 측정은 컴퓨터 비전과도 겹칩니다. 예를 들어, 스테레오 사진 측정 대 컴퓨터 스테레오 비전입니다.

적용들

응용 분야는 생산 라인에서 병이 빠르게 지나가는 것을 검사하는 산업 기계 비전 시스템과 같은 작업부터 인공 지능 및 주변 세계를 이해할 수 있는 컴퓨터 또는 로봇 연구에 이르기까지 다양합니다. 컴퓨터 비전과 기계 비전 분야는 상당히 겹칩니다. 컴퓨터 비전은 많은 분야에서 사용되는 자동화된 이미지 분석의 핵심 기술을 다룹니다. 기계 비전은 일반적으로 자동화된 이미지 분석을 다른 방법 및 기술과 결합하여 산업 응용 분야에서 자동화된 검사 및 로봇 안내를 제공하는 프로세스를 말합니다. 많은 컴퓨터 비전 애플리케이션에서 컴퓨터는 특정 작업을 해결하기 위해 미리 프로그래밍되어 있지만, 이제 학습에 기반한 방법이 점점 더 일반화되고 있습니다. 컴퓨터 비전의 응용 예로는 다음을 위한 시스템이 있습니다.

- 예를 들어 제조 응용 프로그램에서 자동 검사

- 인간의 식별업무를 지원하는 것,[27] 예를 들면 종식별시스템

- 예를 들어, 산업용 로봇과 같은 프로세스를 제어합니다.

- 예를 들어, 시각적 감시를 위한 사건 감지 또는 예를 들어, 레스토랑 업계에서 사람들의 계산.

- 예를 들어, 컴퓨터-인간 상호작용을 위한 장치에 대한 입력으로서의 상호작용;

- 예를 들어, 의료 이미지 분석 또는 지형 모델링과 같은 객체 또는 환경 모델링

- 예를 들어, 자율 주행 차량 또는 이동 로봇에 의한 내비게이션;

- 예를 들어, 이미지 및 이미지 시퀀스의 데이터베이스 인덱싱을 위한 정보 구성.

- 3D 좌표로 표면이나 평면을 추적하여 증강 현실을 경험할 수 있습니다.

약

가장 중요한 응용 분야 중 하나는 환자를 진단하기 위해 이미지 데이터에서 정보를 추출하는 것을 특징으로 하는 의료 컴퓨터 비전, 즉 의료 이미지 처리입니다. 종양, 동맥경화 또는 기타 악성 변화, 다양한 치아 병리의 발견, 장기 치수, 혈류 등을 측정하는 것이 그 예입니다. 그것은 또한 뇌의 구조나 치료의 질과 같은 새로운 정보를 제공함으로써 의학 연구를 지원합니다. 의료 분야에서 컴퓨터 비전의 적용에는 노이즈의 영향을 줄이기 위해 사람이 해석하는 이미지(예: 초음파 이미지 또는 X선 이미지)의 향상도 포함됩니다.

머신비전

컴퓨터 비전의 두 번째 응용 분야는 생산 프로세스를 지원하기 위해 정보를 추출하는 기계 비전이라고도 불리는 산업 분야입니다. 결함을 찾기 위해 세부 사항이나 최종 제품을 자동으로 검사하는 품질 관리가 한 예입니다. 이러한 검사를 위한 가장 일반적인 분야 중 하나는 컴퓨터 칩이 사용할 수 없는 방식으로 시장에 출시되는 것을 방지하기 위해 모든 웨이퍼가 부정확하거나 결함이 있는지 측정 및 검사되는 웨이퍼 산업입니다. 또 다른 예는 로봇 암이 픽업할 세부 사항의 위치와 방향을 측정하는 것입니다. 기계 비전은 또한 대량 재료에서 바람직하지 않은 음식물을 제거하기 위해 농업 과정에서 많이 사용됩니다. 이 과정은 광학 선별입니다.[28]

군사의

군사 애플리케이션은 아마도 컴퓨터 비전의[citation needed] 가장 큰 영역 중 하나일 것입니다. 적병이나 차량의 탐지와 미사일 유도가 명백한 예입니다. 미사일 유도를 위한 더 발전된 시스템은 특정 표적이 아닌 지역으로 미사일을 전송하고, 현지에서 획득한 영상 데이터를 기반으로 미사일이 해당 지역에 도달하면 표적 선택이 이루어집니다. "전장 인식"과 같은 현대 군사 개념은 이미지 센서를 포함한 다양한 센서가 전략적 결정을 지원하는 데 사용할 수 있는 전투 장면에 대한 풍부한 정보를 제공한다는 것을 의미합니다. 이 경우 데이터의 자동 처리를 사용하여 복잡성을 줄이고 여러 센서의 정보를 융합하여 신뢰성을 높입니다.

자율주행차

새로운 응용 분야 중 하나는 잠수정, 육상 차량(바퀴, 자동차 또는 트럭이 있는 소형 로봇), 항공기 및 무인 항공기(UAV)를 포함하는 자율 주행 차량입니다. 자율성 수준은 완전 자율(무인) 차량부터 컴퓨터 비전 기반 시스템이 다양한 상황에서 운전자 또는 조종사를 지원하는 차량까지 다양합니다. 완전 자율 주행 차량은 일반적으로 내비게이션에 컴퓨터 비전(예: 위치 파악 또는 환경 매핑(SLAM)을 사용하여 장애물을 감지합니다. 또한 산불을 찾는 UAV와 같은 특정 작업별 이벤트를 감지하는 데 사용할 수 있습니다. 지원 시스템의 예로는 자동차의 장애물 경고 시스템, 자동차의 카메라 및 라이다 센서, 항공기의 자율 착륙을 위한 시스템 등이 있습니다. 여러 자동차 제조업체에서 자동차의 자율 주행을 위한 시스템을 시연했습니다. 첨단 미사일부터 정찰이나 미사일 유도를 위한 무인항공기까지 군 자율주행차의 예는 충분합니다. 이미 NASA의 큐리오시티와 CNSA의 유투-2 로버 등 컴퓨터 비전을 이용한 자율주행차로 우주 탐사가 이뤄지고 있습니다.

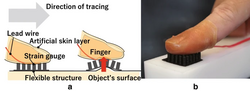

택타일 피드백

고무와 실리콘과 같은 재료는 미세한 기복을 감지하고 로봇 손을 보정하는 것과 같은 응용을 가능하게 하는 센서를 만드는 데 사용되고 있습니다. 고무를 사용하여 손가락 위에 놓을 수 있는 금형을 만들 수 있으며, 이 금형의 내부에는 여러 스트레인 게이지가 있습니다. 그런 다음 손가락 몰드와 센서를 고무 핀 배열이 들어 있는 작은 고무 시트 위에 놓을 수 있습니다. 그런 다음 사용자는 핑거 몰드를 착용하고 표면을 추적할 수 있습니다. 그런 다음 컴퓨터는 스트레인 게이지에서 데이터를 읽고 하나 이상의 핀이 위로 눌려 있는지 측정할 수 있습니다. 핀을 위쪽으로 밀면 컴퓨터는 표면의 결함으로 인식할 수 있습니다. 이러한 종류의 기술은 매우 큰 표면에서 불완전성에 대한 정확한 데이터를 수신하는 데 유용합니다.[29] 이 핑거 몰드 센서의 또 다른 변형은 실리콘에 매달린 카메라를 포함하는 센서입니다. 실리콘은 카메라 외부 주위에 돔을 형성하고 실리콘에 내장된 점 마커는 동일한 간격으로 배치됩니다. 그런 다음 이러한 카메라를 로봇 손과 같은 장치에 배치하여 컴퓨터가 매우 정확한 촉각 데이터를 수신할 수 있도록 할 수 있습니다.[30]

기타 응용 분야는 다음과 같습니다.

일반적인 태스크

위에서 설명한 각 응용 분야는 다양한 컴퓨터 비전 작업을 사용합니다. 다소 명확하게 정의된 측정 문제 또는 처리 문제는 다양한 방법을 사용하여 해결할 수 있습니다. 일반적인 컴퓨터 비전 작업의 몇 가지 예를 아래에 제시합니다.

컴퓨터 비전 작업에는 디지털 이미지를 획득, 처리, 분석 및 이해하는 방법, 예를 들어 의사 결정의 형태로 수치 또는 기호 정보를 생성하기 위해 실제 세계에서 고차원 데이터를 추출하는 방법이 포함됩니다.[1][2][3][4] 이러한 맥락에서의 이해는 시각적 이미지(망막의 입력)를 다른 사고 과정과 상호 작용하고 적절한 행동을 이끌어낼 수 있는 세계에 대한 묘사로 변환하는 것을 의미합니다. 이러한 이미지 이해는 기하학, 물리학, 통계학, 학습이론의 도움을 받아 구축된 모델을 활용하여 이미지 데이터에서 상징적인 정보를 분리하는 것으로 볼 수 있습니다.[35]

인식

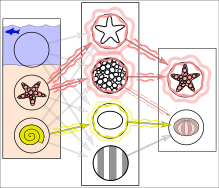

컴퓨터 비전, 이미지 처리 및 기계 비전의 고전적인 문제는 이미지 데이터에 특정 객체, 특징 또는 활동이 포함되어 있는지 여부를 결정하는 것입니다. 다양한 인식 문제가 문헌에 설명되어 있습니다.[36]

- 객체 인식(객체 분류라고도 함) – 하나 또는 여러 개의 미리 지정되거나 학습된 객체 또는 객체 클래스를 인식할 수 있으며, 일반적으로 이미지 내 2D 위치 또는 장면 내 3D 포즈와 함께 인식할 수 있습니다. Blippar, Google Goggs 및 Like That은 이러한 기능을 설명하는 독립형 프로그램을 제공합니다.

- ID – 개체의 개별 인스턴스가 인식됩니다. 특정인의 얼굴이나 지문의 식별, 손으로 쓴 숫자의 식별 또는 특정 차량의 식별 등이 그 예입니다.

- 감지 – 이미지 데이터가 위치와 함께 특정 개체에 대해 스캔됩니다. 자동차 시야의 장애물과 의료 영상에서 발생할 수 있는 비정상적인 세포 또는 조직을 감지하거나 자동 도로 통행료 시스템에서 차량을 감지하는 것이 그 예입니다. 비교적 간단하고 빠른 계산을 기반으로 한 탐지는 때때로 흥미로운 이미지 데이터의 더 작은 영역을 찾는 데 사용되며, 이는 정확한 해석을 생성하기 위해 더 많은 계산 요구 기술을 통해 추가로 분석될 수 있습니다.

현재 이러한 작업에 가장 적합한 알고리즘은 컨볼루션 신경망을 기반으로 합니다. ImageNet Large Scale Visual Recognition Challenge는 이러한 기능을 보여주는 사례로, 수백만 개의 이미지와 1000개의 객체 클래스가 경쟁에 사용되는 객체 분류 및 감지 분야의 벤치마크입니다.[37] ImageNet 테스트에서 컨볼루션 신경망의 성능은 이제 인간의 성능에 가깝습니다.[37] 최고의 알고리즘은 여전히 꽃 줄기에 있는 작은 개미나 손에 퀼을 들고 있는 사람처럼 작거나 얇은 물체와 씨름하고 있습니다. 또한 필터로 왜곡된 이미지(현대 디지털 카메라에서 점점 더 일반화되는 현상)에 문제가 있습니다. 대조적으로, 그러한 종류의 이미지는 인간을 거의 괴롭히지 않습니다. 그러나 인간은 다른 문제에 어려움을 겪는 경향이 있습니다. 예를 들어, 그들은 특정 품종의 개나 새 종과 같은 세분화된 클래스로 물체를 분류하는 데 능숙하지 않지만 컨볼루션 신경망은 이를 쉽게 처리합니다.[citation needed]

다음과 같은 인식에 기반한 몇 가지 전문 작업이 있습니다.

- 콘텐츠 기반 이미지 검색 – 특정 콘텐츠가 포함된 더 큰 이미지 집합에서 모든 이미지를 찾습니다. 역 이미지 검색 기법을 활용하여 대상 이미지에 대한 유사성(이미지 X와 유사한 이미지를 모두 제공) 또는 텍스트 입력으로 제공되는 고급 검색 기준(많은 하우스가 포함된 이미지를 모두 제공)과 같은 다양한 방법으로 내용을 지정할 수 있습니다. 겨울 동안 촬영하고 차가 없습니다."

- 포즈 추정 – 카메라에 대한 특정 물체의 위치 또는 방향을 추정합니다. 이 기술의 예로는 조립 라인 상황에서 컨베이어 벨트에서 물체를 회수하거나 빈에서 부품을 선택하는 로봇 암을 도울 수 있습니다.

- 광학 문자 인식(OCR) – 일반적으로 텍스트를 편집하거나 인덱싱하기에 더 적합한 형식으로 인코딩할 수 있는 보기를 사용하여 인쇄 또는 손으로 쓴 텍스트 이미지의 문자를 식별합니다(예: ASCII). 관련 업무는 데이터 매트릭스, QR 코드 등 2D 코드 판독입니다.

- 얼굴 인식 – 디지털 이미지 또는 비디오 프레임의 얼굴을 얼굴 데이터베이스에 매칭할 수 있도록 하는 기술로, 현재 휴대폰 얼굴 잠금, 스마트 도어 잠금 등에 널리 사용되고 있습니다.[38]

- 감정 인식 – 얼굴 인식의 하위 집합인 감정 인식은 인간의 감정을 분류하는 과정을 말합니다. 그러나 심리학자들은 내면의 감정을 얼굴에서 확실하게 감지할 수 없다고 경고합니다.[39]

- 사람의 형상 인식 기술(SRT)은 사람(머리 및 어깨 패턴)을 물체와 구별하는 카운터 시스템입니다.

- 인간 활동 인식 - 사람이 물체를 집어 들거나 걷고 있는 경우와 같은 일련의 비디오 프레임에서 활동을 인식하는 것을 다룹니다.

동작분석

여러 작업은 영상 시퀀스가 영상의 각 지점 또는 3D 장면 또는 영상을 생성하는 카메라에서 속도 추정치를 생성하기 위해 처리되는 모션 추정과 관련이 있습니다. 이러한 작업의 예는 다음과 같습니다.

- Egomotion – 카메라에서 생성된 이미지 시퀀스로부터 카메라의 3D 강체 모션(회전 및 병진)을 결정합니다.

- 추적 – 이미지 시퀀스에서 (일반적으로) 더 작은 관심 지점 또는 객체(예: 차량, 객체, 인간 또는 기타 유기체[34])의 움직임을 따릅니다. 대부분의 고성능 기계를 이러한 방식으로 모니터링할 수 있기 때문에 광범위한 산업 응용 분야가 있습니다.

- 광학 흐름 – 이미지의 각 점에 대해 해당 점이 이미지 평면에 대해 어떻게 이동하는지, 즉 겉보기 움직임을 결정합니다. 이 동작은 해당 3D 지점이 장면에서 어떻게 이동하는지와 카메라가 장면에 대해 어떻게 이동하는지 모두의 결과입니다.

장면 재구성

장면 또는 비디오의 하나 이상의 이미지가 주어지면 장면 재구성은 장면의 3D 모델을 계산하는 것을 목표로 합니다. 가장 간단한 경우 모델은 3D 포인트 세트가 될 수 있습니다. 보다 정교한 방법으로 완전한 3D 표면 모델을 제작할 수 있습니다. 모션이나 스캐닝이 필요 없는 3D 이미징과 관련 처리 알고리즘의 등장으로 이 분야의 빠른 발전이 가능해지고 있습니다. 그리드 기반 3D 센싱을 사용하여 여러 각도에서 3D 이미지를 획득할 수 있습니다. 이제 알고리즘을 사용하여 여러 개의 3D 이미지를 포인트 클라우드와 3D 모델로 함께 스티칭할 수 있습니다.[23]

이미지 복원

이미지 복원은 렌즈의 잘못된 위치 설정, 전송 간섭, 낮은 조명 또는 노이즈라고 하는 모션 블러 등과 같은 일부 외부 요인으로 인해 원래 이미지가 저하되거나 손상될 때 나타납니다. 이미지가 저하되거나 손상되면 추출할 정보도 손상됩니다. 따라서 이미지를 원래 의도대로 복구하거나 복원해야 합니다. 이미지 복원의 목적은 이미지에서 노이즈(센서 노이즈, 모션 블러 등)를 제거하는 것입니다. 노이즈 제거를 위한 가장 간단한 접근 방식은 저역 통과 필터 또는 중간 필터와 같은 다양한 유형의 필터입니다. 더 정교한 방법은 로컬 이미지 구조가 어떻게 보이는지 모델을 가정하여 노이즈와 구별합니다. 먼저 선이나 가장자리와 같은 로컬 이미지 구조 측면에서 이미지 데이터를 분석한 다음 분석 단계의 로컬 정보를 기반으로 필터링을 제어함으로써 일반적으로 단순한 접근 방식에 비해 더 나은 수준의 노이즈 제거를 얻을 수 있습니다.

이 분야의 예로는 인페인팅이 있습니다.

시스템방법

컴퓨터 비전 시스템의 조직은 애플리케이션 의존도가 높습니다. 일부 시스템은 특정 측정 또는 감지 문제를 해결하는 독립형 애플리케이션인 반면, 다른 시스템은 더 큰 설계의 하위 시스템을 구성하며, 예를 들어 기계적 액추에이터, 계획, 정보 데이터베이스, 인간-기계 인터페이스 등의 제어를 위한 하위 시스템도 포함합니다. 컴퓨터 비전 시스템의 구체적인 구현은 또한 기능이 사전에 지정되었는지 또는 작동 중에 일부 기능을 학습하거나 수정할 수 있는지 여부에 달려 있습니다. 많은 기능이 애플리케이션에 고유합니다. 그러나 많은 컴퓨터 비전 시스템에서 볼 수 있는 전형적인 기능이 있습니다.

- 이미지 획득 – 디지털 이미지는 다양한 유형의 빛에 민감한 카메라 외에도 범위 센서, 단층 촬영 장치, 레이더, 초음파 카메라 등을 포함하는 하나 또는 여러 이미지 센서에 의해 생성됩니다. 센서 유형에 따라 결과 영상 데이터는 일반 2D 영상, 3D 볼륨 또는 영상 시퀀스입니다. 픽셀 값은 일반적으로 하나 또는 여러 스펙트럼 대역(회색 이미지 또는 색상 이미지)의 광 강도에 해당하지만 깊이, 음파 또는 전자기파의 흡수 또는 반사율 또는 자기 공명 영상과 같은 다양한 물리적 측정과도 관련될 수 있습니다.[28]

- 전처리 – 특정 정보를 추출하기 위해 이미지 데이터에 컴퓨터 비전 방법을 적용하기 전에 일반적으로 이 방법이 내포하는 특정 가정을 충족하는지 확인하기 위해 데이터를 처리해야 합니다. 예는 다음과 같습니다.

- 특징 추출 – 다양한 복잡성 수준의 이미지 특징이 이미지 데이터에서 추출됩니다.[28] 이러한 기능의 대표적인 예는 다음과 같습니다.

- 더 복잡한 특징은 질감, 모양 또는 움직임과 관련이 있을 수 있습니다.

- 감지/세그먼트 – 처리 중 어느 시점에서 이미지의 어떤 이미지 포인트 또는 영역이 추가 처리와 관련이 있는지에 대한 결정이 내려집니다.[28] 예는 다음과 같습니다.

- 높은 수준의 처리 – 이 단계에서 입력은 일반적으로 작은 데이터 집합(예: 점 집합 또는 특정 개체를 포함하는 것으로 가정되는 이미지 영역)입니다.[28] 나머지 처리는 다음과 같이 다룹니다.

- 의사결정 신청에 필요한 최종 의사결정 예:[28]

- 자동 검사 응용 프로그램에 합격/불합격합니다.

- 인식 응용 프로그램에서 일치/일치하지 않습니다.

- 의료, 군사, 보안 및 인식 애플리케이션에서 추가적인 인간 검토를 위한 깃발입니다.

이미지 이해 시스템

이미지 이해 시스템(IUS)은 다음과 같이 세 가지 수준의 추상화를 포함합니다. 낮은 수준은 가장자리, 텍스처 요소 또는 영역과 같은 이미지 프리미티브를 포함하고, 중간 수준은 경계, 표면 및 볼륨을 포함하고, 높은 수준은 객체, 장면 또는 이벤트를 포함합니다. 이러한 요구 사항 중 많은 부분은 전적으로 추가 연구를 위한 주제입니다.

이러한 수준에 대한 IUS 설계의 표현 요구 사항은 프로토타입 개념, 개념 조직, 공간 지식, 시간 지식, 스케일링 및 비교 및 차별화에 의한 설명의 표현입니다.

추론이 현재 알려진 사실로부터 명시적으로 표현되지 않은 새로운 사실을 도출하는 과정을 의미한다면, 통제는 많은 추론, 검색, 매칭 기법 중 어떤 기법을 특정 처리 단계에서 적용해야 하는지 선택하는 과정을 의미합니다. IUS에 대한 추론 및 제어 요구 사항은 검색 및 가설 활성화, 일치 및 가설 테스트, 기대의 생성 및 사용, 주의의 변화 및 초점, 믿음의 확실성 및 강도, 추론 및 목표 만족입니다.[44]

하드웨어

컴퓨터 비전 시스템에는 여러 종류가 있지만, 전원, 적어도 하나의 영상 획득 장치(카메라, ccd 등), 프로세서, 제어 및 통신 케이블 또는 일종의 무선 상호 연결 메커니즘과 같은 기본 요소가 모두 포함되어 있습니다. 또한, 실용적인 비전 시스템은 소프트웨어와 함께 시스템을 모니터링하기 위한 디스플레이를 포함합니다. 대부분의 산업용 시스템과 마찬가지로 내부 공간을 위한 비전 시스템에는 조명 시스템이 포함되어 있으며 제어 가능한 환경에 배치될 수 있습니다. 또한 완성된 시스템에는 카메라 지지대, 케이블 및 커넥터와 같은 많은 액세서리가 포함됩니다.

대부분의 컴퓨터 비전 시스템은 초당 최대 60프레임의 프레임 속도(일반적으로 훨씬 느린 속도)로 장면을 수동적으로 보는 가시광 카메라를 사용합니다.

몇몇 컴퓨터 비전 시스템은 능동 조명이 있는 이미지 획득 하드웨어 또는 가시광이 아닌 다른 것 또는 둘 다를 사용합니다. 예를 들어, 구조광 3D 스캐너, 서모그래피 카메라, 초분광 이미저, 레이더 이미징, 라이다 스캐너, 자기 공명 영상, 측면 스캔 음파 탐지기, 합성 조리개 음파 탐지기 등입니다. 이러한 하드웨어는 가시광선 이미지를 처리하는 데 사용되는 것과 동일한 컴퓨터 비전 알고리즘을 사용하여 종종 처리되는 "이미지"를 캡처합니다.

전통적인 방송 및 소비자 비디오 시스템이 초당 30프레임의 속도로 작동하는 반면, 디지털 신호 처리 및 소비자 그래픽 하드웨어의 발전으로 초당 수백에서 수천 프레임 정도의 고속 영상 획득, 처리 및 디스플레이가 가능해졌습니다. 로봇 공학 분야의 응용 분야에서 빠른 실시간 비디오 시스템은 매우 중요하며 특정 알고리즘에 필요한 처리를 단순화할 수 있는 경우가 많습니다. 고속 프로젝터와 결합하면 빠른 영상 획득으로 3D 측정 및 특징 추적을 실현할 수 있습니다.[45]

자기중심적 시각 시스템은 1인칭 시점으로 자동으로 사진을 촬영하는 웨어러블 카메라로 구성됩니다.

2016년 현재 비전 프로세싱 유닛은 CPU와 그래픽 프로세싱 유닛(GPU)을 보완하기 위해 새로운 종류의 프로세서로 부상하고 있습니다.[46]

참고 항목

목록

참고문헌

- ^ a b Reinhard Klette (2014). Concise Computer Vision. Springer. ISBN 978-1-4471-6320-6.

- ^ a b Linda G. Shapiro; George C. Stockman (2001). Computer Vision. Prentice Hall. ISBN 978-0-13-030796-5.

- ^ a b Tim Morris (2004). Computer Vision and Image Processing. Palgrave Macmillan. ISBN 978-0-333-99451-1.

- ^ a b Bernd Jähne; Horst Haußecker (2000). Computer Vision and Applications, A Guide for Students and Practitioners. Academic Press. ISBN 978-0-13-085198-7.

- ^ Dana H. Ballard; Christopher M. Brown (1982). Computer Vision. Prentice Hall. ISBN 978-0-13-165316-0.

- ^ Huang, T. (1996-11-19). Vandoni, Carlo, E (ed.). Computer Vision : Evolution And Promise (PDF). 19th CERN School of Computing. Geneva: CERN. pp. 21–25. doi:10.5170/CERN-1996-008.21. ISBN 978-9290830955. Archived (PDF) from the original on 2018-02-07.

{{cite conference}}: CS1 메인트: 복수 이름: 편집자 목록(링크) - ^ Milan Sonka; Vaclav Hlavac; Roger Boyle (2008). Image Processing, Analysis, and Machine Vision. Thomson. ISBN 978-0-495-08252-1.

- ^ http://www.bmva.org/visionoverview Wayback Machine에 보관된 2017-02-16 영국 기계 비전 협회 및 패턴 인식 협회 2017년 2월 20일 검색

- ^ Murphy, Mike (13 April 2017). "Star Trek's "tricorder" medical scanner just got closer to becoming a reality". Archived from the original on 2 July 2017. Retrieved 18 July 2017.

- ^ 컴퓨터 비전 원리, 알고리즘, 애플리케이션, 학습 5th Edition by E.R. Davies Academic Press, Elselvier 2018 ISBN 978-0-12-809284-2

- ^ a b c d Richard Szeliski (30 September 2010). Computer Vision: Algorithms and Applications. Springer Science & Business Media. pp. 10–16. ISBN 978-1-84882-935-0.

- ^ Sejnowski, Terrence J. (2018). The deep learning revolution. Cambridge, Massachusetts London, England: The MIT Press. p. 28. ISBN 978-0-262-03803-4.

- ^ Papert, Seymour (1966-07-01). "The Summer Vision Project". MIT AI Memos (1959 - 2004). hdl:1721.1/6125.

- ^ Margaret Ann Boden (2006). Mind as Machine: A History of Cognitive Science. Clarendon Press. p. 781. ISBN 978-0-19-954316-8.

- ^ Takeo Kanade (6 December 2012). Three-Dimensional Machine Vision. Springer Science & Business Media. ISBN 978-1-4613-1981-8.

- ^ Nicu Sebe; Ira Cohen; Ashutosh Garg; Thomas S. Huang (3 June 2005). Machine Learning in Computer Vision. Springer Science & Business Media. ISBN 978-1-4020-3274-5.

- ^ William Freeman; Pietro Perona; Bernhard Scholkopf (2008). "Guest Editorial: Machine Learning for Computer Vision". International Journal of Computer Vision. 77 (1): 1. doi:10.1007/s11263-008-0127-7. hdl:21.11116/0000-0003-30FB-C. ISSN 1573-1405.

- ^ LeCun, Yann; Bengio, Yoshua; Hinton, Geoffrey (2015). "Deep Learning". Nature. 521 (7553): 436–444. Bibcode:2015Natur.521..436L. doi:10.1038/nature14539. PMID 26017442. S2CID 3074096.

- ^ Jiao, Licheng; Zhang, Fan; Liu, Fang; Yang, Shuyuan; Li, Lingling; Feng, Zhixi; Qu, Rong (2019). "A Survey of Deep Learning-Based Object Detection". IEEE Access. 7: 128837–128868. arXiv:1907.09408. Bibcode:2019IEEEA...7l8837J. doi:10.1109/ACCESS.2019.2939201. S2CID 198147317.

- ^ Ferrie, C., & Kaiser, S. (2019). Neural Networks for Babies. Sourcebooks. ISBN 978-1492671206.

{{cite book}}: CS1 maint: 다중 이름: 작성자 목록(링크) - ^ a b Steger, Carsten; Markus Ulrich; Christian Wiedemann (2018). Machine Vision Algorithms and Applications (2nd ed.). Weinheim: Wiley-VCH. p. 1. ISBN 978-3-527-41365-2. Archived from the original on 2023-03-15. Retrieved 2018-01-30.

- ^ 머레이, 돈, 컬렌 제닝스. "이동 로봇용 스테레오비전 기반 매핑 및 내비게이션 2020-10-31 Achared at Wayback Machine" 로봇 및 자동화에 관한 국제 회의의 진행. Vol. 2. IEEE, 1997.

- ^ a b c Soltani, A. A.; Huang, H.; Wu, J.; Kulkarni, T. D.; Tenenbaum, J. B. (2017). "Synthesizing 3D Shapes via Modeling Multi-view Depth Maps and Silhouettes with Deep Generative Networks". 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). pp. 1511–1519. doi:10.1109/CVPR.2017.269. hdl:1721.1/126644. ISBN 978-1-5386-0457-1. S2CID 31373273.

- ^ Turek, Fred (June 2011). "Machine Vision Fundamentals, How to Make Robots See". NASA Tech Briefs Magazine. 35 (6). 60-62페이지

- ^ "The Future of Automated Random Bin Picking". Archived from the original on 2018-01-11. Retrieved 2018-01-10.

- ^ Chervyakov, N. I.; Lyakhov, P. A.; Deryabin, M. A.; Nagornov, N. N.; Valueva, M. V.; Valuev, G. V. (2020). "Residue Number System-Based Solution for Reducing the Hardware Cost of a Convolutional Neural Network". Neurocomputing. 407: 439–453. doi:10.1016/j.neucom.2020.04.018. S2CID 219470398.

Convolutional neural networks (CNNs) represent deep learning architectures that are currently used in a wide range of applications, including computer vision, speech recognition, identification of albuminous sequences in bioinformatics, production control, time series analysis in finance, and many others.

- ^ Wäldchen, Jana; Mäder, Patrick (2017-01-07). "Plant Species Identification Using Computer Vision Techniques: A Systematic Literature Review". Archives of Computational Methods in Engineering. 25 (2): 507–543. doi:10.1007/s11831-016-9206-z. ISSN 1134-3060. PMC 6003396. PMID 29962832.

- ^ a b c d e f E. Roy Davies (2005). Machine Vision: Theory, Algorithms, Practicalities. Morgan Kaufmann. ISBN 978-0-12-206093-9.

- ^ Ando, Mitsuhito; Takei, Toshinobu; Mochiyama, Hiromi (2020-03-03). "Rubber artificial skin layer with flexible structure for shape estimation of micro-undulation surfaces". ROBOMECH Journal. 7 (1): 11. doi:10.1186/s40648-020-00159-0. ISSN 2197-4225.

- ^ Choi, Seung-hyun; Tahara, Kenji (2020-03-12). "Dexterous object manipulation by a multi-fingered robotic hand with visual-tactile fingertip sensors". ROBOMECH Journal. 7 (1): 14. doi:10.1186/s40648-020-00162-5. ISSN 2197-4225.

- ^ Garg, Hitendra (2020-02-29). "Drowsiness Detection of a Driver using Conventional Computer Vision Application". 2020 International Conference on Power Electronics & IoT Applications in Renewable Energy and its Control (PARC). pp. 50–53. doi:10.1109/PARC49193.2020.236556. ISBN 978-1-7281-6575-2. S2CID 218564267. Archived from the original on 2022-06-27. Retrieved 2022-11-06.

- ^ Hasan, Fudail; Kashevnik, Alexey (2021-05-14). "State-of-the-Art Analysis of Modern Drowsiness Detection Algorithms Based on Computer Vision". 2021 29th Conference of Open Innovations Association (FRUCT). pp. 141–149. doi:10.23919/FRUCT52173.2021.9435480. ISBN 978-952-69244-5-8. S2CID 235207036. Archived from the original on 2022-06-27. Retrieved 2022-11-06.

- ^ Balasundaram, A; Ashokkumar, S; Kothandaraman, D; kora, SeenaNaik; Sudarshan, E; Harshaverdhan, A (2020-12-01). "Computer vision based fatigue detection using facial parameters". IOP Conference Series: Materials Science and Engineering. 981 (2): 022005. Bibcode:2020MS&E..981b2005B. doi:10.1088/1757-899x/981/2/022005. ISSN 1757-899X. S2CID 230639179.

- ^ a b Bruijning, Marjolein; Visser, Marco D.; Hallmann, Caspar A.; Jongejans, Eelke; Golding, Nick (2018). "trackdem: Automated particle tracking to obtain population counts and size distributions from videos in r". Methods in Ecology and Evolution. 9 (4): 965–973. Bibcode:2018MEcEv...9..965B. doi:10.1111/2041-210X.12975. hdl:2066/184075. ISSN 2041-210X.

- ^ David A. Forsyth; Jean Ponce (2003). Computer Vision, A Modern Approach. Prentice Hall. ISBN 978-0-13-085198-7.

- ^ Forsyth, David; Ponce, Jean (2012). Computer vision: a modern approach. Pearson.

- ^ a b Russakovsky, Olga; Deng, Jia; Su, Hao; Krause, Jonathan; Satheesh, Sanjeev; Ma, Sean; Huang, Zhiheng; Karpathy, Andrej; Khosla, Aditya; Bernstein, Michael; Berg, Alexander C. (December 2015). "ImageNet Large Scale Visual Recognition Challenge". International Journal of Computer Vision. 115 (3): 211–252. arXiv:1409.0575. doi:10.1007/s11263-015-0816-y. hdl:1721.1/104944. ISSN 0920-5691. S2CID 2930547. Archived from the original on 2023-03-15. Retrieved 2020-11-20.

- ^ Quinn, Arthur (2022-10-09). "AI Image Recognition: Inevitable Trending of Modern Lifestyle". TopTen.ai. Archived from the original on 2022-12-02. Retrieved 2022-12-23.

- ^ Barrett, Lisa Feldman; Adolphs, Ralph; Marsella, Stacy; Martinez, Aleix M.; Pollak, Seth D. (July 2019). "Emotional Expressions Reconsidered: Challenges to Inferring Emotion From Human Facial Movements". Psychological Science in the Public Interest. 20 (1): 1–68. doi:10.1177/1529100619832930. ISSN 1529-1006. PMC 6640856. PMID 31313636.

- ^ A. Maity (2015). "Improvised Salient Object Detection and Manipulation". arXiv:1511.02999 [cs.CV].

- ^ 바훗, 로렌. "Fuzzy-Spatial Tax on Cut을 사용한 이미지 세분화에 대한 시각적 세금 측정 접근법은 Wayback Machine에서 2018-11-14년에 보관된 상황별 관련 영역을 산출합니다." 지식기반시스템의 불확실성 정보처리 및 관리 스프링어 국제 출판사, 2014.

- ^ Liu, Ziyi; Wang, Le; Hua, Gang; Zhang, Qilin; Niu, Zhenxing; Wu, Ying; Zheng, Nanning (2018). "Joint Video Object Discovery and Segmentation by Coupled Dynamic Markov Networks" (PDF). IEEE Transactions on Image Processing. 27 (12): 5840–5853. Bibcode:2018ITIP...27.5840L. doi:10.1109/tip.2018.2859622. ISSN 1057-7149. PMID 30059300. S2CID 51867241. Archived from the original (PDF) on 2018-09-07. Retrieved 2018-09-14.

- ^ Wang, Le; Duan, Xuhuan; Zhang, Qilin; Niu, Zhenxing; Hua, Gang; Zheng, Nanning (2018-05-22). "Segment-Tube: Spatio-Temporal Action Localization in Untrimmed Videos with Per-Frame Segmentation" (PDF). Sensors. 18 (5): 1657. Bibcode:2018Senso..18.1657W. doi:10.3390/s18051657. ISSN 1424-8220. PMC 5982167. PMID 29789447. Archived (PDF) from the original on 2018-09-07.

- ^ Shapiro, Stuart C. (1992). Encyclopedia of Artificial Intelligence, Volume 1. New York: John Wiley & Sons, Inc. pp. 643–646. ISBN 978-0-471-50306-4.

- ^ Kagami, Shingo (2010). "High-speed vision systems and projectors for real-time perception of the world". 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition - Workshops. Vol. 2010. pp. 100–107. doi:10.1109/CVPRW.2010.5543776. ISBN 978-1-4244-7029-7. S2CID 14111100.

- ^ Seth Colaner (January 3, 2016). "A Third Type Of Processor For VR/AR: Movidius' Myriad 2 VPU". www.tomshardware.com. Archived from the original on March 15, 2023. Retrieved May 3, 2016.

추가읽기

- James E. Dobson (2023). The Birth of Computer Vision. University of Minnesota Press. ISBN 978-1-5179-1421-9.

- David Marr (1982). Vision. W. H. Freeman and Company. ISBN 978-0-7167-1284-8.

- Azriel Rosenfeld; Avinash Kak (1982). Digital Picture Processing. Academic Press. ISBN 978-0-12-597301-4.

- Barghout, Lauren; Lawrence W. Lee (2003). Perceptual information processing system. U.S. Patent Application 10/618,543. ISBN 978-0-262-08159-7.

- Berthold K.P. Horn (1986). Robot Vision. MIT Press. ISBN 978-0-262-08159-7.

- Michael C. Fairhurst (1988). Computer Vision for robotic systems. Prentice Hall. ISBN 978-0-13-166919-2.

- Olivier Faugeras (1993). Three-Dimensional Computer Vision, A Geometric Viewpoint. MIT Press. ISBN 978-0-262-06158-2.

- Tony Lindeberg (1994). Scale-Space Theory in Computer Vision. Springer. ISBN 978-0-7923-9418-1.

- James L. Crowley and Henrik I. Christensen (Eds.) (1995). Vision as Process. Springer-Verlag. ISBN 978-3-540-58143-7.

- Gösta H. Granlund; Hans Knutsson (1995). Signal Processing for Computer Vision. Kluwer Academic Publisher. ISBN 978-0-7923-9530-0.

- Reinhard Klette; Karsten Schluens; Andreas Koschan (1998). Computer Vision – Three-Dimensional Data from Images. Springer, Singapore. ISBN 978-981-3083-71-4.

- Emanuele Trucco; Alessandro Verri (1998). Introductory Techniques for 3-D Computer Vision. Prentice Hall. ISBN 978-0-13-261108-4.

- Bernd Jähne (2002). Digital Image Processing. Springer. ISBN 978-3-540-67754-3.

- Richard Hartley and Andrew Zisserman (2003). Multiple View Geometry in Computer Vision. Cambridge University Press. ISBN 978-0-521-54051-3.

- Gérard Medioni; Sing Bing Kang (2004). Emerging Topics in Computer Vision. Prentice Hall. ISBN 978-0-13-101366-7.

- R. Fisher; K Dawson-Howe; A. Fitzgibbon; C. Robertson; E. Trucco (2005). Dictionary of Computer Vision and Image Processing. John Wiley. ISBN 978-0-470-01526-1.

- Nikos Paragios and Yunmei Chen and Olivier Faugeras (2005). Handbook of Mathematical Models in Computer Vision. Springer. ISBN 978-0-387-26371-7.

- Wilhelm Burger; Mark J. Burge (2007). Digital Image Processing: An Algorithmic Approach Using Java. Springer. ISBN 978-1-84628-379-6. Archived from the original on 2014-05-17. Retrieved 2007-06-13.

- Pedram Azad; Tilo Gockel; Rüdiger Dillmann (2008). Computer Vision – Principles and Practice. Elektor International Media BV. ISBN 978-0-905705-71-2.

- Richard Szeliski (2010). Computer Vision: Algorithms and Applications. Springer-Verlag. ISBN 978-1848829343.

- J. R. Parker (2011). Algorithms for Image Processing and Computer Vision (2nd ed.). Wiley. ISBN 978-0470643853.

- Richard J. Radke (2013). Computer Vision for Visual Effects. Cambridge University Press. ISBN 978-0-521-76687-6.

- Nixon, Mark; Aguado, Alberto (2019). Feature Extraction and Image Processing for Computer Vision (4th ed.). Academic Press. ISBN 978-0128149768.

외부 링크

- USC 아이리스 컴퓨터 비전 컨퍼런스 목록

- 웹의 컴퓨터 비전 논문 – 가장 관련성이 높은 컴퓨터 비전 컨퍼런스의 전체 논문 목록입니다.

- 컴퓨터 비전 온라인 아카이브 2011-11-30 Wayback Machine – 컴퓨터 비전과 관련된 뉴스, 소스 코드, 데이터 세트 및 구인

- CV online – 밥 피셔의 컴퓨터 비전 개요.

- British Machine Vision Association – BMVC 및 MIUA 컨퍼런스, Annals of the BMVA(오픈 소스 저널), BMVA Summer School 및 당일 미팅을 통해 영국 내 컴퓨터 비전 연구 지원

- 컴퓨터 비전 컨테이너, Joe Hoeller GitHub: GPU 가속 컴퓨터 비전 애플리케이션을 위해 널리 채택된 오픈 소스 컨테이너입니다. 연구원, 대학, 민간 기업은 물론 미국 정부에서도 사용합니다.