변압기(기계 학습 모델)

Transformer (machine learning model)| 시리즈의 일부 |

| 기계 학습 및 데이터 마이닝 |

|---|

|

변압기는 입력 데이터의 각 부분의 중요성에 차등을 두고 자기 주의 메커니즘을 채택하는 딥 러닝 모델입니다.주로 자연어 처리(NLP)[1] 및 컴퓨터 비전(CV)[2] 분야에서 사용됩니다.

RNN(Recurrent Neural Network)과 마찬가지로 변환기는 번역 및 텍스트 요약과 같은 작업을 위한 애플리케이션을 사용하여 자연 언어와 같은 순차적 입력 데이터를 처리하도록 설계되었습니다.그러나 RNN과 달리 변압기는 전체 입력을 한꺼번에 처리합니다.주의 메커니즘은 입력 시퀀스의 모든 위치에 대한 컨텍스트를 제공합니다.예를 들어 입력 데이터가 자연어 문인 경우 변환기는 한 번에 한 단어를 처리할 필요가 없습니다.이를 통해 RNN보다 더 많은 병렬화가 가능하므로 교육 [1]시간이 단축됩니다.

트랜스포머는 Google[1] Brain의 팀에 의해 2017년에 도입되어 롱 단기 메모리(LSTM)와 같은 RNN 모델을 대체하면서 NLP 문제에 [3]대한 선택 모델이 되고 있습니다.추가적인 교육 병렬화를 통해 대규모 데이터셋에 대한 교육이 가능합니다.이를 통해 BERT(Bidirectional Encoder Representations from Transformers) 및 GPT(Generative Pre-Trained Transformer)와 같은 사전 훈련 시스템이 개발되었으며, 이는 위키피디아 말뭉치 및 공통 크롤과 같은 대규모 언어 데이터셋으로 훈련되었으며 특정 [4][5]작업에 대해 미세 조정할 수 있다.

배경

변압기 이전에 대부분의 최첨단 NLP 시스템은 LSTM 및 게이트 반복 단위(GRU)와 같은 게이트 RNN에 의존했으며, 추가적인 주의 메커니즘이 있었다.변압기도 주의 메커니즘을 사용하지만 RNN과 달리 반복 구조를 가지고 있지 않다.즉, 충분한 훈련 데이터가 제공되면 주의 메커니즘만으로도 [1]주의력이 있는 RNN의 성능과 일치할 수 있다.

순차 처리

게이트 RNN은 토큰을 순차적으로 처리하여 모든 토큰 뒤에 표시되는 데이터의 표현을 포함하는 상태 벡터를 유지합니다.을 처리하기 위해 모델은 토큰 n-까지 을 나타내는 상태와 새로운 토큰 정보를 결합하여 까지 문장을 나타내는 새로운 상태를 만듭니다이론적으로 상태가 토큰에 대한 컨텍스트 정보를 계속 인코딩하는 경우, 1개의 토큰으로부터의 정보는 시퀀스에 따라 임의로 전파될 수 있습니다.실제로 이 메커니즘은 결함이 있습니다. 즉, 사라져가는 구배 문제는 이전 토큰에 대한 정확하고 추출 가능한 정보가 없는 긴 문장 끝에 모델의 상태를 남깁니다.이전 토큰 계산 결과에 대한 토큰 계산의 의존성은 또한 현대의 딥 러닝 하드웨어에 대한 계산을 병렬화하는 것을 어렵게 만든다.이로 인해 RNN 훈련이 비효율적일 수 있습니다.

자기 주의

이러한 문제는 주의 메커니즘을 통해 해결되었다.주의 메커니즘은 모델이 시퀀스를 따라 이전의 모든 지점에서 상태를 그릴 수 있도록 합니다.주의 계층은 이전의 모든 상태에 액세스하고 학습된 관련성 측정에 따라 가중치를 부여하여 멀리 떨어진 토큰에 대한 관련 정보를 제공할 수 있습니다.

주의의 가치에 대한 명확한 예는 언어 번역에서, 문맥은 문장에서 단어의 의미를 할당하는 데 필수적입니다.영어-프랑스어 번역 시스템에서 프랑스어 출력의 첫 단어는 영어 입력의 첫 번째 몇 단어에 크게 의존합니다.단, 고전적인 LSTM 모델에서는 프랑스어 출력의 첫 번째 단어를 생성하기 위해 마지막 영어 단어를 처리한 후 모델에는 상태 벡터만 부여됩니다.이론적으로, 이 벡터는 영어 문장 전체에 대한 정보를 부호화할 수 있으며, 모델에 필요한 모든 지식을 제공합니다.실제로 이 정보는 LSTM에 의해 잘 보존되지 않는 경우가 많습니다.이 문제에 대처하기 위해 주의 메커니즘을 추가할 수 있습니다.디코더는 마지막뿐만 아니라 모든 영어 입력 워드의 상태 벡터에 액세스 할 수 있으며, 각 영어 입력 상태 벡터에 얼마나 주의를 기울여야 하는지를 지시하는 주의 가중치를 학습할 수 있습니다.

RNN에 주의 메커니즘을 추가하면 성능이 향상됩니다.트랜스포머 아키텍처의 개발은 주의 메커니즘이 그 자체로 강력하며 주의를 기울여 RNN의 품질 향상을 달성하기 위해 데이터의 순차적 반복 처리가 필요하지 않다는 것을 밝혀냈다.변압기는 RNN이 없는 주의 메커니즘을 사용하여 모든 토큰을 동시에 처리하고 연속된 레이어에서 이들 사이의 주의 가중치를 계산합니다.주의 메커니즘은 하위 계층의 다른 토큰에 대한 정보만 사용하기 때문에, 모든 토큰에 대해 병렬로 계산될 수 있으므로 교육 속도가 향상됩니다.

아키텍처

입력

입력 텍스트는 바이트 쌍 부호화 토큰화자에 의해 토큰으로 해석되며 각 토큰은 단어 삽입을 통해 벡터로 변환됩니다.그 후, 토큰의 위치 정보가 단어 삽입에 부가된다.

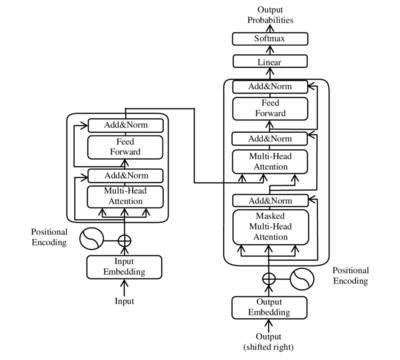

인코더-디코더 아키텍처

이전의 seq2seq 모델과 마찬가지로 원래의 트랜스포머 모델에서는 인코더-디코더 아키텍처를 사용했습니다.인코더는 입력을 1층씩 반복 처리하는 부호화 레이어로 구성되어 있으며, 디코더는 인코더의 출력에 동일한 작업을 수행하는 복호화 레이어로 구성되어 있습니다.

각 인코더 레이어의 기능은 입력의 어느 부분이 서로 관련되어 있는지에 대한 정보를 포함하는 인코딩을 생성하는 것입니다.입력으로서 부호화를 다음의 인코더 레이어에 전달합니다.각 디코더 층은 반대로 모든 인코딩을 받아들여 내장된 컨텍스트 정보를 사용하여 출력 [6]시퀀스를 생성한다.이를 위해 각 인코더 및 디코더 레이어는 어텐션메커니즘을 사용합니다.

각 입력에 대해 주의력은 다른 모든 입력의 관련성을 따져보고 [7]이들로부터 결과를 도출한다.각 디코더 층은 디코더 층이 부호화로부터 정보를 취득하기 전에 이전의 디코더 출력으로부터 정보를 취득하는 추가 주의 메커니즘을 가진다.

인코더층 및 디코더층 모두 출력의 추가 처리를 위한 피드포워드 뉴럴 네트워크를 가지며, 잔류접속 및 레이어 정규화 [7]단계를 포함한다.

도트 제품에 대한 관심 확대

변압기 구성 요소는 스케일링된 도트 제품 주의 단위입니다.문장이 변압기 모델로 전달되면 주의 가중치가 모든 토큰 간에 동시에 계산됩니다.주의 유닛은 주의 무게에 따라 가중치가 부여되는 다른 관련 토큰의 가중 조합과 함께 토큰 자체에 대한 정보를 포함하는 컨텍스트 내의 모든 토큰에 대한 임베딩을 생성합니다.

각 주의 유닛에 대해 트랜스포머 모델은 3개의 가중치 매트릭스( Q 키 W K 값 V 각 i(\ 를 학습합니다.각 토큰 i(\ i에 대해 입력 x{{Vi을(를) 3개의 가중치 매트릭스와 각각 곱하여 쿼리 {ii})를 한다. 키 i i}=}) 및 값 V (\{i}=}) 주의의 가중치는 쿼리와 키 벡터를 사용하여 계산됩니다.i {\i}에서 j {\ j까지의 주의 는 i {\와 j { 사이의 곱입니다.주의 가중치는 키 벡터 치수의 제곱근 d 로 나누어 훈련 중 구배를 안정화하며 가중치를 정규화하는 소프트맥스를 통과합니다. Q와 K는 서로 다른 매트릭스이기 때문에 주의를 비대칭으로 할 수 있습니다.예를 i i가 jj})에 참여하는 경우 이는 반드시 큰 의미가 아닙니다.j {\ j는 i {\ i: j k { style _ { } \ _ { )에 적용됩니다.의 주의 유닛의 출력은모든 토큰의 값 벡터의 가중치 합계입니다. 값은 토큰 i에서 각 토큰에 대한 주의 값 i로 가중치는 j{\입니다.

모든 토큰에 대한 주의력 계산은 softmax 함수를 사용하여 하나의 큰 행렬 계산으로 표현할 수 있으며, 행렬 연산을 빠르게 계산하는 계산 행렬 연산 최적화로 인해 훈련에 유용합니다.Q(\ Q K V V는 i i의 각 행이 (\ 인 행렬로 정의됩니다.

멀티헤드 어텐션

( , K , ) { ( _ { , W _ { , { V} \ ) 매트릭스의1 세트를 어텐션헤드라고 부릅니다.트랜스 모델의 각 레이어에는 복수의 어텐션헤드가 있습니다.각 주의 헤드는 각 토큰과 관련된 토큰에 관심을 가지며, 여러 주의 헤드를 사용하여 모델은 "관련성"에 대한 다양한 정의에 대해 이 작업을 수행할 수 있습니다.또한 관련성을 나타내는 영향 영역은 연속적인 계층에서 점진적으로 확장될 수 있다.많은 변압기 주의 헤드는 인간에게 의미 있는 관련성을 부호화한다.예를 들어, 주의 헤드는 주로 다음 단어에 집중할 수 있는 반면, 다른 사람들은 주로 동사에서 직접 [8]목적어에 집중할 수 있습니다.각 주의 헤드에 대한 연산은 병렬로 수행될 수 있으므로 빠른 처리가 가능합니다.주의 레이어에 대한 출력은 피드 포워드 뉴럴 네트워크 레이어에 전달되도록 연결됩니다.

인코더

각 인코더는 자기주의 메커니즘과 피드포워드 뉴럴 네트워크라는2개의 주요 컴포넌트로 구성됩니다.셀프 어텐션메커니즘은 이전 인코더로부터의 입력 인코딩을 받아들여 서로 관련성을 평가하여 출력 인코딩을 생성합니다.피드포워드 뉴럴 네트워크는 각 출력 부호화를 개별적으로 처리합니다.이러한 출력 부호화는 다음 인코더 및 디코더에 입력으로 전달됩니다.

첫 번째 인코더는 부호화가 아니라 입력 시퀀스의 위치 정보와 임베딩을 입력으로 받아들입니다.위치정보는 변압기의 다른 어떤 부분도 이를 이용하지 않기 때문에 [1]변압기가 시퀀스의 순서를 이용하기 때문입니다.

인코더는 양방향입니다.현재 토큰의 전후로 토큰에 주의를 기울일 수 있습니다.

위치 부호화

위치 부호화는 : R \ f : \ } \ \{의 정의됩니다여기서 d\ d는 정수입니다.

이 함수는 유형 d / {\ f \^{의 복소함수로 표기할 때 보다 단순한 형식입니다.

저자들이 이것을 위치 부호화 함수로 선택한 주된 이유는 선형 변환으로서 시프트를 수행할 수 있기 때문입니다.

선형 합계를 취함으로써 모든 컨볼루션도 선형 변환으로 구현할 수 있습니다.

일반적인 구현에서는 모든 연산은 복소수가 아닌 실수에 의해 이루어지지만, 복소수 곱셈은 실제 2x2 행렬 곱셈으로 구현될 수 있기 때문에 이는 단순한 표기상의 차이일 뿐입니다.

다른 위치 부호화 방식이 존재합니다.[9]

디코더

각 디코더는 자기 주의 메커니즘, 부호화 위의 주의 메커니즘 및 피드 포워드 뉴럴 네트워크의 3가지 주요 구성요소로 구성됩니다.디코더는 인코더와 같은 방법으로 기능하지만 인코더에 의해 생성된 인코딩에서 관련 정보를 얻는 추가 주의 메커니즘이 삽입됩니다.이 메커니즘은 인코더/디코더 [1][7]어텐션이라고도 불립니다.

첫 번째 디코더는 첫 번째 인코더와 마찬가지로 위치정보와 출력 시퀀스의 임베딩을 인코딩이 아닌 입력으로 받아들입니다.트랜스에서는 출력을 예측하기 위해 현재 출력 또는 미래 출력을 사용할 수 없으므로 출력 시퀀스를 부분적으로 마스킹하여 이 [1]역방향 정보 흐름을 방지해야 합니다.이를 통해 자동 회귀 텍스트 생성이 가능합니다.모든 주의 헤드에 대해 다음 토큰에 주의를 기울일 수 없습니다.마지막 디코더는 어휘에 대한 출력 확률을 생성하기 위해 최종 선형 변환과 softmax 레이어에 이어 이어집니다.

GPT는 디코더 전용 아키텍처입니다.

대체 수단

변압기 기반 아키텍처의 훈련은 특히 긴 입력의 경우 비용이 많이 [10]들 수 있습니다.대체 아키텍처로는 리폼러(O 2)에서O ( 로 계산 부하를 저감하는\O N또는 ETC/Big Bird (Nln N)와 같은 ( ( O가 있습니다[11]이 작업은 로컬리티에 민감한 해시 계층과 리버서블 [12][13]계층을 사용하여 수행됩니다.

일반 트랜스에서는 컨텍스트 창의 크기에서 2차 메모리 크기가 필요합니다.주의: 프리 트랜스포머는[14] 키를 값에 링크함으로써 변압기의 장점을 유지하면서 이를 선형 의존성으로 줄입니다.

변압기 아키텍처를 비교하기 위한 벤치마크가 2020년 [15]말에 도입되었습니다.

트레이닝

변압기는 일반적으로 감독되지 않은 사전 훈련을 포함한 자체 감독 학습과 감독된 미세 조정을 거친다.라벨이 붙은 트레이닝 데이터의 가용성이 한정되어 있기 때문에, 통상, 사전 트레이닝은 미세 조정보다 큰 데이터 세트에 대해서 실시됩니다.일반적으로 사전 훈련 및 미세 조정 작업은 다음과 같습니다.

적용들

트랜스포머는 기계번역이나 시계열 [17]예측 등의 자연언어 처리(NLP)에서 큰 성공을 거두고 있습니다.GPT-2, GPT-3, BERT, XLNet, RoBERTA 등의 많은 사전 훈련 모델에서는 이러한 다양한 NLP 관련 태스크를 수행할 수 있는 트랜스포머의 기능이 입증되어 실제 [4][5][18]응용 프로그램을 찾을 수 있습니다.여기에는 다음이 포함됩니다.

2020년에는 변압기 아키텍처, 구체적으로는 GPT-2가 [24]체스를 두도록 조정될 수 있는 것으로 나타났습니다.트랜스포머는 컨볼루션 뉴럴 [25][26]네트워크와 경쟁적인 결과로 영상 처리에 적용되었습니다.

실장

변압기 모델은 TensorFlow 및 PyTorch와 같은 표준 딥 러닝 프레임워크에서 구현되었다.

트랜스포머는 Hugging Face에서 제작한 라이브러리로 트랜스포머 기반 아키텍처와 사전 교육 모델을 [3]제공합니다.

「 」를 참조해 주세요.

레퍼런스

- ^ a b c d e f g h Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N.; Kaiser, Lukasz; Polosukhin, Illia (2017-06-12). "Attention Is All You Need". arXiv:1706.03762 [cs.CL].

- ^ He, Cheng (31 December 2021). "Transformer in CV". Transformer in CV. Towards Data Science.

- ^ a b Wolf, Thomas; Debut, Lysandre; Sanh, Victor; Chaumond, Julien; Delangue, Clement; Moi, Anthony; Cistac, Pierric; Rault, Tim; Louf, Remi; Funtowicz, Morgan; Davison, Joe; Shleifer, Sam; von Platen, Patrick; Ma, Clara; Jernite, Yacine; Plu, Julien; Xu, Canwen; Le Scao, Teven; Gugger, Sylvain; Drame, Mariama; Lhoest, Quentin; Rush, Alexander (2020). "Transformers: State-of-the-Art Natural Language Processing". Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations. pp. 38–45. doi:10.18653/v1/2020.emnlp-demos.6. S2CID 208117506.

- ^ a b c d "Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing". Google AI Blog. Retrieved 2019-08-25.

- ^ a b c "Better Language Models and Their Implications". OpenAI. 2019-02-14. Retrieved 2019-08-25.

- ^ "Sequence Modeling with Neural Networks (Part 2): Attention Models". Indico. 2016-04-18. Retrieved 2019-10-15.

- ^ a b c Alammar, Jay. "The Illustrated Transformer". jalammar.github.io. Retrieved 2019-10-15.

- ^ Clark, Kevin; Khandelwal, Urvashi; Levy, Omer; Manning, Christopher D. (August 2019). "What Does BERT Look at? An Analysis of BERT's Attention". Proceedings of the 2019 ACL Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Florence, Italy: Association for Computational Linguistics: 276–286. doi:10.18653/v1/W19-4828.

- ^ Dufter, Philipp; Schmitt, Martin; Schütze, Hinrich (2022-06-06). "Position Information in Transformers: An Overview". Computational Linguistics: 1–31. doi:10.1162/coli_a_00445. ISSN 0891-2017. S2CID 231986066.

- ^ Kitaev, Nikita; Kaiser, Łukasz; Levskaya, Anselm (2020). "Reformer: The Efficient Transformer". arXiv:2001.04451 [cs.LG].

- ^ "Constructing Transformers For Longer Sequences with Sparse Attention Methods". Google AI Blog. Retrieved 2021-05-28.

- ^ "Tasks with Long Sequences – Chatbot". Coursera.

- ^ "Reformer: The Efficient Transformer". Google AI Blog. Retrieved 2020-10-22.

- ^ Zhai, Shuangfei; Talbott, Walter; Srivastava, Nitish; Huang, Chen; Goh, Hanlin; Zhang, Ruixiang; Susskind, Josh (2021-09-21). "An Attention Free Transformer". arXiv:2105.14103 [cs.LG].

- ^ Tay, Yi; Dehghani, Mostafa; Abnar, Samira; Shen, Yikang; Bahri, Dara; Pham, Philip; Rao, Jinfeng; Yang, Liu; Ruder, Sebastian; Metzler, Donald (2020-11-08). "Long Range Arena: A Benchmark for Efficient Transformers". arXiv:2011.04006 [cs.LG].

- ^ a b Wang, Alex; Singh, Amanpreet; Michael, Julian; Hill, Felix; Levy, Omer; Bowman, Samuel (2018). "GLUE: A Multi-Task Benchmark and Analysis Platform for Natural Language Understanding". Proceedings of the 2018 EMNLP Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Stroudsburg, PA, USA: Association for Computational Linguistics: 353–355. arXiv:1804.07461. doi:10.18653/v1/w18-5446. S2CID 5034059.

- ^ Allard, Maxime (2019-07-01). "What is a Transformer?". Medium. Retrieved 2019-10-21.

- ^ Yang, Zhilin Dai, Zihang Yang, Yiming Carbonell, Jaime Salakhutdinov, Ruslan Le, Quoc V. (2019-06-19). XLNet: Generalized Autoregressive Pretraining for Language Understanding. OCLC 1106350082.

{{cite book}}: CS1 maint: 여러 이름: 작성자 목록(링크) - ^ Monsters, Data (2017-09-26). "10 Applications of Artificial Neural Networks in Natural Language Processing". Medium. Retrieved 2019-10-21.

- ^ Rives, Alexander; Goyal, Siddharth; Meier, Joshua; Guo, Demi; Ott, Myle; Zitnick, C. Lawrence; Ma, Jerry; Fergus, Rob (2019). "Biological structure and function emerge from scaling unsupervised learning to 250 million protein sequences". bioRxiv 10.1101/622803.

- ^ Nambiar, Ananthan; Heflin, Maeve; Liu, Simon; Maslov, Sergei; Hopkins, Mark; Ritz, Anna (2020). "Transforming the Language of Life: Transformer Neural Networks for Protein Prediction Tasks". doi:10.1145/3388440.3412467. S2CID 226283020.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Rao, Roshan; Bhattacharya, Nicholas; Thomas, Neil; Duan, Yan; Chen, Xi; Canny, John; Abbeel, Pieter; Song, Yun S. (2019). "Evaluating Protein Transfer Learning with TAPE". bioRxiv 10.1101/676825.

- ^ Bertasias; Wang; Torresani (2021). "Is Space-Time Attention All You Need for Video Understanding?". arXiv:2102.05095 [cs.CV].

- ^ Noever, David; Ciolino, Matt; Kalin, Josh (2020-08-21). "The Chess Transformer: Mastering Play using Generative Language Models". arXiv:2008.04057 [cs.AI].

- ^ Dosovitskiy, Alexey; Beyer, Lucas; Kolesnikov, Alexander; Weissenborn, Dirk; Zhai, Xiaohua; Unterthiner, Thomas; Dehghani, Mostafa; Minderer, Matthias; Heigold, Georg; Gelly, Sylvain; Uszkoreit, Jakob; Houlsby, Neil (2020). "An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale". arXiv:2010.11929 [cs.CV].

{{cite arxiv}}:Cite에 알 수 없는 매개 변수가 비어 있습니다.access-date=그리고.website=(도움말) - ^ Touvron, Hugo; Cord, Matthieu; Douze, Matthijs; Massa, Francisco; Sablayrolles, Alexandre; Jégou, Hervé (2020). "Training data-efficient image transformers & distillation through attention". arXiv:2012.12877 [cs.CV].

{{cite arxiv}}:Cite에 알 수 없는 매개 변수가 비어 있습니다.access-date=그리고.website=(도움말)

(를) 3개의 가중치 매트릭스와 각각 곱하여 쿼리

(를) 3개의 가중치 매트릭스와 각각 곱하여 쿼리

주의

주의

i

i

행렬로 정의됩니다.

행렬로 정의됩니다.

위치 부호화 함수에 입력되는

위치 부호화 함수에 입력되는  훨씬 큰 자유 파라미터입니다.원본

훨씬 큰 자유 파라미터입니다.원본

이동하려는 거리입니다.이것에 의해, 트랜스포머는 임의의 부호화 위치를 취득해, 행렬 곱셈에 의해서, 1 스텝 선행 또는 1 스텝 배후의 위치의 부호화를 찾아낼 수 있습니다.

이동하려는 거리입니다.이것에 의해, 트랜스포머는 임의의 부호화 위치를 취득해, 행렬 곱셈에 의해서, 1 스텝 선행 또는 1 스텝 배후의 위치의 부호화를 찾아낼 수 있습니다.

계산 부하를 저감하는\

계산 부하를 저감하는\