심층강화학습

Deep reinforcement learning| 시리즈의 일부 |

| 기계학습 및 데이터 마이닝 |

|---|

|

딥 강화 학습(deep RL)은 강화 학습(RL)과 딥 러닝을 결합한 머신 러닝의 하위 분야입니다. RL은 시행착오를 통해 의사결정을 내리는 계산 에이전트 학습의 문제를 고려합니다. Deep RL은 딥 러닝을 솔루션에 통합하여 에이전트가 상태 공간을 수동으로 조작하지 않고도 비정형 입력 데이터로 의사 결정을 내릴 수 있습니다. 딥 RL 알고리즘은 매우 큰 입력(예: 비디오 게임에서 화면에 렌더링되는 모든 픽셀)을 받아들여 목표를 최적화하기 위해 수행할 작업을 결정할 수 있습니다(예: 게임 점수 최대화). 심층 강화 학습은 로봇 공학, 비디오 게임, 자연어 처리, 컴퓨터 비전, 교육, 교통, 금융 및 의료를 포함하지만 이에 국한되지 않는 다양한 응용 분야에 사용되었습니다.[1]

개요

딥러닝

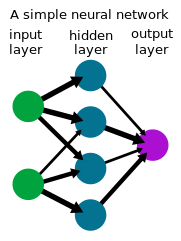

딥 러닝은 인공 신경망을 통해 입력 집합을 출력 집합으로 변환하기 위해 신경망을 활용하는 기계 학습의 한 형태입니다. 종종 레이블이 지정된 데이터 세트와 함께 지도 학습을 사용하는 딥 러닝 방법은 이미지와 같은 복잡한 고차원 원시 입력 데이터를 처리하는 작업을 이전 방법보다 수동 기능 엔지니어링으로 해결하는 것으로 나타났습니다. 컴퓨터 비전 및 자연어 처리를 포함한 여러 분야에서 상당한 발전을 가능하게 합니다. 지난 10년 동안 딥 RL은 GO, Atari Games, Dota 2와 같은 싱글 및 멀티플레이어 게임부터 로봇공학에[2] 이르기까지 다양한 문제에서 놀라운 성과를 거두었습니다.

강화학습

강화학습은 에이전트가 시행착오를 통해 의사결정을 하는 것을 배우는 과정입니다. 이 문제는 종종 매 단계의 에이전트가 {\displaystyle s 에 있고 동작을 취하고스칼라 보상을 받고 환경 역학 에 따라 다음 s로 전환되는 마르코프 결정 프로세스(MDP)로 수학적으로 모델링됩니다 에이전트가 반환(예상 보상 합계)을 최대화하기 위해 정책(예 s))를 학습하거나 관찰에서 수행으로 매핑하려고 시도합니다. (최적 제어와는 반대로) 강화 학습에서 알고리즘은 샘플링을 통해 역학 a에만 액세스할 수 있습니다.

심층강화학습

많은 실제적인 의사 결정 문제에서 MDP의 {\는 고차원(예: 카메라의 이미지 또는 로봇의 원시 센서 스트림)이며 기존의 RL 알고리즘으로는 해결할 수 없습니다. 딥 강화 학습 알고리즘은 이러한 MDP를 해결하기 위해 딥 러닝을 통합하며, 종종 정책π(예 as)) 또는 기타 학습된 기능을 신경망으로 표현하고 이 설정에서 잘 수행되는 전문 알고리즘을 개발합니다.

역사

1980년대 중반부터 신경망에 대한 관심이 높아지면서 신경망이 강화 학습에 사용되어 정책이나 가치 기능을 나타내는 심층 강화 학습에 대한 관심이 높아졌습니다. 이러한 시스템에서는 로봇이나 에이전트의 센서에서 모터에 이르기까지 의사결정 전 과정이 하나의 신경망을 포함하기 때문에 엔드 투 엔드 강화 학습이라고도 합니다.[3] 신경망을 이용한 강화 학습의 첫 번째 성공적인 응용 프로그램 중 하나는 TD-Gamon으로, 1992년에 백개먼을 재생하기 위해 개발된 컴퓨터 프로그램입니다.[4] 보드의 특정 위치에서 주어진 색상의 조각 수에 대해 4개의 입력이 사용되었으며 총 198개의 입력 신호가 사용되었습니다. 제로 지식이 내장된 네트워크는 셀프 플레이와 TD(λdisplaystyle\lambda를 통해 중간 수준에서 게임을 하는 방법을 배웠습니다.

강화 학습에 관한 서튼과 바툰의 중요한 교과서,[5] 신경동역학 프로그래밍에 관한 Bertsekas와 Tsitiklis [6]등이[7] 이 분야에 대한 지식과 관심을 향상시켰습니다.

시바타 카츠나리 그룹은 이 프레임워크에서 이미지 인식,[8][9][10] 색 항상성, 센서 동작(능동 인식), 손과 눈의 협응 및 손에 도달하는 동작, 뇌 활동에 대한 설명, 지식 전달,[11] 기억, 선택적 주의, 예측 및 탐색 등 다양한 기능이 나타난다는 것을 보여주었습니다.[9][12]

2012년경부터 시작된 소위 딥 러닝 혁명으로 인해 다양한 도메인에 걸쳐 딥 뉴럴 네트워크를 기능 근사자로 사용하는 데 대한 관심이 높아졌습니다. 이로 인해 기존 강화 학습 알고리즘에 존재하는 정책, 가치 및/또는 Q 기능을 학습하기 위해 심층 신경망을 사용하는 연구자에 대한 관심이 다시 높아졌습니다.

2013년경부터 DeepMind는 Atari 비디오 게임을 하기 위해 deep RL을 사용하여 인상적인 학습 결과를 보여주었습니다.[13][14] 컴퓨터 플레이어는 게임 점수를 보상으로 하여 딥 Q-네트워크(DQN)라고 하는 딥 버전의 Q-러닝인 딥 RL 알고리즘을 사용하여 신경망을 훈련했습니다. 그들은 4프레임 RGB 픽셀(84x84)을 입력으로 처리하기 위해 심층 컨볼루션 신경망을 사용했습니다. 49개의 모든 게임은 동일한 네트워크 아키텍처를 사용하여 최소한의 사전 지식으로 학습되어 거의 모든 게임에서 경쟁 방식을 능가하고 전문 인간 게임 테스터와 비슷하거나 우수한 수준의 성능을 발휘했습니다.[14]

딥 강화 학습은 2015년 딥 RL로 바둑을 두도록 훈련된 컴퓨터 프로그램인 [15]알파고가 19×19 크기의 풀사이즈 보드에서 인간 프로 바둑기사를 핸디캡 없이 이긴 최초의 컴퓨터 바둑 프로그램이 되면서 또 다른 이정표를 세웠습니다. 2017년 후속 프로젝트에서 알파제로는 바둑에서 성능을 향상시키는 동시에 동일한 알고리즘을 사용하여 해당 게임의 기존 컴퓨터 프로그램보다 경쟁력 있거나 우수한 수준으로 체스와 장기를 두는 방법을 배울 수 있음을 입증했으며 2019년 뮤제로로 다시 개선되었습니다.[16] 이와는 별도로, 2019년 카네기 멜론 대학의 연구원들이 무제한 텍사스 홀드의 멀티플레이어 게임에서 프로를 이긴 최초의 포커 게임인 플루리버스를 개발함으로써 또 다른 이정표를 세웠습니다. OpenAI 파이브, 5대 5 도타 2를 플레이하는 프로그램은 2019년 시범 경기에서 이전 세계 챔피언을 이겼습니다.

딥 강화 학습은 게임을 넘어 많은 영역에도 적용되었습니다. 로봇공학에서는 로봇이 간단한 집안일을 하고 로봇 손으로[17] 루빅스 큐브를 해결하는 데 사용되었습니다.[18][19] Deep RL은 데이터 센터의 에너지 소비를 줄이는 데 사용되는 지속 가능성 애플리케이션도 발견했습니다.[20] 자율주행을 위한 Deep RL은 학계와 산업계의 활발한 연구 분야입니다.[21] Loon은 그들의 높은 고도의 풍선을 자율적으로 항해하기 위해 깊은 RL을 탐사했습니다.[22]

알고리즘

심층 강화 학습 알고리즘으로 과제를 해결하기 위한 정책을 훈련하기 위한 다양한 기술이 존재하며, 각각의 장점이 있습니다. 가장 높은 수준에서는 모델 기반 강화 학습과 모델 없는 강화 학습이 구분되는데, 이는 알고리즘이 환경 역학의 순방향 모델을 학습하려고 시도하는지 여부를 의미합니다.

모델 기반 심층 강화 학습 알고리즘에서 환경 역학의 순방향 모델은 일반적으로 신경망을 사용한 지도 학습에 의해 추정됩니다. 그런 다음 학습된 모델을 사용하여 모델 예측 제어를 사용하여 동작을 얻습니다. 실제 환경 역학은 일반적으로 학습된 역학과 다르기 때문에 에이전트는 환경에서 작업을 수행할 때 종종 다시 계획합니다. 선택된 동작은 교차 엔트로피 방법과 같은 몬테카를로 방법을 사용하거나, 모델이 없는 방법과 모델 학습의 조합을 사용하여 최적화될 수 있습니다.

모델이 없는 심층 강화 학습 알고리즘에서는 순방향 역학을 명시적으로 모델링하지 않고 정책π(예 (as))를 학습합니다. 정책은 정책 기울기를[23] 직접 추정하여 수익률을 최대화하도록 최적화할 수 있지만 분산이 높아 심층 RL에서 함수 근사와 함께 사용하기에는 비현실적입니다. 보다 안정적인 학습을 위해 후속 알고리즘이 개발되어 널리 적용되고 있습니다.[24][25] 또 다른 종류의 모델 없는 심층 강화 학습 알고리즘은 시간차 학습과 Q-러닝에서 영감을 받은 동적 프로그래밍에 의존합니다. In discrete action spaces, these algorithms usually learn a neural network Q-function that estimates the future returns taking action from state .[13] In continuous spaces, these algorithms often learn both a value estimate and a policy.[26][27][28]

조사.

심층 강화 학습은 여러 조사 라인이 있는 활발한 연구 영역입니다.

탐험

RL 에이전트는 탐색/탐색 트레이드오프의 균형을 유지해야 합니다. 즉, 이미 높은 보상을 얻을 수 있는 것으로 알려진 행동을 추구할 것인지 아니면 더 높은 보상을 발견하기 위해 다른 행동을 탐색할 것인지를 결정하는 문제입니다. RL 에이전트는 일반적으로 이산 액션 공간의 볼츠만 분포 또는 연속 액션 공간의 가우시안 분포와 같은 일부 유형의 확률적 정책으로 데이터를 수집하여 기본 탐색 동작을 유도합니다. 새로움 기반 또는 호기심 기반 탐색의 이면에 있는 아이디어는 에이전트에게 최고의 해결책을 찾기 위해 알려지지 않은 결과를 탐색할 동기를 부여합니다. 이것은 "탐색을 장려하기 위한 용어를 추가하여 손실 함수(또는 네트워크 아키텍처)를 수정(수정)"함으로써 수행됩니다.[29] 또한 에이전트가 수행하려는 작업에 맞게 맞춤화된 중간 보상을 제공하여 성공적인 궤적의 시연이나 보상 형성을 활용하여 탐색에 도움을 받을 수 있습니다.[30]

정책 외 강화 학습

RL에서 중요한 차이점은 데이터를 수집하는 정책을 평가하거나 개선해야 하는 온 정책 알고리즘과 임의의 정책에 의해 생성된 데이터로부터 정책을 학습할 수 있는 오프 정책 알고리즘의 차이입니다. 일반적으로 Q-러닝과 같은 가치 기능 기반 방법은 정책 외 학습에 더 적합하고 샘플 효율성이 더 좋습니다. 데이터가 학습에 재사용되기 때문에 작업을 학습하는 데 필요한 데이터 양이 줄어듭니다. 극단적으로, 오프라인(또는 "배치") RL은 환경과의 추가적인 상호 작용 없이 고정된 데이터 세트에서 정책을 학습하는 것을 고려합니다.

역강화학습

Inverse RL은 에이전트의 행동이 주어졌을 때 에이전트의 보상 함수를 추론하는 것을 말합니다. 역강화 학습은 시연자의 보상을 추론한 다음 RL로 수익을 극대화하는 정책을 최적화하여 시연(또는 도제 학습)에서 학습하는 데 사용할 수 있습니다. 딥 러닝 접근법은 다양한 형태의 모방 학습과 역 RL에 사용되었습니다.[31]

목표조건부 강화학습

또 다른 활발한 연구 분야는 에이전트에게 원하는 목표를 전달하기 위해 목표 g g}를 입력으로 받아들이는 컨텍스트 또는 범용 정책π(s, s, g)}라고도 하는 목표 조건 정책을 학습하는 것입니다. 후방 경험 재생은 목표 조건 RL을 위한 방법으로, 이전에 실패한 작업을 저장하고 학습하는 것을 포함합니다.[33] 실패한 시도가 의도한 목표에 도달하지 못했을 수도 있지만, 그것은 나중에 다시 라벨링을 통해 의도하지 않은 결과를 어떻게 달성할 수 있는지에 대한 교훈으로 작용할 수 있습니다.

멀티 에이전트 강화 학습

강화 학습의 많은 응용에는 단일 에이전트만 포함되는 것이 아니라 함께 학습하고 공동 적응하는 에이전트 모음이 포함됩니다. 이러한 에이전트는 많은 게임에서와 같이 경쟁력이 있거나 실제 여러 다중 에이전트 시스템에서와 같이 협력적일 수 있습니다. 다중 에이전트 강화 학습은 이 설정에 도입된 문제를 연구합니다.

일반화

강화 학습에서 딥 러닝 도구를 사용할 수 있는 가능성은 이전에 볼 수 없었던 입력에서 올바르게 작동할 수 있는 능력인 일반화입니다. 예를 들어, 이미지 인식을 위해 훈련된 신경망은 사진이 새를 포함하고 있다는 것을 인식할 수 있습니다. 심지어 그 특정한 이미지나 심지어 그 특정한 새를 본 적이 없습니다. 심층 RL은 원시 데이터(예: 픽셀)를 입력으로 허용하기 때문에 환경을 미리 정의해야 할 필요성이 줄어 모델을 여러 응용 프로그램에 일반화할 수 있습니다. 이 추상화 계층을 사용하면 심층 강화 학습 알고리즘을 일반적으로 사용할 수 있고 동일한 모델을 다른 작업에 사용할 수 있는 방식으로 설계할 수 있습니다.[34] 심층 RL 정책으로 훈련된 정책의 일반화 능력을 높이는 한 가지 방법은 표현 학습을 통합하는 것입니다.

참고문헌

- ^ Francois-Lavet, Vincent; Henderson, Peter; Islam, Riashat; Bellemare, Marc G.; Pineau, Joelle (2018). "An Introduction to Deep Reinforcement Learning". Foundations and Trends in Machine Learning. 11 (3–4): 219–354. arXiv:1811.12560. Bibcode:2018arXiv181112560F. doi:10.1561/2200000071. ISSN 1935-8237. S2CID 54434537.

- ^ Graesser, Laura. "Foundations of Deep Reinforcement Learning: Theory and Practice in Python". Open Library Telkom University. Retrieved 2023-07-01.

- ^ Demis, Hassabis (March 11, 2016). Artificial Intelligence and the Future (Speech).

- ^ Tesauro, Gerald (March 1995). "Temporal Difference Learning and TD-Gammon". Communications of the ACM. 38 (3): 58–68. doi:10.1145/203330.203343. S2CID 8763243. Archived from the original on 2010-02-09. Retrieved 2017-03-10.

- ^ Sutton, Richard; Barto, Andrew (September 1996). Reinforcement Learning: An Introduction. Athena Scientific.

- ^ Bertsekas, John; Tsitsiklis, Dimitri (September 1996). Neuro-Dynamic Programming. Athena Scientific. ISBN 1-886529-10-8.

- ^ Miller, W. Thomas; Werbos, Paul; Sutton, Richard (1990). Neural Networks for Control.

- ^ Shibata, Katsunari; Okabe, Yoichi (1997). Reinforcement Learning When Visual Sensory Signals are Directly Given as Inputs (PDF). International Conference on Neural Networks (ICNN) 1997. Archived from the original (PDF) on 2020-12-09. Retrieved 2020-12-01.

- ^ a b Shibata, Katsunari; Iida, Masaru (2003). Acquisition of Box Pushing by Direct-Vision-Based Reinforcement Learning (PDF). SICE Annual Conference 2003. Archived from the original (PDF) on 2020-12-09. Retrieved 2020-12-01.

- ^ Shibata, Katsunari (March 7, 2017). "Functions that Emerge through End-to-End Reinforcement Learning". arXiv:1703.02239 [cs.AI].

- ^ Utsunomiya, Hiroki; Shibata, Katsunari (2008). Contextual Behavior and Internal Representations Acquired by Reinforcement Learning with a Recurrent Neural Network in a Continuous State and Action Space Task (PDF). International Conference on Neural Information Processing (ICONIP) '08. Archived from the original (PDF) on 2017-08-10. Retrieved 2020-12-14.

- ^ Shibata, Katsunari; Kawano, Tomohiko (2008). Learning of Action Generation from Raw Camera Images in a Real-World-like Environment by Simple Coupling of Reinforcement Learning and a Neural Network (PDF). International Conference on Neural Information Processing (ICONIP) '08. Archived from the original (PDF) on 2020-12-11. Retrieved 2020-12-01.

- ^ a b Mnih, Volodymyr; et al. (December 2013). Playing Atari with Deep Reinforcement Learning (PDF). NIPS Deep Learning Workshop 2013.

- ^ a b Mnih, Volodymyr; et al. (2015). "Human-level control through deep reinforcement learning". Nature. 518 (7540): 529–533. Bibcode:2015Natur.518..529M. doi:10.1038/nature14236. PMID 25719670. S2CID 205242740.

- ^ Silver, David; Huang, Aja; Maddison, Chris J.; Guez, Arthur; Sifre, Laurent; Driessche, George van den; Schrittwieser, Julian; Antonoglou, Ioannis; Panneershelvam, Veda; Lanctot, Marc; Dieleman, Sander; Grewe, Dominik; Nham, John; Kalchbrenner, Nal; Sutskever, Ilya; Lillicrap, Timothy; Leach, Madeleine; Kavukcuoglu, Koray; Graepel, Thore; Hassabis, Demis (28 January 2016). "Mastering the game of Go with deep neural networks and tree search". Nature. 529 (7587): 484–489. Bibcode:2016Natur.529..484S. doi:10.1038/nature16961. ISSN 0028-0836. PMID 26819042. S2CID 515925.

- ^ Schrittwieser, Julian; Antonoglou, Ioannis; Hubert, Thomas; Simonyan, Karen; Sifre, Laurent; Schmitt, Simon; Guez, Arthur; Lockhart, Edward; Hassabis, Demis; Graepel, Thore; Lillicrap, Timothy; Silver, David (23 December 2020). "Mastering Atari, Go, chess and shogi by planning with a learned model". Nature. 588 (7839): 604–609. arXiv:1911.08265. Bibcode:2020Natur.588..604S. doi:10.1038/s41586-020-03051-4. PMID 33361790. S2CID 208158225.

- ^ Levine, Sergey; Finn, Chelsea; Darrell, Trevor; Abbeel, Pieter (January 2016). "End-to-end training of deep visuomotor policies" (PDF). JMLR. 17. arXiv:1504.00702.

- ^ "OpenAI - Solving Rubik's Cube With A Robot Hand". OpenAI.

- ^ OpenAI; et al. (2019). Solving Rubik's Cube with a Robot Hand. arXiv:1910.07113.

- ^ "DeepMind AI Reduces Google Data Centre Cooling Bill by 40%". DeepMind.

- ^ "Machine Learning for Autonomous Driving Workshop @ NeurIPS 2021". NeurIPS 2021. December 2021.

- ^ Bellemare, Marc; Candido, Salvatore; Castro, Pablo; Gong, Jun; Machado, Marlos; Moitra, Subhodeep; Ponda, Sameera; Wang, Ziyu (2 December 2020). "Autonomous navigation of stratospheric balloons using reinforcement learning". Nature. 588 (7836): 77–82. Bibcode:2020Natur.588...77B. doi:10.1038/s41586-020-2939-8. PMID 33268863. S2CID 227260253.

- ^ Williams, Ronald J (1992). "Simple Statistical Gradient-Following Algorithms for Connectionist Reinforcement Learning". Machine Learning. 8 (3–4): 229–256. doi:10.1007/BF00992696. S2CID 2332513.

- ^ Schulman, John; Levine, Sergey; Moritz, Philipp; Jordan, Michael; Abbeel, Pieter (2015). Trust Region Policy Optimization. International Conference on Machine Learning (ICML). arXiv:1502.05477.

- ^ Schulman, John; Wolski, Filip; Dhariwal, Prafulla; Radford, Alec; Klimov, Oleg (2017). Proximal Policy Optimization Algorithms. arXiv:1707.06347.

- ^ Lillicrap, Timothy; Hunt, Jonathan; Pritzel, Alexander; Heess, Nicolas; Erez, Tom; Tassa, Yuval; Silver, David; Wierstra, Daan (2016). Continuous control with deep reinforcement learning. International Conference on Learning Representations (ICLR). arXiv:1509.02971.

- ^ Mnih, Volodymyr; Puigdomenech Badia, Adria; Mirzi, Mehdi; Graves, Alex; Harley, Tim; Lillicrap, Timothy; Silver, David; Kavukcuoglu, Koray (2016). Asynchronous Methods for Deep Reinforcement Learning. International Conference on Machine Learning (ICML). arXiv:1602.01783.

- ^ Haarnoja, Tuomas; Zhou, Aurick; Levine, Sergey; Abbeel, Pieter (2018). Soft Actor-Critic: Off-Policy Maximum Entropy Deep Reinforcement Learning with a Stochastic Actor. International Conference on Machine Learning (ICML). arXiv:1801.01290.

- ^ Reizinger, Patrik; Szemenyei, Márton (2019-10-23). "Attention-Based Curiosity-Driven Exploration in Deep Reinforcement Learning". ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). pp. 3542–3546. arXiv:1910.10840. doi:10.1109/ICASSP40776.2020.9054546. ISBN 978-1-5090-6631-5. S2CID 204852215.

- ^ Wiewiora, Eric (2010), "Reward Shaping", in Sammut, Claude; Webb, Geoffrey I. (eds.), Encyclopedia of Machine Learning, Boston, MA: Springer US, pp. 863–865, doi:10.1007/978-0-387-30164-8_731, ISBN 978-0-387-30164-8, retrieved 2020-11-16

- ^ Wulfmeier, Markus; Ondruska, Peter; Posner, Ingmar (2015). "Maximum Entropy Deep Inverse Reinforcement Learning". arXiv:1507.04888 [cs.LG].

- ^ Schaul, Tom; Horgan, Daniel; Gregor, Karol; Silver, David (2015). Universal Value Function Approximators. International Conference on Machine Learning (ICML).

- ^ Andrychowicz, Marcin; Wolski, Filip; Ray, Alex; Schneider, Jonas; Fong, Rachel; Welinder, Peter; McGrew, Bob; Tobin, Josh; Abbeel, Pieter; Zaremba, Wojciech (2018). Hindsight Experience Replay. Advances in Neural Information Processing Systems (NeurIPS). arXiv:1707.01495.

- ^ Packer, Charles; Gao, Katelyn; Kos, Jernej; Krähenbühl, Philipp; Koltun, Vladlen; Song, Dawn (2019-03-15). "Assessing Generalization in Deep Reinforcement Learning". arXiv:1810.12282 [cs.LG].

따라 다음

따라 다음