일반화 오류

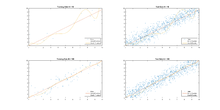

Generalization error기계학습 및 통계학습 이론의 감독학습 애플리케이션의 경우, 일반화 오류[1](표본[2] 외 오류 또는 위험이라고도 함)는 알고리즘이 이전에 보이지 않았던 데이터에 대한 결과 값을 얼마나 정확하게 예측할 수 있는지를 측정하는 척도이다.학습 알고리즘은 유한 샘플로 평가되기 때문에 학습 알고리즘의 평가는 샘플링 오류에 민감할 수 있습니다.따라서 현재 데이터의 예측 오차 측정은 새 데이터의 예측 능력에 대한 많은 정보를 제공하지 못할 수 있습니다.학습 알고리즘에 과적합하지 않도록 함으로써 일반화 오류를 최소화할 수 있습니다.기계 학습 알고리즘의 성능은 학습 곡선이라고 불리는 학습 과정을 통해 일반화 오류 추정치의 값을 보여주는 플롯에 의해 시각화된다.

정의.

학습 문제에서는 각 입력 기준 {\의 출력를 예측하는 n( ){ {x을 개발하는 것이 목표입니다.n(\ n은 fn})이 n n 데이터 의 데이터 세트를 기반으로 개발되었음을 나타냅니다.x 및 {\y의 가능한 모든 값에 대한 특정 의 일반화 오류 또는 예상되는 손실 또는 위험 [ { I]}는 다음과 같습니다.[3]

서V(\ V는 손실 함수를 나타내고, ,)({\{x 는 x { 및 {\displaystyle y의 알 수 없는 관절 확률 입니다.

합동확률분포 { 를 모르면I [ { I [ f] 의 이 불가능하며, 대신 경험적 오차(또는 경험적 리스크)라고 하는 시료데이터의 오차를 산출할 수 있다.n개의 데이터 포인트가 경우 후보 함수 f의 경험적 오류는 다음과 같습니다.

알고리즘은 다음과 같은 경우에 일반화된다고 합니다.

특히 중요한 것은 샘플에 기초한 학습 알고리즘에 의해 발견된 데이터 의존 의 I[ n { [ { } }입니다.다시 알 수 없는 확률 분포의 경우I [ { I [ f { } }을(를) 계산할 수 없습니다.대신, 통계학 학습 이론에서 많은 문제의 목적은 확률에서 일반화 오류와 경험적 오류의 차이를 제한하거나 특징짓는 것이다.

즉, 일반화 오류가 경험적 오류에 일부 오차 으로 \ 및\ n보다 작을 1 - n { n} ize ize ize ize izeizeizeizeizeizeize izeizeizeizeizeizeize that that that that that that that that that that thatizeizeizeizeizeizeizeizeizeizeizeize that that thatizeizeizeizeize plus plusizeizeizeizeize plus plusizeizeize 많은 종류의 알고리즘에서 알고리즘이 특정 안정성 기준을 충족하면 일반화 한계가 있는 것으로 나타났습니다.특히 알고리즘이 대칭이고(입력 순서가 결과에 영향을 주지 않음), 한계 손실이 있으며 두 가지 안정성 조건을 충족한다면, 일반화할 것이다.첫 번째 안정성 조건인 leave-one-out cross-validation 안정성은 leave-one-out cross-validation을 사용할 때 각 데이터 포인트의 예측 오차가 n { n 로 수렴되어야 한다고 말한다.두 번째 조건, expected-one-out 오류 안정성(가설이라고도 함)L 1 norm)에서 작동하는 경우 단일 데이터 포인트가 교육 [4]데이터 세트에서 제거될 때 왼쪽 데이터 포인트에 대한 예측이 변경되지 않으면 안정성이 충족됩니다.

이러한 조건은 다음과 같이 공식화할 수 있습니다.

단일 누락 교차 검증 안정성

L(\ L은 과 같은 이 .각(\에 대해 _{CV 및 가 존재하면 과 같습니다.

C (n ) { \ _ { CV }^ ( ) c cC V( ) n \ \ _ { ( n ) [4] {\ {\ {\ 0 、 \ n。

예상 이탈 오류 안정성

L(\ L은 다음과 같은 이 n n에 대해 m _}^m과 m(\ \}^이 존재할 경우 과 같이 됩니다.

E ( n)( { \ _ { ( ) and e e 、 n( n) 、 n n \ n \ \ with for with with with with with with 、 0 。

에서의 생략 안정성의 경우 이는 가설 안정성과 동일합니다.

H ( )( { displaystyle \ _ { H( ) } 、n { n}이([4]가) 무한대로 되면 0이 됩니다.

안정성이 입증된 알고리즘

다수의 알고리즘이 안정성이 입증되었으며 그 결과 일반화 오류에 한계가 있습니다.이러한 알고리즘과 안정성을 증명한 논문의 목록은 여기에서 확인할 수 있습니다.

과적합과의 관계

일반화 오류와 과적합 개념은 밀접하게 관련되어 있습니다.과적합은 학습된 (\ f_{S가 샘플의 노이즈에 민감해지면 발생합니다.그 결과 함수는 교육 세트에서는 잘 수행되지만 x및y의 공동 확률 분포의 다른 수행되지 않습니다.\ y의 공동 확률 분포의 다른 데이터에서는 잘 수행되지 않습니다.따라서 과적합이 많을수록 일반화 오차가 커집니다.

과적합 정도는 샘플을 시뮬레이션된 교육 샘플과 테스트 샘플로 분할하는 교차 검증 방법을 사용하여 테스트할 수 있습니다.그런 다음 모델을 교육 샘플로 교육하고 테스트 샘플로 평가합니다.테스트 샘플은 이전에는 알고리즘에 의해 표시되지 않았으므로 x x y의 확률 분포에서 랜덤 샘플을 나타냅니다.이 테스트 샘플을 사용하여 예상되는 오차를 근사하고 그 결과 일반화 오차의 특정 형태에 근사할 수 있습니다.

과적합을 방지하기 위해 많은 알고리즘이 존재합니다.최소화 알고리즘은 더 복잡한 함수(티코노프 정규화라고 함)에 불이익을 주거나, 함수의 형태로 명시적으로 또는 최소화 함수에 제약을 가함으로써 가설 공간을 제한할 수 있다(이바노프 정규화).

과적합하지 않는 함수를 찾는 방법은 데이터의 특정 특성을 포착하기에 충분히 복잡한 함수를 찾는 목표와 상충됩니다.이를 바이어스-분산 트레이드오프라고 합니다.함수를 단순하게 유지하여 과적합을 방지하면 결과 예측에 치우침이 발생할 수 있으며, 함수를 더 복잡하게 만들 수 있으므로 과적합이 발생하고 예측의 분산이 커집니다.두 가지를 동시에 최소화하는 것은 불가능하다.

레퍼런스

- ^ Mohri, M., Rostamizadeh A., Talwakar A., (2018) 기계학습재단, 제2판, 보스턴: MIT 프레스

- ^ Y. S. 아부 모스타파, M.Magdon-Ismail과 H.T.입니다.Lin (2012) 데이터를 통한 학습, AMLBook Press. ISBN978-1600490064

- ^ Mohri, M., Rostamizadeh A., Talwakar A., (2018) 기계학습재단, 제2판, 보스턴: MIT 프레스

- ^ a b c Mukherjee, S.; Niyogi, P.; Poggio, T.; Rifkin., R. M. (2006). "Learning theory: stability is sufficient for generalization and necessary and sufficient for consistency of empirical risk minimization" (PDF). Adv. Comput. Math. 25 (1–3): 161–193. doi:10.1007/s10444-004-7634-z. S2CID 2240256.

추가 정보

- Bouquet, O., S. Boucheron 및 G. Lugosi.통계학 학습 이론의 입문인공지능 기계학습 강의 노트 고급강의 3176, 169-207. (Eds)독일 하이델베르크 스프링거, O., U. von Luxburg 및 G. Ratsch, Bousquet, O., U. von Luxburg 및 G. Ratsch (2004)

- 부스케, O.와 A.Eliseef (2002), 안정성과 일반화, 기계학습연구저널, 499-526.

- Devroye L., L. Gyorfi 및 G. Lugosi(1996).패턴 인식의 확률론적 이론.스프링거-벨라그.ISBN 978-0387946184.

- 포지오 T와 S. 스마일학습의 수학: 데이터 처리.AMS의 통지, 2003

- Vapnik, V. (2000)통계학습이론의 본질.정보과학 및 통계.스프링거-벨라그.ISBN 978-0-387-98780-4.

- Bishop, C.M.(1995), Neural Networks for Pattern Recognition, Oxford:옥스퍼드 대학 출판부, 특히 섹션 6.4.

- 모저, Smolensky, Tourtzky, Elman, & Weigend, ed, 1993 커넥티니스트 모델 여름 학교, 힐스, 힐스데일, 모저, Smolensky, Tourtzky, Elman, and Weigend, 1993 연결주의 모델 Summer School, Hills, Hills: "확률적 네트워크 모델을 사용하여 a-postioriori 확률 추정"

- Geman, S., Bienenstock, E. and Doursat, R. (1992) , "신경 네트워크와 편향/변화 딜레마", 신경 계산, 4, 1-58.

- Husmeier, D.(1999), 조건부 확률 추정을 위한 신경 네트워크: Forecasting Beyond Point Predictions, 베를린: Springer Verlag, ISBN 1-85233-095-3.

- J.A. McCullagh, P. and Nelder, J.A.(1989) 일반 선형 모델, 런던 제2판:채프먼 앤 홀

- Mohri, M., Rostamizadeh A., Talwakar A., (2018) 기계학습재단, 제2판, 보스턴: MIT 프레스.

- Moody, J.E.(1992) "유효한 매개변수 수: "비선형 학습 시스템의 일반화 및 정규화 분석"은 무디스, J.E., 핸슨, S.J., 리프만, R.P.에서 신경 정보 처리 시스템 4, 847-854의 발전이다.

- Ripley, B.D.(1996) 패턴 인식 및 뉴럴 네트워크, 캠브리지:케임브리지 대학 출판부

- Rowwer, R. 및 van der Rest, J.C.(1996), "최소 기술 길이, 정규화 및 멀티모달 데이터", Neural Computation, 8, 595-609.

- Rojas, R. (1996), "분급기 신경망의 후방 확률 특성에 대한 짧은 증거", Neural Computation, 8, 41-43.

- 화이트, H.(1990), "연결주의 비모수 회귀: Multilayer Feedforward Networks Can Learn Arbitrary Mappings," Neural Networks, 3, 535-550.화이트로 전재(1992년).

- 화이트, H.(1992a), "신경망을 이용한 조건부 분위수의 비모수 추정", 페이지 C. 및 Le 페이지, R.(ed.)에서, 인터페이스에 대한 23번째 심프슘의 진행: Computing Science and Statistics, Alexandria, VA: American Statistics Association, 190-199페이지.흰색으로 전재(1992b).

- White, H.(1992b), 인공 신경 네트워크: 근사 및 학습 이론, Blackwell.

출력

출력

개발하는 것이 목표입니다.

개발하는 것이 목표입니다.

일반화 오류 또는 예상되는 손실 또는 위험

일반화 오류 또는 예상되는 손실 또는 위험![I[f]](https://wikimedia.org/api/rest_v1/media/math/render/svg/8213b3ec4b7c34969992d3f12dd96b830c9082ef)

![{\displaystyle I[f]=\int _{X\times Y}V(f({\vec {x}}),y)\rho ({\vec {x}},y)d{\vec {x}}dy,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6dbb449f1246d2d43f7913fdce840176d89eaceb)

![{\displaystyle I_{n}[f]={\frac {1}{n}}\sum _{i=1}^{n}V(f({\vec {x}}_{i}),y_{i})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6ebbb7c212127a833303ad4ebc28b8249204f3bb)

![{\displaystyle \lim _{n\rightarrow \infty }I[f]-I_{n}[f]=0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c05fa4b3ba87ee702f09fde44ed49d570c921361)

![{\displaystyle I[f_{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3a7111bafb06436dbb5c6bdd88aaad9f689133c2)

![{\displaystyle P_{G}=P(I[f_{n}]-I_{n}[f_{n}]\leq \epsilon )\geq 1-\delta _{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d68caa5402a52609e73c853af11069095cc00b6c)

존재하면

존재하면

존재할 경우

존재할 경우 ![{\displaystyle \forall i\in \{1,...,n\},\mathbb {P} _{S}\left\{\left|I[f_{S}]-{\frac {1}{n}}\sum _{i=1}^{N}V\left(f_{S^{i}},z_{i}\right)\right|\leq \beta _{EL}^{(n)}\right\}\geq 1-\delta _{EL}^{(n)}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f0055901b3111a9b60b2532bb3d7905884787cd)

![{\displaystyle \mathbb {E} _{S,z}[|V(f_{S},z)-V(f_{S^{i}},z)|]\leq \beta _{H}^{(n)}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/06cc4ccaa28eae9dd8c93319e4304c66a93f9845)

샘플의 노이즈에 민감해지면 발생합니다.그 결과 함수는 교육 세트에서는 잘 수행되지만 x

샘플의 노이즈에 민감해지면 발생합니다.그 결과 함수는 교육 세트에서는 잘 수행되지만 x