이상치

Outlier통계량에서 특이치는 다른 [1][2]관측치와 유의하게 다른 데이터 점입니다.특이치는 측정값의 변동성 때문일 수도 있고 실험 오차를 나타낼 수도 있습니다. 특이치는 [3]데이터 집합에서 제외되는 경우도 있습니다.특이치는 통계 분석에 심각한 문제를 일으킬 수 있습니다.

특이치는 모든 분포에서 우연히 발생할 수 있지만 종종 측정 오차가 있거나 모집단의 꼬리가 두꺼운 분포를 나타냅니다.전자의 경우 특이치에 대해 강력한 통계량을 사용하거나, 후자의 경우 분포의 왜도가 높으며 정규 분포를 가정하는 도구나 직관을 사용할 때 매우 주의해야 한다는 것을 나타냅니다.특이치의 빈번한 원인은 두 개의 서로 다른 하위 모집단이거나 '정확한 시행' 대 '측정 오차'를 나타낼 수 있는 두 분포의 혼합입니다. 이 분포는 혼합물 모형에 의해 모형화됩니다.

대부분의 대규모 데이터 표본 추출에서 일부 데이터 지점은 합리적인 것으로 간주되는 것보다 표본 평균에서 더 멀리 떨어져 있습니다.이는 확률 분포의 가정된 패밀리를 생성한 이론의 우발적인 시스템 오류 또는 결함 때문일 수 있으며, 일부 관측치가 데이터의 중심에서 멀리 떨어져 있을 수도 있습니다.따라서 특이치 점은 잘못된 데이터, 잘못된 절차 또는 특정 이론이 유효하지 않을 수 있는 영역을 나타낼 수 있습니다.그러나 큰 표본에서는 (변칙적인 조건 때문이 아니라) 소수의 특이치를 예상해야 합니다.

특이치는 극단적 관측치로서 극단적으로 높은지 낮은지에 따라 표본 최대값 또는 표본 최소값 또는 둘 다 포함될 수 있습니다.그러나 표본 최대값과 최소값이 다른 관측치와 비정상적으로 멀리 떨어져 있지 않을 수 있으므로 항상 특이치인 것은 아닙니다.

특이치를 포함하는 데이터 집합에서 파생된 통계량을 단순하게 해석하면 오해를 일으킬 수 있습니다.예를 들어, 한 방에 있는 10개 물체의 평균 온도를 계산하고 있고 그 중 9개가 섭씨 20도에서 25도 사이이지만 오븐이 175°C에 있는 경우 데이터의 중앙값은 20도에서 25°C 사이이지만 평균 온도는 35.5도에서 40°C 사이입니다.이 경우 중위수가 평균보다 랜덤하게 표본 추출된 물체의 온도(실내 온도는 아님)를 더 잘 반영합니다. 평균을 중위수와 동일한 "일반 표본"으로 순진하게 해석하는 것은 올바르지 않습니다.이 경우에서 볼 수 있듯이 특이치는 표본 집합의 나머지 부분과 다른 모집단에 속하는 데이터 점을 나타낼 수 있습니다.

특이치를 처리할 수 있는 추정치는 견고하다고 합니다. 중위수는 중심 경향의 견고한 통계량인 반면 평균은 [4]그렇지 않습니다.그러나 평균은 일반적으로 더 정확한 추정치입니다.[5]

발생 및 원인

정규 분포 데이터의 경우 3 시그마 규칙은 관측치 22개 중 1개가 평균보다 표준 편차의 2배 이상 차이가 나고 370개 중 1개가 표준 [6]편차의 3배 이상 차이가 난다는 것을 의미합니다.관측치 1000개의 표본에서 평균에서 표준 편차의 3배 이상 벗어난 최대 5개의 관측치가 예상 값의 범위 내에 있으며, 예상 수의 2배 미만이며 따라서 기대 수의 1 표준 편차 내에 있습니다. 포아송 분포 참조 - 이상 징후를 나타내지 않음y. 그러나 표본 크기가 100에 불과할 경우 이러한 특이치 3개만 이미 예상 수의 11배를 초과하여 문제가 됩니다.

일반적으로 모집단 분포의 성질이 사전에 알려진 경우, 특이치의 수가 예상할 수 있는 것과 크게 다른지 여부를 검정할 수 있다. 즉, 주어진 분포의 컷오프(그래서 샘플이 확률 p를 갖는 컷오프 초과)에 대해 특이치의 수는 모수 p를 갖는 이항 분포를 따른다.일반적으로 µ = pn인 포아송 분포로 근사할 수 있다.따라서 평균에서 컷오프 표준 편차가 3인 정규 분포를 취하면 p는 약 0.3%이므로 1000번 시행의 경우 편차가 3 시그마를 초과하는 표본의 수를 포아송 분포로 θ = 3으로 근사할 수 있습니다.

원인들

특이치에는 많은 비정상적인 원인이 있을 수 있습니다.측정을 위한 물리적 장치가 일시적인 오작동을 일으켰을 수 있습니다.데이터 전송 또는 변환에 오류가 있을 수 있습니다.특이치는 시스템 행동, 사기 행동, 인적 오류, 계기 오류 또는 모집단의 자연 편차를 통해 발생한다.표본이 조사 대상 모집단 외부의 원소로 오염되었을 수 있습니다.또는 특이치는 가정된 이론의 결함의 결과일 수 있으며, 연구자의 추가 조사가 요구됩니다.또한, 특정 형태의 특이치의 병리학적 외관은 다양한 데이터 세트에 나타나며, 데이터에 대한 원인 메커니즘이 극단에서 다를 수 있음을 나타낸다(킹 효과).

정의 및 검출

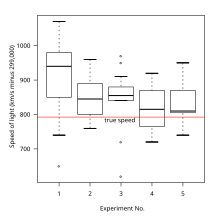

특이치를 구성하는 것에 대한 엄격한 수학적 정의는 없다. 관측치가 특이치인지 아닌지를 결정하는 것은 [7]궁극적으로 주관적인 연습이다.특이치를 [8][9][10][11]검출하는 방법은 다양합니다.일부는 정규 확률도와 같은 그래픽입니다.그 외의 것은 모델 베이스입니다.상자 그림은 하이브리드입니다.

식별에 일반적으로 사용되는 모형 기반 방법은 데이터가 정규 분포에서 추출되었다고 가정하고 평균 및 표준 편차를 기반으로 "비슷하게" 간주되는 관측치를 식별합니다.

- 쇼브네의 기준

- Grubbs의 특이치 검정

- 딕슨 Q 검정

- ASTM E178: 외부 관찰에[12] 대처하는 표준 프랙티스

- Mahalanobis 거리 및 지렛대는 특히 선형 회귀 모형의 개발에서 특이치를 탐지하는 데 자주 사용됩니다.

- 고차원 수치[11] 데이터를 위한 부분 공간 및 상관 관계 기반 기술

피어스의 기준

일련의 m 관측치에서는 그러한 관측치가라도 존재하는 경우, 그 이상으로 큰 오류를 포함하는 모든 관측치가 거부될 수 있는 오차 한계를 결정할 것을 제안한다.이 문제를 해결하기 위해 제안된 원칙은 제안된 관측치를 보유함으로써 얻은 오류 시스템의 확률이 거부로 얻은 오류 시스템의 확률에 비정상 관측치를 많이 만들 확률을 곱한 값보다 작을 경우 거부해야 한다는 것이다.(516페이지의 사설 노트에서 샤우베네의 천문학 매뉴얼 2:558에서 피어스(1982년판)로 인용)[13][14][15][16]

투키의 울타리

다른 방법에서는 사분위간 범위와 같은 측도를 기준으로 관측치에 플래그를 표시합니다.예를 들어 과 이 각각 하위 사분위수 및 상위 사분위수인 , 특이치를 범위 밖의 관측치로 정의할 수 있습니다.

음이 아닌 k(\ k에 대해 John Tukey는 이 검정을 제안했다. 서 k 1. k는 "이상치"를 나타내고 k k=은 "멀리 떨어진"[17] 데이터를 나타낸다.

이상 검출 중

통계, 신호 처리, 금융, 계량경제학, 제조, 네트워킹 및 데이터 마이닝과 같은 다양한 영역에서 이상 검출 태스크는 다른 접근방식을 취할 수 있다.이들 중 일부는 Local Outlier Factor(LOF)[20]와 같은 거리 기반 및 밀도 기반일[18][19] 수 있습니다.일부 접근 방식에서는 k-근접 인접 관측치에 대한 거리를 사용하여 관측치에 특이치 또는 [21]비특이치로 레이블을 지정할 수 있습니다.

수정 톰슨 타우 시험

수정된 Thompson Tau[citation needed] 검정은 데이터 집합에 특이치가 있는지 확인하는 데 사용되는 방법입니다.이 방법의 강점은 데이터 세트의 표준 편차, 평균을 고려하고 통계적으로 결정된 거부 구역을 제공하므로 데이터 점이 [citation needed][22]특이치인지 여부를 결정하는 객관적인 방법을 제공한다는 데 있습니다.구조:우선, 데이터 세트의 평균을 구한다.다음으로 각 데이터 포인트와 평균 간의 절대 편차를 구한다.셋째, 다음 공식을 사용하여 거부 영역을 구한다.

- {n {2

서 tα / {\ /은 자유도가 n-2인 Student t 분포의 임계값, n은 샘플 크기, s는 샘플 표준 편차입니다.값이 특이치인지 판별하려면: ( - e (X )/ \ \\ script ( ) / > Reject Region일 경우 데이터 포인트는 특이치입니다.δ rejection Reject Region이면 데이터 점이 특이치가 아닙니다.

수정된 Thompson Tau 검정은 한 번에 하나의 특이치를 찾는 데 사용됩니다(특이치인 경우 가장 큰 값인 θ는 제거됨).즉, 데이터 점이 특이치인 경우 데이터 집합에서 제거되고 검정이 새 평균 및 기각 영역으로 다시 적용됩니다.이 프로세스는 데이터 집합에 특이치가 남아 있지 않을 때까지 계속됩니다.

일부 작업에서는 명목(또는 범주형) 데이터에 대한 특이치도 조사했습니다.데이터 세트의 예(또는 인스턴스) 세트의 컨텍스트에서 인스턴스 경도는 인스턴스가 잘못 분류될 확률을 측정합니다(-p ( ) \ ( x ) 。여기서 y는 할당된 클래스 라벨이고 x는 트레이닝 세트 [23]t 내의 인스턴스의 입력 속성값을 나타냅니다.이상적으로는 인스턴스 경도는 가능한 모든 가설의 집합 H를 합계를 통해 계산됩니다.

이 공식은 H가 무한대일 가능성이 있고 많은 알고리즘에서 p t)\ p(h t)\ ph t)\ p(h t)\display p(h t)\calculation p(h t)\calcalculation ph t)\따라서 인스턴스 경도는 다양한 L H을 사용하여 근사할 수 있습니다.

서 gj ( ,α) { _ { } ( , \alpha 는 하이퍼 ( \ \ )를 사용하여 트레이닝 세트 t에 대해 훈련받은 g {\ 에 의해 유도되는 가설입니다.인스턴스 경도는 인스턴스가 이상 인스턴스인지 판별하기 위한 연속적인 값을 제공합니다.

특이치 작업

특이치를 처리하는 방법은 원인에 따라 달라야 합니다.일부 추정치는 특이치, 특히 공분산 행렬의 추정에 매우 민감합니다.

보유

분석 중인 데이터에 정규 분포 모형이 적절한 경우에도 표본 크기가 큰 경우에는 특이치가 예상되므로 이 경우 자동으로 폐기되지 않아야 합니다.응용 프로그램은 특이치에 대해 강력한 분류 알고리즘을 사용하여 자연 발생 특이치 점을 사용하여 데이터를 모형화해야 합니다.

제외

특이치 데이터의 삭제는 많은 과학자와 과학 강사들에 의해 비난받고 있는 논쟁의 여지가 있는 관행입니다.수학적 기준은 데이터 거부를 위한 객관적이고 정량적인 방법을 제공하지만, 그것들은 특히 작은 집합이나 정규 분포를 지원할 수 없는 경우 더 과학적이고 방법론적으로 타당하지 않습니다.중위수. 측정 중인 공정의 기본 모형과 측정 오류의 정규 분포를 자신 있게 알고 있는 실천 영역에서 특이치 제거가 더 적합합니다.기기 판독 오류로 인한 특이치는 제외될 수 있지만 적어도 판독값을 검증하는 것이 바람직하다.

특이치를 제외하는 두 가지 일반적인 접근 방식은 잘라내기(또는 트리밍)와 윈소라이징입니다.트리밍은 특이치를 폐기하는 반면 Winsorising은 특이치를 가장 가까운 "이상치"[24] 데이터로 대체합니다.제외는 또한 실험이 그러한 극단값을 완전히 측정할 수 없는 경우와 같이 측정 과정의 결과일 수 있으며, 따라서 관측 [25]중단 데이터가 발생할 수 있습니다.

회귀 문제에서는 Cook의 [26]거리와 같은 측도를 사용하여 추정된 계수에 큰 영향을 미치는 점만 제외하는 것이 대안적 접근법이 될 수 있습니다.

데이터 분석에서 데이터 포인트를 제외하는 경우 후속 보고서에 이를 명확히 명시해야 한다.

비정규 분포

데이터의 기본 분포가 "뚱뚱한 꼬리"를 가지고 있어 근사적으로 정규 분포가 아닐 가능성을 고려해야 한다.예를 들어, 코시 [27]분포에서 표본을 추출할 때 표본 분산은 표본 크기에 따라 증가하고 표본 평균은 표본 크기가 증가함에 따라 수렴되지 않으며 특이치는 정규 분포보다 훨씬 큰 비율로 기대됩니다.꼬리의 두께에 약간의 차이가 있어도 예상되는 극단값의 수가 크게 달라질 수 있습니다.

세트 멤버십의 불확실성

집합 멤버쉽 어프로치는 미지의 랜덤 벡터 x의 ith 측정에 대응하는 불확실성이 (확률밀도함수 대신) 집합i X로 표현되는 것으로 간주한다.특이치가 발생하지 않으면 x는 모든i X의 교차점에 속해야 합니다.특이치가 발생하면 이 교차가 비어 있을 수 있으므로 [28]불일치를 방지하기 위해 소수의 집합i X를 완화해야 합니다(가능한 한 작음).이것은 q완화 교차로의 개념을 사용하여 수행할 수 있습니다.그림에서 알 수 있듯이, q완화 교차는 q를 제외한 모든 집합에 속하는 모든 x의 집합에 대응한다.Q-완화 교차점과 교차하지 않는 집합i X는 특이치로 의심될 수 있습니다.

대체 모델

특이치의 원인을 알고 있는 경우 계층적 베이즈 모형 또는 혼합물 [29][30]모형을 사용하여 이 효과를 모형 구조에 통합할 수 있습니다.

「 」를 참조해 주세요.

레퍼런스

- ^ Grubbs, F. E. (February 1969). "Procedures for detecting outlying observations in samples". Technometrics. 11 (1): 1–21. doi:10.1080/00401706.1969.10490657.

An outlying observation, or "outlier," is one that appears to deviate markedly from other members of the sample in which it occurs.

- ^ Maddala, G. S. (1992). "Outliers". Introduction to Econometrics (2nd ed.). New York: MacMillan. pp. 89. ISBN 978-0-02-374545-4.

An outlier is an observation that is far removed from the rest of the observations.

- ^ Grubbs 1969, 페이지 1은 "외계 관측은 데이터에 내재된 무작위 변동성의 극단적인 발현일 수 있다...한편, 외부 관찰은 소정의 실험 절차로부터의 총편차 또는 수치 계산 또는 기록 오류의 결과일 수 있습니다."

- ^ Ripley, Brian D. 2004.Wayback Machine에서 2012-10-21년에 아카이브된 견고한 통계

- ^ Chandan Mukherjee, Howard White, Marc Wuyts, 1998, "개발 도상국을 위한 계량 및 데이터 분석 Vol.1" [1]

- ^ Ruan, Da; Chen, Guoqing; Kerre, Etienne (2005). Wets, G. (ed.). Intelligent Data Mining: Techniques and Applications. Studies in Computational Intelligence Vol. 5. Springer. p. 318. ISBN 978-3-540-26256-5.

- ^ Zimek, Arthur; Filzmoser, Peter (2018). "There and back again: Outlier detection between statistical reasoning and data mining algorithms" (PDF). Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery. 8 (6): e1280. doi:10.1002/widm.1280. ISSN 1942-4787.

- ^ Rousseeuw, P; Leroy, A. (1996), Robust Regression and Outlier Detection (3rd ed.), John Wiley & Sons

- ^ Hodge, Victoria J.; Austin, Jim (2004), "A Survey of Outlier Detection Methodologies", Artificial Intelligence Review, 22 (2): 85–126, CiteSeerX 10.1.1.109.1943, doi:10.1023/B:AIRE.0000045502.10941.a9, S2CID 3330313

- ^ Barnett, Vic; Lewis, Toby (1994) [1978], Outliers in Statistical Data (3 ed.), Wiley, ISBN 978-0-471-93094-5

- ^ a b Zimek, A.; Schubert, E.; Kriegel, H.-P. (2012). "A survey on unsupervised outlier detection in high-dimensional numerical data". Statistical Analysis and Data Mining. 5 (5): 363–387. doi:10.1002/sam.11161.

- ^ E178: 외부 관찰에 대처하는 표준 프랙티스

- ^ 벤자민 피어스, "의심스러운 관측 거부 기준", 천문학 저널 II 45 (1852) 및 에라타 원본 논문.

- ^ Peirce, Benjamin (May 1877 – May 1878). "On Peirce's criterion". Proceedings of the American Academy of Arts and Sciences. 13: 348–351. doi:10.2307/25138498. JSTOR 25138498.

- ^ Peirce, Charles Sanders (1873) [1870]. "Appendix No. 21. On the Theory of Errors of Observation". Report of the Superintendent of the United States Coast Survey Showing the Progress of the Survey During the Year 1870: 200–224.. NOAA PDF Eprint (보고서 페이지 200, PDF 페이지 215로 이동합니다.)

- ^ Peirce, Charles Sanders (1986) [1982]. "On the Theory of Errors of Observation". In Kloesel, Christian J. W.; et al. (eds.). Writings of Charles S. Peirce: A Chronological Edition. Vol. 3, 1872–1878. Bloomington, Indiana: Indiana University Press. pp. 140–160. ISBN 978-0-253-37201-7. – 부록 21 (515 페이지)의 편집 주석에 따르면

- ^ Tukey, John W (1977). Exploratory Data Analysis. Addison-Wesley. ISBN 978-0-201-07616-5. OCLC 3058187.

- ^ Knorr, E. M.; Ng, R. T.; Tucakov, V. (2000). "Distance-based outliers: Algorithms and applications". The VLDB Journal the International Journal on Very Large Data Bases. 8 (3–4): 237. CiteSeerX 10.1.1.43.1842. doi:10.1007/s007780050006. S2CID 11707259.

- ^ Ramaswamy, S.; Rastogi, R.; Shim, K. (2000). Efficient algorithms for mining outliers from large data sets. Proceedings of the 2000 ACM SIGMOD international conference on Management of data - SIGMOD '00. p. 427. doi:10.1145/342009.335437. ISBN 1581132174.

- ^ Breunig, M. M.; Kriegel, H.-P.; Ng, R. T.; Sander, J. (2000). LOF: Identifying Density-based Local Outliers (PDF). Proceedings of the 2000 ACM SIGMOD International Conference on Management of Data. SIGMOD. pp. 93–104. doi:10.1145/335191.335388. ISBN 1-58113-217-4.

- ^ Schubert, E.; Zimek, A.; Kriegel, H. -P. (2012). "Local outlier detection reconsidered: A generalized view on locality with applications to spatial, video, and network outlier detection". Data Mining and Knowledge Discovery. 28: 190–237. doi:10.1007/s10618-012-0300-z. S2CID 19036098.

- ^ Thompson .R. (1985년)"대안 특이치 모형을 사용한 제한된 최대우도 추정 참고"왕립통계학회지시리즈 B (방법론), 제47권, 제1호, 53-55페이지

- ^ 스미스, M.R.; 마르티네즈, T.; 지로-캐리어, C. (2014)."데이터 복잡성의 인스턴스 수준 분석"머신 러닝, 95(2): 225-256.

- ^ Wike, Edward L. (2006). Data Analysis: A Statistical Primer for Psychology Students. pp. 24–25. ISBN 9780202365350.

- ^ Dixon, W. J. (June 1960). "Simplified estimation from censored normal samples". The Annals of Mathematical Statistics. 31 (2): 385–391. doi:10.1214/aoms/1177705900.

- ^ 쿡, R. 데니스(1977년 2월)."선형 회귀에서 영향력 있는 관측치의 탐지"테크노메트릭스(American Statistical Association): 15~18.

- ^ Weisstein, Eric W. Cauchy Distribution. Math World에서--Wolfram 웹 리소스

- ^ Jaulin, L. (2010). "Probabilistic set-membership approach for robust regression" (PDF). Journal of Statistical Theory and Practice. 4: 155–167. doi:10.1080/15598608.2010.10411978. S2CID 16500768.

- ^ Roberts, S. 및 Tarassenko, L.: 1995, 신규성 검출을 위한 확률론적 자원 할당 네트워크.Neural Computation 6, 270–284.

- ^ Bishop, C. M. (August 1994). "Novelty detection and Neural Network validation". IEE Proceedings - Vision, Image, and Signal Processing. 141 (4): 217–222. doi:10.1049/ip-vis:19941330.

외부 링크

- Renze, John. "Outlier". MathWorld.

- Balakrishnan, N.; Childs, A. (2001) [1994], "Outlier", Encyclopedia of Mathematics, EMS Press

- NIST 매뉴얼에 의해 기술된 Grubbs 테스트

존재하는 경우, 그 이상으로 큰 오류를 포함하는 모든 관측치가 거부될 수 있는 오차 한계를 결정할 것을 제안한다.이 문제를 해결하기 위해 제안된 원칙은 제안된 관측치를 보유함으로써 얻은 오류 시스템의 확률이 거부로 얻은 오류 시스템의 확률에 비정상 관측치를 많이 만들 확률을 곱한 값보다 작을 경우 거부해야 한다는 것이다.(516페이지의 사설 노트에서 샤우베네의 천문학 매뉴얼 2:558에서 피어스(1982년판)로 인용)

존재하는 경우, 그 이상으로 큰 오류를 포함하는 모든 관측치가 거부될 수 있는 오차 한계를 결정할 것을 제안한다.이 문제를 해결하기 위해 제안된 원칙은 제안된 관측치를 보유함으로써 얻은 오류 시스템의 확률이 거부로 얻은 오류 시스템의 확률에 비정상 관측치를 많이 만들 확률을 곱한 값보다 작을 경우 거부해야 한다는 것이다.(516페이지의 사설 노트에서 샤우베네의 천문학 매뉴얼 2:558에서 피어스(1982년판)로 인용)

각각 하위

각각 하위 ![{\big [}Q_{1}-k(Q_{3}-Q_{1}),Q_{3}+k(Q_{3}-Q_{1}){\big ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/efa0c7280d2bbf322c81de7c0a7d65296a6e5d18)

"이상치"를 나타내고 k

"이상치"를 나타내고 k  "멀리 떨어진"

"멀리 떨어진"

자유도가 n-2인

자유도가 n-2인

y는 할당된 클래스

y는 할당된 클래스

하이퍼

하이퍼

의해 유도되는 가설입니다.인스턴스 경도는 인스턴스가 이상 인스턴스인지 판별하기 위한 연속적인 값을 제공합니다.

의해 유도되는 가설입니다.인스턴스 경도는 인스턴스가 이상 인스턴스인지 판별하기 위한 연속적인 값을 제공합니다.