메타사이언스

Metascience| 시리즈의 일부 |

| 근거에 근거한 프랙티스 |

|---|

메타 연구라고도 알려진 메타 과학은 과학 자체를 연구하기 위해 과학적 방법론을 사용하는 것이다.메타사이언스는 비효율성을 줄이면서 과학 연구의 질을 높이려고 한다.그것은 또한 연구가 어떻게 이루어지는지를 연구하고 개선될 수 있는 곳을 찾기 위해 연구 방법을 사용하기 때문에 "연구 연구"와 "과학 과학"으로도 알려져 있다.메타사이언스는 모든 연구 분야에 관여하며 "과학의 [1]조감도"로 묘사되어 왔다.존 이오아니디스의 말을 빌리자면, "과학은 인간에게 일어난 일 중 가장 좋은 일이지만... 우리는 더 잘 [2]할 수 있다."

1966년, 초기 메타 연구 논문은 10개의 저명한 의학 저널에 발표된 295개의 논문의 통계적 방법을 조사했다.그것은 "거의 73%의 보고서에서 ... 결론은 이러한 결론에 대한 정당성이 무효일 때 도출되었다"고 밝혔다.이후 수십 년간의 메타 연구는 수많은 과학 분야에 걸친 연구에서 많은 방법론적인 결함, 비효율성, 그리고 빈약한 관행을 발견했습니다.많은 과학적 연구, 특히 의학이나 소프트 사이언스에서는 재현할 수 없었다.레플리케이션 위기라는 용어는 2010년대 초에 이 [3]문제에 대한 인식이 높아지면서 생겨났습니다.

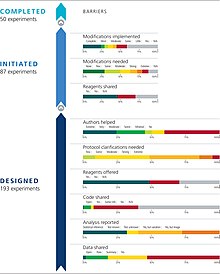

메타사이언스에 의해 밝혀진 문제들을 다루기 위한 조치들이 시행되었다.이러한 조치에는 과학적 연구 및 임상시험의 사전 등록, 방법론 및 보고 지침을 발행하는 CONSORT 및 적도 네트워크 등의 조직의 설립이 포함됩니다.통계 오남용을 줄이고, 학계의 왜곡된 인센티브를 제거하고, 안전 점검 과정을 개선하고, 과학 문헌의 편견과 싸우고, 과학 과정의 전반적인 품질과 효율성을 높이기 위한 지속적인 노력이 있다.

역사

1966년, 초기 메타 연구 논문은 10개의 저명한 의학 저널에 발표된 295개의 논문의 통계적 방법을 조사했다.조사 결과, "거의 73%의 보고서에서 ... 결론은 이러한 결론에 대한 정당성이 [5]무효일 때 도출되었다."2005년, John Ioannidis는 "왜 대부분의 발표된 연구 결과가 거짓인가"라는 제목의 논문을 발표했는데, 이 논문은 의학 분야의 대부분의 [4]논문이 잘못된 결론을 낸다고 주장했다.이 논문은 공공과학도서관에서[6][7] 가장 많이 다운로드 된 논문이 되었고 메타과학 [8]분야의 기초가 되는 것으로 여겨지고 있다.제레미 하윅과 데스피나 콜레티와의 관련 연구에서 요아니디스는 권고 평가, 개발 및 평가 등급(GRADE) 접근법에 따라 소수의 의료 개입만이 '고품질' 증거에 의해 뒷받침된다는 것을 보여주었다.[9] 이후 메타 연구는 심리학 및 의학을 포함한 많은 과학 분야에서 결과를 복제하는 데 광범위한 어려움을 확인했다.이 문제를 레플리케이션 위기라고 부릅니다.Metascience는 복제 위기와 [10]연구 낭비에 대한 우려에 대한 대응으로 성장했습니다.

많은 저명한 출판사들은 메타 리서치와 출판물의 품질 향상에 관심이 있습니다.Science, The Lancet, Nature와 같은 상위 저널은 메타 연구 [11]및 재현성 문제에 대한 지속적인 보도를 제공합니다.2012년 PLOS ONE은 재현성 이니셔티브를 시작했습니다.2015년 바이오메트릭 센트럴은 네 개의 제목에 최소 표준 보고서 체크리스트를 도입했다.

메타 리서치의 광범위한 영역에서 첫 번째 국제 회의는 연구 폐기물/EQ였습니다.2015년 에딘버러에서 열린 UATOR 회의. 최초의 안전 점검 국제 회의는 [12]1989년에 열린 안전 점검 회의였다.2016년에는 리서치 Integrity and Peer Review가 시작되었습니다.저널의 오프닝 사설은 "동료 검토, 연구 보고, 연구 및 출판 [13]윤리와 관련된 문제에 대한 우리의 이해를 높이고 잠재적인 해결책을 제안할 연구"를 요구했다.

메타 리서치 필드 및 토픽

메타사이언스는 크게 5가지 관심 영역으로 분류할 수 있습니다.방법, 보고, 재현성, 평가 및 인센티브.이는 각각 [14]연구를 수행하고, 전달하고, 검증하고, 평가하고, 보상하는 방법과 일치한다.

방법들

메타사이언스는 연구에 대한 편견, 연구 설계, 통계의 남용 등 열악한 연구 관행을 식별하고 이러한 [14]관행을 줄일 수 있는 방법을 찾으려고 한다.메타 연구는 과학 [15]문헌에서 수많은 편견을 찾아냈다.특히 주목할 점은 p-값의 광범위한 오남용과 통계적 [16]유의성의 남용이다.

인과 관계

인과관계 분야는 관측된 변수의 분포가 아니라 데이터 생성 모델의 관점에서 현실을 이해하려는 시도로 진화했다.이는 예측과 관련된 논리를 설명할 수 있는 신뢰할 수 있는 AI 시스템이 주목받는 머신러닝 분야, 특히 금융 등 민감한 데이터가 관련된 애플리케이션에서 관련된다.블랙박스라는 용어는 내부 구조의 해석성이 부족한 모형을 설명하는 데 일반적으로 사용됩니다.인과적 발견과 인과적 추론은 모두 그러한 문제를 다루기 위한 공리 기반의 프레임워크를 제공하며, 전자는 데이터 세트에 내재된 인과적 구조를 식별하는 데 관여하는 반면 후자는 특정 관심 결과에 대한 특정 변수(치료)의 인과적 영향을 추정하는 것을 목표로 한다.인과성은 또한 사회과학 같은 경험적 연구에서도 상식이 되고 있는데, 여기서 인과적 결론은 종종 결정적인 정당성 없이 관찰 데이터에서 도출된다.

저널로지

출판 과학으로도 알려진 저널로지는 학술 출판 [17][18]과정의 모든 측면에 대한 학문적 연구이다.이 분야는 학술 [19]출판에서 증거 기반 관행을 구현함으로써 학술 연구의 질을 향상시키려 한다.저널로지라는 용어는 1989년 일리노이주 시카고에서 열린 제1회 피어 리뷰 콩그레스(Peer Review Congress)는 저널로지가 독특한 [19]분야로 설립되는 데 중추적인 순간으로 여겨진다.저널로지 분야는 과학, 특히 임상 시험에서 연구 사전 등록을 추진하는 데 영향을 미쳤다.현재 대부분의 국가에서 임상시험 [19]등록이 예정되어 있다.

리포트

메타 리서치는 특히 사회 및 보건 과학 분야에서 연구 보고, 설명, 전파 및 대중화에 있어 잘못된 관행을 식별했다.보고서가 부실하면 과학적 연구의 결과를 정확하게 해석하고, 연구를 복제하고, 저자에 대한 편견과 이해 상충을 식별하기가 어렵다.해결책에는 보고 표준의 구현과 과학적 연구의 투명성 향상(이익 상충 공개에 대한 더 나은 요건 포함)이 포함된다.CONSORT나 대규모 적도 [14]네트워크등의 보고 기관에 의한 가이드 라인의 작성을 통해서, 데이터와 방법론의 보고를 표준화하려는 시도가 있다.

재현성

복제 위기는 많은 과학적 연구가 [20][21]복제하기 어렵거나 불가능하다는 것이 밝혀진 지속적인 방법론적 위기이다.이 위기는 1900년대 중후반의 메타연구에 뿌리를 두고 있지만, 레플리케이션 위기라는 용어는 이 [14]문제에 대한 인식의 일환으로 2010년대[3] 초까지 만들어지지 않았다.복제 위기는 특히 암 [24][25]연구를 포함한 심리학(특히 사회 심리학)과 [22][23]의학에 영향을 미칩니다.레플리케이션은 과학 프로세스의 중요한 부분이며, 레플리케이션의 광범위한 실패는 영향을 받는 [26]분야의 신뢰성에 의문을 제기합니다.

또한, 연구의 복제(또는 복제 실패)는 원래 연구보다 영향력이 덜하다고 간주되며, 많은 분야에서 출판될 가능성이 낮다.이로 인해 [27][28]스터디를 보고하거나 복제하려는 시도가 방해됩니다.

평가 및 인센티브

메타사이언스는 동료 검토를 위한 과학적 기반을 만드는 것을 추구한다.메타 리서치는 출판 전 피어 리뷰, 출판 후 피어 리뷰 및 오픈 피어 리뷰를 포함한 피어 리뷰 시스템을 평가합니다.그것은 또한 더 나은 연구 자금 [14]기준을 개발하기 위해 노력하고 있다.

메타사이언스는 더 나은 인센티브 시스템을 통해 더 나은 연구를 촉진하고자 한다.여기에는 연구 순위 부여 및 평가와 이를 수행하는 [14]사람에 대한 다양한 접근법의 정확성, 효과, 비용 및 편익 연구가 포함된다.비평가들은 비뚤어진 인센티브가 정크 사이언스, 저품질 연구, 그리고 [29][30]잘못된 긍정의 생산을 촉진하는 출판 또는 순환 환경을 학계에 조성했다고 주장한다.브라이언 노섹에 따르면, "우리가 직면한 문제는 인센티브 제도가 연구를 제대로 [31]하는 것보다 연구를 출판하는 데 초점을 맞추고 있다는 것입니다." 개혁의 지지자들은 인센티브 시스템을 보다 질 높은 [32]결과를 선호하도록 구성하려고 합니다.

연구 결과,[33][34][35] 연구 인력의 어느 정도와 무엇을 공헌했는지에 관계없이, 출판물 작성에 관여하고 있는 종래의 개념의 일반 저자를 사용하는 것이 아니라, 공헌도를 중시하는 과학 출판물 관리 시스템의 기계 판독 가능한 표준이 제안되었습니다.한 연구는 기고문헌의 지속적인 무시와 관련된 문제점 중 하나를 지적했다. 즉, "저자 리스트가 길어지고, 논문이 짧아지고, 출판 수가 [36]급증함에 따라 출판물의 수가 더 이상 좋은 지표가 되지 못하고 있다."

제출의 장점 이외의 요소는 동료 검토자의 [37]평가에 상당한 영향을 미칠 수 있습니다.그러나 이러한 요인은 연구자의 이전 출판물의 진실성 및 공공 이익과의 연계에 대한 기록의 사용과 같이 중요할 수 있다.그럼에도 불구하고, 평가 시스템(동료 검토 시스템 포함)은 인용 수나 종합적 지표와 같은 분석적 지표보다는 장점, 실제 긍정적 영향, 진전 및 공공 유용성을 지향하거나 잘 수행하는 메커니즘과 기준이 상당히 부족할 수 있다.그런 [38][39]목적을 가진 자들.

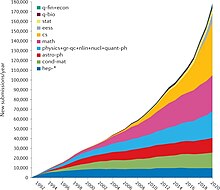

사이언트메트릭스

사이언티메트릭스는 과학 출판물의 서지 데이터를 측정하는 것과 관련이 있습니다.주요 연구 과제로는 연구 논문과 학술지의 영향 측정, 과학적 인용의 이해, 정책 및 경영 [40]맥락에서 그러한 측정의 활용 등이 있다.연구에 따르면 "출판수, 인용수, 영향인자 등 학문적 성공을 측정하는 데 사용되는 지표는 수십 년 동안 변하지 않았으며, 좋은 척도가 [36]되려면 어느 정도 중단되어야 한다"고 한다.

과학 거버넌스

과학 자금과 과학 거버넌스 또한 메타과학에 [41]의해 탐구될 수 있다.

인센티브

우선 순위 부여와 같은 다양한 개입이 중요할 수 있습니다.예를 들어 고의적으로 예를 들어 – 기술을 개발하고 있는, 미분 기술적 발전의 개념을 지칭한다. control-, 안전과 대 policy-technologies 위험한 생명 공학 등 다른 예방적 걸음 떨어진 곳에서도 위험을 주로 세계적인 비극적인 위험을 감소시킴으로써 기술이 개발되는 순서에 영향을 미침으로써 –.[42][43]올바른 결과를 보장하기 위해 확립된 형태의 법률과 인센티브에만 의존하는 것은 종종 너무[44] 느리거나 부적절할 수 있기 때문에 적절하지 않을 수 있습니다.

메타과학 기반 개혁을 포함한 과학 및 관련 과정을 통제하기 위한 다른 인센티브에는 일반인에 대한 설명 책임 보장(특히 공적 자금 지원 연구 또는 진지한 방식으로 공공 관심의 다양한 연구 주제에 대한 접근성 측면에서), 자격 있는 생산적 과학자의 증가가 포함될 수 있다.일반적으로 문제 해결을 개선하기 위해 과학의 효율성을 향상시키고, 인간의 생리학 등 확실한 과학적 근거에 기초한 명확한 사회적 요구를 적절히 우선시하고 대처한다.그러한 개입, 인센티브 및 개입 설계는 메타 과학의 대상이 될 수 있다.

과학 기금 및 수상

과학상은 과학 인센티브의 한 범주이다.메타사이언스는 과학상의 기존 및 가상 시스템을 탐구할 수 있다.예를 들어, 114/849개 분야 중 최소한 한 개의 노벨상을 받은 과학 분야만 36/71로 노벨상 클러스터가 수여하는 연구는 DC2와 DC3 분류 체계에 따라 분류될 수 있다는 것을 발견했다.114개 분야 중 5개 분야는 1995-2017년 노벨상 수상자의 절반 이상을 차지하는 것으로 나타났다(입자 물리학[14%], 세포 생물학[12.1%], 원자 물리학[10.9%], 신경 과학[10.1%], 분자 화학[5.3%)).[45][46]

한 연구에 따르면, 지식 생산과 과학에 대한 적절한 자금 지원에 대한 정책 입안자들의 책임 위임(집중화된 권위 기반의 하향식 접근법)은 매우 [41]간단하며, 결과적으로 "신뢰하고 유용한 지식"을 사회에 전달하는 것이 매우 간단하다는 것이 밝혀졌다.

측정 결과에 따르면 바이오 의료 자원의 할당은 [47]질병 부담보다는 이전 할당 및 연구와 더 강하게 관련될 수 있다.

한 연구는 "i] 안전 점검이 연구 보고서와 자금의 경쟁 선택에서 중재 메커니즘의 1차적 메커니즘으로 유지된다면 과학계는 그것이 자의적이지 않음을 확인할 필요가 있다"[37]고 시사한다.

한 연구에 따르면 "성공 측정 방법을 재고할 필요가 있다"고 합니다.(#과[36]진보의

과학 커뮤니케이션 및 공공 용도

"과학은 세계적인 공공재로서의 가치를 뒷받침하는 두 가지 기본 속성을 가지고 있다"는 주장이 제기되어 왔다. 즉, 지식 주장과 그 근거가 되는 증거는 정밀 조사를 위해 공개적으로 이용가능하며, 과학 연구의 결과는 신속하고 효율적으로 전달된다는 것이다.[48]메타사이언티픽 연구는 과학에 대한 언론 보도, 과학 저널리즘, [49][50][51][52]과학 교육자와 과학자들의 온라인 결과 커뮤니케이션과 같은 과학 커뮤니케이션의 주제를 탐구한다.한 연구에 따르면 "소셜 미디어를 사용하기 위해 제공되는 주요 인센티브 학문은 증폭"이며 "이러한 (또는 그러한) 플랫폼이 연구에 대한 진정한 참여를 촉진하는 방법에 더 초점을 맞춘 제도적 문화로 나아가야 한다"[53]고 한다.과학의 소통은 또한 과학자들에 대한 사회적 요구, 우려 및 요청의 의사소통을 수반할 수 있다.

대체 측정 도구는 평가와 검색 가능성뿐만 아니라 레딧, 위키피디아 인용, 뉴스 미디어에서의 연구에 대한 보고서와 같은 소셜 미디어에서 과학 논문에 대한 많은 공개 토론을 종합하여 메타과학적으로 분석하거나 관련 도구를 사용하여 사용할 수 있습니다.를 [54]참조해 주세요.

과학 데이터 과학

과학적 데이터 과학은 연구 논문을 분석하기 위해 데이터 과학을 사용하는 것입니다.그것은 질적 방법과 정량적 방법 모두를 포함한다.과학 데이터 과학 연구에는 사기[55] 탐지 및 인용 네트워크 [56]분석이 포함됩니다.

과학의 진화

과학적 실천

메타사이언스는 과학적 과정이 시간에 따라 어떻게 진화하는지 조사할 수 있다.한 연구에 따르면 팀의 규모는 "10년당 평균 17%씩 증가하고 있다"[47]고 합니다.

비공개 접근 출판물의 일반적인 형태와 많은 종래 저널에 부과되는 가격(공적인 자금 지원을 받는 논문이라도)은 보증되지 않거나 불필요하거나 차선책이며 과학적 [48][57][58][59]진보에 해로운 장벽인 것으로 밝혀졌다.

과학 전반 및 분야 내 개발

스터디에는 유용한 방법으로 활용, 보완 및 액세스할 수 있는 다양한 메타데이터가 있습니다.OpenAlex는 출처, 인용문, 저자 정보, 과학 분야 및 연구 주제 등의 메타데이터를 통합하고 제공하는 2억 개 이상의 과학 문서 무료 온라인 색인입니다.API와 오픈소스 웹사이트는 메타사이언스,[60][61][62] 사이언트 메트릭스 및 논문의 의미적 웹을 문의하는 새로운 도구에 사용할 수 있습니다.개발 중인 또 다른 프로젝트인 Scholia는 Wikidata의 "주제" [63]속성을 사용하여 SARS-CoV-2 바이러스의 특정 특성에 대한 간단한 사용자 인터페이스를 제공하는 등 다양한 시각화 및 집계 기능을 위해 과학 출판물의 메타데이터를 사용합니다.

공동 결과 해석의 과제

특정 연구 질문이나 연구 주제에 대한 연구는 종종 다양한 연구 결과를 통합, 비교, 비판적으로 분석하고 해석하는 상위 수준의 개요의 형태로 검토된다.그러한 작업의 예로는 과학적 검토와 메타 분석 등이 있다.이러한 관행과 관련된 관행은 다양한 도전에 직면해 있으며 메타사이언스의 대상이다.

지식 통합 및 생활 문서

다양한 문제들은 새롭고 기존의 과학에 기반을 둔 지식의 신속한 통합을 필요로 한다.특히 느슨하게 관련된 프로젝트와 이니셔티브가 다수 존재하는 설정은 공통의 근거 또는 "공통"[63]으로부터 이익을 얻는다.

증거 합성은 중요하고, 특히 비교적 긴급한 특정 글로벌 과제 모두에 적용될 수 있다. 즉, "기후 변화, 에너지 전환, 생물 다양성 손실, 항균성 내성, 빈곤 근절 등"더 나은 시스템은 살아있는 체계적인 검토(예: 살아있는 문서)를 통해 연구 증거의 요약을 최신 상태로 유지할 것을 제안했다.과학 논문과 데이터(또는 정보와 온라인 지식)의 수는 [additional citation(s) needed]크게 증가한 반면, 발표된 학술 체계적 리뷰의 수는 "2011년 약 6000건"에서 [64]2021년 45,000건 이상으로 증가했다.

메타 분석

예를 들어 사용된 방법의 이질성과 같은 포함되거나 이용 가능한 연구에 대한 다양한 문제는 메타 [69]분석의 잘못된 결론을 초래할 수 있다.

성공과 진보의 요인

두 명의 메타시언티스트는 이미 잘 인용된 논문에 불균형적으로 통합되어 표준적인 [70][71]진보를 늦추고 방해할 수 있는 증가하는 과학 분야 인용 흐름에서와 같이 "파괴적인 학문을 육성하고 새로운 아이디어에 주의를 집중하는 구조"가 중요할 수 있다고 보고했다.진정한 혁신적이고 고도로 학문 간 융합된 참신한 아이디어의 영향을 강화한다는 연구 결과는 확립된 [47]지식의 맥락에 배치되어야 한다.

다른 연구자들은 "수상 가능성, 국립과학아카데미(NAS) 유도, 또는 슈퍼스타돔" 측면에서 가장 성공적인 피실험자들은 피실험자의 멘토직 후 상을 받은 연구를 발표한 멘토 밑에서 연구했다고 보고했다.이러한 멘토들의 연구 주제보다 독창적인 주제를 공부하는 것도 [72][73]성공과 긍정적으로 연결되었다.

성공적인 과학의 이면에 있는 요소들에 대한 더 깊은 이해가 "사회 [47]문제를 보다 효과적으로 다루기 위해 과학 전체의 전망을 높일 수 있다"는 가설이 제기되었다.

개혁

과학적 실천의 결함을 찾아내는 메타 연구는 과학 개혁에 영감을 주었다.이러한 개혁은 저품질 또는 비효율적인 연구를 초래하는 과학적 실천의 문제를 해결하고 해결하고자 한다.

사전 등록

과학적 연구가 수행되기 전에 등록하는 관행을 사전 등록이라고 합니다.그것은 복제 위기를 해결하기 위한 수단으로서 생겨났다.사전등록은 등록된 보고서를 제출해야 하며, 이는 이론적 정당성, 실험설계 및 제안된 통계분석에 기초하여 저널에 의해 공개를 위해 승인되거나 거부된다.연구의 사전 등록은 출판 편향(예: 부정적인 결과를 발표하지 않음)을 방지하고, 데이터 준설을 줄이고,[74][75] 복제 가능성을 높이는 역할을 한다.

보고 기준

보고의 일관성과 품질이 낮은 것으로 나타난 연구는 과학 분야의 보고 표준과 가이드라인의 필요성을 입증했으며, 이는 CONTUS(Consolidated Standards of Reporting Trials) 및 적도 네트워크와 같은 그러한 표준을 작성하는 조직의 증가로 이어졌다.

URITO(Enhancy the Quality and Transparency Of Health Research)[76] 네트워크는 의료 연구 연구의 투명하고 정확한 보고를 촉진하여 의학 연구 문헌의 [77]가치와 신뢰성을 높이는 것을 목적으로 하는 국제적인 이니셔티브입니다.적도의 네트워크는 연구에 대한 좋은 보고의 중요성에 대한 인식을 높이고, 다양한 유형의 연구 설계에 대한 보고 지침의 개발, 보급 및 이행을 지원하며, 보건 과학 문헌에서 연구의 보고 품질 상태를 모니터링하는 것을 목표로 설립되었다.e, 건강 연구 [78]연구의 보고 품질에 영향을 미치는 문제와 관련된 연구를 수행한다.네트워크는 보고서 작성 지침 개발자, 의학 저널 편집자 및 동료 검토자, 연구 자금 지원 기관 및 기타 주요 이해관계자들이 연구 간행물 및 연구 자체의 품질 향상에 상호 관심을 가지고 모여 있는 "우산" 조직으로 기능합니다.

적용들

메타사이언스의 적용 분야는 ICT, 의학, 심리학 및 물리학을 포함한다.

ICT

메타사이언스는 기술 시스템(ICT)의 작성 및 개선과 과학 평가, 인센티브, 커뮤니케이션, 커미셔닝, 자금 조달, 규제, 생산, 관리, 사용 및 출판의 표준에 사용됩니다.그러한 것을 「응용 메타 과학」[79][better source needed]이라고 부를 수 있고, 연구의 양, 질, 그리고 긍정적인 영향을 증가시키는 방법을 모색할 수 있다.이에 대한 한 가지 예는 대체 [47]지표의 개발이다.과학적 [80][81]재현성 문제로 인해 "연구가 얼마나 자주 반복되었는지, 원래의 연구 결과가 확인되었는지 확인할 수 있는 간단한 방법"이 필요하다는 연구 결과가 나왔다.scite.ai 툴은 논문 인용을 추적하여 '지원', '댓글 작성' 또는 '대조'[82]로 연결하는 것을 목적으로 합니다.

약

의학에서의 임상 연구는 종종 질이 낮고,[83][84] 많은 연구들이 복제될 수 없다.연구비의 85%가 [85]낭비되고 있습니다.또한 편견의 존재는 연구 [86]품질에 영향을 미친다.제약 산업은 의학 연구의 설계와 실행에 상당한 영향력을 행사합니다.이해 상충은 의학 문헌의[87] 저자와 의학 저널의 편집자들 사이에서 흔히 볼 수 있다.거의 모든 의학 저널은 저자가 이해 상충을 공개하도록 요구하지만,[88] 편집자는 그렇게 할 필요가 없다.재정적 이해 상충은 긍정적인 연구 결과의 높은 비율과 연결되었다.항우울제 실험에서는 의약품 협찬이 실험 [89]결과의 가장 좋은 예측 변수입니다.

블라인딩은 메타 연구의 또 다른 초점이며, 블라인딩이 불량한 블라인딩으로 인한 오류는 실험적인 편견의 원천이다.블라인딩은 의학 문헌에서 잘 보고되지 않으며, 주제에 대한 광범위한 오해로 인해 임상 [90]시험에서 블라인딩의 구현이 제대로 이루어지지 않았다.또한 블라인드 장애는 측정 및 [91]보고되는 경우가 거의 없다.항우울제 실험에서 실명의 실패를 보여주는 연구는 일부 과학자들이 [92][93]항우울제가 플라시보보다 낫지 않다고 주장하게 만들었다.블라인딩의 실패를 보여주는 메타 연구에 비추어 볼 때,[94] 컨소시엄 표준은 모든 임상 시험에서 블라인딩의 품질을 평가하고 보고할 것을 권고한다.

연구에 따르면 기존 연구 증거에 대한 체계적인 검토는 새로운 연구를 계획하거나 [95]결과를 요약하는 데 차선책적으로 사용된다.의료 개입의 효과를 평가하는 연구의 누적 메타 분석 결과, 새로운 [96][97][98]시험을 수행하기 전에 기존 증거를 체계적으로 검토했다면 많은 임상 시험을 피할 수 있었다.예를 들어, Lau [96]외 연구진은 급성 심근경색에 대한 정맥 내 스트렙토키나아제 효과를 평가하는 33건의 임상시험(환자 36974명 포함)을 분석했다.이들의 누적 메타분석 결과 33개 재판 중 25개 재판은 새로운 재판을 실시하기 전에 체계적인 검토를 했더라면 피할 수 있었음을 알 수 있었다.즉, 34542명의 환자를 무작위로 추출하는 것은 잠재적으로 불필요했다.한[99] 연구는 227개의 메타분석에 포함된 1523개의 임상시험을 분석했고 "관련 선행 연구의 1/4 미만"이 인용되었다고 결론지었다.그들은 또한 대부분의 임상시험 보고서가 연구를 정당화하거나 [99]결과를 요약하기 위한 체계적인 검토를 제시하지 않는다는 이전 연구 결과를 확인했다.

현대의학에서 사용되는 많은 치료법이 효과가 없거나 심지어 해롭다는 것이 증명되었다.2007년 John Ioannidis의 연구에 따르면 의료계가 그 효능이 명백하게 [100][101]반증된 후 인기 있는 관행을 언급하는 것을 멈추는 데 평균 10년이 걸린 것으로 나타났다.

심리학

메타사이언스는 심리 연구에서 중대한 문제점을 밝혀냈다.이 분야는 높은 편중, 낮은 재현성 및 광범위한 통계 [102][103][104]오남용으로 어려움을 겪고 있다.복제 위기는 다른 어떤 분야보다 심리학에 더 큰 영향을 미칩니다. 고도로 공개된 연구 결과의 3분의 2는 [105]복제하는 것이 불가능할 수 있습니다.메타 리서치는 심리학 연구의 80-95%가 그들의 초기 가설을 지지한다는 것을 발견했는데, 이것은 출판 [106]편향의 존재를 강하게 암시한다.

레플리케이션의 위기로 인해, 중요한 [107][108]조사 결과를 재테스트하기 위한 새로운 노력이 필요하게 되었습니다.출판 편향과 p-해킹에 대한 우려에 대응하여 140개 이상의 심리학 저널이 결과 [109]맹목적인 동료 검토를 채택했다. 이 리뷰는 결과를 고려하지 않고 사전 등록되고 발표된다.이러한 개혁에 대한 분석에서는 결과 맹목적인 연구의 61%가 무효인 것으로 추정했는데, 이는 이전 연구의 5-20%와 대조를 이룬다.이 분석은 결과 맹목적인 안전 점검이 출판 [106]편향을 상당히 감소시킨다는 것을 보여준다.

심리학자들은 통계적 중요성과 실제적 중요성을 일상적으로 혼동하고, 중요하지 않은 [110]사실들에 대한 엄청난 확실성을 열정적으로 보고한다.일부 심리학자들은 p [citation needed]값에 대한 단독 의존보다는 효과 크기 통계를 더 많이 사용하여 대응했다.

물리

리처드 파인만은 물리 상수의 추정치가 우연으로 예상하는 것보다 발표된 값에 더 가깝다고 언급했다.이는 확인 편견의 결과로 생각되었다. 즉, 기존 문헌에 동의한 결과는 더 믿을 가능성이 높았고, 따라서 출판되었다.물리학자들은 이제 이러한 [111]편견을 방지하기 위해 블라인딩을 시행합니다.

조직 및 연구소

그 세계 meta-research –에 작업하는 이것들은 Meta-Research 혁신 센터 Berlin,[112]에서 Meta-Research 혁신 센터 Stanford,[113][114]에서 Meta-Research 센터 틸부르프:네덜란드 남부의 도시. 대학교, Meta-research 및에서 증거의 단위, 조지 연구소 글로벌에 해당한다의 여러 기관과 대학들은. 보건에 인도와오픈 사이언스 센터메타사이언스용 툴을 개발하는 조직에는 델의 리서치, 과학정합성센터, 알트메트릭스 회사가 있습니다.매년 메타사이언스 [115]컨퍼런스가 있다.

「 」를 참조해 주세요.

레퍼런스

- ^ Ioannidis, John P. A.; Fanelli, Daniele; Dunne, Debbie Drake; Goodman, Steven N. (2015-10-02). "Meta-research: Evaluation and Improvement of Research Methods and Practices". PLOS Biology. 13 (10): 1002264. doi:10.1371/journal.pbio.1002264. ISSN 1545-7885. PMC 4592065. PMID 26431313.

- ^ Bach, Becky (8 December 2015). "On communicating science and uncertainty: A podcast with John Ioannidis". Scope. Retrieved 20 May 2019.

- ^ a b Pashler, Harold; Wagenmakers, Eric Jan (2012). "Editors' Introduction to the Special Section on Replicability in Psychological Science: A Crisis of Confidence?". Perspectives on Psychological Science. 7 (6): 528–530. doi:10.1177/1745691612465253. PMID 26168108. S2CID 26361121.

- ^ a b Ioannidis, JP (August 2005). "Why most published research findings are false". PLOS Medicine. 2 (8): e124. doi:10.1371/journal.pmed.0020124. PMC 1182327. PMID 16060722.

- ^ Schor, Stanley (1966). "Statistical Evaluation of Medical Journal Manuscripts". JAMA: The Journal of the American Medical Association. 195 (13): 1123–1128. doi:10.1001/jama.1966.03100130097026. ISSN 0098-7484. PMID 5952081.

- ^ "Highly Cited Researchers". Retrieved September 17, 2015.

- ^ 의학 - 스탠포드 예방 연구 센터.존 P.A.요아니디스

- ^ Robert Lee Hotz (September 14, 2007). "Most Science Studies Appear to Be Tainted By Sloppy Analysis". Wall Street Journal. Dow Jones & Company. Retrieved 2016-12-05.

- ^ Howick J, Koleti D, Pandis N, Fleming PS, Loef M, Walach H, Schmidt S, Ioannidis JA.의료 개입에 대한 증거의 질은 개선되거나 악화되지 않는다: 코크란의 리뷰에 대한 메타 에피드역학 연구.임상 역학 저널 2020;126:154-159 [1]

- ^ "Researching the researchers". Nature Genetics. 46 (5): 417. 2014. doi:10.1038/ng.2972. ISSN 1061-4036. PMID 24769715.

- ^ Enserink, Martin (2018). "Research on research". Science. 361 (6408): 1178–1179. Bibcode:2018Sci...361.1178E. doi:10.1126/science.361.6408.1178. ISSN 0036-8075. PMID 30237336. S2CID 206626417.

- ^ Rennie, Drummond (1990). "Editorial Peer Review in Biomedical Publication". JAMA. 263 (10): 1317–1441. doi:10.1001/jama.1990.03440100011001. ISSN 0098-7484. PMID 2304208.

- ^ Harriman, Stephanie L.; Kowalczuk, Maria K.; Simera, Iveta; Wager, Elizabeth (2016). "A new forum for research on research integrity and peer review". Research Integrity and Peer Review. 1 (1): 5. doi:10.1186/s41073-016-0010-y. ISSN 2058-8615. PMC 5794038. PMID 29451544.

- ^ a b c d e f Ioannidis, John P. A.; Fanelli, Daniele; Dunne, Debbie Drake; Goodman, Steven N. (2 October 2015). "Meta-research: Evaluation and Improvement of Research Methods and Practices". PLOS Biology. 13 (10): e1002264. doi:10.1371/journal.pbio.1002264. ISSN 1544-9173. PMC 4592065. PMID 26431313.

- ^ Fanelli, Daniele; Costas, Rodrigo; Ioannidis, John P. A. (2017). "Meta-assessment of bias in science". Proceedings of the National Academy of Sciences of the United States of America. 114 (14): 3714–3719. doi:10.1073/pnas.1618569114. ISSN 1091-6490. PMC 5389310. PMID 28320937.

- ^ Check Hayden, Erika (2013). "Weak statistical standards implicated in scientific irreproducibility". Nature. doi:10.1038/nature.2013.14131. S2CID 211729036. Retrieved 9 May 2019.

- ^ Galipeau, James; Moher, David; Campbell, Craig; Hendry, Paul; Cameron, D. William; Palepu, Anita; Hébert, Paul C. (March 2015). "A systematic review highlights a knowledge gap regarding the effectiveness of health-related training programs in journalology". Journal of Clinical Epidemiology. 68 (3): 257–265. doi:10.1016/j.jclinepi.2014.09.024. PMID 25510373.

- ^ Wilson, Mitch; Moher, David (March 2019). "The Changing Landscape of Journalology in Medicine". Seminars in Nuclear Medicine. 49 (2): 105–114. doi:10.1053/j.semnuclmed.2018.11.009. hdl:10393/38493. PMID 30819390. S2CID 73471103.

- ^ a b c Couzin-Frankel, Jennifer (18 September 2018). "'Journalologists' use scientific methods to study academic publishing. Is their work improving science?". Science. doi:10.1126/science.aav4758. S2CID 115360831.

- ^ Schooler, J. W. (2014). "Metascience could rescue the 'replication crisis'". Nature. 515 (7525): 9. Bibcode:2014Natur.515....9S. doi:10.1038/515009a. PMID 25373639.

- ^ Smith, Noah (2 November 2017). "Why 'Statistical Significance' Is Often Insignificant". Bloomberg.com. Retrieved 7 November 2017.

- ^ Gary Marcus (May 1, 2013). "The Crisis in Social Psychology That Isn't". The New Yorker.

- ^ Jonah Lehrer (December 13, 2010). "The Truth Wears Off". The New Yorker.

- ^ "Dozens of major cancer studies can't be replicated". Science News. 7 December 2021. Retrieved 19 January 2022.

- ^ "Reproducibility Project: Cancer Biology". www.cos.io. Center for Open Science. Retrieved 19 January 2022.

- ^ Staddon, John (2017) 과학적 방법:과학이 어떻게 작용하는지, 실패하는지, 또는 작동하는 척하는지.테일러와 프란시스.

- ^ Yeung, Andy W. K. (2017). "Do Neuroscience Journals Accept Replications? A Survey of Literature". Frontiers in Human Neuroscience. 11: 468. doi:10.3389/fnhum.2017.00468. ISSN 1662-5161. PMC 5611708. PMID 28979201.

- ^ Martin, G. N.; Clarke, Richard M. (2017). "Are Psychology Journals Anti-replication? A Snapshot of Editorial Practices". Frontiers in Psychology. 8: 523. doi:10.3389/fpsyg.2017.00523. ISSN 1664-1078. PMC 5387793. PMID 28443044.

- ^ Binswanger, Mathias (2015). "How Nonsense Became Excellence: Forcing Professors to Publish". In Welpe, Isabell M.; Wollersheim, Jutta; Ringelhan, Stefanie; Osterloh, Margit (eds.). Incentives and Performance. Incentives and Performance: Governance of Research Organizations. Springer International Publishing. pp. 19–32. doi:10.1007/978-3-319-09785-5_2. ISBN 978-3319097855. S2CID 110698382.

- ^ Edwards, Marc A.; Roy, Siddhartha (2016-09-22). "Academic Research in the 21st Century: Maintaining Scientific Integrity in a Climate of Perverse Incentives and Hypercompetition". Environmental Engineering Science. 34 (1): 51–61. doi:10.1089/ees.2016.0223. PMC 5206685. PMID 28115824.

- ^ Brookshire, Bethany (21 October 2016). "Blame bad incentives for bad science". Science News. Retrieved 11 July 2019.

- ^ Smaldino, Paul E.; McElreath, Richard (2016). "The natural selection of bad science". Royal Society Open Science. 3 (9): 160384. arXiv:1605.09511. Bibcode:2016RSOS....360384S. doi:10.1098/rsos.160384. PMC 5043322. PMID 27703703.

- ^ Holcombe, Alex O. (September 2019). "Contributorship, Not Authorship: Use CRediT to Indicate Who Did What". Publications. 7 (3): 48. doi:10.3390/publications7030048.

- ^ McNutt, Marcia K.; Bradford, Monica; Drazen, Jeffrey M.; Hanson, Brooks; Howard, Bob; Jamieson, Kathleen Hall; Kiermer, Véronique; Marcus, Emilie; Pope, Barbara Kline; Schekman, Randy; Swaminathan, Sowmya; Stang, Peter J.; Verma, Inder M. (13 March 2018). "Transparency in authors' contributions and responsibilities to promote integrity in scientific publication". Proceedings of the National Academy of Sciences. 115 (11): 2557–2560. doi:10.1073/pnas.1715374115. ISSN 0027-8424. PMC 5856527. PMID 29487213.

- ^ Brand, Amy; Allen, Liz; Altman, Micah; Hlava, Marjorie; Scott, Jo (1 April 2015). "Beyond authorship: attribution, contribution, collaboration, and credit". Learned Publishing. 28 (2): 151–155. doi:10.1087/20150211. S2CID 45167271.

- ^ a b c Fire, Michael; Guestrin, Carlos (1 June 2019). "Over-optimization of academic publishing metrics: observing Goodhart's Law in action". GigaScience. 8 (6): giz053. doi:10.1093/gigascience/giz053. PMC 6541803. PMID 31144712.

- ^ a b Elson, Malte; Huff, Markus; Utz, Sonja (1 March 2020). "Metascience on Peer Review: Testing the Effects of a Study's Originality and Statistical Significance in a Field Experiment". Advances in Methods and Practices in Psychological Science. 3 (1): 53–65. doi:10.1177/2515245919895419. ISSN 2515-2459. S2CID 212778011.

- ^ McLean, Robert K D; Sen, Kunal (1 April 2019). "Making a difference in the real world? A meta-analysis of the quality of use-oriented research using the Research Quality Plus approach". Research Evaluation. 28 (2): 123–135. doi:10.1093/reseval/rvy026.

- ^ "Bringing Rigor to Relevant Questions: How Social Science Research Can Improve Youth Outcomes in the Real World" (PDF). Retrieved 22 November 2021.

- ^ Laydesdorff, L. 및 Milojevic, S., "Scientometrics" arXiv:1208.4566 (2013), Lynch, M. (편집자), 사회 및 행동과학 국제 백과사전 서브섹션 85030에서 발표.(2015)

- ^ a b Nielsen, Kristian H. (1 March 2021). "Science and public policy". Metascience. 30 (1): 79–81. doi:10.1007/s11016-020-00581-5. ISSN 1467-9981. PMC 7605730. S2CID 226237994.

- ^ Bostrom, Nick (2014). Superintelligence: Paths, Dangers, Strategies. Oxford: Oxford University Press. pp. 229–237. ISBN 978-0199678112.

- ^ Ord, Toby (2020). The Precipice: Existential Risk and the Future of Humanity. United Kingdom: Bloomsbury Publishing. p. 200. ISBN 978-1526600219.

- ^ "Technology is changing faster than regulators can keep up - here's how to close the gap". World Economic Forum. Retrieved 27 January 2022.

- ^ "Nobel prize-winning work is concentrated in minority of scientific fields". phys.org. Retrieved 17 August 2020.

- ^ Ioannidis, John P. A.; Cristea, Ioana-Alina; Boyack, Kevin W. (29 July 2020). "Work honored by Nobel prizes clusters heavily in a few scientific fields". PLOS ONE. 15 (7): e0234612. Bibcode:2020PLoSO..1534612I. doi:10.1371/journal.pone.0234612. ISSN 1932-6203. PMC 7390258. PMID 32726312.

- ^ a b c d e Fortunato, Santo; Bergstrom, Carl T.; Börner, Katy; Evans, James A.; Helbing, Dirk; Milojević, Staša; Petersen, Alexander M.; Radicchi, Filippo; Sinatra, Roberta; Uzzi, Brian; Vespignani, Alessandro; Waltman, Ludo; Wang, Dashun; Barabási, Albert-László (2 March 2018). "Science of science". Science. 359 (6379): eaao0185. doi:10.1126/science.aao0185. PMC 5949209. PMID 29496846. Retrieved 22 November 2021.

- ^ a b "Science as a Global Public Good". International Science Council. 8 October 2021. Retrieved 22 November 2021.

- ^ Jamieson, Kathleen Hall; Kahan, Dan; Scheufele, Dietram A. (17 May 2017). The Oxford Handbook of the Science of Science Communication. Oxford University Press. ISBN 978-0190497637.

- ^ Grochala, Rafał (16 December 2019). "Science communication in online media: influence of press releases on coverage of genetics and CRISPR". doi:10.1101/2019.12.13.875278. S2CID 213125031.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ "FRAMING ANALYSIS OF NEWS COVERAGE ON RENEWABLE ENERGYIN THE STAR ONLINE NEWS PORTAL" (PDF). Retrieved 22 November 2021.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ MacLaughlin, Ansel; Wihbey, John; Smith, David (15 June 2018). "Predicting News Coverage of Scientific Articles". Proceedings of the International AAAI Conference on Web and Social Media. 12 (1). ISSN 2334-0770.

- ^ Carrigan, Mark; Jordan, Katy (4 November 2021). "Platforms and Institutions in the Post-Pandemic University: a Case Study of Social Media and the Impact Agenda". Postdigital Science and Education. 4 (2): 354–372. doi:10.1007/s42438-021-00269-x. ISSN 2524-4868. S2CID 243760357.

- ^ Baykoucheva, Svetla (2015). "Measuring attention". Managing Scientific Information and Research Data: 127–136. doi:10.1016/B978-0-08-100195-0.00014-7. ISBN 978-0081001950.

- ^ Markowitz, David M.; Hancock, Jeffrey T. (2016). "Linguistic obfuscation in fraudulent science". Journal of Language and Social Psychology. 35 (4): 435–445. doi:10.1177/0261927X15614605. S2CID 146174471.

- ^ Ding, Y. (2010). "Applying weighted PageRank to author citation networks". Journal of the American Society for Information Science and Technology. 62 (2): 236–245. arXiv:1102.1760. doi:10.1002/asi.21452. S2CID 3752804.

- ^ "Nature Journals To Charge Authors Hefty Fee To Make Scientific Papers Open Access". IFLScience. Retrieved 22 November 2021.

- ^ "Harvard University says it can't afford journal publishers' prices". The Guardian. 24 April 2012. Retrieved 22 November 2021.

- ^ Van Noorden, Richard (1 March 2013). "Open access: The true cost of science publishing". Nature. 495 (7442): 426–429. Bibcode:2013Natur.495..426V. doi:10.1038/495426a. ISSN 1476-4687. PMID 23538808. S2CID 27021567.

- ^ Singh Chawla, Dalmeet (24 January 2022). "Massive open index of scholarly papers launches". Nature. doi:10.1038/d41586-022-00138-y. Retrieved 14 February 2022.

- ^ "OpenAlex: The Promising Alternative to Microsoft Academic Graph". Singapore Management University (SMU). Retrieved 14 February 2022.

- ^ "OpenAlex Documentation". Retrieved 18 February 2022.

- ^ a b Waagmeester, Andra; Willighagen, Egon L.; Su, Andrew I.; Kutmon, Martina; Gayo, Jose Emilio Labra; Fernández-Álvarez, Daniel; Groom, Quentin; Schaap, Peter J.; Verhagen, Lisa M.; Koehorst, Jasper J. (22 January 2021). "A protocol for adding knowledge to Wikidata: aligning resources on human coronaviruses". BMC Biology. 19 (1): 12. doi:10.1186/s12915-020-00940-y. ISSN 1741-7007. PMC 7820539. PMID 33482803.

- ^ Elliott, Julian; Lawrence, Rebecca; Minx, Jan C.; Oladapo, Olufemi T.; Ravaud, Philippe; Tendal Jeppesen, Britta; Thomas, James; Turner, Tari; Vandvik, Per Olav; Grimshaw, Jeremy M. (December 2021). "Decision makers need constantly updated evidence synthesis". Nature. 600 (7889): 383–385. Bibcode:2021Natur.600..383E. doi:10.1038/d41586-021-03690-1. PMID 34912079. S2CID 245220047.

- ^ LeLorier J, Grégoire G, Benhaddad A, Lapierre J, Derderian F (August 1997). "Discrepancies between meta-analyses and subsequent large randomized, controlled trials". The New England Journal of Medicine. 337 (8): 536–542. doi:10.1056/NEJM199708213370806. PMID 9262498.

- ^ a b Slavin RE (1986). "Best-Evidence Synthesis: An Alternative to Meta-Analytic and Traditional Reviews". Educational Researcher. 15 (9): 5–9. doi:10.3102/0013189X015009005. S2CID 146457142.

- ^ Hunter JE, Schmidt FL, Jackson GB, et al. (American Psychological Association. Division of Industrial-Organizational Psychology) (1982). Meta-analysis: cumulating research findings across studies. Beverly Hills, California: Sage. ISBN 978-0-8039-1864-1.

- ^ Glass GV, McGaw B, Smith ML (1981). Meta-analysis in social research. Beverly Hills, California: Sage Publications. ISBN 978-0-8039-1633-3.

- ^ Stone, Dianna L.; Rosopa, Patrick J. (1 March 2017). "The Advantages and Limitations of Using Meta-analysis in Human Resource Management Research". Human Resource Management Review. 27 (1): 1–7. doi:10.1016/j.hrmr.2016.09.001. ISSN 1053-4822.

- ^ Snyder, Alison (14 October 2021). "New ideas are struggling to emerge from the sea of science". Axios. Retrieved 15 November 2021.

- ^ Chu, Johan S. G.; Evans, James A. (12 October 2021). "Slowed canonical progress in large fields of science". Proceedings of the National Academy of Sciences. 118 (41): e2021636118. doi:10.1073/pnas.2021636118. ISSN 0027-8424. PMC 8522281. PMID 34607941.

- ^ "Sharing of tacit knowledge is most important aspect of mentorship, study finds". phys.org. Retrieved 4 July 2020.

- ^ Ma, Yifang; Mukherjee, Satyam; Uzzi, Brian (23 June 2020). "Mentorship and protégé success in STEM fields". Proceedings of the National Academy of Sciences. 117 (25): 14077–14083. doi:10.1073/pnas.1915516117. ISSN 0027-8424. PMC 7322065. PMID 32522881.

- ^ "Registered Replication Reports". Association for Psychological Science. Retrieved 2015-11-13.

- ^ Chambers, Chris (2014-05-20). "Psychology's 'registration revolution'". the Guardian. Retrieved 2015-11-13.

- ^ Simera, I; Moher, D; Hirst, A; Hoey, J; Schulz, KF; Altman, DG (2010). "Transparent and accurate reporting increases reliability, utility, and impact of your research: reporting guidelines and the EQUATOR Network". BMC Medicine. 8: 24. doi:10.1186/1741-7015-8-24. PMC 2874506. PMID 20420659.

- ^ Simera, I.; Moher, D.; Hoey, J.; Schulz, K. F.; Altman, D. G. (2010). "A catalogue of reporting guidelines for health research". European Journal of Clinical Investigation. 40 (1): 35–53. doi:10.1111/j.1365-2362.2009.02234.x. PMID 20055895.

- ^ Simera, I; Altman, DG (October 2009). "Writing a research article that is "fit for purpose": EQUATOR Network and reporting guidelines". Evidence-Based Medicine. 14 (5): 132–134. doi:10.1136/ebm.14.5.132. PMID 19794009. S2CID 36739841.

- ^ Ep. 49: Joel Chan on metascience, creativity, and tools for thought.

- ^ "A new replication crisis: Research that is less likely to be true is cited more". phys.org. Retrieved 14 June 2021.

- ^ Serra-Garcia, Marta; Gneezy, Uri (2021-05-01). "Nonreplicable publications are cited more than replicable ones". Science Advances. 7 (21): eabd1705. Bibcode:2021SciA....7D1705S. doi:10.1126/sciadv.abd1705. ISSN 2375-2548. PMC 8139580. PMID 34020944.

- ^ Khamsi, Roxanne (1 May 2020). "Coronavirus in context: Scite.ai tracks positive and negative citations for COVID-19 literature". Nature. doi:10.1038/d41586-020-01324-6. Retrieved 19 February 2022.

- ^ Ioannidis, JPA (2016). "Why Most Clinical Research Is Not Useful". PLOS Med. 13 (6): e1002049. doi:10.1371/journal.pmed.1002049. PMC 4915619. PMID 27328301.

- ^ Ioannidis JA (13 July 2005). "Contradicted and initially stronger effects in highly cited clinical research". JAMA. 294 (2): 218–228. doi:10.1001/jama.294.2.218. PMID 16014596.

- ^ Chalmers, Iain; Glasziou, Paul (2009). "Avoidable waste in the production and reporting of research evidence". The Lancet. 374 (9683): 86–89. doi:10.1016/S0140-6736(09)60329-9. ISSN 0140-6736. PMID 19525005. S2CID 11797088.

- ^ June 24, Jeremy Hsu; ET, Jeremy Hsu (24 June 2010). "Dark Side of Medical Research: Widespread Bias and Omissions". Live Science. Retrieved 24 May 2019.

- ^ "Confronting conflict of interest". Nature Medicine. 24 (11): 1629. November 2018. doi:10.1038/s41591-018-0256-7. ISSN 1546-170X. PMID 30401866.

- ^ Haque, Waqas; Minhajuddin, Abu; Gupta, Arjun; Agrawal, Deepak (2018). "Conflicts of interest of editors of medical journals". PLOS ONE. 13 (5): e0197141. Bibcode:2018PLoSO..1397141H. doi:10.1371/journal.pone.0197141. ISSN 1932-6203. PMC 5959187. PMID 29775468.

- ^ Moncrieff, J (March 2002). "The antidepressant debate". The British Journal of Psychiatry. 180 (3): 193–194. doi:10.1192/bjp.180.3.193. ISSN 0007-1250. PMID 11872507.

- ^ Bello, S; Moustgaard, H; Hróbjartsson, A (October 2014). "The risk of unblinding was infrequently and incompletely reported in 300 randomized clinical trial publications". Journal of Clinical Epidemiology. 67 (10): 1059–1069. doi:10.1016/j.jclinepi.2014.05.007. ISSN 1878-5921. PMID 24973822.

- ^ Tuleu, Catherine; Legay, Helene; Orlu-Gul, Mine; Wan, Mandy (1 September 2013). "Blinding in pharmacological trials: the devil is in the details". Archives of Disease in Childhood. 98 (9): 656–659. doi:10.1136/archdischild-2013-304037. ISSN 0003-9888. PMC 3833301. PMID 23898156.

- ^ Kirsch, I (2014). "Antidepressants and the Placebo Effect". Zeitschrift für Psychologie. 222 (3): 128–134. doi:10.1027/2151-2604/a000176. ISSN 2190-8370. PMC 4172306. PMID 25279271.

- ^ Ioannidis, John PA (27 May 2008). "Effectiveness of antidepressants: an evidence myth constructed from a thousand randomized trials?". Philosophy, Ethics, and Humanities in Medicine. 3: 14. doi:10.1186/1747-5341-3-14. ISSN 1747-5341. PMC 2412901. PMID 18505564.

- ^ Moher, David; Altman, Douglas G.; Schulz, Kenneth F. (24 March 2010). "CONSORT 2010 Statement: updated guidelines for reporting parallel group randomised trials". BMJ. 340: c332. doi:10.1136/bmj.c332. ISSN 0959-8138. PMC 2844940. PMID 20332509.

- ^ Clarke, Michael; Chalmers, Iain (1998). "Discussion Sections in Reports of Controlled Trials Published in General Medical Journals". JAMA. 280 (3): 280–282. doi:10.1001/jama.280.3.280. PMID 9676682.

- ^ a b Lau, Joseph; Antman, Elliott M; Jimenez-Silva, Jeanette; Kupelnick, Bruce; Mosteller, Frederick; Chalmers, Thomas C (1992). "Cumulative Meta-Analysis of Therapeutic Trials for Myocardial Infarction". New England Journal of Medicine. 327 (4): 248–254. doi:10.1056/NEJM199207233270406. PMID 1614465.

- ^ Fergusson, Dean; Glass, Kathleen Cranley; Hutton, Brian; Shapiro, Stan (2016). "Randomized controlled trials of aprotinin in cardiac surgery: Could clinical equipoise have stopped the bleeding?". Clinical Trials. 2 (3): 218–229, discussion 229–232. doi:10.1191/1740774505cn085oa. PMID 16279145. S2CID 31375469.

- ^ Clarke, Mike; Brice, Anne; Chalmers, Iain (2014). "Accumulating Research: A Systematic Account of How Cumulative Meta-Analyses Would Have Provided Knowledge, Improved Health, Reduced Harm and Saved Resources". PLOS ONE. 9 (7): e102670. Bibcode:2014PLoSO...9j2670C. doi:10.1371/journal.pone.0102670. PMC 4113310. PMID 25068257.

- ^ a b Robinson, Karen A; Goodman, Steven N (2011). "A Systematic Examination of the Citation of Prior Research in Reports of Randomized, Controlled Trials". Annals of Internal Medicine. 154 (1): 50–55. doi:10.7326/0003-4819-154-1-201101040-00007. PMID 21200038. S2CID 207536137.

- ^ Epstein, David. "When Evidence Says No, but Doctors Say Yes - The Atlantic". Pocket. Retrieved 10 April 2020.

- ^ Tatsioni, A; Bonitsis, NG; Ioannidis, JP (5 December 2007). "Persistence of contradicted claims in the literature". JAMA. 298 (21): 2517–2526. doi:10.1001/jama.298.21.2517. ISSN 1538-3598. PMID 18056905.

- ^ Franco, Annie; Malhotra, Neil; Simonovits, Gabor (1 January 2016). "Underreporting in Psychology Experiments: Evidence From a Study Registry". Social Psychological and Personality Science. 7 (1): 8–12. doi:10.1177/1948550615598377. ISSN 1948-5506. S2CID 143182733.

- ^ Munafò, Marcus (29 March 2017). "Metascience: Reproducibility blues". Nature. 543 (7647): 619–620. Bibcode:2017Natur.543..619M. doi:10.1038/543619a. ISSN 1476-4687.

- ^ Stokstad, Erik (20 September 2018). "This research group seeks to expose weaknesses in science – and they'll step on some toes if they have to". Science. doi:10.1126/science.aav4784. S2CID 158525979.

- ^ Open Science Collaboration (2015). "Estimating the reproducibility of psychological science" (PDF). Science. 349 (6251): aac4716. doi:10.1126/science.aac4716. hdl:10722/230596. PMID 26315443. S2CID 218065162.

- ^ a b Allen, Christopher P G.; Mehler, David Marc Anton. "Open Science challenges, benefits and tips in early career and beyond". doi:10.31234/osf.io/3czyt. S2CID 240061030.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Simmons, Joseph P.; Nelson, Leif D.; Simonsohn, Uri (2011). "False-Positive Psychology". Psychological Science. 22 (11): 1359–1366. doi:10.1177/0956797611417632. PMID 22006061.

- ^ Stroebe, Wolfgang; Strack, Fritz (2014). "The Alleged Crisis and the Illusion of Exact Replication" (PDF). Perspectives on Psychological Science. 9 (1): 59–71. doi:10.1177/1745691613514450. PMID 26173241. S2CID 31938129.

- ^ Aschwanden, Christie (6 December 2018). "Psychology's Replication Crisis Has Made The Field Better". FiveThirtyEight. Retrieved 19 December 2018.

- ^ Cohen, Jacob (1994). "The earth is round (p < .05)". American Psychologist. 49 (12): 997–1003. doi:10.1037/0003-066X.49.12.997. S2CID 380942.

- ^ MacCoun, Robert; Perlmutter, Saul (8 October 2015). "Blind analysis: Hide results to seek the truth". Nature. 526 (7572): 187–189. Bibcode:2015Natur.526..187M. doi:10.1038/526187a. PMID 26450040.

- ^ Berlin, Meta-Research Innovation Center. "Meta-Research Innovation Center Berlin". Meta-Research Innovation Center Berlin. Retrieved 2021-12-06.

- ^ "Home Meta-research Innovation Center at Stanford". metrics.stanford.edu. Retrieved 2021-12-06.

- ^ "Meta-research and Evidence Synthesis Unit". The George Institute for Global Health. Retrieved 2021-12-19.

- ^ "Metascience 2021". Metascience 2021. Retrieved 20 February 2022.

추가 정보

- Lydia Denworth, "중요한 문제:표준적인 과학적 방법이 비난을 받고 있다.무엇이 바뀔 것인가?" Scientific American, vol. 321, no. 4(2019년 10월), 페이지 62-67. "실험 결과의 통계적 유의성을 결정하기 위해 거의 1세기 동안 p 값을 사용한 것은 많은 과학 분야에서 확실성과 재현성 위기에 대한 환상에 기여했다.통계 분석을 개혁하겠다는 의지가 강해지고 있다.일부 [연구자]는 통계 방법을 변경할 것을 제안하는 반면, 다른 [연구자]는 "중요한" 결과를 정의하기 위한 임계값을 없앨 것이다.(p.63).

- Harris, Richard (2017). Rigor Mortis: How Sloppy Science Creates Worthless Cures, Crushes Hopes, and Wastes Billions. Basic Books. ISBN 978-0465097913.

외부 링크

일지

회의