통계 에서 투영 행렬 (P {\displaystyle (\mathbf {P [1] 영향 행렬 [2] 모자 행렬 (H ( {\displaystyle(\mathbf {H} ) 반응 값 (종속 변수 값)의 벡터를 적합치 (또는 예측 값)의 벡터에 매핑한다. 각 반응 값이 각 적합치에 미치는 영향 을 설명한다.[3] [4] 투영 매트릭스의 대각선 요소는 레버리지 로, 동일한 관측치에 대한 각 반응 값이 적합치에 미치는 영향을 설명한다.

정의 반응 값 의 벡터가 y {\ displaystyle \mathbf {y} y ^ {\ mathbf hat 의해 ,

y ^ = P y . {\displaystyle \mathbf {\hat {y} =\mathbf {P} \mathbf {y} .} y^ {\ displaystyle \mathbf {\hat y}}} ( P {\ displaystyle \mathbf {P}} y {\ displaysty \mathbf {y}" 모자 를 씌우면서 hat 행렬 로 명명된다

P {\ displaystyle \mathbf {P} 사이 의 공분산과 동일하며분산 으로 나눈 값:[citation needed

p i j = 코브 [ y ^ i , y j ] VAR [ y j ] {\displaystyle p_{ij}={\frac {\operatorname {Cov} \left[{y}_{i}}}, y_{j}\right]{\operatorname {Var} \left[y_{j}\rig]} }} 잔차 적용 잔차 r {\ displaystyle \mathbf {r} }

r = y − y ^ = y − P y = ( I − P ) y . {\displaystyle \mathbf {r} =\mathbf {y} -\mathbf {y} -\mathbf {P} \mathbf {y} -\mathbf {I} =\lef(\mathbf {I} -\right)\mathbf {y}. 여기 {\ displaystyle \mathbf {I} ( ID 행렬 이다. M ≡ P {\ displaystyle \mathbf {M} \equiv \mathbf {I} \mathbf {P} 잔차 메이커 행렬이라고 도 한다.

오류 전파 에 의한 r {\ displaystyle \mathbf {r} 공분산 행렬 이 동일함

Σ r = ( I − P ) T Σ ( I − P ) {\displaystyle \mathbf {\Sigma } _{\mathbf {r} }=\left(\mathbf {I} -\mathbf {P} \right)^{\textsf {T}}\mathbf {\Sigma } \left(\mathbf {I} -\mathbf {P} \right)} 여기서 σ {\ displaystyle \mathbf {\Sigma } 공분산 행렬(그리고 확장자로도 응답 벡터)이다 σ σ 2 I {\ displaystyle \mathbf {\Sigma =\sigma ^{2}\mathbf {I}} 선형 모델 의 경우, [3]

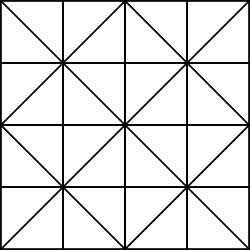

σ I P σ 2 {\ displaystyle \mathbf {\Sigma _{\mathbf {r}}=\left(\mathbf {I} \mathbf {P}\right)\sigma ^{2 직감 행렬 A {\ displaystyle \mathbf {A} A {\ displaystyle \mathbf {b} b {\ \mathbf A} x {\ displaystyle \mathbf {x} . From the figure, it is clear that the closest point from the vector b {\displaystyle \mathbf {b} } A {\displaystyle \mathbf {A} } A x {\displaystyle \mathbf {Ax} } A {\displaystyle \mathbf {A} } 행렬의 열 공간에 직교하는 것은 전치 행렬의 null 공간에 있으므로

A T ( b − A x ) = 0 {\displaystyle \mathbf {A}^{\textsf {T}(\mathbf {b} -\mathbf {Ax} )=0} 거기서부터 한 척의 백랑이, 그러니까.

A T b − A T A x = 0 ⇒ A T b = A T A x ⇒ x = ( A T A ) − 1 A T b {\displaystyle{\begin{정렬}&,&\mathbf{A}^{\textsf{T}}{b}및 \mathbf, -\mathbf{A}^{\textsf{T}}{도끼를}=0\\\Rightarrow 및 \mathbf,&\mathbf{A}^{\textsf{T}}{b}및 \mathbf, =\mathbf{A}^{\textsf{T}}{도끼를}\\\Rightarrow 및 \mathbf,&\mathbf{)}&=\left(\mathbf{A}^{\textsf{T}}\mathbf{A}\right)^{)}\mathbf{A}^{\text.sf{T}}}{b}\end{정렬}\mathbf} Therefore, since x {\displaystyle \mathbf {x} } A {\displaystyle \mathbf {A} } b {\displaystyle \mathbf {b} } x {\displaystyle \mathbf {x} } A x {\displaystyle \mathbf {Ax} } A ( A T A ) − 1 A T b {\ displaystyle \mathbf {A} \left(\mathbf {A} ^{\textsf {T}\mathbf {A} \right)^{-1}\mathbf {A} ^{\textsf {T}\mathbf {b}}}}}}}}}}}}}}}}}}}}}}}}}

선형 모형 선형 최소 제곱을 사용하여 선형 모형을 추정한다고 가정합시다. 모델은 다음과 같이 쓸 수 있다.

y = X β + ε , {\displaystyle \mathbf {y} =\mathbf {X} {\boldsymbol {\beta }+{\boldsymbol {\barepsilon},} 여기서 X {\ displaystyle \mathbf {X} ( 설명 변수 의 행렬(설계 행렬 ), β는 추정 오차

많은 유형의 모델과 기법은 이 공식에 따른다. 선형 최소 제곱 , 평활 스플라인 , 회귀 스플라인 , 로컬 회귀 분석, 커널 회귀 분석 및 선형 필터링 등이 몇 가지 예다.

보통 최소 제곱 각 관측치의 가중치가 동일하고 오차 가 상관관계가 없을 때 추정된 모수는 다음과 같다.

β ^ = ( X T X ) − 1 X T y , {\displaystyle {\boldsymbol {\beta}}=\왼쪽(\mathbf {X}) ^{\textsf {T}\x}^{-1}\mathbf {X}^{\textsf {T}\mathbf {y},},},}} 적합치는 다음과 같다.

y ^ = X β ^ = X ( X T X ) − 1 X T y . {\displaystyle {\hat {\mathbf {y} }}=\mathbf {X} {\hat {\boldsymbol {\beta }}}=\mathbf {X} \left(\mathbf {X} ^{\textsf {T}}\mathbf {X} \right)^{-1}\mathbf {X} ^{\textsf {T}}\mathbf {y} .} 따라서 투영 매트릭스(및 hat 매트릭스)는 다음에 의해 주어진다.

P ≡ X ( X T X ) − 1 X T . {\displaystyle \mathbf {P} \equiv \mathbf {X} \좌(\mathbf {X}) ^{\textsf {T}\mathbf {X}^{-1}\mathbf {X} ^{\textsf {T}}}. } 가중 및 일반화 최소 제곱 위 사항은 가중치가 동일하지 않거나 오차가 상관관계가 있는 경우로 일반화할 수 있다. 오차의 공분산 행렬 이 σ 이라고 가정합시다. 그 후

β ^ GLS σ X X T σ y {\ displaystyle {\hat {\mathbf {\beta}}}}{\text{ GLS}}=\left(\mathbf {X} ^{\textsf {T}}\mathbf {\Sigma } ^{-1}\mathbf {X} \right)^{-1}\mathbf {X} ^{\textsf {T}}\mathbf {\Sigma } ^{-1}\mathbf {y} } 모자 행렬은 다음과 같다.

H = X ( X T Σ − 1 X ) − 1 X T Σ − 1 {\displaystyle \mathbf {H} =\mathbf {X} \left(\mathbf {X} ^{\textsf {T}}\mathbf {\Sigma } ^{-1}\mathbf {X} \right)^{-1}\mathbf {X} ^{\textsf {T}}\mathbf {\Sigma } ^{-1}} 그리고 아니지만 H 2 H {\displaystyle H^{2}=H\cdot H=H} .

특성. 투영 매트릭스에는 여러 가지 유용한 대수적 특성이 있다.[5] [6] 선형 대수학의 언어로 설계 매트릭스 X{\displaystyle \mathbf{X}의 세로 줄 공간에 프로젝션 행렬은 정사영}}}은 pseudoi(그(XTX습니다)− 1XT{\displaystyle \left(\mathbf{X}^{\textsf{T}}\mathbf{X}\right)^{)}\mathbf{X}^{\textsf{T}.[4].nv X .) 이 설정에서 투영 행렬의 일부 사실은 다음과 같이 요약된다.[4]

u = ( I − P ) y , {\displaystyle \mathbf {u} =(\mathbf {I} -\mathbf {P} )\mathbf {y} ,} u = y − P y ⊥ X . {\displaystyle \mathbf {u} =\mathbf {y} -\mathbf {P} \mathbf {y} \perp \mathbf {X} .} P {\ displaystyle \mathbf {P}} M ≡ I P {\ displaystyle \mathbf {M} \equiv \mathbf {I} \mathbf {P} } . P {\ displaystyle \mathbf {P} } P P displaystyle \mathbf {P} ^{2}=\mathbf {P} M {\ displaysty \mathbf {M} . X {\ displaystyle \ mathbf {X}} ) 랭크 ( X r {\displaystyle \operatorname {rank }(\mathbf {X} 경우 랭크 ( ) r {\displaysty \operatorname {rank}(\mathbf {P})=r}). P {\ displaystyle \mathbf {P} 고유값 은 r 1과 n 0 M {\ displaystyle \mathbf {M}} n 1 0 으로 구성된다[7] X {\displaystyle \mathbf {X} } P {\displaystyle \mathbf {P} } P X = X , {\displaystyle \mathbf {PX} =\mathbf {X} ,} ( I − P ) X = 0 {\displaystyle \left(\mathbf {I} -\mathbf {P} \right)\mathbf {X} =\mathbf {0} } ( I − P ) P = P ( I − P ) = 0 . {\displaystyle \left(\mathbf {I} -\mathbf {P} \right)\mathbf {P} \left(\mathbf {I} -\mathbf {P} \right)=\mathbf {0}.} P {\ displaystyle \mathbf {P} } 선형 모형 에 해당하는 투영 행렬은 대칭 및 idempotent , 즉 P 2 {\ displaystyle \mathbf {P}^{2}=\mathbf {P 국소 가중 산점도 평활(LOESS) 에서는 모자 행렬이 일반적으로 대칭이나 idempotentent가 아니다.

선형 모형 의 경우 투영 행렬 의 트레이스는 선형 모형의 독립 매개변수 수인 X {\ displaystyle \mathbf {X} 순위 와 동일하다. [8] 관측치 y {\ displaystyle \mathbf {y} 유효 자유도 를 정의할 수 있다.

회귀 분석에서 투영 행렬의 실제 적용은 레버리지 와 Cook 의 거리를 포함하며, 영향력 있는 관측치, 즉 회귀 분석 결과에 큰 영향을 미치는 관측치를 식별하는 것과 관련이 있다.

블럭화 공식 설계 행렬 X {\displaystyle X} X B ] {\ displaystyle X={\begin{bmatrix}A& B\end{bmatrix}}} P { X } = X ( X T X ) − 1 X T {\displaystyle P\{X\}=X\left(X^{\textsf {T}}X\right)^{-1}X^{\textsf {T}}} M { X } = I − P { X } {\displaystyle M\{X\}=I-P\{X\}} llows:[9]

P { X } = P { A } + P { M { A } B } , P\{X\}=P\{displaystyle P\} A\}+P\{M\ {A\}B\}} where, e.g., P { A } = A ( A T A ) − 1 A T {\displaystyle P\{A\}=A\left(A^{\textsf {T}}A\right)^{-1}A^{\textsf {T}}} M { A } = I − P { A } {\displaystyle M\{A\}=I-P\{ A 고전적 어플리케이션 A {\displaystyle A} 또 다른 용도는 고정 효과 모델 에서 사용되며, 여기 {\displaystyle A} 희소 행렬 이다 너무 {\displaystyle X } X {\displaystyle X } .

참고 항목 참조 ^ Basilevsky, Alexander (2005). Applied Matrix Algebra in the Statistical Sciences ISBN 0-486-44538-0 ^ "Data Assimilation: Observation influence diagnostic of a data assimilation system" (PDF) . Archived from the original (PDF) on 2014-09-03.^ a b Hoaglin, David C.; Welsch, Roy E. (February 1978). "The Hat Matrix in Regression and ANOVA" (PDF) . The American Statistician 32 (1): 17–22. doi :10.2307/2683469 . hdl :1721.1/1920 JSTOR 2683469 . ^ a b c David A. Freedman (2009). Statistical Models: Theory and Practice . Cambridge University Press .^ Gans, P. (1992). Data Fitting in the Chemical Sciences ISBN 0-471-93412-7 ^ Draper, N. R.; Smith, H. (1998). Applied Regression Analysis . Wiley. ISBN 0-471-17082-8 ^ Amemiya, Takeshi (1985). Advanced Econometrics 460 –461. ISBN 0-674-00560-0 ^ "Proof that trace of 'hat' matrix in linear regression is rank of X" . Stack Exchange . April 13, 2017.^ Rao, C. Radhakrishna; Toutenburg, Helge; Shalabh; Heumann, Christian (2008). Linear Models and Generalizations 323 . ISBN 978-3-540-74226-5

![{\displaystyle p_{ij}={\frac {\operatorname {Cov} \left[{\hat {y}}_{i},y_{j}\right]}{\operatorname {Var} \left[y_{j}\right]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3ebb67e8f8d3b9ef02d777944b63b2c22d0e89fe)

모든 어플리케이션의 컬럼으로, 회귀에 절편 용어를 추가하는 효과를 분석할 수 있다. 또 다른 용도는

모든 어플리케이션의 컬럼으로, 회귀에 절편 용어를 추가하는 효과를 분석할 수 있다. 또 다른 용도는