모델 선택

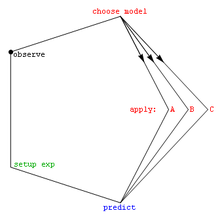

Model selection모델 선택은 데이터가 주어진 후보 모델 집합에서 통계 모델을 선택하는 작업이다.가장 단순한 경우 기존 데이터 세트가 고려됩니다.그러나 이 작업은 수집된 데이터가 모델 선택 문제에 잘 적합하도록 실험 설계를 포함할 수도 있다.예측력 또는 설명력이 유사한 후보 모델을 고려할 때 가장 단순한 모델이 최선의 선택일 가능성이 높습니다(Occam의 면도기).

Konishi & Kitagawa(2008, 페이지 75)는 "통계적 추론의 문제의 대부분은 통계적 모델링과 관련된 문제로 간주될 수 있다"고 말한다.이와 관련, Cox(2006, 페이지 197)는 "주제 문제에서 통계 모델로 [어떻게] 변환하는지가 종종 분석에서 가장 중요한 부분이다."라고 말했다.

모델 선택은 [1]또한 불확실성 하에서 의사결정을 하거나 최적화를 위해 대규모 계산 모델 집합에서 몇 가지 대표 모델을 선택하는 문제를 언급할 수 있다.

서론

가장 기본적인 형태에서 모델 선택은 과학 연구의 기본 작업 중 하나입니다.일련의 관측치를 설명하는 원리를 결정하는 것은 종종 그러한 관측치를 예측하는 수학적 모형과 직접 연결됩니다.예를 들어, 갈릴레오가 그의 경사면 실험을 수행했을 때, 그는 공들의 움직임이 그의[citation needed] 모델에 의해 예측된 포물선에 적합하다는 것을 증명했다.

데이터를 생성할 수 있는 수많은 메커니즘과 프로세스 중에서 어떻게 최적의 모델을 선택할 수 있을까요?일반적으로 채택되는 수학적 접근방식은 후보 모델 집합 사이에서 결정되며, 이 집합은 연구자에 의해 선택되어야 한다.적어도 초기에는[citation needed] 다항식과 같은 간단한 모델이 사용되는 경우가 많습니다.Burnham & Anderson(2002)은 저서에서 데이터의 기초가 되는 현상학적 과정이나 메커니즘(예: 화학 반응)의 이해와 같은 건전한 과학적 원리에 기초한 모델 선택의 중요성을 강조한다.

후보 모델 세트가 선택되면 통계 분석을 통해 이들 모델 중 가장 적합한 모델을 선택할 수 있습니다.베스트가 의미하는 것은 논란의 여지가 있다.좋은 모델 선택 기술은 적합성과 단순성의[citation needed] 균형을 맞출 것입니다.더 복잡한 모형은 데이터에 맞게 모양을 조정할 수 있지만(5차 다항식은 정확히 6개의 점을 적합시킬 수 있음) 추가 모수는 유용한 내용을 나타내지 못할 수 있습니다(아마도 이러한 6개의 점은 직선 주위에 랜덤하게 분포되어 있을 것입니다).적합도는 일반적으로 우도비 접근법 또는 이에 대한 근사치를 사용하여 결정되므로 카이 제곱 검정이 이루어집니다.복잡도는 일반적으로 모형의 매개변수 수를 세어 측정합니다.

모델 선택 기법은 주어진 데이터를 생성하는 모델의 확률과 같은 일부 물리적 수량의 추정기로 간주할 수 있다.치우침과 분산은 모두 이 추정기의 품질에 대한 중요한 척도이며 효율성도 종종 고려됩니다.

모델 선택의 표준 예는 곡선 피팅의 경우로, 포인트 세트 및 기타 배경 지식(예: 포인트는 샘플의 결과)이 주어지면 해당 포인트를 생성한 함수를 설명하는 곡선을 선택해야 합니다.

모델 선택의 두 가지 방향

추론과 데이터로부터의 학습에는 두 가지 주요 목적이 있다.하나는 과학적 발견, 기본 데이터 생성 메커니즘의 이해 및 데이터 성격의 해석을 위한 것이다.데이터를 통해 학습하는 또 다른 목적은 미래 또는 보이지 않는 관찰을 예측하는 것이다.두 번째 목표에서 데이터 과학자는 데이터에 대한 정확한 확률론적 설명을 반드시 고려하지 않는다.물론 양방향에도 관심이 있을 수 있습니다.

두 가지 다른 목적에 따라 모델 선택은 추론을 위한 모델 선택과 [2]예측을 위한 모델 선택이라는 두 가지 방향을 가질 수도 있습니다.첫 번째 방향은 데이터에 대한 최선의 모델을 식별하는 것이며, 이는 과학적 해석을 위한 불확실성의 원천에 대한 신뢰할 수 있는 특성을 제공하는 것이 바람직하다.이 목표를 위해서는 선택한 모형이 표본 크기에 너무 민감하지 않은 것이 중요합니다.따라서 모델 선택을 평가하기 위한 적절한 개념은 선택 일관성이며, 이는 충분한 수의 데이터 샘플이 주어졌을 때 가장 견고한 후보가 일관되게 선택된다는 것을 의미한다.

두 번째 방향은 우수한 예측 성능을 제공하기 위해 기계로 모델을 선택하는 것입니다.그러나 후자의 경우, 선택된 모델이 소수의 근접한 경쟁사 중 행운의 승자일 수 있지만, 예측 성능은 여전히 최상의 성능을 발휘할 수 있습니다.이 경우 두 번째 목표(예측)에 대해서는 모형 선택이 괜찮지만 통찰력 및 해석을 위해 선택된 모형을 사용하는 것은 매우 신뢰할 수 없고 [2]오해를 일으킬 수 있습니다.또한 이렇게 선택된 매우 복잡한 모델의 경우,[3] 예측조차 선택된 데이터와 약간 다른 데이터에 대해서만 불합리할 수 있습니다.

후보 모델 세트를 선택하는 데 도움이 되는 방법

기준

아래는 모델 선택 기준 목록입니다.가장 일반적으로 사용되는 기준은 (i) Akaike 정보 기준 및 (ii) Bayes 요인 및/또는 베이지안 정보 기준(어느 정도 Bayes 요인에 근접)이다. 검토를 위해 Stoica & Selen(2004)을 참조한다.

- 추정된 통계 모형의 선량 적합도에 대한 측도인 AIC(Akaike Information Criteria)

- 베이즈 계수

- 베이지안 정보 기준(BIC), 모델 선택을 위한 통계 기준인 슈바르츠 정보 기준이라고도 한다.

- Bridge Criteria(BC; 브리지 기준), 모델 [4]사양의 적절성에도 불구하고 AIC와 BIC의 더 나은 성능을 달성할 수 있는 통계 기준.

- 교차 검증

- 이탈도 정보 기준(DIC), 또 다른 베이지안 지향 모델 선택 기준

- 오검출률

- 주어진 초점 매개변수에 대한 효과별로 통계 모델을 정렬하는 선택 기준인 FIC(Focused Information Criteria)

- Akaike 및 베이지안 기준의 대안인 Hannan-Qinn 정보 기준

- KIC는 피셔 정보 매트릭스를 사용하기 때문에 Kashyap 정보 기준(KIC)은 AIC와 BIC의 강력한 대안입니다.

- 우도비 검정

- 말로우즈p C

- 최소 설명 길이

- 최소 메시지 길이(MML)

- PRESS 통계(PRESS 기준이라고도 함)

- 구조적 리스크 최소화

- 단계적 회귀 분석

- 와타나베– Akaike 정보 기준(WAIC), 널리 적용되는 정보 기준이라고도 함

- 확장 베이지안 정보 기준(EBIC)은 파라미터 공간이 많은 모델에 대한 일반 베이지안 정보 기준(BIC)의 확장입니다.

- 확장 피셔 정보 기준(EFIC)은 선형 회귀 모형의 모형 선택 기준입니다.

이러한 기준들 중에서 교차 검증은 감독된 학습 문제에 [citation needed]대해 일반적으로 가장 정확하고 계산적으로 가장 비용이 많이 든다.

Burnham & Anderson (2002년, § 6.3)은 다음과 같이 말합니다.

다양한 모델 선택 방법이 있습니다.그러나 방법의 통계적 성과와 사용의 의도된 맥락에서 볼 때, 방법에는 두 가지 분류가 있다.이들은 효율적이고 일관성 있는 라벨로 지정되었다. (...) 모델 선택을 위한 빈도주의 패러다임에서는 일반적으로 (I) 일부 선택 기준의 최적화, (II) 가설의 테스트 및 (II) 임시 방법이라는 세 가지 주요 접근방식이 있다.

「 」를 참조해 주세요.

메모들

- ^ Shirangi, Mehrdad G.; Durlofsky, Louis J. (2016). "A general method to select representative models for decision making and optimization under uncertainty". Computers & Geosciences. 96: 109–123. Bibcode:2016CG.....96..109S. doi:10.1016/j.cageo.2016.08.002.

- ^ a b Ding, Jie; Tarokh, Vahid; Yang, Yuhong (2018). "Model Selection Techniques: An Overview". IEEE Signal Processing Magazine. 35 (6): 16–34. arXiv:1810.09583. doi:10.1109/MSP.2018.2867638. ISSN 1053-5888. S2CID 53035396.

- ^ Su, J.; Vargas, D.V.; Sakurai, K. (2019). "One Pixel Attack for Fooling Deep Neural Networks". IEEE Transactions on Evolutionary Computation. 23 (5): 828–841. arXiv:1710.08864. doi:10.1109/TEVC.2019.2890858. S2CID 2698863.

- ^ Ding, J.; Tarokh, V.; Yang, Y. (June 2018). "Bridging AIC and BIC: A New Criterion for Autoregression". IEEE Transactions on Information Theory. 64 (6): 4024–4043. arXiv:1508.02473. doi:10.1109/TIT.2017.2717599. ISSN 1557-9654. S2CID 5189440.

레퍼런스

- Aho, K.; Derryberry, D.; Peterson, T. (2014), "Model selection for ecologists: the worldviews of AIC and BIC", Ecology, 95 (3): 631–636, doi:10.1890/13-1452.1, PMID 24804445

- Akaike, H. (1994), "Implications of informational point of view on the development of statistical science", in Bozdogan, H. (ed.), Proceedings of the First US/JAPAN Conference on The Frontiers of Statistical Modeling: An Informational Approach—Volume 3, Kluwer Academic Publishers, pp. 27–38

- Anderson, D.R. (2008), Model Based Inference in the Life Sciences, Springer, ISBN 9780387740751

- Ando, T. (2010), Bayesian Model Selection and Statistical Modeling, CRC Press, ISBN 9781439836156

- Breiman, L. (2001), "Statistical modeling: the two cultures", Statistical Science, 16: 199–231, doi:10.1214/ss/1009213726

- Burnham, K.P.; Anderson, D.R. (2002), Model Selection and Multimodel Inference: A Practical Information-Theoretic Approach (2nd ed.), Springer-Verlag, ISBN 0-387-95364-7 [Google Scholar 인용문 38,000개 돌파]

- Chamberlin, T.C. (1890), "The method of multiple working hypotheses", Science, 15 (366): 92–6, Bibcode:1890Sci....15R..92., doi:10.1126/science.ns-15.366.92, PMID 17782687 (1965년 사이언스 148:754–759 [1] doi:10.1126/science.148.3671.754로 재인쇄)

- Claeskens, G. (2016), "Statistical model choice" (PDF), Annual Review of Statistics and Its Application, 3 (1): 233–256, Bibcode:2016AnRSA...3..233C, doi:10.1146/annurev-statistics-041715-033413[영구 데드링크]

- Claeskens, G.; Hjort, N.L. (2008), Model Selection and Model Averaging, Cambridge University Press, ISBN 9781139471800

- Cox, D.R. (2006), Principles of Statistical Inference, Cambridge University Press

- Kashyap, R.L. (1982), "Optimal choice of AR and MA parts in autoregressive moving average models", IEEE Transactions on Pattern Analysis and Machine Intelligence, IEEE, PAMI-4 (2): 99–104, doi:10.1109/TPAMI.1982.4767213, PMID 21869012, S2CID 18484243

- Konishi, S.; Kitagawa, G. (2008), Information Criteria and Statistical Modeling, Springer, Bibcode:2007icsm.book.....K, ISBN 9780387718866

- Lahiri, P. (2001), Model Selection, Institute of Mathematical Statistics

- Leeb, H.; Pötscher, B. M. (2009), "Model selection", in Anderson, T. G. (ed.), Handbook of Financial Time Series, Springer, pp. 889–925, doi:10.1007/978-3-540-71297-8_39, ISBN 978-3-540-71296-1

- Lukacs, P. M.; Thompson, W. L.; Kendall, W. L.; Gould, W. R.; Doherty, P. F. Jr.; Burnham, K. P.; Anderson, D. R. (2007), "Concerns regarding a call for pluralism of information theory and hypothesis testing", Journal of Applied Ecology, 44 (2): 456–460, doi:10.1111/j.1365-2664.2006.01267.x, S2CID 83816981

- McQuarrie, Allan D. R.; Tsai, Chih-Ling (1998), Regression and Time Series Model Selection, Singapore: World Scientific, ISBN 981-02-3242-X

- Massart, P. (2007), Concentration Inequalities and Model Selection, Springer

- Massart, P. (2014), "A non-asymptotic walk in probability and statistics", in Lin, Xihong (ed.), Past, Present, and Future of Statistical Science, Chapman & Hall, pp. 309–321, ISBN 9781482204988

- Navarro, D. J. (2019), "Between the Devil and the Deep Blue Sea: Tensions between scientific judgement and statistical model selection", Computational Brain & Behavior, 2: 28–34, doi:10.1007/s42113-018-0019-z

- Resende, Paulo Angelo Alves; Dorea, Chang Chung Yu (2016), "Model identification using the Efficient Determination Criterion", Journal of Multivariate Analysis, 150: 229–244, arXiv:1409.7441, doi:10.1016/j.jmva.2016.06.002, S2CID 5469654

- Shmueli, G. (2010), "To explain or to predict?", Statistical Science, 25 (3): 289–310, arXiv:1101.0891, doi:10.1214/10-STS330, MR 2791669, S2CID 15900983

- Stoica, P.; Selen, Y. (2004), "Model-order selection: a review of information criterion rules" (PDF), IEEE Signal Processing Magazine, 21 (4): 36–47, doi:10.1109/MSP.2004.1311138, S2CID 17338979

- Wit, E.; van den Heuvel, E.; Romeijn, J.-W. (2012), "'All models are wrong...': an introduction to model uncertainty" (PDF), Statistica Neerlandica, 66 (3): 217–236, doi:10.1111/j.1467-9574.2012.00530.x, S2CID 7793470

- Wit, E.; McCullagh, P. (2001), Viana, M. A. G.; Richards, D. St. P. (eds.), "The extendibility of statistical models", Algebraic Methods in Statistics and Probability, pp. 327–340

- Wójtowicz, Anna; Bigaj, Tomasz (2016), "Justification, confirmation, and the problem of mutually exclusive hypotheses", in Kuźniar, Adrian; Odrowąż-Sypniewska, Joanna (eds.), Uncovering Facts and Values, Brill Publishers, pp. 122–143, doi:10.1163/9789004312654_009, ISBN 9789004312654

- Owrang, Arash; Jansson, Magnus (2018), "A Model Selection Criterion for High-Dimensional Linear Regression", IEEE Transactions on Signal Processing , 66 (13): 3436–3446, Bibcode:2018ITSP...66.3436O, doi:10.1109/TSP.2018.2821628, ISSN 1941-0476, S2CID 46931136

- B. Gohain, Prakash; Jansson, Magnus (2022), "Scale-Invariant and consistent Bayesian information criterion for order selection in linear regression models", Signal Processing, 196: 108499, doi:10.1016/j.sigpro.2022.108499, ISSN 0165-1684, S2CID 246759677